| IT周報 | Deepmind | 蛋白質 | MoE | 效能 | 行政院 | AI生態系 | 數發部 | Visual Studio

AI趨勢周報第259期:比現有最佳方法好3到300倍,DeepMind新模型可生成蛋白結合劑

Google DeepMind打造一款AI模型AlphaProteo,可生成蛋白結合劑且與多種標靶蛋白高度親和;艾倫AI研究所聯手打造更節能的MoE語言模型;行政院經發會首次顧問會議聚焦AI生態圈;行政院提五大信賴方案,要提高特定產業AI應用普及率達50%;數發部預計12月提出公務機關AI應用指引

2024-09-12

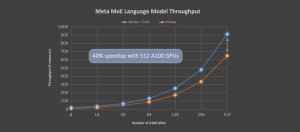

Google讓模型依任務學習路由,有效提高大型語言模型推理效率

Google發表新的新型混合專家模型TaskMoE,大小不只是典型混合專家模型TaskMoE的七分之一,吞吐量更是提升達2倍

2022-01-18