圖片來源/Pure Storage

我們前面介紹的分解式儲存產品,都是基於分離運算與儲存節點的概念。不過,有些廠商如Pure Storage,正在推動另一種分離式儲存架構,他們打算從資料流的角度出發,提出分離metadata與資料I/O的概念。

分散式儲存這類基於叢集架構的系統,每份資料都被分割、分散存放在不同節點的不同磁碟上,須透過metadata記錄所有資料實體儲存位置的配置,所有存取必須透過查詢metadata,以確認資料實體位置,所以,在分散式儲存系統存取作業中,關於metadata的處理,也成為一大重點。

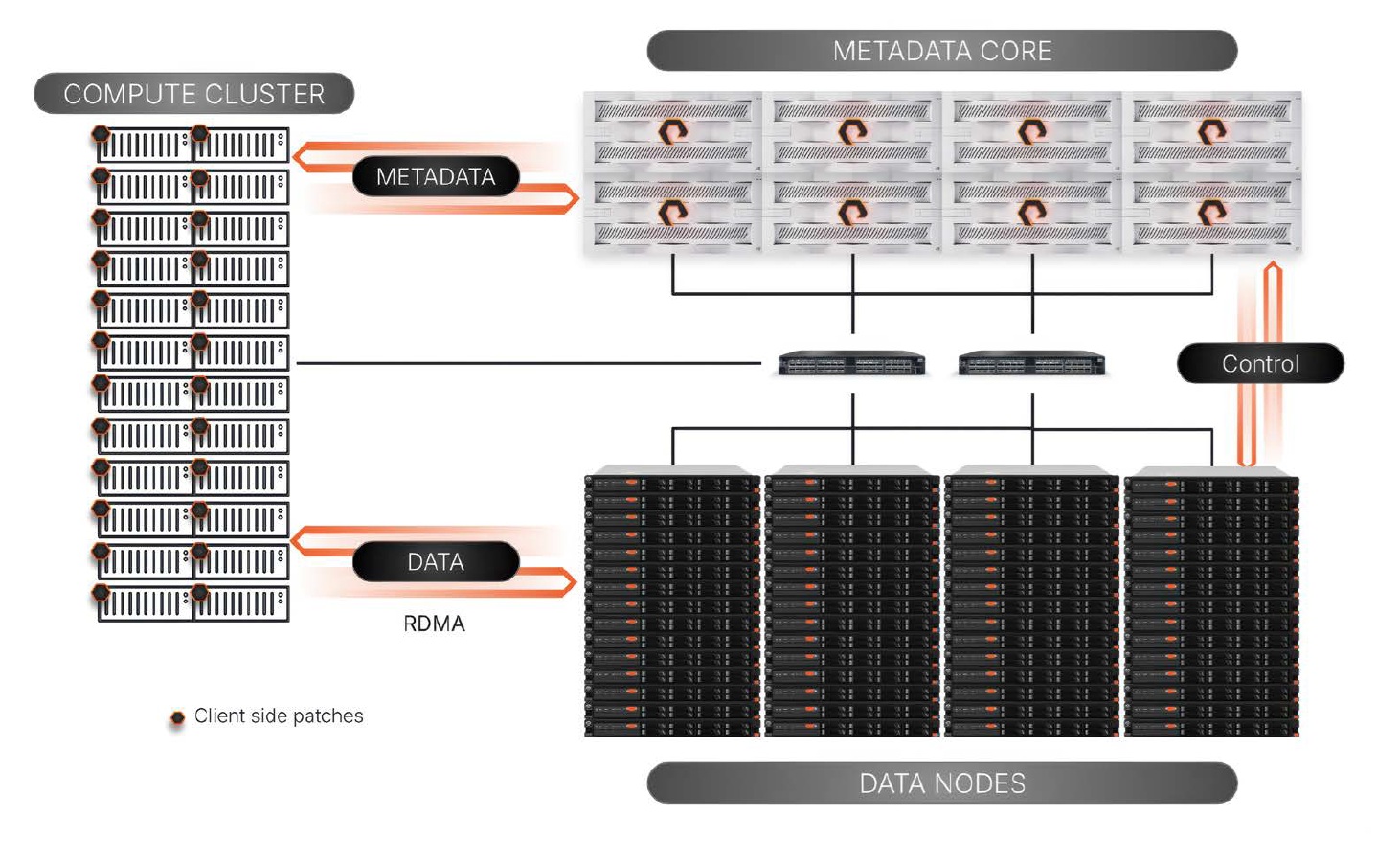

Pure Storage指出,特別是在AI與HPC應用這類大規模平行處理架構中,對metadata的存取請求數量,甚至會超過資料I/O,但是,在傳統儲存架構難以擴展metadata架構,此時將成為效能瓶頸,因而在他們新推出的FlashBlade//EXA上,透過分離metadata與資料I/O解決這個問題,兩者分別由metadata叢集與資料叢集來負責,也形成另一種型態的分解式儲存架構。

FlashBlade//EXA是Pure Storage的FlashBlade物件與檔案儲存陣列家族中,專門針對AI與HPC應用發展的新版本,採用pNFS平行存取架構,由負責metadata處理的MetaData核心節點(Metadata Core Node),與負責資料I/O的資料節點(Data Node)組成。

MetaData核心節點採用FlashBlade//S的硬體,資料節點使用第三方伺服器,並安裝FlashBlade//EXA資料節點軟體,均透過400GbE網路連接用戶端主機。

用戶端主機透過NFSv4.1 over TCP連結到MetaData核心節點,處理metadata,另透過NFSv3 over RDMA連接資料節點,執行資料I/O處理。用戶端主機從MetaData核心節點查詢資料位置後,便能逕自與資料節點進行存取操作,metadata與資料I/O的操作完全分離,互不干擾,藉此帶來一系列效益:

首先,MetaData核心節點與資料節點可各自獨立地擴展。

其次,資料I/O無須經過MetaData核心節點,不受metadata操作影響,可實現極高的傳輸率,原廠聲稱目前實測已能達到5 TB/s,未來將能達到10 TB/s。

第3,雖然MetaData核心節點採用Pure Storage專屬設備,但資料節點可使用第三方標準儲存伺服器硬體,用戶端主機也採用標準NFS協議,只需安裝Linux NFS client即可。

基本上,一套FlashBlade//EXA應用環境,可以支援1到10臺MetaData核心節點,資料節點數量則沒有上限,原廠建議至少搭配10臺以上。

Pure Storage FlashBlade//EXA運作架構

FlashBlade//EXA採用分離metadata與資料I/O的架構,各自由獨立的Metadata核心節點,以及資料節點負責處理,藉此達到metadata操作不影響資料I/O,提高I/O傳輸效能的目的。圖片來源/Pure Storage

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-06