iThome

隨著AI應用的興起,帶動了企業IT基礎設施規格的全面升級,也讓我們在時隔5、6年之後的現在,再次回歸到資料中心I/O規格更新這個議題。

過去,我們曾在2018年製作報導的封面故事「I/O介面更新潮正式啟動」,以及2019年的封面故事「資料中心超高速網路時代來臨」,介紹上一輪的I/O技術更新風潮,當時在大型資料中心建設,與巨量資料分析等應用的引領之下,帶動一波I/O介面規格的更新潮,促使32Gb FC、25Gb乙太網路、NVMe,以及100Gb等級乙太網路與InfiniBand等I/O技術,邁向普及應用。

過去兩年以來,在機器學習與生成式AI技術應用的帶動之下,又掀起新一輪I/O技術更新風潮。AI應用不僅需要更高的運算能力,也需要容量更大、存取速度更快的儲存設備,同時還需要傳輸吞吐能力更大的I/O介面,來滿足運算與儲存單元之間龐大的資料傳輸要求。

為了因應AI應用近乎無止盡成長、膨脹的資料傳輸流量需求,不僅促使PCIe 5.0、400Gb等級乙太網路與InfiniBand等新一代I/O規格,迅速進入實用化,另一方面,推出已久、但應用遲遲沒有打開局面的64Gb FC與SAS-4等介面,也連帶出現轉機,開始獲得較普遍的採用。

而這一系列的發展突破,也讓資料中心的I/O架構,在短短不到兩年之內,有了煥然一新的面貌。

伺服器內部I/O與外部I/O規格同步進化

關於資料中心應用的I/O技術,我們可以簡單區分為「伺服器內部I/O」與「伺服器外部I/O」等2大類。

伺服器內部I/O指的是伺服器內部元件,如CPU、GPU、記憶體與周邊裝置如磁碟機、網路卡等,互連使用的I/O介面,如PCIe、SATA、SAS等。

伺服器外部I/O指的是伺服器與外部裝置,如伺服器與其他伺服器、網路設備、儲存設備之間,跨機箱與機櫃相互連結所使用的I/O介面,像是:乙太網路、InfiniBand,還有FC等。

另外,還有一些I/O介面,同時兼具內部I/O與外部I/O的功能,最典型的例子便是SAS介面。

5、6年前的上一輪I/O介面更新潮,主要聚焦在伺服器外部I/O的更新,當時引進的新規格中,除了嫁接在PCIe上的NVMe介面以外,其餘新規格都是屬於外部I/O介面。

而這一輪I/O介面更新潮,同時涵蓋伺服器內部I/O與外部I/O介面,以兩大基礎I/O介面為首——作為內部I/O基礎介面的PCIe,以及最廣獲使用外部I/O介面乙太網路,另外再加上InfiniBand、FC、SAS等介面,都在過去1、2年內,出現開始導入新一代規格的風潮。

內部I/O介面的世代交替

近兩年來,伺服器內部I/O介面最重要的進展,便是作為通用基礎互連介面的PCIe,以及作為Nvidia GPU專屬互連介面的NVLink與NVSwitch,這2個方面的規格更新。

作為伺服器主機基礎I/O介面的PCIe,也可以稱作是「I/O介面的I/O介面」,幾乎所有周邊裝置或其他I/O介面,都是直接或間接透過PCIe的介接與運算核心連結。另外還有一些I/O介面,是直接嫁接在PCIe的實體層上,算是PCIe的衍生介面,例如用於SSD儲存裝置的NVMe,還有CXL記憶體互連技術等。

PCIe自擺脫3.0時期長達10年的停滯後,這幾年明顯加速發展,當前的主流是PCIe 4.0,今年起,PCIe 5.0也進入伺服器平臺普遍支援階段,周邊裝置的支援也顯著的增加,特別是基於PCIe 5.0的NVMe SSD產品。下一代的PCIe 6.0於去年出現第一批元件層級產品,最新一代的PCIe 7.0,今年初完成初步規格制定,預定明年便能推出正式版規格。

不過,比起PCIe的更新,更受人矚目的是GPU專屬互連介面的發展,在AI相關應用的帶動下,GPU已經取代CPU,成為當前資料中心運算能力的主要來源,連帶也讓Nvidia的專屬GPU互連介面NVLink,成為重要性不下於PCIe的另一伺服器內部I/O介面規格。

在Nvidia之外,AMD與Intel也各有專屬的GPU互連介面規格,也就是Infinity Fabric與Xe Link,但無論規格、應用普及程度還是影響力,都遠不能與Nvidia的NVLink相比。

至於多家廠商聯合發展的UALink規格,目前也還未問世,距離「成氣候」的階段還很遙遠。因而Nvidia的NVLink,當前幾乎也就等同於GPU互連傳輸技術的代名詞。

Nvidia發展NVLink的目的,是滿足多GPU協同作業環境下的巨量傳輸頻寬需求,NVLink用於GPU與GPU之間的直連,再結合NVSwitch連接多組NVLink,組成更大的GPU連結架構。

透過NVLink與NVSwitch,Nvidia不僅可為自身GPU提供數倍於PCIe的高頻寬,而且,還憑藉封閉規格的完全自主優勢,架構更迭的速度非常快。

自Nvidia於2014年發表第1代NVLink以來,短短10年內就推出5個世代,稍晚於2017年問世的NVSwich,迄今也發展了4個世代。最新的第5代NVLink與第4代NVSwitch,都是今年伴隨著新一代GPU運算架構Blackwell一同推出。

值得一提的是,Nvidia在2022年推出第4代NVLink與第3代NVSwitch,也以NVSwtch技術為基礎,推出獨立NVLink Switch網路交換器,藉此將原本用於伺服器內部的NVLink與NVSwitch技術,擴展到跨機箱與機櫃的外部互連環境,從而能組成更大規模的GPU運算環境。

由於NVSwtch與NVLink Switch兩者系出同源,Nvidia目前已統一稱為NVLink Switch。

外部I/O介面的進化

包括通用的乙太網路在內,以及主要用於高效能運算領域的InfiniBand,還有FC與SAS兩種儲存專用介面,都在這兩年有了規格發展,或是產品應用方面的重要進展。

在乙太網路方面,在AI應用的推動下,短短幾年時間內,200/400GbE規格便從迅速從上行/骨幹/核心網路(Uplink/Spine/Core)應用,開始擴展到TOR/伺服器端,下一代的800GbE應用環境也開始成形。

IEEE 802.3小組早從2017年起,就陸續制定一系列200/400GbE規格,相關產品也在2018年開始推出市場,但直到5、6年前,TOR與伺服器端的主要乙太網路規格,仍以10GbE為主流,部分開始導入25GbE規格,上行/骨幹/核心網路多半是40/100GbE,只有少數大型用戶開始導入200/400GbE。

但為了滿足AI應用無止盡般的資料傳輸需求,近兩年來,200/400GbE迅速進入AI伺服器端應用,200/400GbE網路卡已經是當前GPU伺服器常見的配備。不過在AI應用環境之外,多數資料中心的乙太網路架構,仍以100/40/25/10GbE為主。

在800GbE方面,乙太網路技術聯盟(Ethernet Technology Consortium)在2020年完成800GbE規格制定,相關產品則在這兩年間陸續問世,第一批800GbE交換器,是在2022年上半年現身於市場,最早的800Gb網路卡也在今年發表(即Nvidia的ConnectX-8,但尚未正式上市),完整的應用環境應該會在1、2年內逐漸成形。

除了傳輸頻寬的增長,超級乙太網路聯盟(Ultra Ethernet Consortium,UEC)也正在制定改進的乙太網路傳輸協定,以求改善乙太網路在高效能應用領域的效能表現,進而挑戰InfiniBand的地位。

而當前統治高效能運算領域網路應用的InfiniBand,目前普遍使用的規格是100Gb EDR與200Gb HDR,但面對乙太網路競爭,新規格的發展也跟著加速。

由於資料鏈結層、流量控制與組網方式的差異,在同等頻寬的條件下,InfiniBand的效能要優於乙太網路,可靠性也較佳,而乙太網路的主要優點則是較低的成本。但近幾年來,乙太網路憑藉更迅速的頻寬規格增長,已相當程度抵銷InfiniBand的優勢,迫使InfiniBand不得不跟著提高頻寬作為對應。

原本InfiniBand大致是以4年的頻率更新規格,56Gb的FDR是2011年問世,在2014、2018、2022年,依序推出100Gb的EDR,200Gb的HDR,以及400Gb的NDR,但這樣的傳輸速度增長,已落後乙太網路2年以上。

於是,負責規格制定的InfiniBand貿易協會(InfiniBand Trade Association),在2024年推出800Gb的XDR規格,緊接著Nvidia也發表800Gb XDR交換器,算是跟上乙太網路的傳輸頻寬規格。

儲存I/O介面新進展

最後來看看FC與SAS這2種老牌儲存專用介面,近幾年都同樣遭遇發展與應用停滯困境,而現在則出現復甦跡象。

目前最新的FC介面,是2018年制定完成的第7代64Gb FC,支援的HBA卡與SAN交換器產品在2019到2020年間陸續上市。但是受到儲存網路「乙太網路化」發展的衝擊,64Gb FC的應用進展十分緩慢,僅有交換器與板卡端產品支援,儲存產品端採用的廠商不多,以致FC SAN領域的主流規格,仍是問世多年的16Gb與32Gb FC,進而也影響到下一代FC規格的制定。

依照早期的規畫,第8代128Gb FC應該會在2021年間完成規格制訂,但實際上推出時間一延再延,直到2024年中的現在,仍未實際問世。

儘管FC介面在下一代規格方面尚未有具體成果,但在應用方面,近來則有一些好消息傳出——64Gb FC開始獲得NetApp、IBM、Hitachi Vantara、Pure Storage多家一線大廠的儲存設備支援,可望逐漸改變FC主流應用規格長期停滯在32Gb FC的情況。

單就SAS介面而言,過去10年以來,在NVMe與NVMe-oF規格的擠壓之下,逐漸失去標準磁碟裝置介面與後端儲存介面的地位,連帶也導致新一代SAS規格的發展與應用,都陷入停滯,直到近一年多來,才在規格發展與應用兩方面,同時出現重要進展。

在規格發展方面,目前SAS介面最新規格是2017年制訂的SAS-4,也就是24G SAS。依照原本的路線圖,下一步的發展應該是頻寬加倍的SAS-5,即48G SAS。但負責制定規格的SCSI貿易協會(SCSI Trade Association,STA),在2023年底,提出異於原本路線圖的規畫,放棄48G SAS這條提高頻寬的路線,改為沿用既有的24G SAS實體層,搭配強化上層協定可靠性、安全性與效率的24G+ SAS。

而在產品應用方面,在NVMe介面的擠壓下,讓SAS-4的產品應用受到很大的局限,市場主流應用的SAS規格,仍停留在上一代SAS-3,SAS-4陷入乏人問津的窘境,只有少數板卡與SSD產品支援SAS-4。

不過,到了今年,情況終於稍有改觀,終於出現了第一批支援SAS-4介面的伺服器與外接儲存設備,有望打破停滯的局面。

相互帶動與競爭的I/O規格

我們前面介紹的6種資料中心主要I/O介面——PCIe、NVLink,乙太網路,InfiniBand、FC與SAS,就規格發展來說,它們是由完全獨立的不同組織制定與維護,技術架構也各有不同,但彼此間不全然是相互孤立的關係,而是存在著彼此聯繫依存與相互競爭的關係,其中一種介面的發展演變,會連動影響到其他介面。

就聯繫與依存關係來說,400Gb以上頻寬的乙太網路卡與InfiniBand介面卡,都必須搭配伺服器端PCIe 5.0介面,才能完整發揮效能。所以,在幾年前伺服器端只有PCIe 4.0的時候,使用400GbE網路卡並無法帶來傳輸能力的有效提升,這也制約400GbE在當時的應用情境,只能用於骨幹網路,而不適合應用在伺服器端。直到這2年伺服器端普遍支援PCIe 5.0後,才「解放」了400GbE網路在伺服器端的應用。

除了超高頻寬的網路介面,必須搭配PCIe的升級才能發揮效能外,一些嫁接在PCIe上的I/O介面,如NVMe與CXL等,更完全依賴PCIe的發展,才能造就自身的成功。

而就競爭關係來說,最典型的例子,便是InfiniBand與乙太網路在高效能運算領域的競爭,雖然InfiniBand在Top 500頂級用戶的應用佔有優勢,但面對乙太網路的挑戰,也不得不加快頻寬提升速度,提早推出800Gb XDR規格。

另外,PCIe與NVLink也在GPU應用領域形成了競爭。當初Nvidia就是不滿於PCIe的效能不足,才另起爐灶發展了NVLink,相對於只有PCIe可用的競爭對手,NVLink也是幫助Nvidia取得關鍵優勢的「護城河」之一。

更早的例子還有FC與SAS,就目前來看,這2種介面是各司其職,各自有不同應用領域,FC被用於前端的SAN儲存網路,SAS則被用於磁碟介面與後端儲存擴充介面。但是在10多年前,這2種介面曾存在競爭關係,FC早期也曾被用於磁碟介面與後端儲存擴充介面,當時還有FC硬碟產品的存在,但面對SAS介面的興起,成本較高的FC介面,最後退出磁碟介面與後端擴充儲存介面應用,由SAS介面佔有這個領域。而隨著技術發展的推移,現在換成SAS介面不敵擁有效能優勢的PCIe/NVMe介面,應用範圍不斷縮減與退守。

所以我們在探討資料中心I/O介面發展時,必須將這些不同的I/O規格,彼此聯繫起來,才能更全面地檢視技術趨勢的演變。

接下來我們將分別針對內部I/O與外部I/O,進一步介紹相關技術近期的更迭情況。

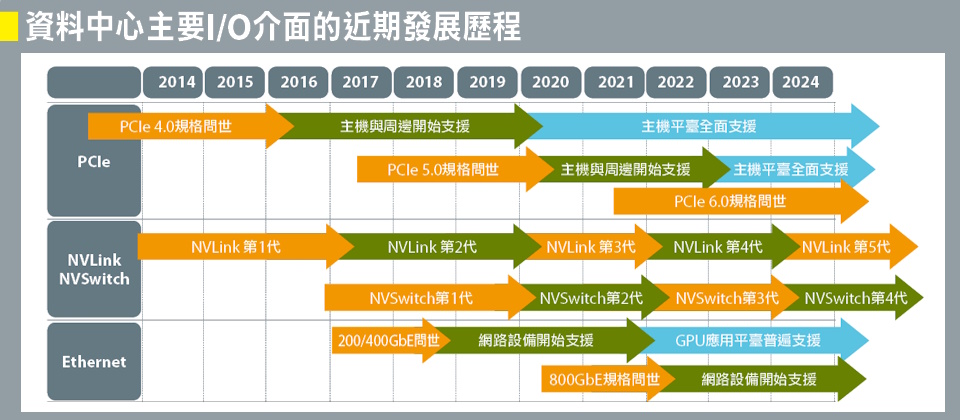

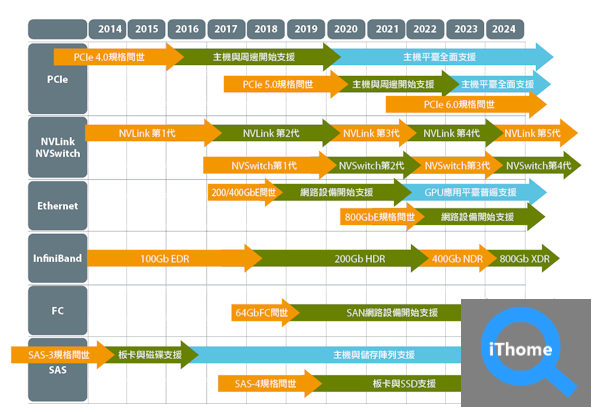

資料中心6大主要I/O介面的近期發展歷程

我們將近10年來,資料中心6種主要I/O介面的發展演進情況,簡略整理於下圖。

自2022年至今,短短不到兩年,這6大I/O介面的發展與演進都出現明顯加速,正好對應生成式AI技術的興起。

在PCIe方面,PCIe 5.0開始全面為伺服器主機平臺支援,周邊也顯著增加;Nvidia則在這段期間內推出2個世代的NVLink與NVSwitch;乙太網路方面,則是200/400GbE規格開始普遍為GPU平臺支援與採用,800GbE規格產品也正式問世;至於InfiniBand,則是接連推出400Gb NDR與800Gb XDR等2個新世代。

最後在FC與SAS方面,雖然在新規格方面尚無具體進展,但數年來乏人問津的64Gb FC與SAS-4等2種規格,在近期開始獲得較普遍的應用。

另外,要特別注意的是,NVLink/NVSwitch與InfiniBand這兩種I/O介面,產品應用演進與規格更迭的方式,與其他4種I/O介面有根本的差異。

PCIe、乙太網路、FC、SAS都是大量供應商參與的開放生態環境,所以在規格與產品更迭方面,可從供應商支援程度,區分出不同的成熟度階段,從最初的規格發布,到少數廠商先行支援,最後成為業界普遍支援與供應產品(圖中藍色階段)。

NVLink/NVSwitch則是Nvidia的私有專屬規格,相關產品供應也屬於封閉的生態環境;InfiniBand雖然形式上屬於開放性規格,但實質上是由Nvidia/Mellanox壟斷相關產品的發展與供應,基本上也是屬於封閉性或半封閉性生態環境。由於這兩種I/O介面都是單一廠商主導規格發展與產品供應,所以,也不存在其他介面更迭演進時,廠商端不同的成熟度階段區分。

關乎資料中心傳輸效率的神經線路:6大I/O介面

作為伺服器內部I/O基礎介面的PCIe,構成Nvidia多GPU協同運作互連架構的NVLink/NVSwitch,最廣獲使用的通用網路技術乙太網路,主宰高效能運算網路互連應用的InfiniBand,還有儲存網路環境普遍使用的FC介面,以及兼具磁碟介面與外接儲存擴充介面的SAS,構成了當前資料中心最重要的6種I/O技術。

其中PCIe又延伸發展出用於連接SSD的NVMe介面,而NVMe協定與乙太網路、InfiniBand與FC等網路介面的結合,則衍生出一系列用於外接的NVMe-over-Fabric介面,另外NVSwitch也衍生出用於跨機箱/機櫃外接應用的NVLink Switch,都兼具內接與外接I/O能力。

熱門新聞

2026-02-09

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-06

.png)