在商用GPU市場,Nvidia這幾年獨領風騷,主推的Blackwell架構,陸續發表資料中心等級的B100、B200與GB200、B300與GB300,幾家大型雲端服務業者(CSP)紛紛宣布採用、建置超大型AI叢集系統,今年Nvidia開始提供用於單板電腦的Jetson Thor,以及專業繪圖處理的RTX Pro Blackwell,而當中的RTX Pro 6000 Blackwell Server Edition(BSE),不僅被Nvidia認定為新世代RTX Pro伺服器平臺的核心配備之一,多家伺服器廠商響應推出新機型,部分雲端服務業者也基於這款資料中心GPU,開設新的加速運算服務,例如,CoreWeave率先在7月宣布供應搭配RTX Pro 6000 Blackwell Server Edition的執行個體服務,到了10月下半,Google Cloud宣布新的加速器最佳化虛擬機器G4正式上線(GA),同樣標榜採用這款Blackwell架構的資料中心GPU,最大組態可搭配8張,匯聚與運用多達768 GB容量的GDDR7記憶體。然而,雖然Google Cloud為此發布兩篇部落格文章,前一天也在Google Cloud與Compute Engine的服務公告區揭露,但直到11月第一週,我們才在Google Cloud管理主控臺看到Nvidia RTX Pro 6000的GPU虛擬機器選項,Google Cloud表示,先前允許清單的限制尚未完全移除,因此出現未完全供應的狀況。

提供G4的消息最早出現在6月,當時正值Nvidia GTC 2025 Paris大會舉行的期間,Google Cloud表示,繼採用HGX B200的A4與採用GB200 NVL72的A4X,這兩款專攻大規模AI訓練需求的產品登場後,G4鎖定的市場是企業與內容創作者,並預告它將採用Nvidia今年新主打的RTX Pro 6000 Blackwell Server Edition。

相較於Google Cloud現有的加速器最佳化虛擬機器G2,採用的GPU是導入Ada Lovelace架構的Nvidia L4,Google Cloud G4搭配的RTX Pro 6000 Blackwell Server Edition,具備4倍的運算能力(30.3 TFLOPS vs.120 TFLOPS)與記憶體容量(24 GB vs. 96 GB),以及5.3倍的記憶體頻寬(300 GB/s vs. 1,597 GB/s),而且支援GPU多執行個體(MIG)。

而比起前一代資料中心GPU,Google Cloud也強調RTX Pro 6000 Blackwell Server Edition可帶來兩倍的光線追蹤效能提升,關鍵在於這款GPU內建第五代的RT Core,能模擬光線的物理行為,可針對複雜、即時的著色處理需求提供超逼真的視覺體驗。

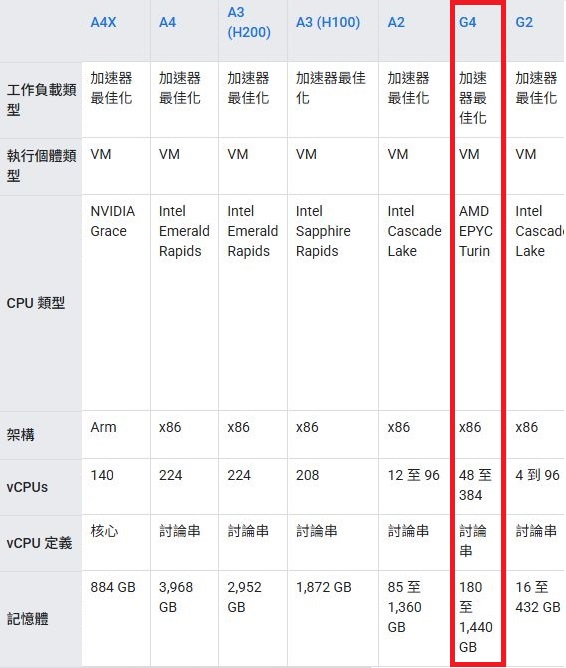

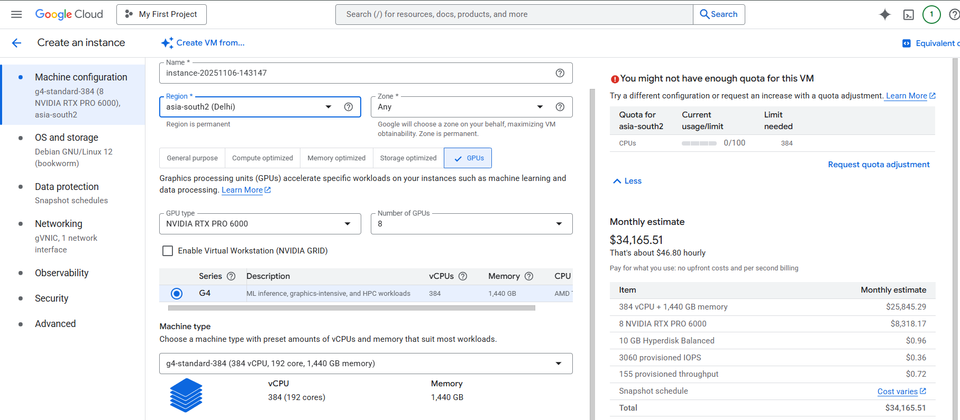

處理器的部分,G4搭配AMD EPYC 9005系列(代號Turin),最大可配置384顆虛擬處理器與1.4 TB容量的DDR5記憶體,並且對應8張RTX Pro 6000 Blackwell Server Edition,此時可形成1張GPU搭配48個虛擬處理器的運算組態,能實現執行嵌入AI模型的預先運算,處理器可協助調度指揮相關的模擬作業。

同時,G4也與Google Cloud其他虛擬機器一樣,沿襲該公司近期發展的IT基礎架構卸載平臺Titanium,能提供專屬的網路處理能力,連線頻寬最高可達400 Gbps,是G2虛擬機器的4倍。

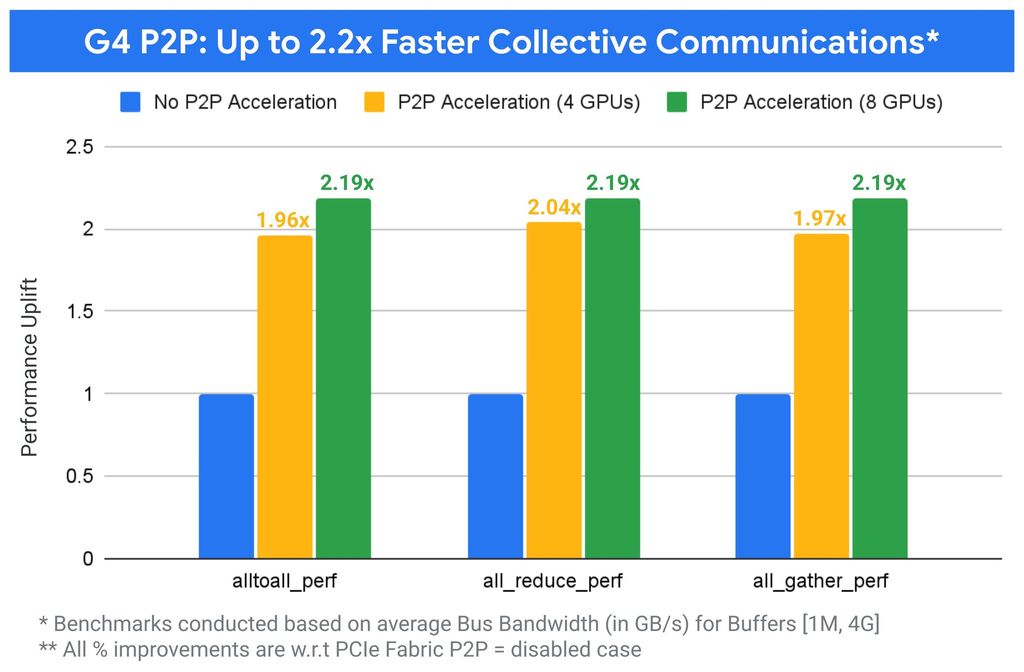

經過4個月的發展,G4終於正式推出,Google Cloud強調他們大幅提升多GPU效能,關鍵於實作強化的PCIe點對點資料路徑,能改善All-Reduce這類重要的集合通訊效率,有利於橫跨多個GPU的分割模型處理,適用於g4-standard-96(2張GPU)、g4-standard-192(4張GPU)、g4-standard-384(8張GPU)這三種組態。

比起標準的非點對點做法,Google Cloud表示,他們將這項發展的高效能、支援點對點通訊的軟體定義PCIe交織網路,用於需要多GPU擴展規模的工作負載,例如支援Nvidia集合通訊程式庫(NCCL)的系統,最大可增加至2.2倍——以搭配4個GPU的G4虛擬機器為例,當設置在1個非統一記憶體存取架構(NUMA)的節點內,集合通訊速度可達2.04倍;若是搭配8個GPU的G4虛擬機器,並且設置在2個NUMA的節點內,集合通訊速度可達2.19倍。如此一來,AI推論及大型語言模型的微調皆可顯著提升速度。

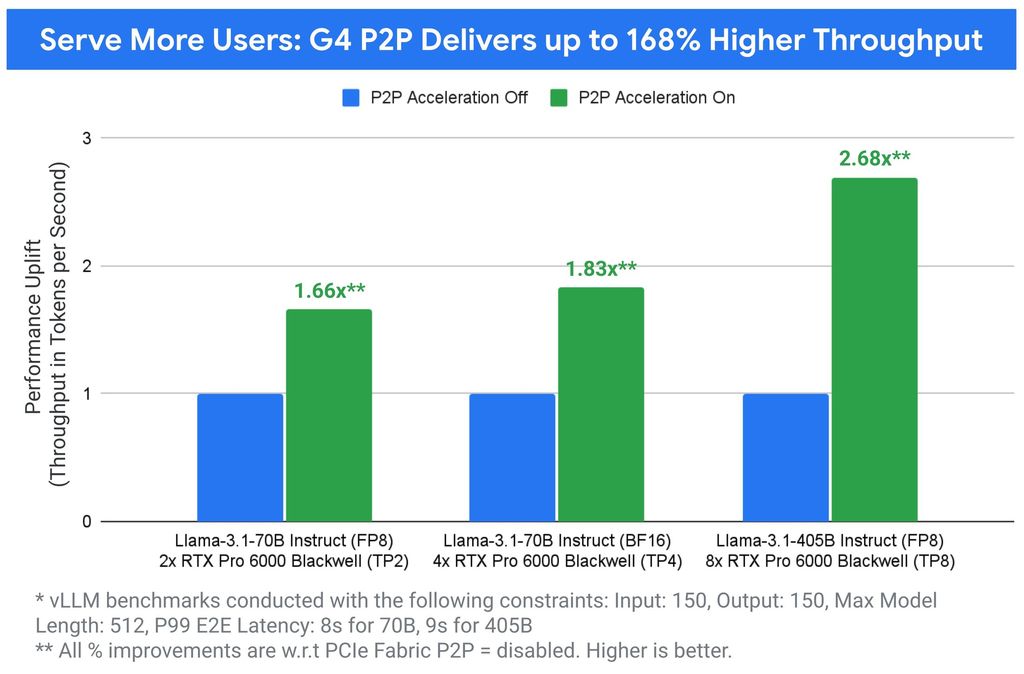

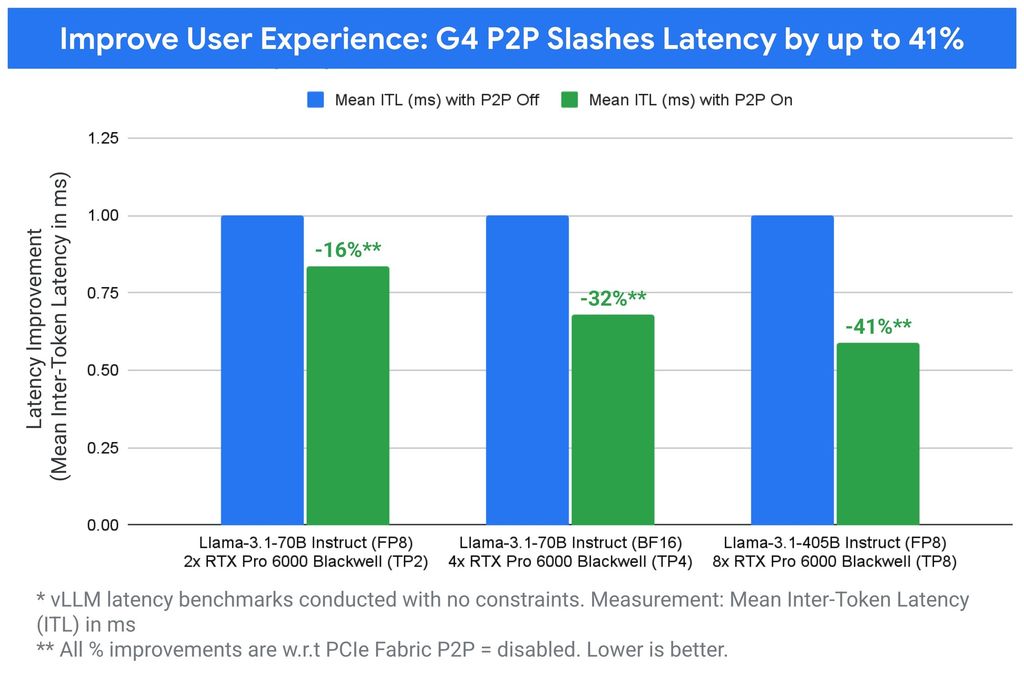

若將GPU的P2P網路用於模型服務的張量平行處理時,吞吐量可提升168%,詞元之間的延遲(inter-token latency)也能減少41%。

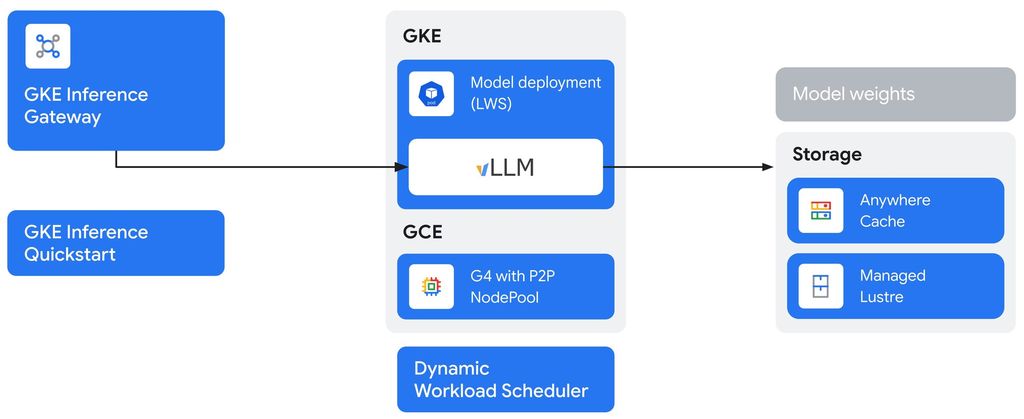

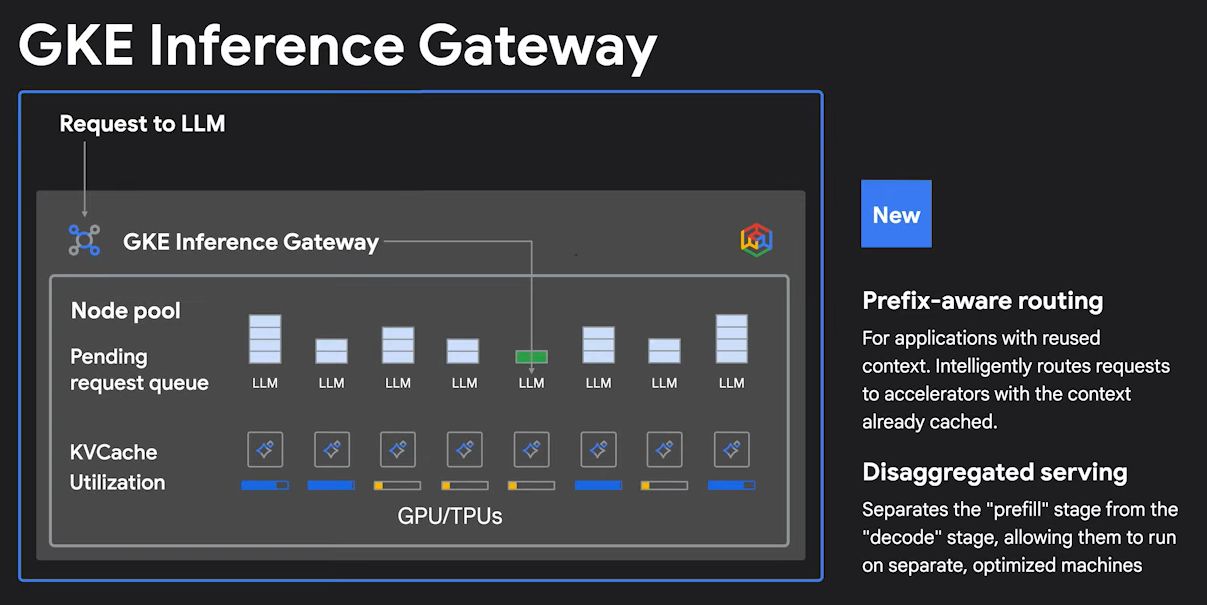

提供更好的多GPU存取能力之餘,G4也能整合Google Cloud旗下眾多雲端服務。首先是容器即服務Google Kubernetes Engine(GKE),可選用G4虛擬機器,從9月底開始,GKE的自動輔助操作功能Autopilot可用於所有符合條件的GKE叢集,所以,GKE也能運用G4虛擬機器快速擴展GPU執行規模,進而改善支出,可增設同樣具備橫向擴展能力的GKE Inference Gateway,聰明地管理AI模型的流量,例如,可用雙GPU組態的G4虛擬機器執行Llama-3.1-70B這個AI模型的副本,吞吐量可提升66%,再用GKE Inference Gateway閘道管理與自動擴展多個副本,以因應全球用戶需求。

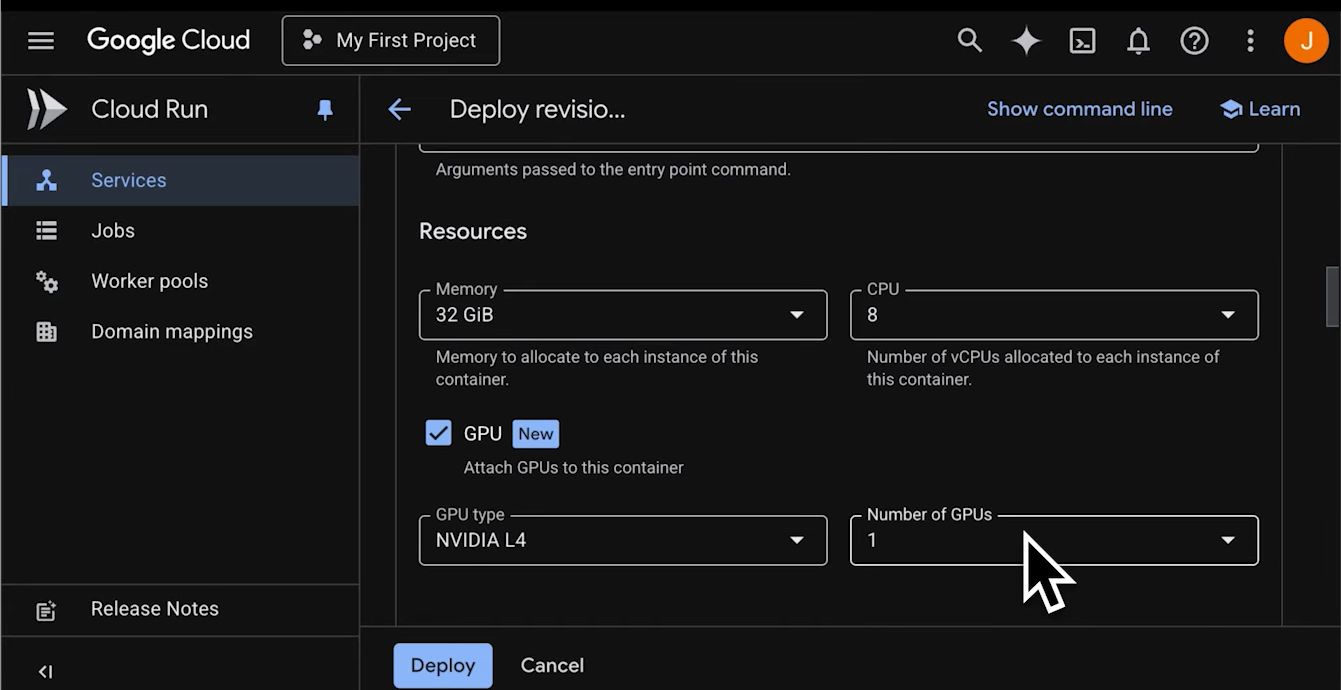

除此之外,機器學習平臺Vertex AI可選用G4虛擬機器進行AI推論與訓練,資料分析平臺Dataproc能運用G4虛擬機器加速大型Spark與Hadoop工作負載;Google Cloud也預告無伺服器型態的容器應用執行服務Cloud Run,很快將提供Nvidia RTX Pro 6000的GPU選項,以便用戶能夠更隨需存取這款GPU運算服務。

產品資訊

Google Cloud G4

●原廠:Google Cloud

●建議售價:asia-southeast1-b區域,g4-standard-48、1張GPU,每月預估3,944.01美元

●處理器:AMD第五代EPYC(9B45)

●提供服務規模選擇與最大組態:

g4-standard-48、g4-standard-96、g4-standard-192、g4-standard-384,384顆虛擬處理器、1,440 GiB記憶體、本機儲存空間為12,000 GiB、8張Nvidia RTX Pro 6000 Blackwell Server Edition GPU(768 GDDR7記憶體)、網路頻寬為400 Gbps

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23