美國艾倫AI研究院Ai2發表開源程式開發代理(Open Coding Agents)計畫,首波釋出SERA開源程式開發代理模型,並公開訓練資料與可重現的後訓練流程。Ai2目標是讓開發團隊能把模型快速調整到特定程式碼庫,包含企業內部或個人私有儲存庫,同時也把模型與整合工具放到公開平臺供外界取用。

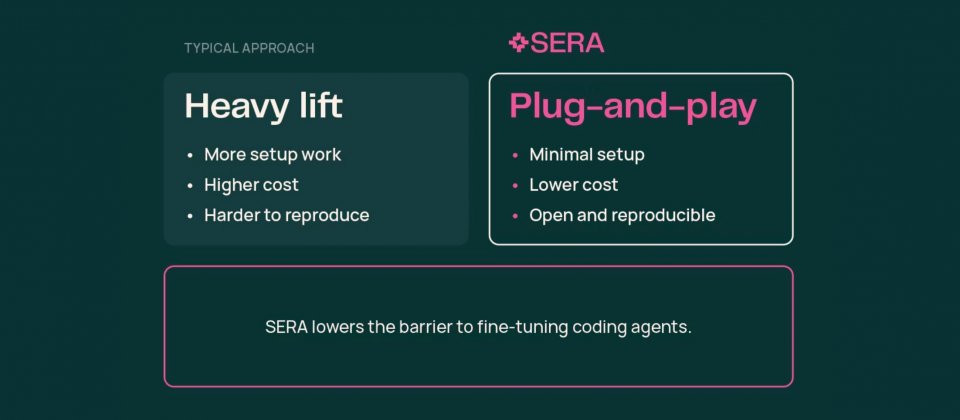

Ai2說明,封閉式模型通常未見過組織內部程式碼與慣例,因此在資料管線、內部API或程式碼風格等情境,容易出現理解落差。Ai2提出以合成資料驅動的後訓練方法,目標是降低私有程式碼庫的調整門檻。官方估算,重現先前最佳開源成果約需400美元的運算資源。若要把效能推進到同級尺寸的業界頂尖模型水準,成本最高約1.2萬美元,讓實驗室與小型團隊也較能負擔完整配方。

在基準測試上,Ai2表示SERA-32B在SWE-Bench Verified的解題率可達54.2%,並稱以約40個GPU日或更少即可完成訓練,部署時也能直接相容於Claude Code。Ai2另與Nvidia合作,進行推論最佳化,提升在H100與B200等平臺的吞吐量。

Ai2設定SERA為軟驗證的高效率儲存庫代理,其作法是先產生包含修補程式的合成開發軌跡資料。這些修補程式不必完全正確或通過完整測試驗證,也能用於訓練,藉此降低對測試環境與測試基礎設施的依賴,同時壓低合成資料生成成本。Ai2也引用既有分析整理的51種常見程式臭蟲型態,擴充資料多樣性,讓同一段函式程式碼能衍生出多種任務情境,增加訓練資料涵蓋面。

在針對特定儲存庫調整後的表現上,Ai2以Django、SymPy與Sphinx等SWE-Bench大型儲存庫進行專案化訓練,稱每個儲存庫僅用8,000筆合成開發過程資料做監督式微調,就能在部分設定下達到或超過教師模型GLM-4.5-Air,並公布在32K上下文條件下,Django與SymPy的成績分別為52.23%與51.11%。

Ai2也釋出SERA CLI與Claude Code相容層,並在PyPI提供ai2-sera-cli套件,說明其用途是讓Claude Code CLI可對接SWE-agent格式模型。官方表示本次釋出內容涵蓋模型、整合與訓練配方,讓研究者能檢視資料與方法,並在自身環境重現與延伸應用。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-25

2026-02-23