Google DeepMind聯手全球33家學術實驗室,將22種機器人累積執行的15萬項任務、527個技能、100多萬個場景資料彙整為標準化格式資料集並開源。

重點新聞(0929~1006)

Google DeepMind 機器人 通才

超大機器人資料集開源,涵百萬場景可訓練通才機器人

Google DeepMind聯手33間學術實驗室,將22種機器人累積執行的15萬項任務、527個技能、100多萬個場景資料彙整為標準化格式的資料集Open X-Embodiment,並開源出來,是目前該領域最大的資料集,可用來訓練通才機器人。

團隊指出,一直以來,開發者得根據不同任務、環境和機器人來個別訓練模型,甚至光是更改1個變數,就得從頭訓練。而他們發表的Open X-Embodiment就是要解決這個問題,團隊也用該資料集訓練2個機器人模型,一是用來控制機器人的Transformer模型RT-1-X,團隊測試發現,該模型執行任務的平均成功率,比專門設計的模型高出50%,如開門的表現更好。

另一個是視覺-語言-動作模型RT-2-X,可理解機器人看到和聽到的內容,不過,該模型訓練時不只用了資料集,也用了網路資料。經測試,RT-2-X比前代的機器人模型RT-1和RT-2更好,而且,2款機器人也能執行訓練時沒見過的任務。團隊分析,這是因為,模型的訓練資料更多樣化且跨機體,還能讓特定領域訓練的模型,泛化表現更好。為推進通才機器人領域的研究,Google DeepMind團隊開源資料集和模型,來供社群進行更多研究。(詳全文)

XGBoost 2.0 排名 記憶體

XGBoost 2.0.0來了,支援聯邦學習、優化排名任務能力

機器學習演算法XGBoost最近升級了,最新的XGBoost 2.0版不只修復重大錯誤,還支援聯邦式學習、外部記憶體優化和統一的device參數,企業可用來處理更複雜的資料、打造更好的推薦和排名應用。

XGBoost是表格等結構化資料機器學習任務的好用解法,新版刪除了多種CPU和GPU特定參數,改為統一的device參數,來簡化執行作業。同時,新版也將hist樹方法設為預設值,來提高模型訓練效率和一致性,另也新添支援GPU的近似樹方法,但該方法的效能還在優化中。此外,XGBoost 2.0改善了外部記憶體的訓練效能和使用,降低CPU記憶體使用量。

特別的是,XGBoost 2.0還針對學習排序任務,提供一系列新功能和參數,來改善排名表現。另外,2.0版也支援多種樹方法和垂直聯邦式學習應用,還為PySpark介面新添不少功能,如GPU預測、資料初始化優化、訓練日誌優化等。(詳全文)

LLM 長序列 StreamingLLM

高效框架StreamingLLM可處理無限長度文本

麻省理工學院、Meta AI和卡內基美隆大學聯手開發一套框架StreamingLLM,可讓語言模型處理無限長度的串流輸入,來解決語言模型部署在串流互動應用程式中,可能遇到的記憶體消耗與泛化長序列等問題。因為,LLM在解碼階段時,快取先前token的鍵值狀態會消耗大量記憶體,而主流的語言模型,無法泛化適用到超過訓練序列長度的長文本中。

Transformer架構模型,特別是使用注意力機制時,每個token會被映射為鍵和值兩種狀態,以用於注意力運算。這種設計能讓模型根據每個輸入token的上下文關係,來動態調整輸出結果。而StreamingLLM採取注意力下沉策略,透過保留注意力下沉token的鍵值,並與滑動窗口近期token鍵值結合,來確保注意力運算維持穩定。

團隊測試發現,StreamingLLM能讓Llama 2、MPT、Falcon和Pythia等模型處理高達400萬個token的文本。而且,使用專為注意力下沉設計的token進行預訓練時,還能進一步提高模型的串流運算效能。(詳全文)

MongoDB 生成式AI 開發

開發應用更容易了!MongoDB釋出生成式AI新功能

生成式AI深入各領域,MongoDB在原有開發工具中也導入生成式AI功能,如MongoDB Compass、Atlas Charts、Relational Migrator等,來提高開發者的生產力,加速打造應用程式。首先,MongoDB的GUI工具Compass新添AI功能,在1.40.0版公開預覽,用戶可用自然語言建立複雜的資料查詢和聚合。而Atlas Charts視覺化工具也新增了自然語言支援,開發者可用視覺化Atlas資料。

此外,MongoDB也用AI來協助開發者搬遷資料庫,當開發者要從原有資料庫轉而使用MongoDB時,官方提供一個Relational Migrator工具,能將現有SQL查詢和儲存程序,轉換使用MongoDB Query API語法,透過SQL查詢轉換功能,開發者就減少了手動建立MongoDB查詢的工作,加速專案轉移。不過,該功能目前為私人預覽。最後,MongoDB還推出Chatbot,來讓使用者用自然語言提問,Chatbot會提供參考文章、程式碼範例和各種相關資訊。(詳全文)

輕量化 GAN 低階裝置

開源新選擇,Mistral 7B輕巧、表現還比2倍大的Llama 2好

AI新創Mistral AI以Apache 2.0授權開源Mistral 7B語言模型,雖然只有73億參數,但在所有基準測試上,表現都比規模更大的語言模型。比如在常識推理、世界知識、閱讀理解、數學和程式碼等測試,不只明顯優於Llama 2 13B,也和Llama 34B打成平手,其編寫程式碼的能力還接近CodeLlama 7B,並在英文任務中表現良好。

Mistral 7B運用群組查詢注意力(GQA)來加速推理,還使用滑動視窗注意力(SWA),以更小的運算成本處理更長的序列。群組查詢注意力方法能分組多個查詢並同時處理,減少重複計算,進而提高推理速度、降低運算成本。滑動視窗注意力機制則限制模型,在神經網路的每一個層級,只能關注前面一定範圍的token,這個限制視窗會根據模型的層數向前滑動,在更高的層數中,模型能夠間接關注序列中更早出現的token,來降低記憶體需求,還能更高效處理長序列,Mistral 7B每層注意前4,096個隱藏狀態,能夠以線性計算成本提高處理速度,特別是序列長度為16,000時,速度快上2倍。(詳全文)

Llama 2 Long 長序列 Meta

Meta開源模型Llama 2 Long,可處理更長文章

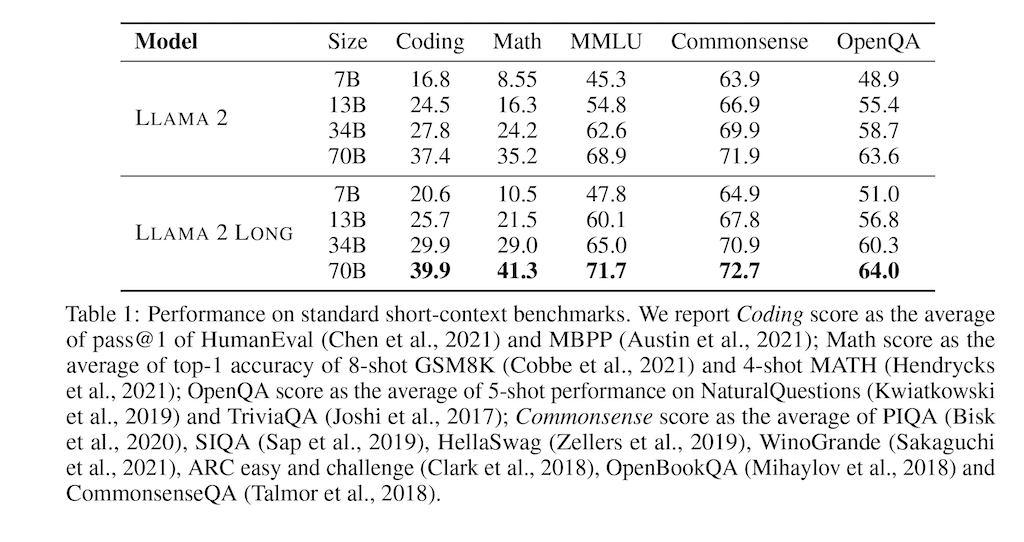

LLM能處理多長的文章,成為新研究議題,Meta日前就發表新語言模型研究論文,提出可處理長文本的模型Llama 2 Long,最多可處理32,768個token。經基準測試評估,在長上下文任務方面,該模型比LLAMA 2還要好,且就700億參數版本表現比gpt-3.5-turbo-16k還要好。

Llama 2 Long以LLAMA 2為基礎,另以4,000億個token進行預訓練。這些token分割為許多較小序列,來訓練各種模型版本,如70億與130億參數的模型,就使用長度32,768個token的序列進行訓練,而340億與700億參數的模型,則使用長度為16,384個token的序列。之後,團隊以語言建模、合成任務等基準測試來評估模型表現,他們發現,與Llama 2相比,Llama 2 Long不只在長上下文任務有明顯進步,在標準短上下文任務(如程式開發、數學和知識基準),也有所改進。(詳全文)

AWS 生成式AI 視覺化

AWS一口氣釋出多項生成式AI新功能

最近,AWS在多個服務加入生成式AI新功能,像是全託管AI平臺Amazon Bedrock正式推出、提供更多強大的模型,而程式碼編寫助理Amazon CodeWhisperer新增客製化功能,商業智慧解決方案Amazon QuickSight Q也加入語言模型來簡化資料分析任務。

Amazon Bedrock是一個基礎模型API服務,用戶可透過API存取Amazon和AI21 Labs、Anthropic、Cohere、Meta、Stability AI等第三方的基礎模型,這次正式推出的同時,也增加Llama 2和Amazon Titan Embeddings等新模型供用戶選擇。此外,Amazon Bedrock還獲美國醫療資訊規範HIPAA認證且符合歐盟個資法GDPR,企業可用來開發醫療保健應用。再來,Amazon QuickSight Q讓用戶不需學習SQL或商業智慧工具,用自然語言就能查詢資料,現在更導入語言模型、推出Generative BI功能,來讓用戶以自然語言來詢問,快速建立資料視覺效果,如「top 10 products」。(詳全文)

LLM Google 生成式AI

Google釋出新工具,網站可拒絕內容成為AI訓練資料

繼OpenAI提出新方法來讓內容擁有者拒絕資料被爬蟲、成為生成式AI訓練資料後,Google最近也釋出新工具Google-Extended,來讓網站決定內容是否用來改善Bard和Vertex AI的生成式模型,只需透過robots.txt即可啟用該工具。

不少LLM都用公開網路資料來訓練模型,如OpenAI的GPT,但OpenAI先前打造網路爬蟲軟體GPTBot來蒐集網路資料、用來訓練模型,若出版商不同意,可在robots.txt中直接封鎖這些爬蟲。然而當時出版商無法直接封鎖來自Google的爬蟲軟體,因為這可能影響網站在Google搜尋結果中的能見度。因此Google特別設計Google-Extended,來供出版商使用。(詳全文)

圖片來源/Google DeepMind、MongoDB、Meta、AWS

AI近期新聞

1. Google揭露生成式AI加持的Google Assistant with Bard,但未說明上線時間

2. Meta聊天機器人Meta AI上線,會互動、生成圖片

資料來源:iThome整理,2023年10月

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-25