Nvidia發表新的高效能系統模組(SOM)系列Jetson Orin Nano,該系列針對人工智慧應用,提供高於上一代Jetson Nano 80倍的人工智慧運算效能。在最新的Jetson系列產品發布後,該產品線現在支援各種邊緣人工智慧應用的效能需求,從入門級的Jetson Orin Nano,到最高效能Jetson AGX Orin,供用戶按需求擴展其應用程式。

Nvidia提到,各產業對於即時處理能力需求增加,包括智慧相機、手持裝置、服務機器人、無人機以及各種入門級人工智慧應用,而這些應用面臨類似的挑戰,那便是這些需要在裝置上,低延遲處理來自各種感測器工作管線的資料,同時還要節能、成本最佳化,更要符合小尺寸的限制。

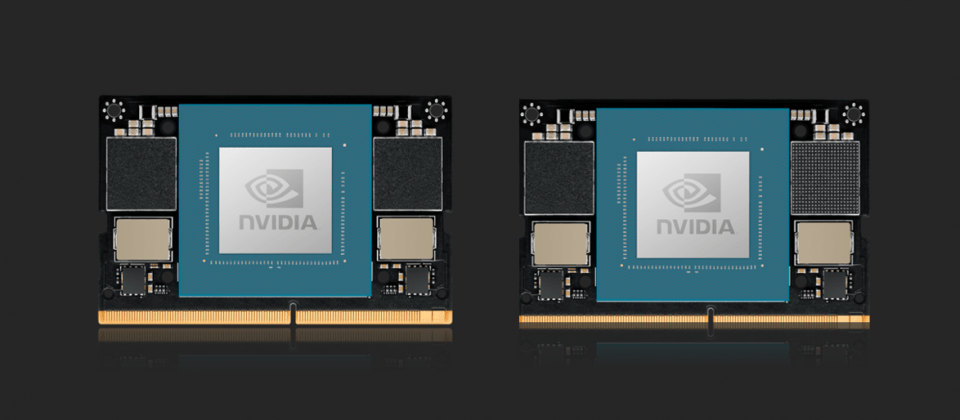

Jetson Orin使用Nvidia Ampere架構GPU以及Arm CPU,並且配備深度學習和視覺加速器,同時也支援高速介面、高記憶體頻寬以及多模感測器,使其能夠用來執行人工智慧應用程式,甚至是智慧機器人作業系統。

Orin Nano模組有兩個版本分別是8GB以及4GB,前者能以7W到15W的功率,提供40 TOPS運算能力,而4GB版本功率則可以低至5W到10W,提供20 TOPS運算能力。

由於Jetson AGX Orin開發人員套件和所有Jetson Orin模組,共用同一個SoC架構,因此開發人員套件可以模擬任何模組,在開發者還沒實際拿到Jetson Orin Nano硬體之前,就能著手開發工作。Nvidia所發布新的程式覆蓋(Overlay),讓開發者能夠使用開發工具包模擬Jetson Orin Nano模組,並且配置成適用於8GB或是4GB的開發工具包,開發並且執行完整的應用程式工具管線。

Jetson可以執行Nvidia人工智慧軟體堆疊,以及特定用例的應用程式框架,像是用於機器人開發的Isaac、電腦視覺DeepStream,或是對話人工智慧Riva,開發者也可以使用Omniverse Replicator來生成合成資料,並使用TAO工具包微調預訓練的模型,增加Jetson上人工智慧應用開發速度。

官方提到,與前一代只能執行簡單應用程式的Jetson Nano不同,Jetson Orin Nano能夠處理複雜應用,並且隨著Isaac機器人作業系統的發展,獲得更高的準確性和吞吐量。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-25

2026-02-23