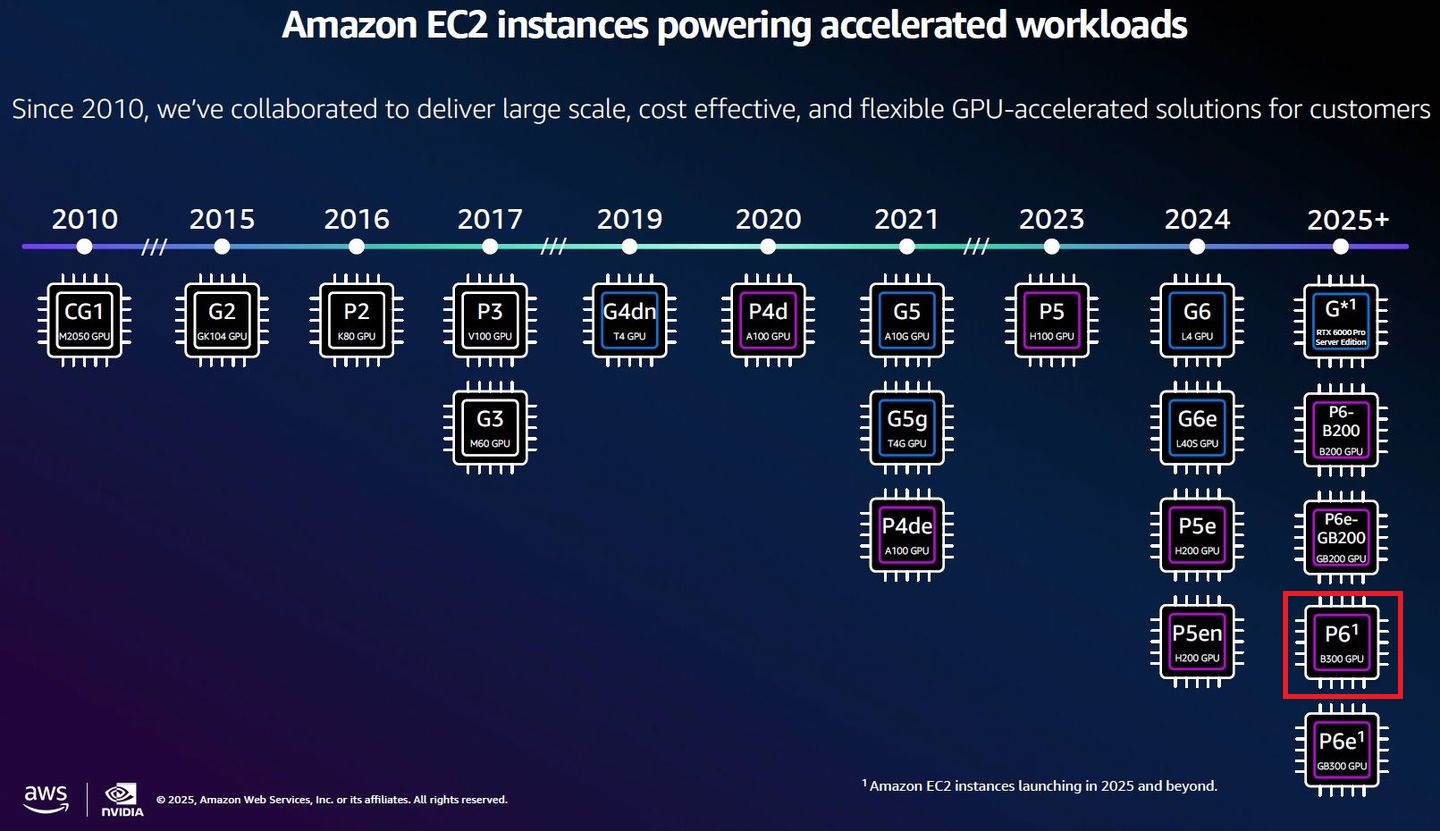

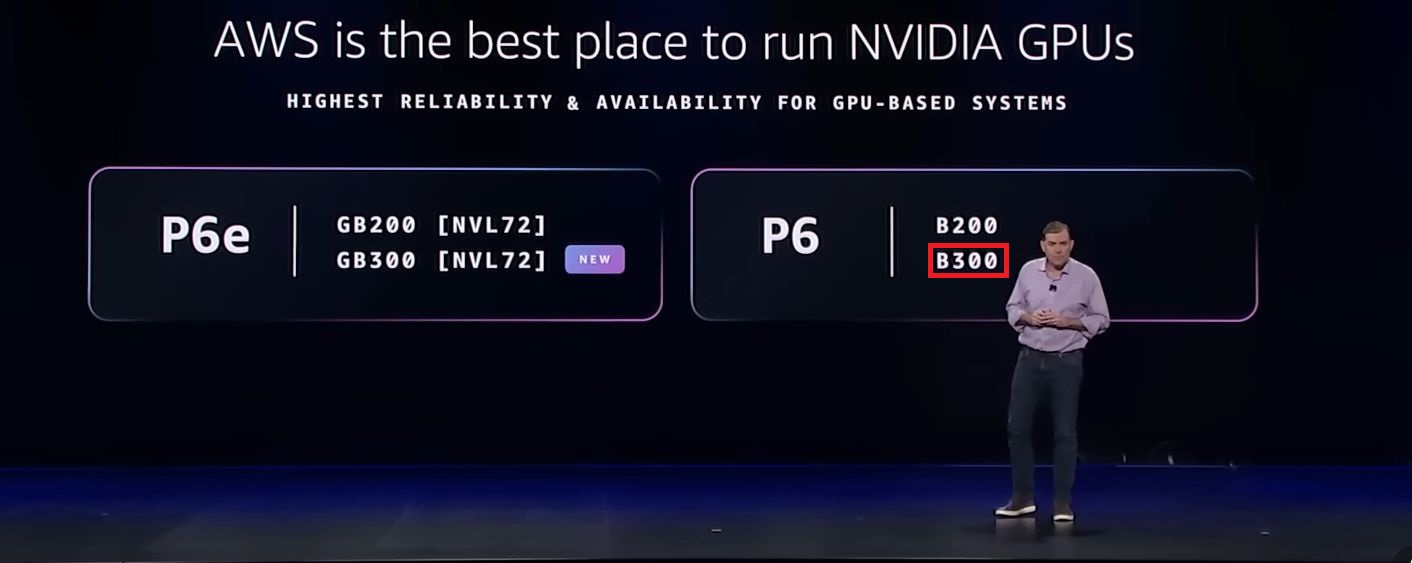

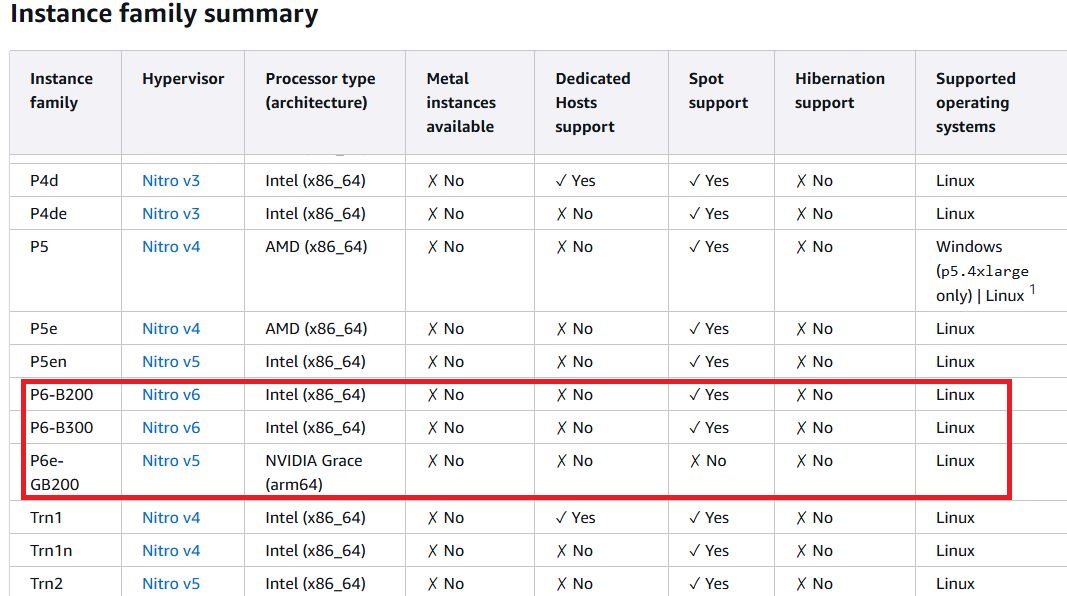

去年AWS陸續推出導入Nvidia Blackwell架構GPU的加速運算服務,例如5月正式推出的P6、7月上線的P6e-GB200,搭配的GPU產品分別為B200、GB200。

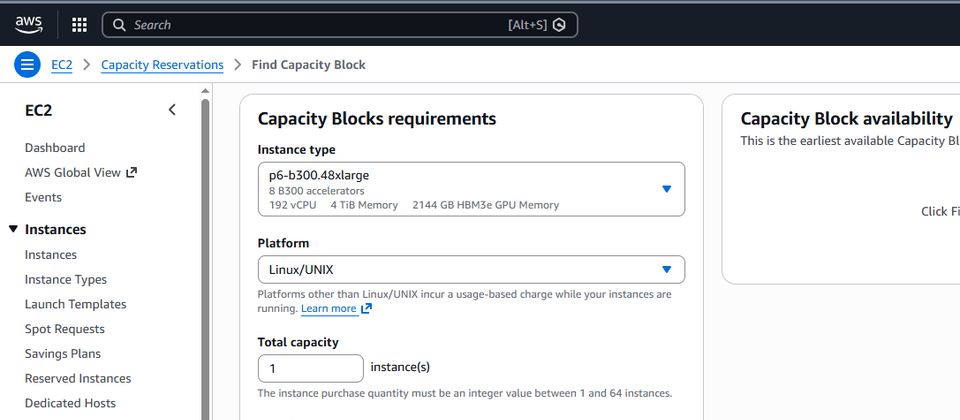

時隔4個月後,AWS宣布P6系列擴增採用性能更強大的B300(Blackwell Ultra)的加速運算服務,稱為P6-B300,有意採用的企業,目前可至美國西部(奧勒岡)的雲端區域,經由適用於ML的Amazon EC2容量區塊(Capacity Blocks for ML)訂購。

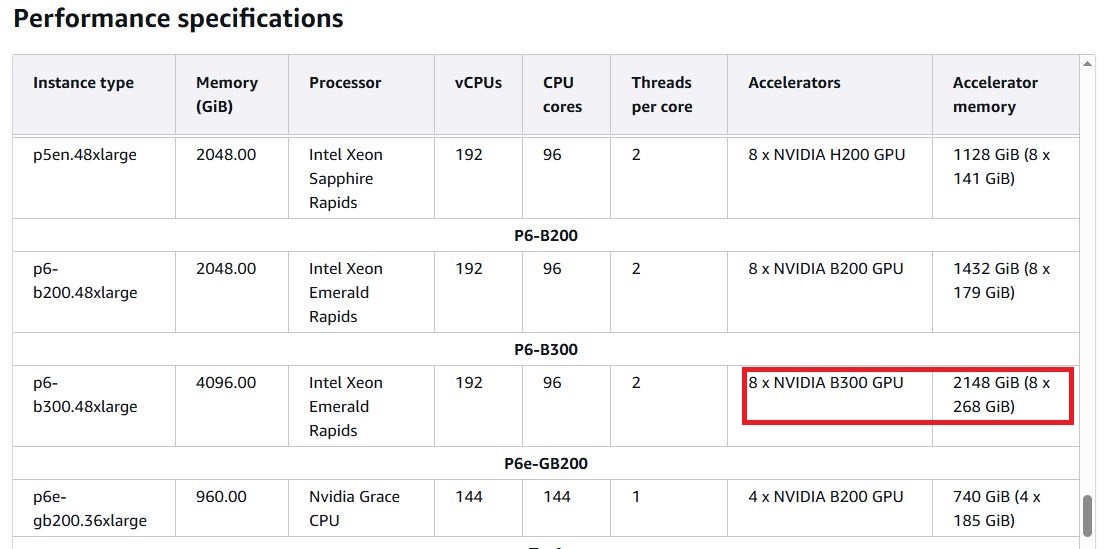

如同稍早推出的P6-B200,P6-B300僅提供一種執行個體組態,分別是p6-b300.48xlarge與p6-b200.48xlarge,系統記憶體內建4 TB與2 TB,同樣搭配96顆核心的英特爾第五代Xeon Scalable系列處理器,提供192個虛擬處理器,以及8個B300 GPU。

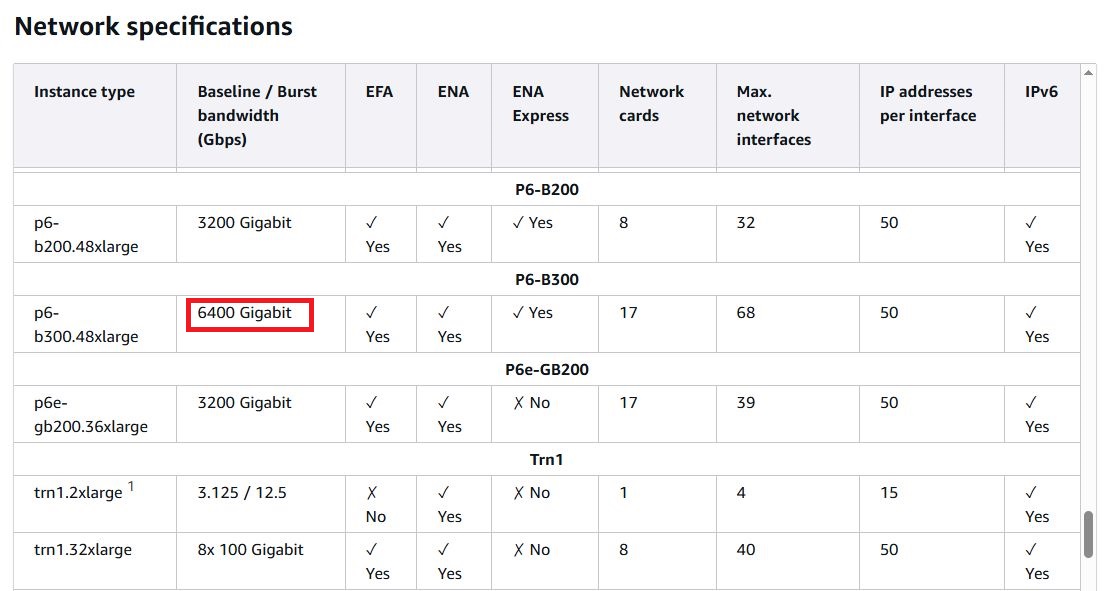

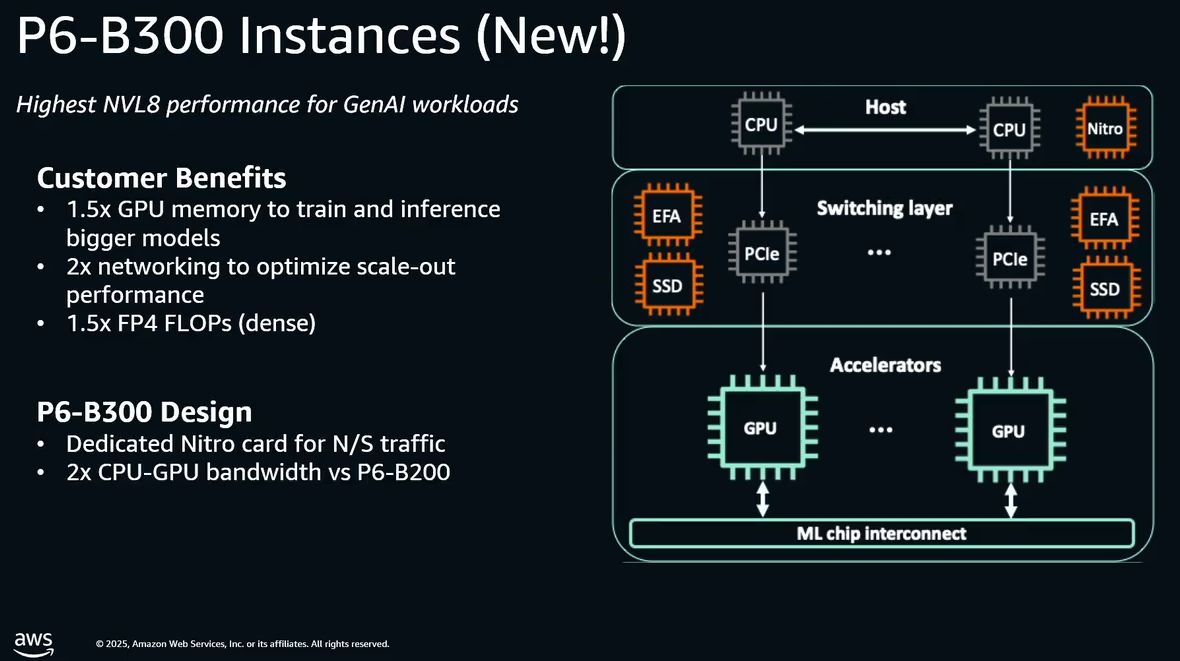

不過,這款加速運算服務,可用的GPU記憶體總容量增加50%(2,144 GB HBM3e vs. 1440 GB HBM3e),GPU提供的FP4浮點運算效能也領先50%(108 PFLOPS vs. 72 PFLOPS),GPU互連頻寬均為1,800 GB/s;而在網路頻寬方面,P6-B300同樣採用第四代EFA網路卡(EFAv4),但受益於I/O介面新支援PCIe 6.0,而能增至兩倍以上(6,400 Gbps vs. 3,200 Gbps),值得注意的是,它也額外配置專屬ENA網路卡,可提供300 Gbps的網路吞吐量。

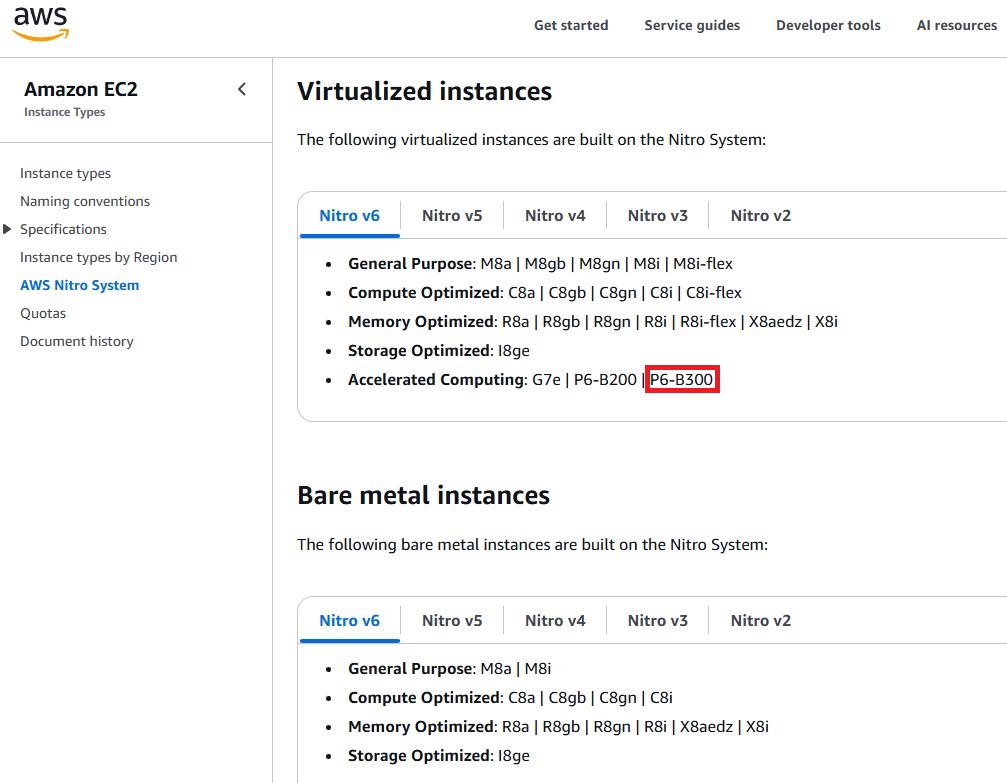

在此同時,如同近期AWS新推出的Amazon EC2雲端運算服務,它也導入Nitro v6系統架構,當中整合EFA網路技術,以及進階的虛擬化與資安防護功能,用於AI工作負載的運作時,提供前所未有的傳輸速度、規模擴展能力,以及安全性。

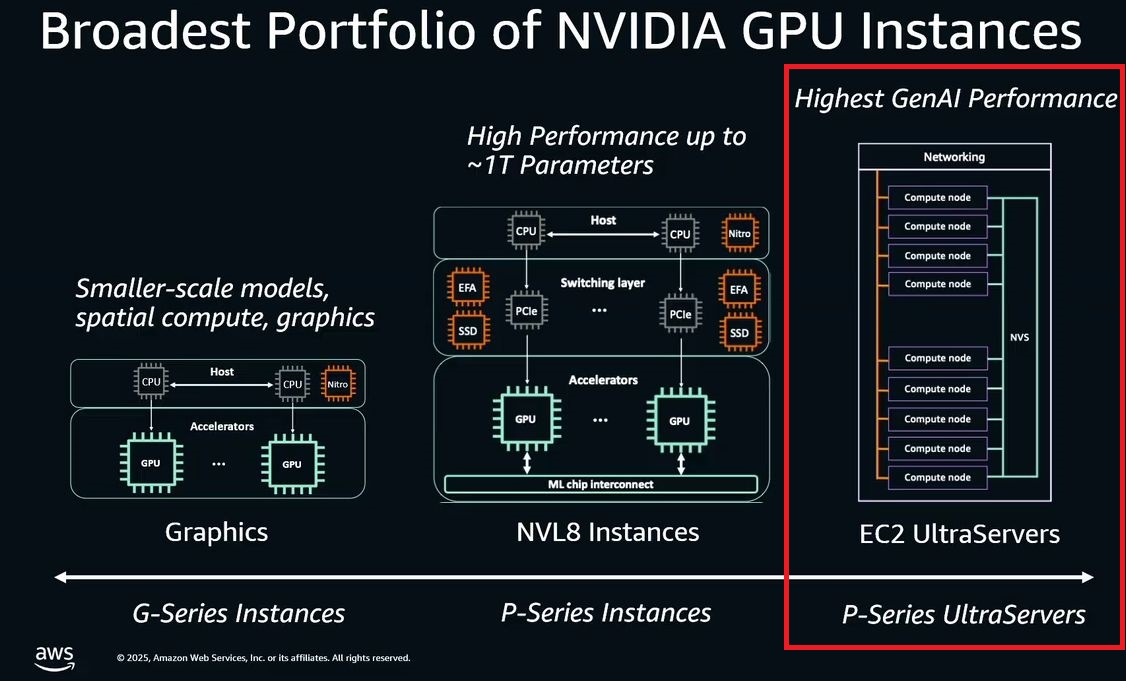

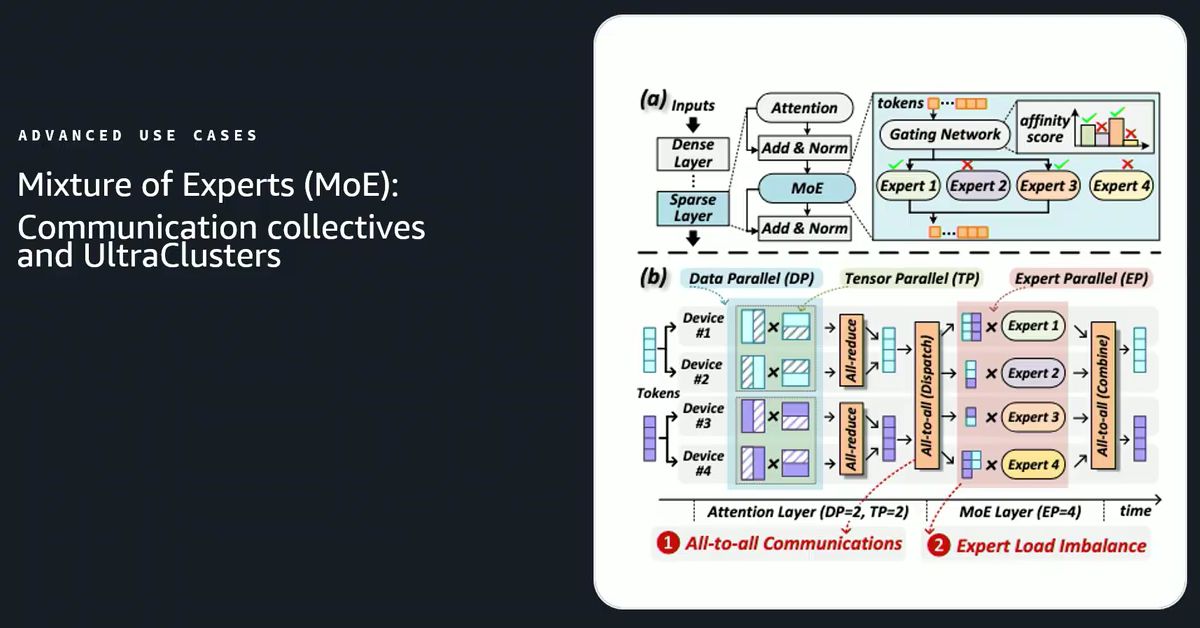

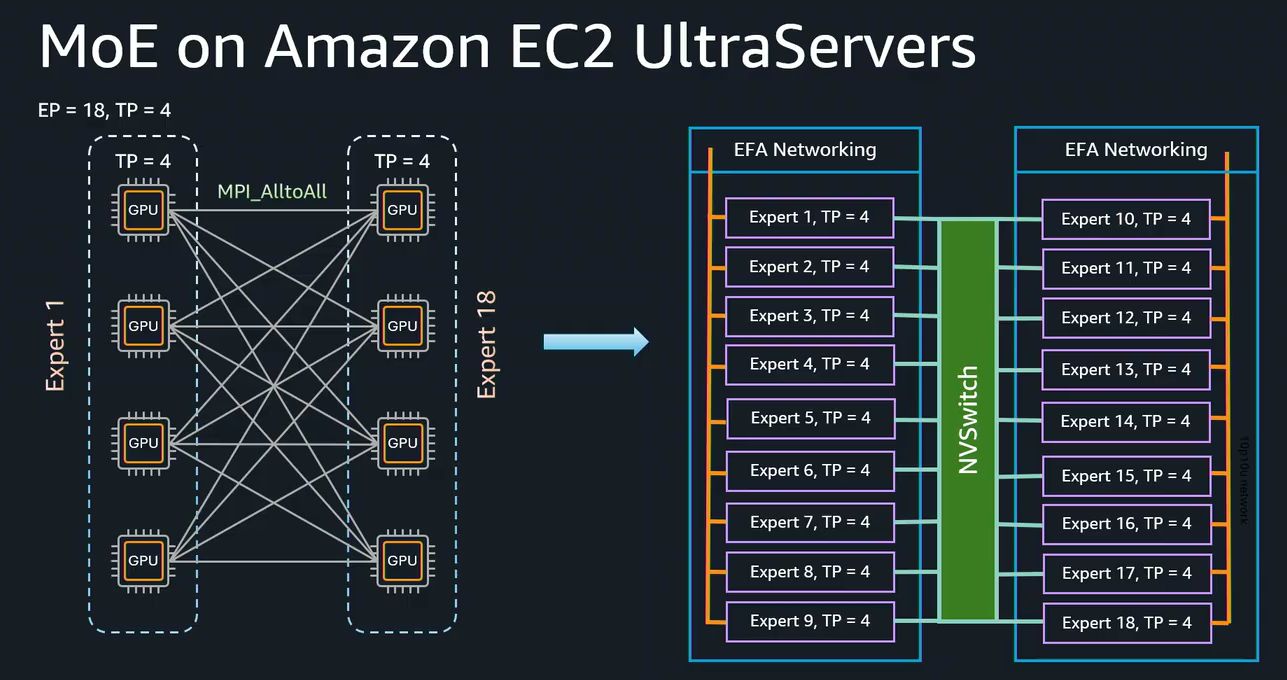

AWS表示,P6-B300可針對大型AI應用系統的執行,提供資源更均衡的平臺,適用於大規模AI模型的訓練與服務存取,尤其需要用到混合專家模型(MoE)與多模態模型處理的工作。

企業若須處理到參數量達到兆級的AI基礎模型與大型語言模型,以及橫跨數千個GPU的分散式AI訓練,可善用P6-B300執行個體,因為這批運算服務具有更平衡的運算、記憶體,以及網路處理能力。

產品資訊

AWS Amazon EC2 P6-B300

●原廠:AWS

●建議售價:美國西部(奧勒岡)區域,p6-b300.48xlarge,隨需每小時142.416美元,Capacity Blocks for ML每個執行個體每小時93.60美元(每個加速器每小時為11.70美元)

●處理器:英特爾第五代Xeon Scalable

●提供服務規模選擇與組態:

p6-b300.48xlarge,192顆虛擬處理器、4 TiB記憶體、30.72 TB本機儲存(8臺3.84 TB)、8個Nvidia B300 GPU、網路頻寬為6400 Gbps,網路儲存:使用AWS區塊儲存服務EBS,存取頻寬為100 Gbps

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-02

2026-02-03

2026-02-04

2026-02-02

2026-02-04

2026-02-03

2026-02-05