Photo by Igor Omilaev on Unsplash

資安業者SentinelOne及Censys發現,開源大語言模型(LLM)框架Ollama在全球的部署,形成了17.5萬臺主機可公開存取的AI運算基礎架構,可能被惡意人士濫用。

Ollama是開源、輕量級且高效的LLM開發框架,允許使用者在自有硬體上執行LLM。研究人員說明,原始設計中,Ollama執行個體綁定在本機接口上,只有在本機上的程式或使用者可以存取。但若使用者或部署者改變服務綁定地址(例如設成0.0.0.0或指向某個公開網路介面),就會經由端點暴露於整個網際網路。而且許多使用者並未配置防火牆或存取控制,導致大量Ollama執行個體可被外部網路存取。

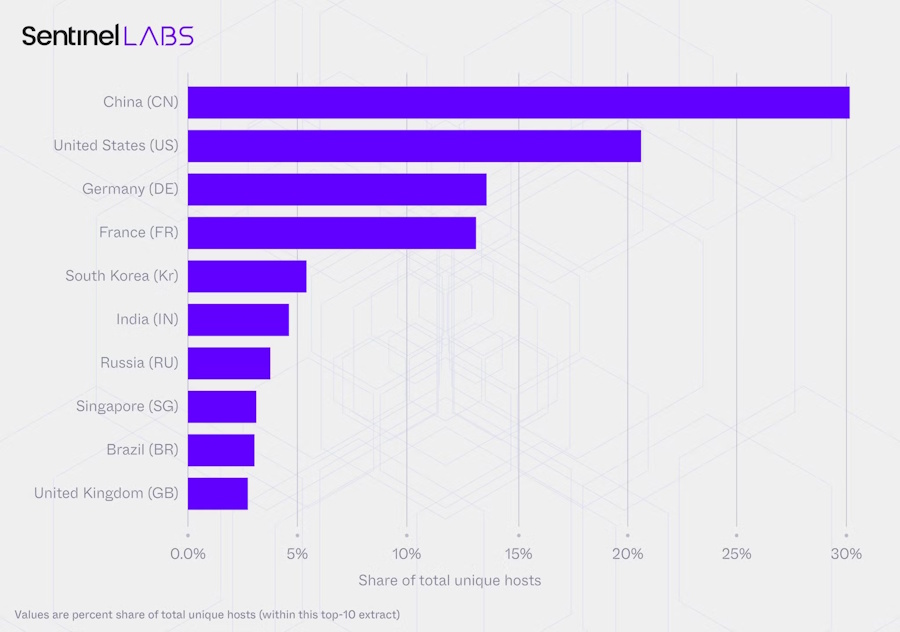

SentinelOne及Censys合作的研究計畫掃描了網際網路可存取的Ollama環境。掃描293天後,他們發現175,018臺Ollama主機,分布於130個國家、4,032個自主系統編碼(Autonomous System Numbers,ASN),其中中國和美國各佔30%和21%。他們紀錄到這17.5萬臺主機執行了723萬次觀察,其中大半活動是來自2.3萬臺主機。

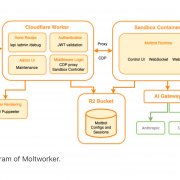

圖片來源/SentinelLABS

為了探究其安全風險,研究人員細究了這些主機的能力。超過48%觀察到的主機具備可以API端點呼叫工具的能力,使其能執行程式碼、存取API和外部系統互動,38%同時具備使用工具及完整任務的能力。他們還發現,至少有201臺主機執行「非審查」(uncensored)的提示範本,可移除安全護欄。

這份報告歸納這一龐大去中心的Ollama主機網路的安全隱憂。首先,這些資源可非經驗證、監控或計費控管來存取,並用於惡意活動如發送垃圾信、釣魚信、假訊息或濫用網路。其次,呼叫工具能力結合驗證不足、公開曝露的主機,能讓駭客執行高權限的運作,像是透過提示注入(prompt injection)攻擊者可能誘導這些LLM查詢或操作本不應暴露的系統資料。研究人員相信這創造最高風險的情境。

公開的Ollama主機運行的語言模型,主要集中在三大主流模型家族:Llama、Qwen2與Gemma2,且這些主機仰賴相同量化格式(如Q4_K_M),形成一個脆弱的單一環境。一旦該模型或格式存在缺陷或可被操控的處理方式,大量暴露系統就可能同時受單一攻擊手法之害。

相關其他二項風險還包括:身份洗白及繞過安全,Ollama網路大量執行在家用網路、低成本VPS此系統,駭客將流量導經家庭網路來隱匿身份、繞過安全過濾及反機器人檢測。另外,欠缺雲端的中央化網路管理機制,一旦被濫用很難透過傳統安全通報或封鎖流程來遏止。

熱門新聞

2026-02-02

2026-02-02

2026-02-03

2026-02-02

2026-02-01

2026-02-02