大語言模型與生成式AI應用大爆發,資料中心GPU成為全球最搶手的商用IT產品,尤其是Nvidia H100,更是炙手可熱,若不願久等伺服器廠商供貨,想要在最短時間內開始使用,可考慮到公有雲服務申租搭配這款GPU的執行個體,目前四大業者都已陸續提供服務。

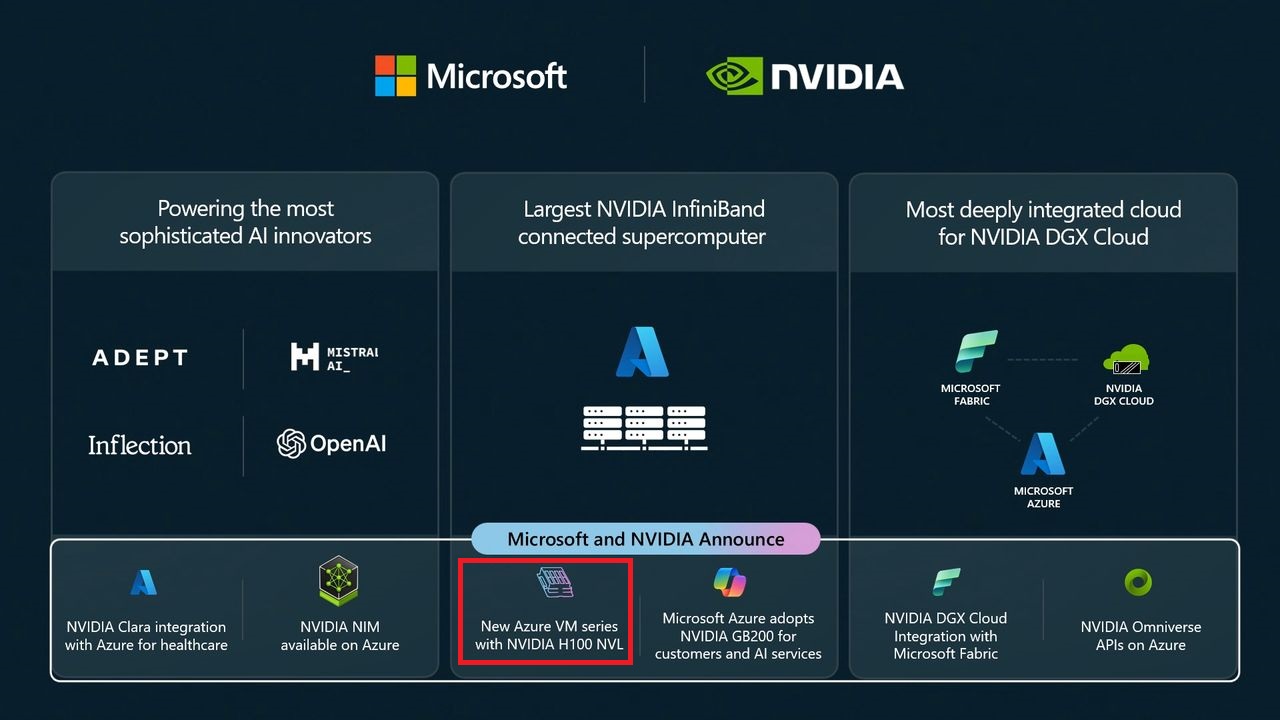

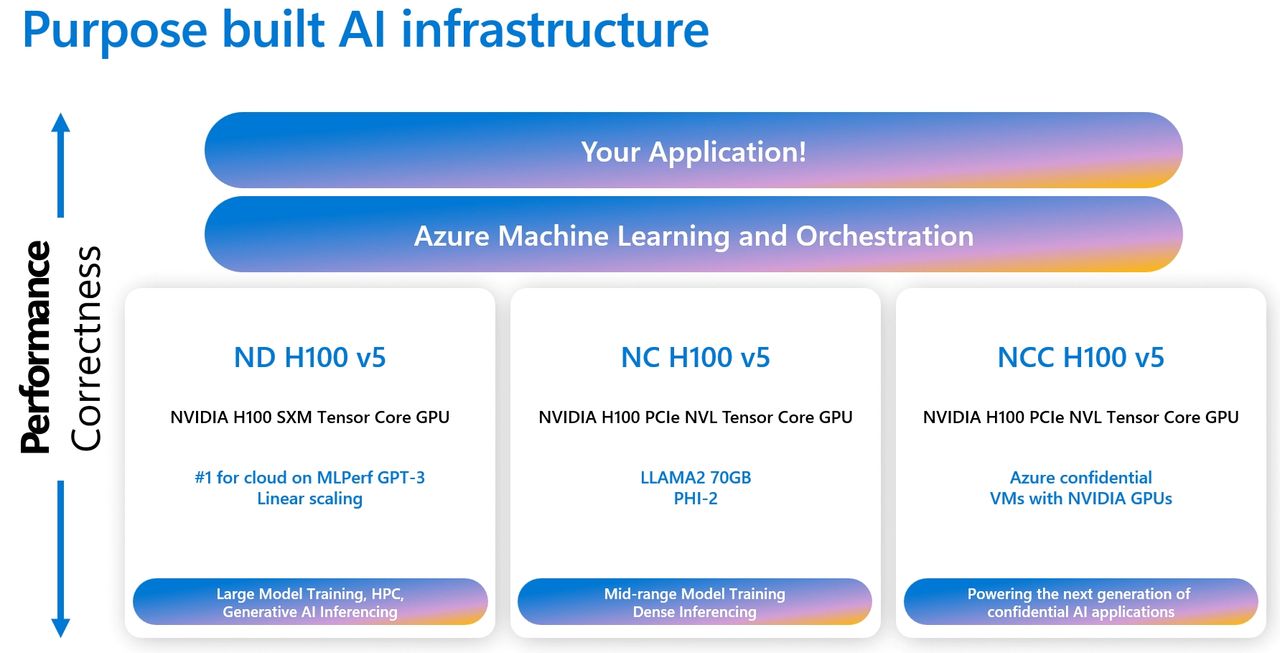

以微軟Azure而言,是最早宣布推出搭配Nvidia H100雲端GPU運算服務的業者,他們在一年前Nvidia舉行GTC 2023大會的前夕,率先發表ND H100 v5,用戶可在此使用8到數千臺Nvidia H100,GPU之間透過Nvidia Quantum-2 InfiniBand交換器互連,同年8月正式上線,但截至目前為止,用戶仍無法在Azure網站入口直接選取建立,有這類需求的用戶要洽詢微軟業務團隊。

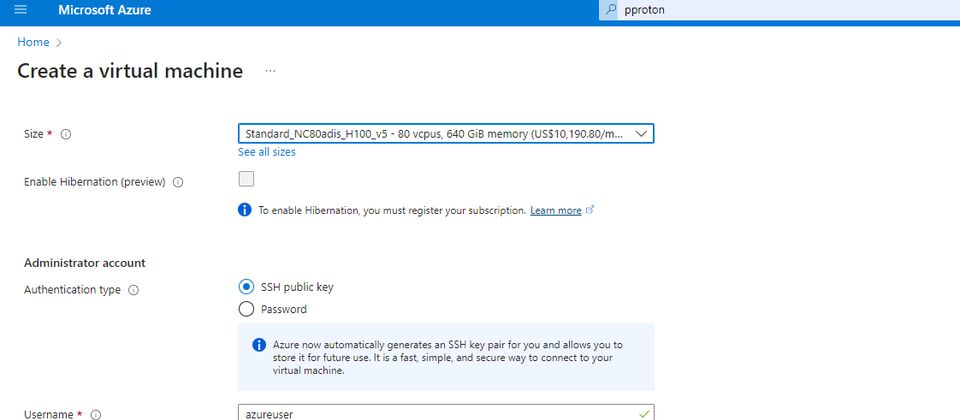

而從今年3月底開始,用戶若要在Azure網站入口,能夠直接選取建立具有Nvidia H100的執行個體,終於有其他辦法,那就是NC H100 v5系列。

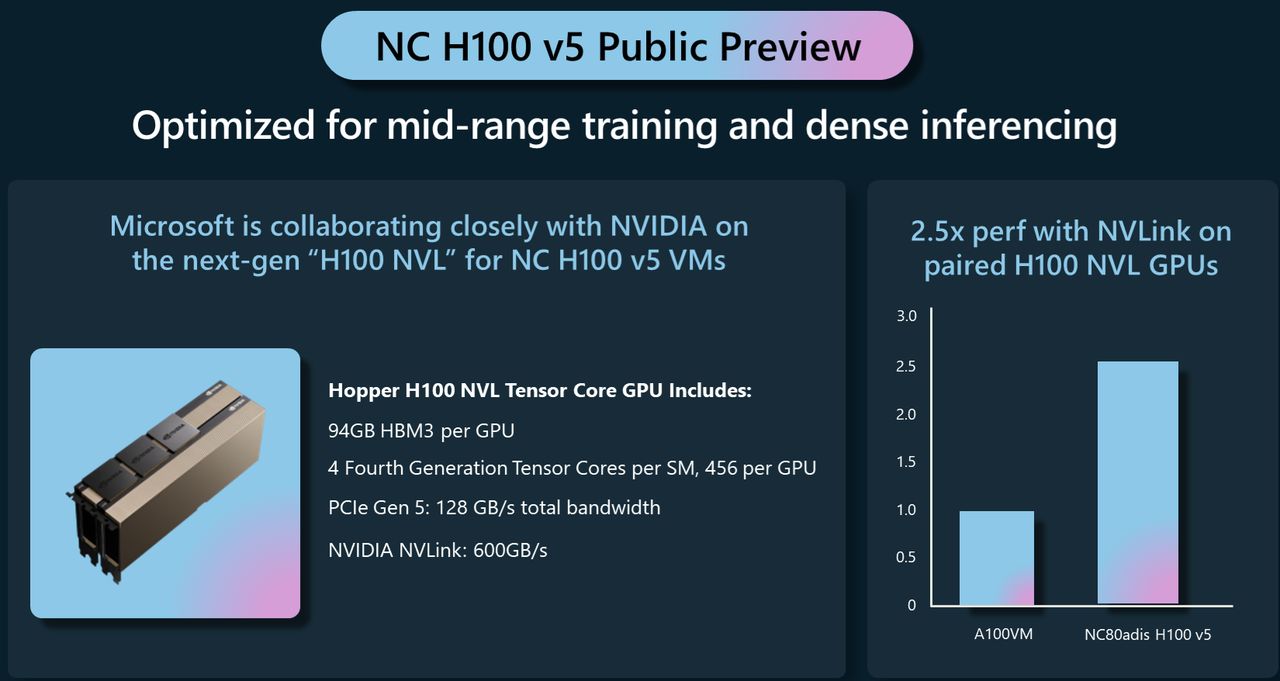

微軟最新宣布正式上線營運的這套GPU執行個體服務,是專為中階AI訓練與推論需求所設計的解決方案,其實是在2023年11月微軟年度企業IT專業人員大會Ignite發表的,也是第一個搭配Nvidia H100 NVL的雲端運算服務。

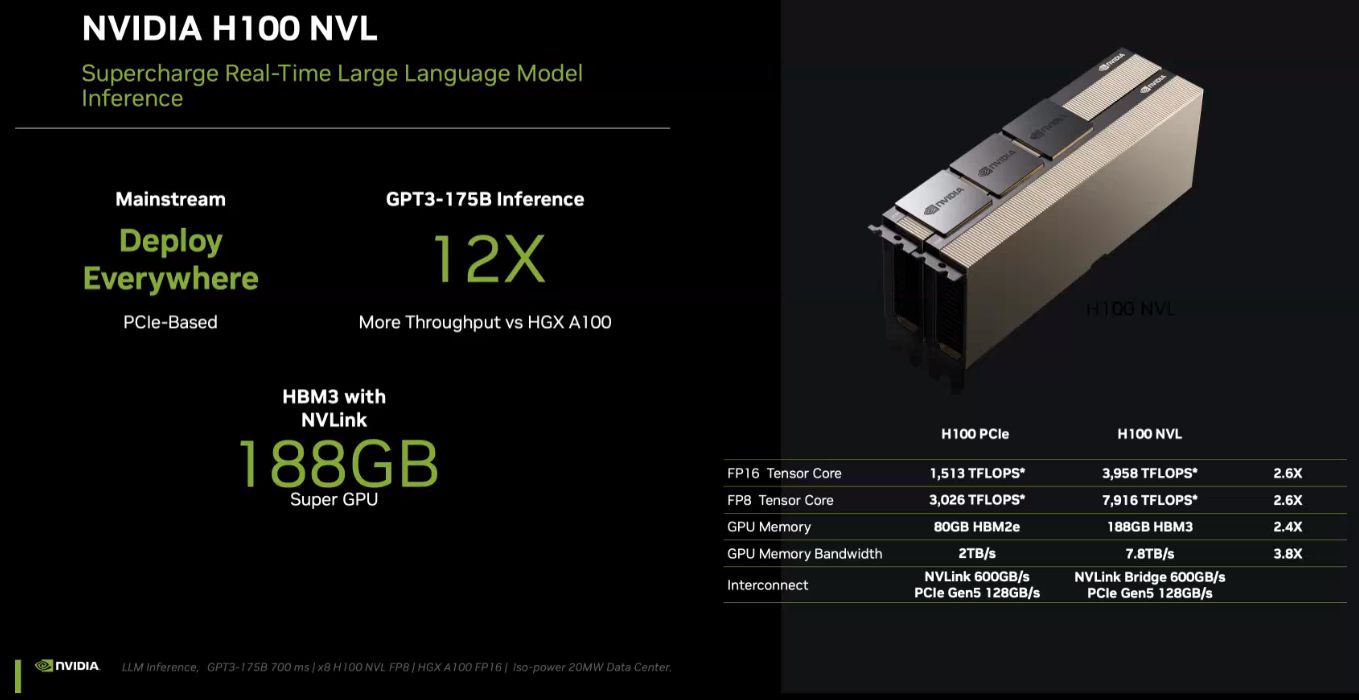

而這款資料中心GPU是Nvidia在2023年3月發表的兩款產品之一(另一款是Nvidia L4),當時Nvidia標榜H100 NVL不僅如同H100支援Transformer Engine加速,而且配備94 GB容量的記憶體,若以上一代資料中心GPU產品A100為基準,用於大型語言模型GPT-3的AI推論時,可提供12倍的效能增長,預計下半年推出。

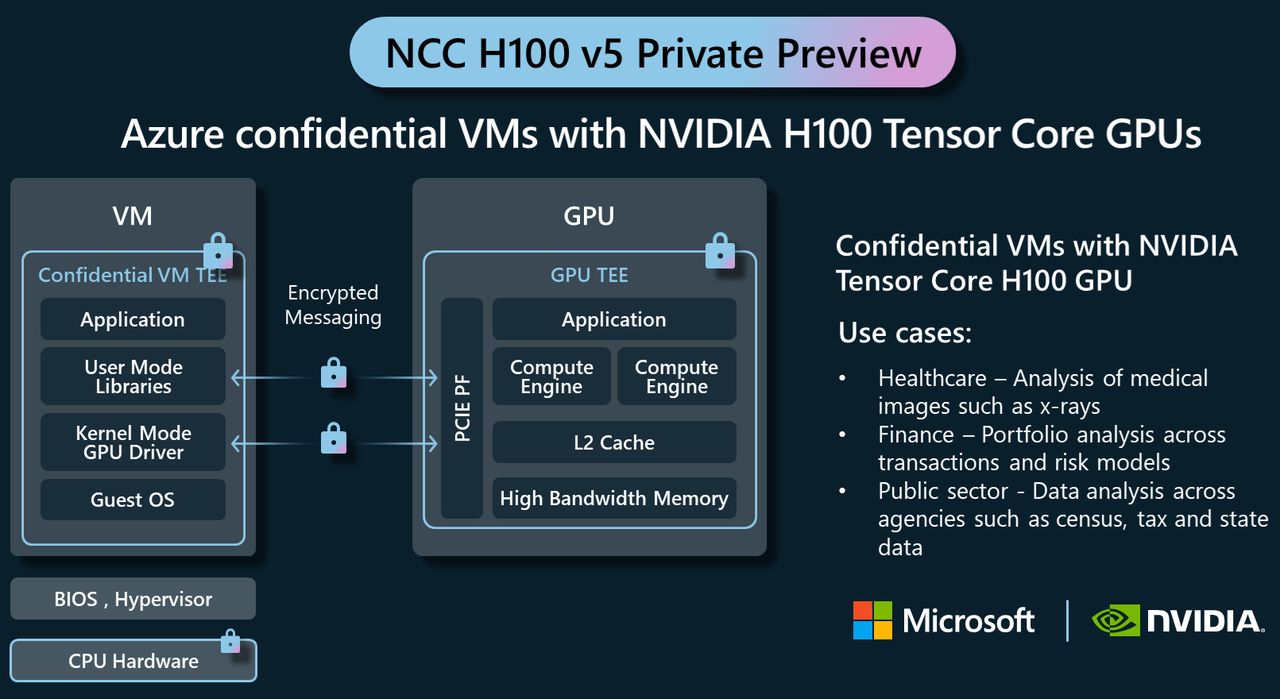

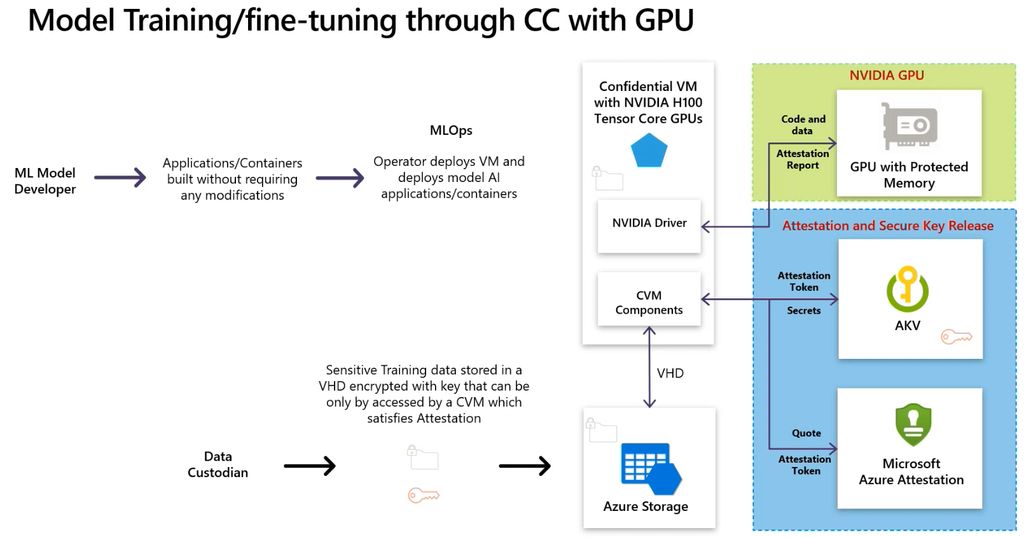

到了2023年11月,微軟發表NC H100 v5系列,呼應原本的H100 NVL上市時程之餘,他們進一步基於這樣的組態而延伸,宣布將推出搭配Nvidia H100 GPU的機密運算虛擬機器服務,稱為NCC H100 v5系列,同樣適合常見開放原始碼AI模型與語言模型的訓練、微調,針對雲端服務環境執行的資料與應用程式工作負載,提供更多兼顧效率與安全性保護的彈性選項。

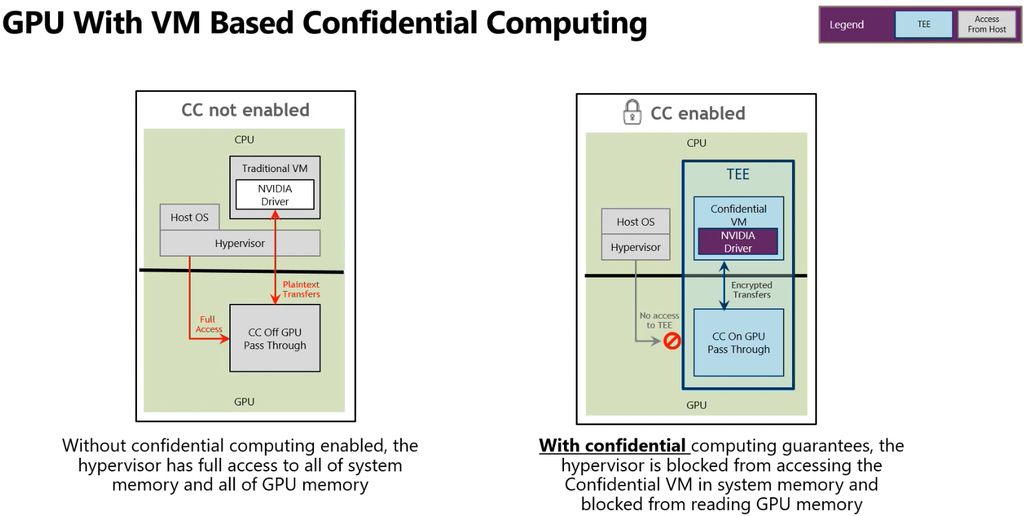

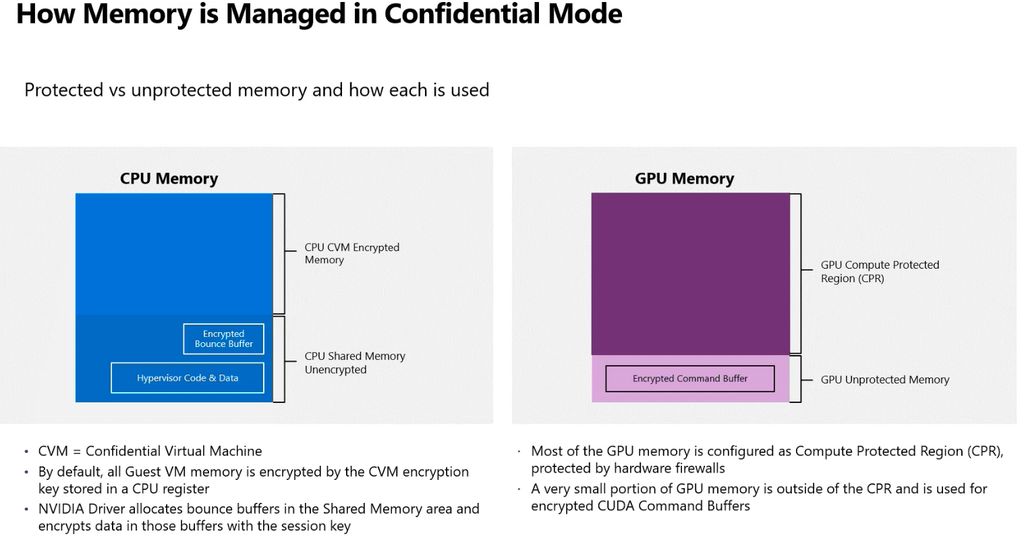

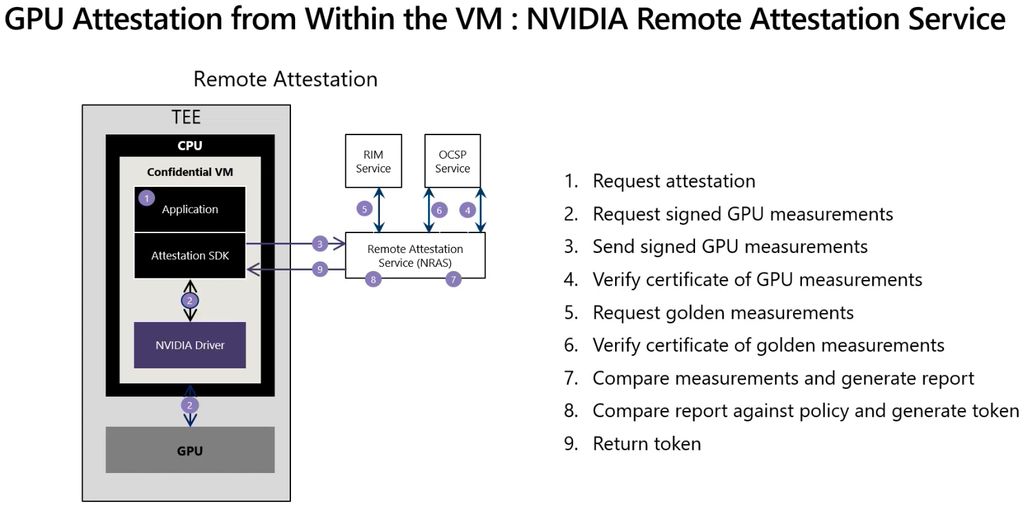

這個GPU機密運算服務將提供4種機制,首先是基於硬體而成的可信任執行環境(Trusted Execution Environment,TEE),可橫跨虛擬機器本身使用的CPU與連結的GPU進行防護,可啟用資料、模型、運算安全卸載至GPU處理的機制;第二是虛擬機器的記憶體加密,當中會運用硬體產生的加密金鑰;第三是加密通訊,當機密虛擬機器與GPU經由PCIe介面進行I/O存取時,可實施加密保護;第四是見證,賦予CPU與GPU產生遠端可驗證的見證報告能力,當中將會擷取CPU與GPU的安全性關鍵硬體與韌體組態。

微軟表示,若使用這套解決方案,指派給虛擬機器的GPU會進入機密模式,此時GPU記憶體與安全性關鍵組態暫存器會受到隔離,能防止未經授權的存取,一旦機密虛擬機器載入GPU裝置驅動程式,隨後就會與GPU之間建立安全通道,並以此執行CPU與GPU之間所有後續的資料傳輸作業,同時,用戶可在發布敏感應用程式與釋出資料加密金鑰等祕密內容之前,提出見證請求,確認虛擬機器與GPU皆執行經過正確設置的TEE環境。基於上述的架構,包含Nvidia CUDA在內的加速應用,均能以透明且受保護的方式執行在這樣的虛擬機器上。

形同搭配記憶體容量更大的H100 PCIe,且能透過NVLink兩兩相連,匯集188 GB的HBM3記憶體

單就GPU規格而言,NC H100 v5系列最顯著的特色在於,可搭配1或2張PCIe介面卡形式的H100 NVL(記憶體容量為94 GB或188 GB,記憶體類型為HBM3,記憶體頻寬單個GPU為3,938 GB/s,兩個GPU為7.8 TB/s),而且這款GPU同樣支援多執行個體GPU(MIG),單張GPU可分割成7個執行個體,每個執行個體的GPU記憶體容量為12 GB。

縱觀目前已推出的Nvidia H100 GPU雲端執行個體服務,可區分為兩種配置,一種是透過NVSwitch與NVLink串連8個SXM外形Nvidia H100的組成架構(個別GPU的記憶體容量為80 GB,記憶體類型為HBM3,記憶體頻寬為3,352 GB/s),例如微軟Azure ND H100 v5、AWS EC2 P5、Google Cloud A3,另一種則是採用PCIe介面卡形式的Nvidia H100(個別GPU記憶體容量為80 GB,記憶體類型為HBM2e,記憶體頻寬為2,000 GB/s),例如,Scaleway、CoreWeave。而在多執行個體GPU(MIG)的配置上,單張H100 GPU可分割成7個執行個體,每個執行個體的GPU記憶體容量為10 GB。

至於新登場的NC H100 v5系列所用的H100 NVL,優勢在於GPU記憶體容量增加17.5%,GPU記憶體頻寬提升17%,而且由於H100 NVL可透過NVLink結合另一張H100 NVL,因此可將記憶體容量匯集為188 GB,提供更大的效能。

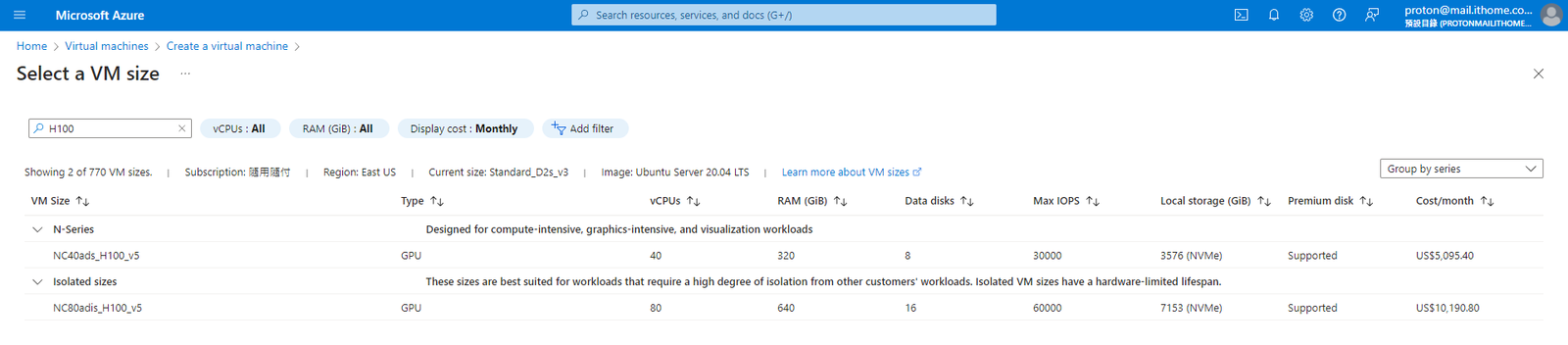

相較於Azure NC系列上一代虛擬機器NC A100 v4系列,NC H100 v5系列還有哪些差異?此系列提供兩種組態:NC40ads_H100_v5、NC80adis_H100_v5,採用AMD第四代EPYC處理器與Nvidia H100 NVL,分別內建40顆虛擬CPU、320 GiB記憶體、1張Nvidia H100 NVL,以及80顆虛擬CPU、640 GiB記憶體、2張Nvidia H100 NVL。

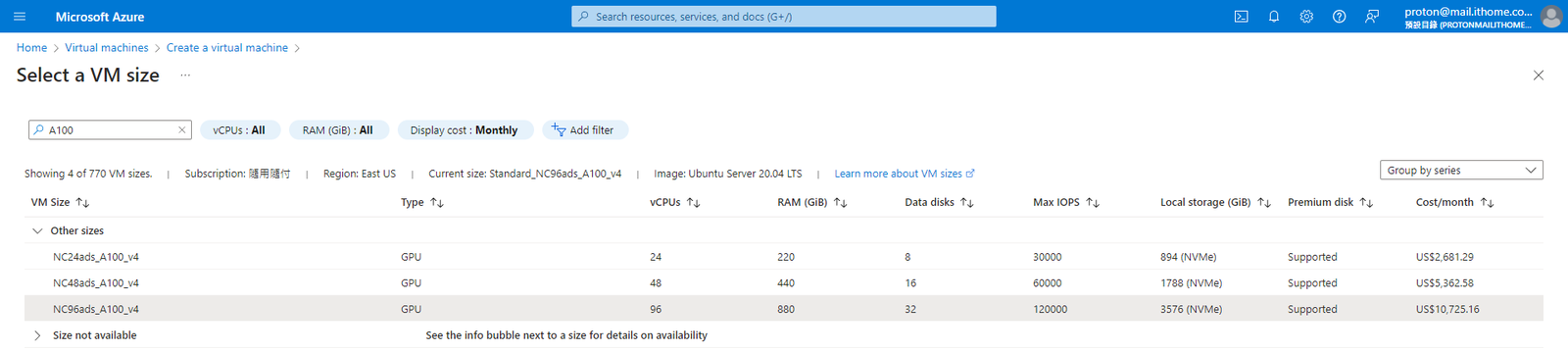

至於既有的NC A100 v4系列,採用AMD第三代EPYC處理器與Nvidia A100 PCIe(記憶體容量為80 GB,記憶體頻寬為1,935 GB/s),提供3種組態:NC24ads_A100_v4、NC48ads_A100_v4、NC96ads_A100_v4,分別內建24顆虛擬CPU、220 GiB記憶體、1張Nvidia A100 PCIe,48顆虛擬CPU、440 GiB記憶體、2張Nvidia A100 PCIe,以及96顆虛擬CPU、880 GiB記憶體、4張Nvidia A100 PCIe。若以同為搭配1張與2張GPU的虛擬機器來對比,NC H100 v5系列的處理器核心數量提升60%,記憶體容量增加45%。

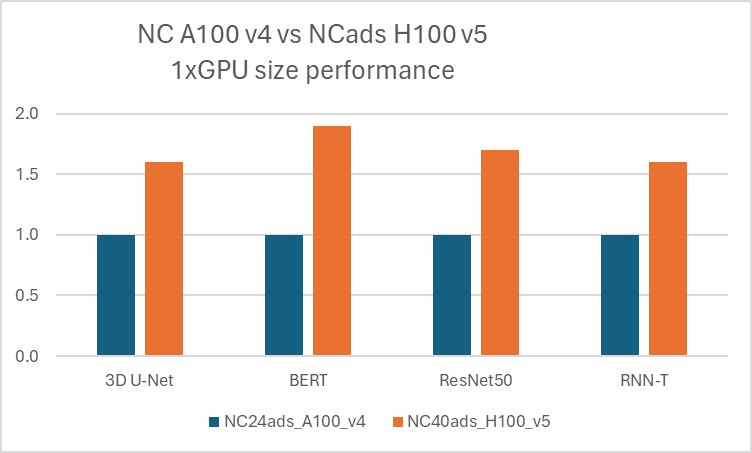

效能超越前代搭配A100 PCIe GPU的虛擬機器,領先幅度超過40%

關於運算效能的表現上,2023年11月微軟公布5組AI推論測試結果,其中4組搭配單張H100 NVL用於常見的AI框架,像是BERT、ResNet50、RNN-T、3D U-Net,領先NC A100 v4系列的幅度為60%至90%,1組是用於60億參數的大型語言模型GPT-J,對比於搭配4張Nvidia A100 PCIe的Dell PowerEdge R750xa,NC80adis_H100_v5的效能可達到2.5倍。

在2024年3月,適逢月中Nvidia召開GTC年度大會,以及月底MLCommon公布MLPerf Inference v4.0效能測試結果,當中恰巧就有一筆紀錄是NC H100 v5系列的NC80adis_H100_v5,以700億參數的Llama2推論而言,若是伺服器存取時,每秒查詢3458.96次,若是離線存取時,每秒處理的樣本數量為3900.33個,微軟強調,相較於其他配備80 GB記憶體GPU的伺服器系統,Azure NC H100 v5系列效能領先幅度可達46%。

而在GPT-J推論運算的部分,微軟NC80adis_H100_v5若是伺服器存取時,每秒查詢42.0691次,若是離線存取時,每秒處理的樣本數量為43.5639個。微軟表示,對照其他雲端服務業者提供配備記憶體小型容量AI加速器(編按應為Google搭配4個TPU v5e的系統),搭配逼近6倍記憶體容量Nvidia H100 NVL的NC80adis_H100_v5,效能增長幅度可達8.6倍至11.6倍。

產品資訊

微軟Azure NC H100 v5系列

●原廠:微軟

●建議售價:NC40ads_H100_v5每月5,095.40美元,NC80adis_H100_v5每月10,190.80美元

●執行個體服務選擇:NC40ads_H100_v5、NC80adis_H100_v5

●搭配處理器:AMD第四代EPYC(Genoa)

●搭配GPU:Nvidia H100 NVL 94 GB

●運算資源配置:

NC40ads_H100_v5為40顆vCPU、320 GiB記憶體、8臺資料硬碟、1張GPU、GPU記憶體94 GiB、NVMe儲存3,576 GiB

NC80adis_H100_v5為80顆vCPU、640 GiB記憶體、16臺資料硬碟、2張GPU、GPU記憶體188 GiB、NVMe儲存7,152 GiB

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23