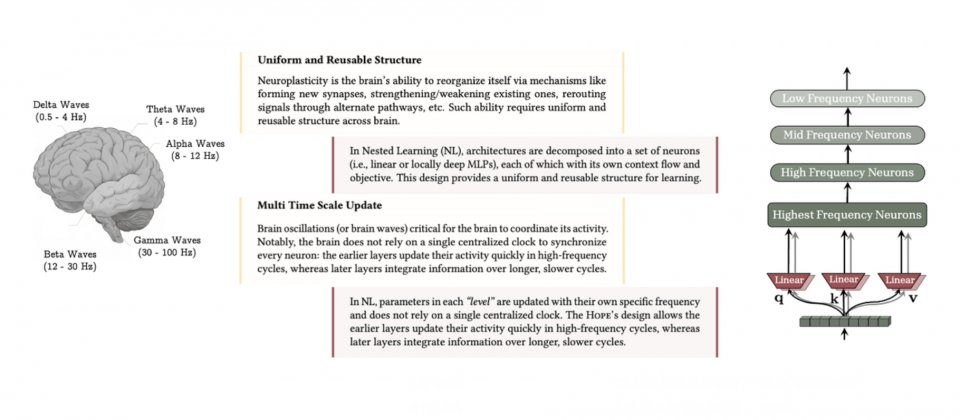

巢狀學習(Nested Learning)模仿人腦以多時間尺度協同運作的機制,讓模型各元件依不同更新頻率學習與整合資訊,使神經網路在持續學習中兼具快速反應與穩定記憶

Google研究人員公開巢狀學習(Nested Learning)這項新模型訓練方法,主張把單一模型視為多個彼此銜接或並行的巢狀學習子問題,並以不同更新頻率運作,目標是在持續學習中降低災難性遺忘(Catastrophic Forgetting),同步提升長內容理解與記憶管理能力。

所謂的災難性遺忘,是模型持續學習時,新資料訓練會把權重往符合新任務的方向調整,結果把原先針對舊任務學到的特徵表示覆寫。

巢狀學習的切入點是重新定義架構與最佳化的關係,研究將模型拆解為多層級的最佳化子問題,各層按照更新頻率排序,並各自擁有脈絡資訊流(Context Glow),形成在多時間尺度上協同運作的學習系統。透過這種層級化設計,模型不只處理輸入視窗中的即時脈絡,也能跨多個時間尺度整合新舊知識,概念上更接近人腦神經可塑性鞏固記憶的機制。

研究人員用一個新的角度重新理解模型內部的運作,他們認為,像反向傳播(Backpropagation)或注意力機制這些深度學習的基本元件,其實都可以被視為記憶過程的一部分。也就是說,模型在學習時,不只是調整權重,而是在建立不同層次的關聯與回憶方式。這種對模型的重新理解,讓研究人員能以統一的架構來看待模型設計。

研究也提出新的連續體記憶系統(Continuum Memory Systems)觀念,主張人工智慧的記憶不該只分成短期與長期兩種,而是應該像光譜一樣,依更新速度形成多層次的記憶結構,讓模型在吸收新知的同時,更穩定地保留舊知識,避免遺忘過往的能力。

Google開發Hope實驗模型來驗證這個想法,Hope可以自行調整記憶方式與學習規則,也就是讓模型學會怎麼學習。相較於過去僅能在固定層次調整的架構,Hope能在更多層面同時更新與最佳化,因此在長時間學習或處理龐大內容時,表現出更好的穩定性與記憶延展能力。

在多項語言建模與常識推理測試中,Hope模型展現出比現有主流架構更穩定,Google指出,Hope在語言模型評測中的困惑度更低,代表模型能以更精確的方式預測句子中下一個詞。在常識推理任務上的準確率也更高,顯示其推理能力與知識整合效果更好。

在更具挑戰性的長上下文任務中,例如大海撈針(Needle-in-a-Haystack)測試,Hope展現出良好的記憶管理能力。官方比較顯示,在不同難度等級的長上下文任務上,Hope與Titans皆明顯優於TTT與Mamba2。

熱門新聞

2026-02-26

2026-02-27

2026-02-27

2026-02-27

2026-02-27

2026-02-26