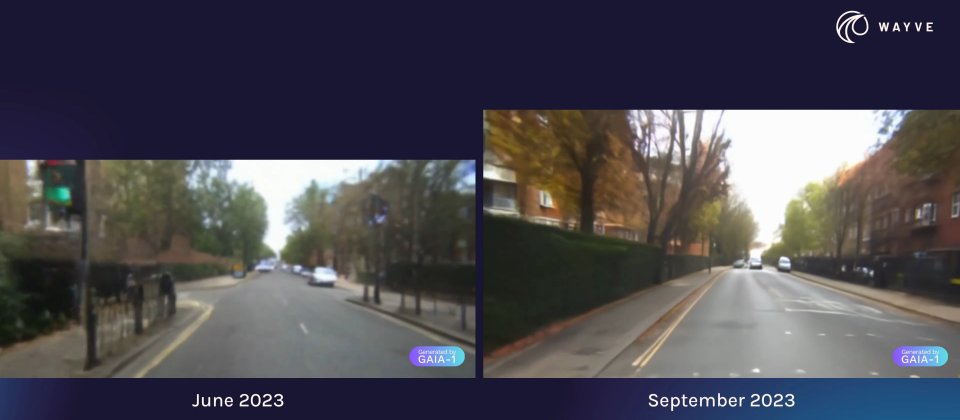

英國AI新創公司Wayve揭露了GAIA-1生成式模型的最新進展,在今年6月的時候,Wayve建立了將生成式模型用於自動駕駛的慨念性驗證,而在這幾個月,Wayve持續擴展GAIA-1,使其擁有90億個參數,能夠生成逼真的駕駛場景影片,呈現自動駕駛在各種情境的反應,並且更好的預測未來事件。

GAIA-1是一個可以利用不同類型輸入資料,包括影片、文字和動作,創建逼真駕駛場景影片的世界模型(World Model)。GAIA-1可學習環境以及未來動態表示,向自動駕駛模型提供一個結構化的環境理解,協助駕駛模型做出明智的決策。

官方提到,預測未來事件是自動駕駛系統一個基本且關鍵的能力,對未來的準確預測,可以讓自動駕駛車輛預先知道即將發生的事件,並且規畫其相對應的動作,增加上路時的安全性和效率。因此將世界模型整合到駕駛模型中,有助於自動駕駛系統更好地理解人類決策,並具備應對真實世界各種情境的能力。

GAIA-1可對自動駕駛車輛的行為和場景特徵進行細緻的控制,且由於GAIA-1多模態的性質,能夠從多種提示模式和組合中生成影片。首先,GAIA-1會先運用專門的編碼器,將影片或文字等各種形式的輸入,編碼成一個共享的表示形式,進而在模型中實現統一的時序對齊和上下文理解,這種編碼方法,讓模型能夠更好地整合和理解不同類型的輸入。

而GAIA-1的核心也就是世界模型,是一個自迴歸Transformer,能夠預測序列中下一組圖像token,世界模型不只考慮過去的圖像token,還參照文字和動作token的上下文資訊,運用這個方法所生成的圖像token,不僅會在視覺上連貫,而且也和預期的文字和動作指引保持一致。

接著,影片解碼器這個階段被啟動,主要功能是將這些圖像token轉換回像素空間,影片解碼器作為一個影片擴散模型,其強大之處在於可保證生成的影片,具語義意義、視覺準確且時間序一致性。GAIA-1的世界模型經過64個Nvidia A100 GPU上長達15天的訓練,包含了高達65億個參數,而影片解碼器則在32個Nvidia A100 GPU上訓練15天,總共擁有26億個參數。

經過數個月的發展,GAIA-1從原本的10億參數,成長到超過90億參數的模型,整個訓練資料集涵蓋2019年到2023年間,在英國倫敦所收集的4,700小時專用駕駛資料。參數規模的擴展,使得GAIA-1能力大幅提升,無論是影片生成、事件預測能力都更好,也更能理解基於文本和動作的控制。

GAIA-1的主要價值,便是在自動駕駛中引入生成式世界模型的概念,透過整合影片、文本和動作輸入,展示多模態學習在創建多樣化駕駛情境的潛力,而且透過整合世界模型與駕駛模型,使駕駛模型能夠更好地理解自己的決策,並且泛化至真實世界的情境中,進而提升自駕車系統的能力。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23