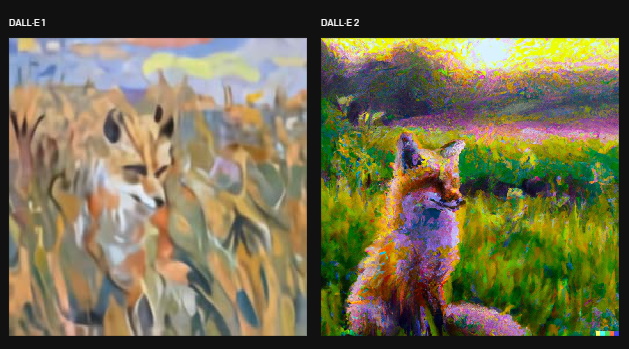

OpenAI表示,比起去年1月發表的第一代DALL-E版本,DALL-E 2可產生更寫實、更精確,解析度也更高的圖像。(圖片來源/OpenAI)

OpenAI本周發表了新版的文字轉圖像模型DALL-E 2,使用者只要給出文字敘述,DALL-E 2系統就能自動生成圖像,比起去年1月發表的第一代版本,DALL-E 2可產生更寫實、更精確,解析度也更高的圖像。

DALL-E奠基在具備1,750億個參數GPT-3上,但它僅使用120億個參數,利用一個文字與圖像配對的資料集,以文字敘述來產生圖像。

原始版DALL-E得以各種由文字組成的句子來建立合理的圖像,DALL-E 2的精確度改善了71.7%,寫實度改善了88.8%,解析度更是原本的4倍,還可結合概念、屬性及風格,打造出更生動的圖像,例如使用者得以指定系統以安迪.沃荷(Andy Warhol)風格畫出太空人騎在馬背上的圖像,或者是以莫內(Claude Monet)的風格畫出草原上的狐狸。

圖片來源/OpenAI

此外,DALL-E 2還能以文字來編輯既有的圖像,在考量陰影、反射與質地的狀態下新增、移除或置換圖像中的元件;或是以同一張圖像為基準,建立不同風格或編排的版本。

OpenAI說明,DALL-E 2學習了圖像與用來描述它們的語言之間的關係,透過擴散程序,從隨機點的一個圖案開始,並在確認圖像的具體部分時,慢慢將該圖案轉變為圖像。

現階段OpenAI仍在與特定的使用者研究DALL-E的限制與能力,包括避免被用來建立暴力、仇恨或成人圖像,並打算藉由過濾機制來辨識違反政策的文字或圖像,即使計畫擴大預覽社群,但現有的API並不支援DALL-E 2。

熱門新聞

2026-02-26

2026-02-27

2026-02-27

2026-02-27

2026-02-27

2026-02-27