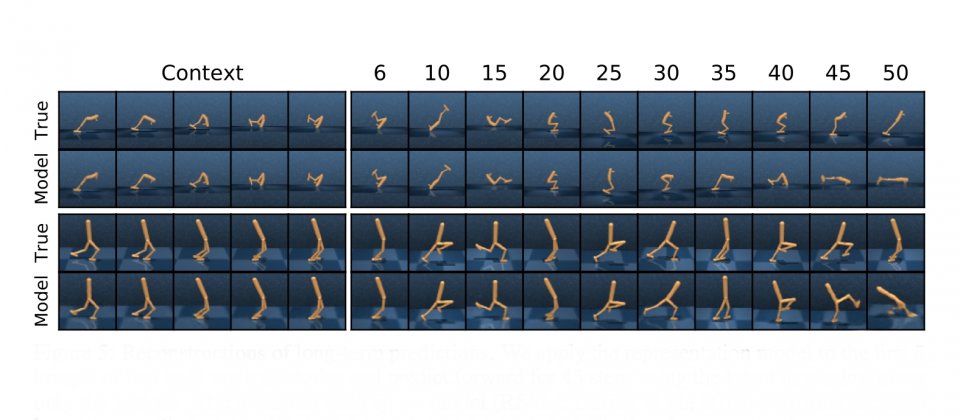

Google與DeepMind合作所發展的Dreamer,是一種增強學習代理,能夠預測模型狀態的序列,學習較長遠的行為。例如上圖的兩個序列,代理皆沒有在事前經歷過,但只要輸入5個圖像,模型便能進行重建,並且預測未來45步。(圖片來源/Google)

Google與DeepMind合作,開發出了一個稱為Dreamer的增強學習代理,可利用圖像習得世界模型,並用來進一步學習目光較長遠(Long-sighted)的行為。Dreamer利用圖像輸入,就能解決連續控制任務,還能掌握遊玩Atari遊戲技巧,應付需要反應、遠見、空間感知和場景理解的操作。

人工智慧的增強學習研究正蓬勃的發展,增強學習無模型方法可以透過反覆試錯,學習預測成功的行動,使得人工智慧能夠在即時戰略遊戲中打贏人類,但Google提到,增強學習需要代理人與環境進行大量互動之後,才能達到良好的成果,但這同時也限制了將其應用在現實世界中的機會,因為在現實世界中出錯,可能導致不可彌補的傷害。

比起無模型增強學習,基於模型的增強學習方法可以學習精簡化的環境模型,而這樣的世界模型使代理能夠預測潛在行動序列的結果,使其能在各種假設情況下做出反應,並在新情境下做出比較明智的決定,進而減少為了實現目標,所需要進行反覆試錯次數。

近期的增強學習研究,是透過學習精準的世界模型,讓代理學習成功行為,像是Google自家深度計畫網路PlaNet,便是利用圖像來訓練世界模型,而所謂的世界模型,便是能夠明確表示代理知識的參數模型。但是Google提到,基於模型的增強學習方法,因為缺乏效率,或者計畫機制的運算成本過於高昂,是其一直無法被用來解決困難的問題。

現在Google與DeepMind合作所發展的Dreamer,是一種增強學習代理,透過經訓練過的世界模型,所提供的潛在想像力,幫助代理解決長時間任務,也就是說,Dreamer會預測模型狀態的序列,學習較長遠的行為。Dreamer由3個典型程序構成,首先是學習世界模型,接著是透過世界模型,從預測中學習行為,第三個程序則是執行在環境中學習的行為,以收集新的經驗。

在學習世界模型的部分,Dreamer利用Google之前開發的PlaNet世界模型,該模型根據輸入的圖像,計算出一系列壓縮模型狀態序列來預測結果,這些模型狀態指的是,對預測未來結果有幫助的概念,像是物件的類型、位置和物件與周圍環境的相互作用,Google稱這個能計算未來的能力為想像力。

Google提到,PlaNet世界模型的優點之一,便是使用壓縮模型狀態,而非直接使用圖像進行預測,這個做法改進了計算效率,使得模型可以在單個GPU中,平行預測數千個行動序列,這個方法促進了方法的一般化,使得對時間較長的影片預測更加精確。

使用壓縮模型狀態進行預測,可讓代理在複雜環境中進行長期預測。下圖的兩個序列,代理皆沒有在事前經歷過,但只要輸入5個圖像,模型便能進行重建,並且預測未來45步。

.png)

另一個Dreamer的重點,在於高效率的學習行為,過去基於模型的代理,不是利用多個模型預測來制定計畫,不然就是利用世界模型來代替模擬器,並且續用既有的無模型技術,這兩種方法需要的運算要求都很高,而且也不能最大化世界模型帶來的優勢。

更重要的是,即便使用了功能強大的世界模型,也無法進行精確的預測,因為過去基於模型的代理無法預測太久之後的行為。而Dreamer利用反向傳播(Backpropagation)演算法來解決代理短視近利的問題,使世界模型能有效地學習行為。

整體來說,Dreamer在20個連續控制任務基準測試中(下圖),在效能、資料效率和計算時間都突破過去的水準。Google提到,他們利用世界模型的預測序列,就能讓代理學習行為,不僅以圖像輸入解決視覺控制任務,且效能超越過去的無模型方法。在Atari遊戲上,Dreamer也能良好地掌握離散的動作,和存在多個物件的3D環境的多樣化場景。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23