圖片來源/QNAP、NetApp

分散式儲存系統領域,正在歷經一波叢集基礎架構變革。由VAST Data在6年前率先引進的分解式架構,原本在市場上獨樹一幟,一直是該公司的標誌,不過,過去短短1年內,接連有多家廠商跟進推出同樣基於分解式概念的新產品,包括HPE、NetApp等一線大廠,意味著分解式架構已經獲得市場認可,並開始成為主流架構之一。

所謂的「分解」,指的是將儲存叢集節點的「控制」與「儲存」單元,加以分離與獨立。

傳統的分散式儲存系統,是以問世多年的「無共享」叢集架構(shared-nothing)為主流,每臺叢集節點都擁有獨立、完整的處理器、記憶體與儲存空間,多臺節點透過網路互連,透過跨節點的多複本資料複製,或erasure coding等機制,提供承受節點故障失效的備援能力。

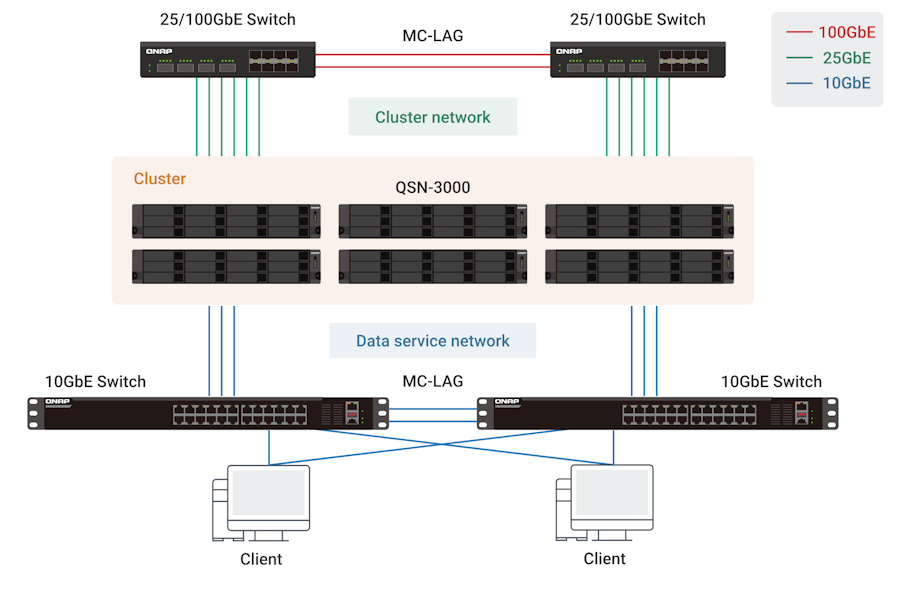

典型的無共享式儲存叢集架構

我們以QNAP的Scale-Out NAS,作為無共享式儲存叢集架構的範例,叢集節點只有QSN-3000一種,每1臺QSN-3000節點都有完整的處理器、記憶體與儲存空間資源,各節點透過後端的叢集網路互連,提供高可用性與資料保護功能,並透過前端的資料服務網路連接用戶端,為用戶端提供基於S3、NFS/SMB的物件與檔案儲存服務。圖片來源/QNAP

分解式架構則反其道而行,將叢集節點分拆為各自獨立的控制節點與儲存節點單元,然後再透過高速、低延遲網路互連,企圖藉此突破傳統架構在部署與擴展靈活性方面的束縛,進而在I/O效能、儲存容量與成本方面,獲得更精細、彈性的按需部署能力。

從無共享邁向分解式架構

過去二十多年來,無共享架構被認為是實現大規模擴展能力,又能兼顧節省成本的儲存叢集架構最佳選擇,廣泛應用在橫向擴展(Scale-Out)NAS、物件儲存系統,以及超融合系統(Hyper Converged Infrastructure,HCI)等,幾乎涵蓋所有分散式儲存產品領域。

無共享架構的優點是單純、相對容易建置與管理,每臺叢集節點都含有處理器與儲存空間,擁有完整的存取能力,只要在叢集中加入數量更多的叢集節點,就能同步擴展儲存叢集的I/O處理能力,以及儲存空間。

但另一方面,無共享架構也在資源調度、擴展靈活性與承擔災害受損能力方面,存在一系列限制。

關於資源調度方面,在無共享架構之下,處理器與儲存裝置之間的配置是固定的,資源調度與配置相對缺乏彈性,每一臺叢集節點都只能控制與存取自身後端的擴充空間(本機磁碟或擴充儲存櫃),無法將儲存空間或處理器I/O處理效能,分享給其他儲存節點使用。

相反地,當叢集節點的I/O效能或儲存空間滿載、超過負荷時,也無法臨時調度其他叢集節點的資源,此時我們只能將工作負載或資料遷移到其他有足夠資源的節點。

在擴展方面,無共享架構是以1個完整的「處理器+儲存」叢集節點為基本單元,每加入1臺節點,就能同時擴展I/O運算處理與儲存空間。但問題在於,用戶的擴展需求通常是不對稱的,許多時候只需要更多儲存空間,有時卻只需要提高I/O處理能力,因而「無共享」架構以完整「控制器+儲存」節點作為擴充單元的做法,便顯得難以精準對應用戶的擴展需求,往往造成資源的過度配置,形成浪費。

而在承受系統受損的能力方面,無共享架構以完整「處理器+儲存」節點為基本單元的型態,因而當1臺叢集節點故障時,也會同時損失該節點的運算與儲存資源。

更進一步,由於每1臺節點的處理器與儲存資源相互捆綁,當運算單元失效時,連帶也會導致後端連接的儲存裝置無法使用,等同於損失整個「處理器+儲存」單元。

分解叢集節點打破束縛

無共享架構的局限,來自將運算單元與儲存裝置合而為一,但這種架構在二、三十年前是合理的,因為當時的網路效能有限,速度遠低於本機儲存裝置,如果讓處理器運算單元與儲存裝置彼此分離,處理器必須透過效能有限的網路,跨遠端去存取儲存裝置,將導致很大的延遲,傳輸頻寬也會受到很大的限制。

不過,2010年代後期,隨著NVMe-oF(NVMe over Fabrics)傳輸架構,以及新一代乙太網路的問世,情況就不同了。有了低延遲、高頻寬的新一代網路架構作為憑藉,讓分解運算與儲存單元的分解式儲存架構,有了步入實用階段的基礎。

相較於以完整「處理器+儲存」節點,作為叢集基本單元的無共享架構,分解式架構則是將處理器與儲存單元分拆,由運算節點與儲存節點等兩種節點來組成叢集,透過這兩種節點的相互搭配組合,提供儲存服務。

在分解式架構之下,任何個別運算節點與儲存節點,都沒有獨立執行I/O存取的能力,一定要透過彼此相互組合,由若干運算節點搭配若干儲存節點,在節點之間,相互分享與結合I/O處理與儲存空間資源,才能回應前端的I/O存取需求。

分解處理器與儲存單元的主要目的,則是獲得擴展與資源調度方面的彈性,由於負責I/O的處理器,以及提供儲存空間的儲存空間節點彼此相互獨立,因而可以「非對稱」的個別擴充,用戶可以視情況單獨增加運算節點單元,或是單獨增加儲存空間節點單元,更精準地對應應用需求。

而在資源調度方面,在分解式架構下,運算節點與儲存空間節點的連接是動態、彈性的,任一臺運算節點,都可以存取任一臺儲存空間節點的儲存空間,可以靈活地調整處理器與儲存空間的資源配置。

更進一步,我們還能將整個分解式架構視為「資源池化」的儲存應用環境,管理者可以按需要組合處理器節點與儲存空間節點,提供前端應用環境需要的I/O效能與儲存空間。

除了擴展與資源調度方面的靈活性,分解式架構在承受系統受損能力方面,也優於無共享架構。由於控制器與儲存空間節點相互分離,因而單一節點失效的影響也較小,只會損失該節點角色的運算或儲存資源。

至於分解式架構相較於無共享架構的主要劣勢,則是「複雜」。

首先,叢集節點類型較多。無共享架構的主要叢集節點類型只有1種,分解式架構的主要節點有兩種(運算節點與儲存空間節點)。

其次,叢集內部的互連網路也更為複雜。分解式架構擁有運算節點與儲存空間節點等兩類叢集節點,必須讓所有的運算節點與儲存空間節點能彼此互連,才能讓所有運算節點存取所有儲存空間節點,需要更多的網路卡、交換器埠與IP位址,網路配置複雜許多。

實現分解式叢集架構的關鍵

用於連結分解式叢集架構中所有節點單元的內部互連網路,是分解式架構的核心所在,而NVMe-oF這類高速、低延遲傳輸技術的誕生,是分解式儲存叢集架構得以實用化的關鍵。

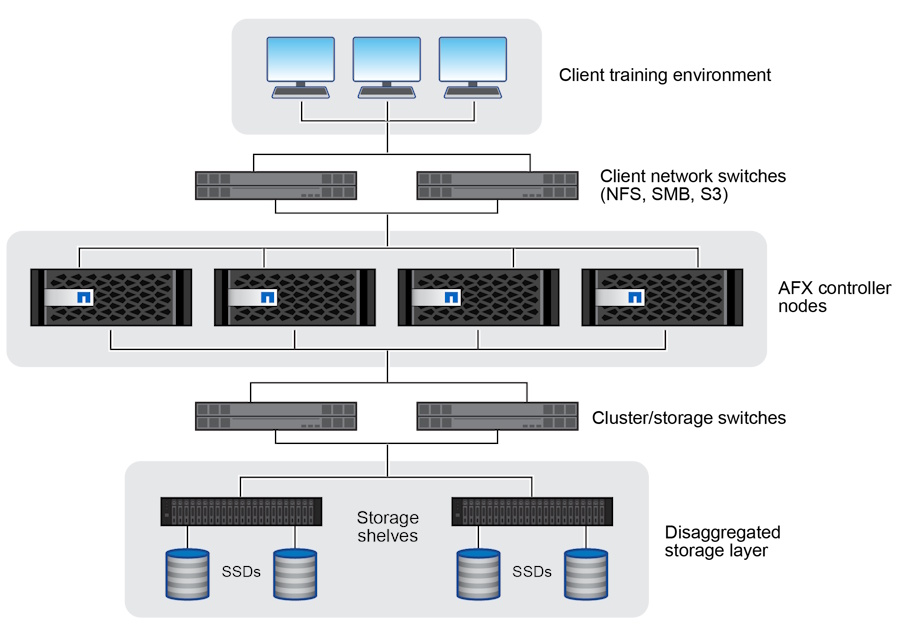

典型的分解式儲存叢集架構

這裡以NetApp的AFX,作為分解式儲存叢集架構的範例。AFX的叢集節點分為控制器節點,以及儲存機箱等兩種,個別控制器節點或儲存機箱,都不具備獨立運作能力,而需彼此連結組合運用,所以所有控制器節點都透過後端的叢集/儲存交換器彼此互連,控制器節點另外再經由前端的用戶端網路交換器,提供S3。NFS/SMB等儲存服務。圖片來源/NetApp

在傳統的無共享叢集架構中,儲存裝置是透過機箱內部的PCIe/NVMe、SAS,或是外接SAS介面,來與處理器直連,可為運算單元與儲存裝置間的I/O存取,提供極低的存取延遲。

相較下,分解式叢集架構則需透過跨節點的網路,來連結彼此分離的運算節點與儲存空間節點,如果沒有低延遲、高頻寬的網路作為跨節點的網路,將無法滿足控制器節點與儲存節點之間的I/O存取效能要求。而嫁接在RDMA乙太網路上的NVMe-oF技術,正能滿足這項要求,可以讓處理器與儲存裝置跨遠端存取,而不致影響效能。

擴散中的分解式儲存架構

VAST Data在2019年初發表、應用於其VAST Data Platform儲存平臺的「分解與共享一切」(Disaggregated Shared Everything,DASE)架構,是分解式儲存叢集架構的創始者。憑藉DASE與其他嶄新的技術架構,VAST Data以驚人的速度崛起,從產品首發到獲得10億美元估值,只花了17個月,創下儲存領域獨角獸企業新紀錄。

這也吸引HPE於2023年初,引進客製化的VAST Data核心軟體平臺,並且推出自身的Alletra MP for File Storage產品,也因此擴大了分解式儲存叢集架構的勢力版圖。

接著,HPE又在2024年底推出搭載自身儲存軟體平臺的Alletra MP X10000與B10000等兩款產品,前者針對物件儲存應用,後者針對區塊儲存服務,這幾款產品雖然都採用HPE自身發展的核心軟體,但同樣都屬於運算與儲存節點分離的分解式叢集架構,算是VAST Data的DASE架構之外,另一條分解式儲存叢集技術路線。

到了2025年,NetApp在10月發表AFX系列,雖然基於歷史悠久的ONTAP儲存平臺,但是,當中改用分解式叢集架構,也成為分解式儲存架構領域的最新成員,並在市場上逐漸形成分解式儲存這個新的產品類型。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-06

2026-02-09

2026-02-09