NetApp

憑藉AI應用持續興盛,以及輝達在GPU與加速運算的龐大影響力,用於改善GPU應用環境I/O傳輸效率的GPUDirect Storage(GDS),短短幾年內,就成為GPU領域標準的傳輸架構之一,也是有意在AI應用扮演重要角色的儲存廠商,必須支援的I/O技術架構。

支援GDS的儲存裝置形式

從儲存裝置的存取層級來說,GDS支援2種類型的儲存裝置:

(1)GPU伺服器本機掛載的區塊型(Block)儲存裝置,又分為兩種類型,一為透過NVMe介面直連的NVMe SSD,另一為外部儲存設備經由NVMe-oF架構連接的儲存區(Volume),這類裝置將格式化為EXT4或XFS檔案系統,再提供給GDS建立連結。

(2)GPU伺服器遠端掛載的外部檔案系統,也就是支援RDMA傳輸架構,且相容於GDS技術的第3方檔案層級儲存設備。

所以從儲存裝置的型態來說,GDS一共支援3種儲存裝置:(1)GPU伺服器內接的NVMe SSD,(2)經由NVMe-oF掛載的外部區塊型儲存裝置,(3)經由RDMA網路連結的外部檔案型儲存裝置。

在這3類儲存裝置中,GPU伺服器內接NVMe SSD的規格限制條件最少,幾乎適用所有相容於GPU伺服器的NVMe SSD產品(包括ScaleFlux的運算型儲存裝置產品),存取延遲最低,但在容量與傳輸頻寬擴展能力方面,會受到相當大的限制,取決於GPU伺服器能支援的NVMe SSD數量,一般而言,最多搭配十多臺NVMe SSD。

考慮到AI相關應用的規模擴展需求,更實用的GDS儲存應用架構,將是搭配外部儲存設備的型式,也就是藉由NVMe-oF掛載的外部區塊型儲存設備,以及經由RDMA網路連結的外部檔案型儲存設備。

典型的GDS應用架構:NetApp EF系列與BeeGFS的組合

-600--2.png)

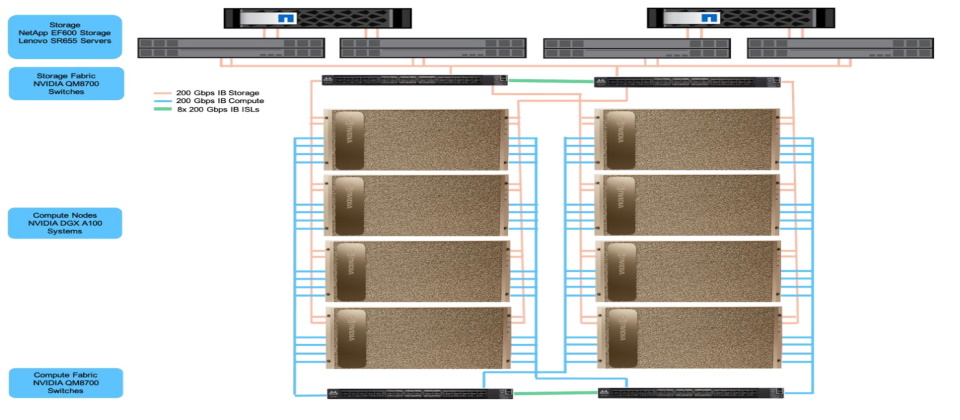

這是後端NVMe-oF搭配前端InfiniBand/RDMA的GDS應用架構。由NetApp的EF600儲存陣列,以NVMe over InfiniBand協定經由200Gb IfiniBand網路介面,將儲存區直接掛載到運行BeeGFS檔案系統的SR655伺服器上,後者再經由InfiniBand交換器,將檔案系統空間以InfiniBand/RDMA方式連到GPU伺服器,構成GDS連接。圖片來源/NetApp

支援GDS的儲存平臺

目前支援GDS的外部儲存設備,以檔案型儲存設備占大多數,總共有十多家廠商的產品,幾乎涵蓋當前市場上多數常見的檔案儲存平臺,包括:在高效能運算領域常見的知名老牌檔案儲存平臺,例如DDN的EXAScaler,HPE Cray ClusterStor,IBM Spectrum Scale(現在已改稱Storage Scale),ThinkParQ的BeeGFS,還有兩大分散式高效能檔案平臺新秀——VAST Data的Universal Storage,Weka的WekaFS,以及知名的通用檔案儲存平臺,如Dell的PowerScale、NetApp的ONTAP,Pure Storage的FlashBlade,以及華為的GFS(Global File System)等。

前述這些平臺,又可依照支援GDS的傳輸架構型式,分為直接透過RDMA網路連接(InfiniBand或RoCE乙太網路),以及透過NFS over RDMA協定(NFSoRDMA)等2大類。前者有EXAScaler、Spectrum Scale、BeeGFS、WekaFS等平行檔案系統,後者則有PowerScale、ONTAP等通用型平臺。

至於區塊型儲存設備,原則上任何支援NVMe-oF架構的產品都適用GDS,但實際確實標示支援GDS的產品,我們目前已知的,有Excelero的NVMesh,以及WD的OpenFlex Data24這2款外接NVMe儲存櫃,其中Excelero已於2022年併入Nvidia。

接下來,我們檢視其中較具代表性的平臺。

Dell

Dell算是最早支援GDS的廠商之一,9.2版以後的PowerScale OneFS檔案系統,能透過基於NFS v3的NFS over RDMA協定,搭配Mellanox的CX系列RDMA乙太網路卡支援GDS傳輸架構。稍後推出的OneFS 9.5版,又進一步改善了GDS傳輸效率,Dell實測顯示提升幅度可達36%。

Dell宣稱最小規模的3節點組態PowerScale F600儲存叢集,透過GDS可提供24 GB/s的傳輸率,若擴展到最大252節點規模時,將能擁有高達2 TB/s的龐大傳輸能力。

DDN

長年致力於高效能運算儲存服務的DDN,當然也沒有在GDS支援上缺席,是首批支援廠商之一。DDN基於Lustre平行檔案系統發展的EXAScaler檔案系統,包括基於Lustre 2.12的EXAScaler 5.2以後版本,以及基於Lustre 2.4的EXAScaler 6以後版本,都能透過InfiniBand支援GDS,適用的DDN硬體產品,包括DDN AI200X、AI400X與AI7990X。

DDN以4節點AI400X的實測為例宣稱,啟用GDS可獲得多達57%的傳輸率提升,提供高達162 GB/s讀取與143 GB/s的寫入速率。

IBM

源自GPFS平行檔案系統、在高效能運算儲存領域耕耘已久的IBM Spectrum Scale平臺,也就是今日的IBM Storage Scale平臺,同樣是第一批支援GDS的儲存平臺,自5.1.2以後的版本,都支援經由InfiniBand或RMDA乙太網路介面,建立GDS傳輸架構(5.1.2版只支援InfiniBand,5.1.3版以後額外支援RoCE乙太網路)。

IBM以兩臺ESS 3200儲存陣列(運行Spectrum Scale 5.1.2版)搭配兩臺Nvidia DGX A100,進行實測的結果顯示,藉由GDS可獲得196 GB/s的總傳輸頻寬,相當於兩臺ESS 3200網路介面線速的95%以上。

NetApp

NetApp目前有兩個平臺支援GDS,一是由NetApp EF600儲存陣列搭配ThinkParQ BeeGFS檔案系統的組合,一是NetApp自身的ONTAP儲存平臺。

在NetApp EF600與BeeGFS的組合中,NetApp其實是配角,EF600僅扮演單純提供儲存空間的角色,將自身的儲存區經由InfiniBand HCA網路卡,以NVMe over InfiniBand協定,掛載到負責執行BeeGFS檔案系統的Lenovo SR655伺服器,再由後者以InfiniBand HCA網路卡經由InfiniBand交換器,以RDMA/InfiniBand協定掛載給GPU伺服器使用,並由SR655伺服器運行的BeeGFS檔案系統,負責建立GDS連接。

而在NetApp所提出的參考架構中,是使用在RHEL 7.8作業系統上運行的7.2或7.3版BeeGFS檔案系統。而在實測中,這個組合架構搭配Nvidia DGX A100後,可獲得74 GB/s的傳輸率(基於8U的組態)。

NetApp的ONTAP儲存平臺,9.10.1版以後也提供透過NFS over RDMA協定,支援GDS傳輸架構的能力,適用於AFF A400、A700與A800等儲存陣列產品,可搭配Nvidia / Mellanox CX-5或CX-6等支援RDMA架構的乙太網路卡,使用經修改的NFS v4.0協定來運作。

後來在9.14.1以後版本的ONTAP平臺上,NetApp將搭配的NFS版本擴展到NFS v3與NFS v4.1,支援的儲存陣列機型也增加AFF C系列與AFF A900。

在GDS實測上,NetApp以4臺AFF A800儲存陣列搭配2臺DGX A100與2臺DGX-1,在使用2組、4組、8組A800控制器的情況下,分別可得到45.6 GB/s、86.5 GB/s與171 GB/s的傳輸率,總傳輸頻寬高於EF600與BeeGFS的組合,不過,若換成每節點或每U空間的平均頻寬,則略遜於後者。

HPE

HPE算是一線大廠最積極支援GDS架構的一家,旗下共有3個儲存平臺可支援GDS,包括Ezmeral Data Fabric(5.5版以後)、Cray ClusterStor(4.2版以後)、GreenLake File Storage(3.0版以後)。

它們其實都不是HPE原生開發的產品。例如:Ezmeral Data Fabric來自2019年HPE併購MapR取得的MapR Data Platform,一開始改稱HPE Data Fabric,2021年後名稱才換成現在的Ezmeral Data Fabric,應該是透過修改的NFS協定來支援GDS。

ClusterStor是HPE於2019年併購Cray取得的產品線,核心其實就是Cray修改版的Lustre平行檔案系統,應該是以InfiniBand支援GDS;GreenLake File Storage是由Alletra MP硬體執行的VAST Data分散式檔案系統,透過NFS over RDMA支援GDS。

Hitachi Vantara

身為老牌大廠之一的Hitachi Vantara,目前是透過源自Weka的分散式檔案系統產品——Hitachi Content Software for File(HCSF),提供對於GDS的支援。

回顧過去,Hitachi Vantara是在2021年中,以OEM形式引進Weka的WekaFS平行檔案系統,搭配自身的伺服器硬體,組成新的HCSF產品線,因而也跟Weka本家一樣,具備支援GDS的能力。

除了以獨立產品線銷售,Hitachi Vantara在7月正式推出的BasePOD整合套件Hitachi iQ 中,也搭配HCSF作為套件中的儲存單元。

Pure Storage

Pure Storage是從2023年10月開始支援GDS,適用於FlashBlade家族中的效能取向款式FlashBlade//S,需搭配4.3.4版以後的Purity//FB作業系統(目前最新版本是4.5.x版),採用的連接架構是基於乙太網路的NFS over RDMA。

至於FlashBlade家族中成本取向的FlashBlade//E系列,目前則不提供GDS的支援。

Weka

就時間點來看,Weka的WekaFS是最早支援GDS架構的第3方儲存平臺,2020年便與Nvidia進行驗證測試,自3.13版以後的WekaFS(現在稱作WEKA Data Platform),便能透過InfiniBand來建立GDS連接。

VAST Data

VAST Data也是第一波支援GDS的儲存廠商,其Universal Storage平臺在4.1版以後,支援以NFS over RDMA建立GDS連接。

Universal Storage平臺採用特別的「解構與共享一切」(Disaggregated Shared Everything,DASE)架構,由負責儲存服務的運算節點,與提供儲存空間的儲存節點組成叢集,搭配Nvidia GPU環境時,VAST Data所建議的參考架構,是採用新的高效能LightSpeed儲存機箱,透過100GbE乙太網路將空間掛載到VAST Data的檔案服務節點,再由VAST Data的檔案伺服器節點,以InfiniBand將儲存空間掛載給GPU伺服器。

尚未通過Nvidia認證的GDS支援產品

除了前述名列Nvidia認證的GDS支援廠商與平臺,還有幾家廠商雖然尚未列入Nvidia的認證名單,但也已發表支援GDS的解決方案,包括Hammerspace、PEAK:AIO、華為。

以平行NFS儲存系統打出名號的Hammerspace,是在今年初加入支援GDS行列。Hammerspace的口號是讓用戶現有的儲存設備,透過他們Hyperscale NAS介接,從而支援GDS架構。基本概念是將用戶原有的NVMe-oF儲存陣列、或是沒有RDMA連網能力的NAS,掛載到Hammerspace的Data Services(DSX)節點上,然後由後者藉由NFS over RDMA與GPU伺服器建立GDS連接。

英國新創公司PEAK:AIO的AI Data Server軟體平臺,同時具備NFS檔案存取與NVMe/TCP區塊存取支援能力,也能透過NFS與NVMe/TCP這兩種方式支援GDS架構,在2023年底與HPE合作的測試中,驗證了這項能力。

至於華為,是在2023年8月發布OceanStor A310儲存陣列的GDS測試結果,當中顯示他們的GFS(Global File System)平行檔案系統具備支援GDS的能力,但華為並未說明GFS是以何種底層傳輸架構支援GDS。

不同傳輸架構帶來的效能差異

迄今已有超過15種第3方檔案儲存平臺支援GDS,我們在10月檢視各廠商發布的GDS實測報告,以及儲存新聞網站「Block & Files」收集的GDS測試結果,發現各種平臺達到的GDS傳輸效率,有著很大的差距,而且其中還存在一些共同的傾向。

依照當前各種不同平臺支援GDS時,所採用的傳輸架構,我們可以大致分為3個群組——基於NVMe-oF,基於InfiniBand RDMA,以及基於NFS over RDMA架構。

參照Block & Files將各廠商測試結果標準化以後的平均單位節點輸出效能,我們發現IBM、DDN、Weka這些廠商,利用InfiniBand建立GDS傳輸架構的平行檔案系統,還有WD基於NVMe-oF連接架構的平臺,效能要比Dell、NetApp這些採用NFS over RDMA的平臺,高出一個層次。不過也有例外,例如Pure Storage與PEAK:AIO,都透過NFS over RDMA獲得不錯的讀取效能,但寫入效能仍不能與前述平臺相比。

這顯示NVMe-oF與InfiniBand RDMA具備一定的效能優勢,但從另一方面來看,NFS over RDMA雖然效能上受到較大限制,也有著運用簡便,與低成本的優點。

由於傳輸架構只是影響傳輸效能的眾多因素之一,加上各廠商的測試環境設定差異,前述比較並不精確,不過仍能作為我們衡量在GDS應用中使用不同傳輸架構時,一個粗略的參考依據。

-600-PNG.png)

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06