| Llama 3.2 | 邊緣AI | 裝置端模型 | Meta

Meta釋出支援邊緣與行動裝置的Llama 3.2 1B/3B

Meta強調開發人員能夠利用輕量文字生成模型Llama 3.2 1B及Llama 3.2 3B,建置個人化的裝置端代理應用程式,優點是提高回應速度並確保使用隱私

2024-09-28

| Threads.com | Meta | Threads

Meta旗下通訊服務Threads去年上線時的網址是Threads.net,至於Threads.com則屬於Shopify今年6月收購的新創公司所持有,但外界發現Instagram已經取得了Threads.com的網域名稱

2024-09-26

| Orion | Project Nazare | Meta | AR眼鏡 | 產品原型

Meta對外展示重量僅100公克的AR眼鏡Orion產品原型,除了透過語音、眼球移動輸入指令,也能搭配專用腕帶以手勢執行更細緻的操作,上市時程未定

2024-09-26

| DMA | 歐盟數位市場法 | Meta | WhatsApp | Facebook Messenger

Meta在歐洲準備讓第三方App和WhatsApp、FB Messenger互通

為了符合歐盟數位市場法(DMA)要求,Meta公布歐盟區WhatsApp與Facebook Messenger與第三方通訊應用程式的互通功能

2024-09-09

強調開源才是AI的未來,Meta公布Llama模型家族釋出一年後的累積下載次數,其中在Hugging Face平臺已逼近3.5億、成長超過10倍

2024-09-03

7月底Meta釋出Llama 3.1,針對這項眾所矚目的生成式AI模型,我們解讀Meta公司發布的技術文件,整理當中的硬體基礎架構組成,憑藉我們對企業級IT基礎架構相關技術的了解,一起讓更多人認識用來訓練生成式AI模型的超大規模運算環境

2024-08-16

| Llama 3 | Meta | 大語言模型 | AI基礎設施

【GPU是大型AI運算架構中最脆弱環節,自動化偵測與故障排除技術是確保維運關鍵】超大規模AI運算設施的維運挑戰

足夠的系統規模,只是執行Llama 3這類應用的必要門檻,而不能保證運算工作能順利進行,並獲得期望的成果,想要讓這類超大規模AI基礎設施充分發揮效益,還需要仔細的調校,並維持足夠的穩定性

2024-08-16

| Llama 3 | Meta | 大語言模型 | AI基礎設施

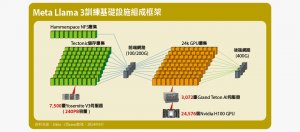

【2.4萬個GPU結合6千個CPU,打造當前全球最高規格AI運算環境】探索Meta Llama 3模型訓練的硬體基礎架構全貌

基於開放策略,Meta釋出當前炙手可熱的Llama 3大語言模型,也公開訓練這套模型的硬體基礎架構細節,使外界有機會瞭解這種超大規模AI運算設施的真實設置場景

2024-08-16

Meta發布財報,祖克柏宣稱Meta AI年底前將成為全球最多人使用的AI助理

儘管Meta持續擴大投資AI與Reality Labs,但依然創下134.6億美元的淨收入,成長73%

2024-08-01

| Segment Anything Model | SAM | 物件分割 | Meta

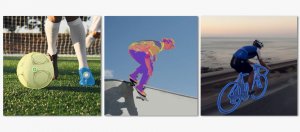

Meta釋出可用來分割影片物件的Segment Anything Model 2

Meta強調SAM 2模型可以分割圖像或影片中的任何物件,還能即時於影片中的所有畫面追蹤該物件

2024-07-30

| IT周報 | Mamba | 程式碼生成 | Meta | Llama 3.1 | 蘋果 | Transformer | Nvidia

AI趨勢周報第257期: Mistral AI用Mamba架構打造程式碼生成模型

Mistral AI用Mamba 2架構打造程式碼生成模型,表現比同規模的Transformer模型好;Hugging Face釋出小又強健的語言模型SmolLM;Meta開源Llama 3.1 405B;有效加速Transformer生成時間,蘋果推LazyLLM;Nvidia推出企業級模型客製化平臺AI Foundry

2024-07-26