Meta

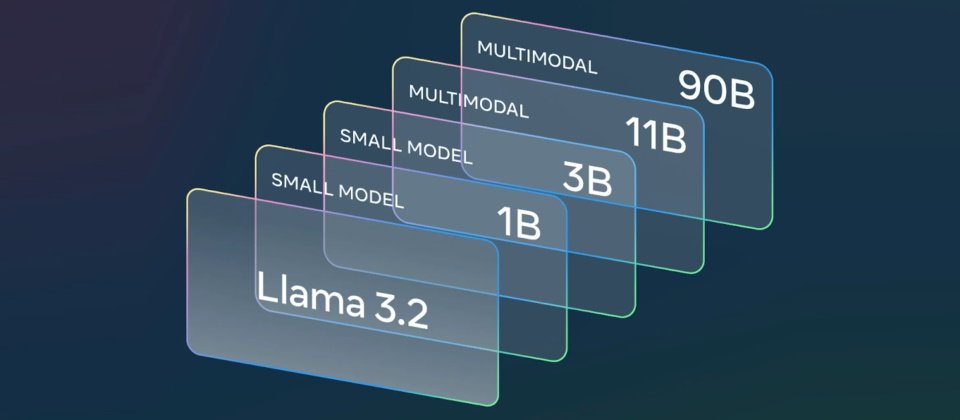

Meta本周發表了Llama 3.2,包括視覺語言模型Llama 3.2 11B及Llama 3.2 90B,以及鎖定邊緣及行動裝置、輕量且只有文字的Llama 3.2 1B及Llama 3.2 3B,已開放使用者自Llama官網及Hugging Face上下載。

其中,Llama 3.2 11B與Llama 3.2 90B主要支援圖像推論使用案例,可理解包含圖表、圖形及圖說在內的文件,或者是透過自然語言描述,於圖像中精確定位物件位置等視覺定位任務。例如使用者可詢問企業在去年哪個月的業績最好,Llama即可根據圖表回答;或者是基於地圖來回答路徑及距離等問題。

至於輕量的Llama 3.2 1B及Llama 3.2 3B,則具備強大的文字生成及工具調用功能,允許開發人員建置個人化的裝置端代理應用程式,以讓資料保存於裝置上而不外流。

Meta表示,於裝置端執行上述模型有兩大好處,一是提示與回應感覺像是即時的,二是不會將個人資料傳送到雲端,讓相關程式更具隱私,或者是控制將哪些查詢保留於裝置上,哪些則需送至雲上的大模型處理。

此外,基準測試顯示,Llama 3.2的視覺模型在圖像辨識及許多視覺理解任務上,足以與Claude 3 Haiku和GPT4o-mini 競爭,Llama 3.2 3B在遵循指令、摘錄、重寫提示及工具使用等任務上的表現,超越了Gemma 2 2.6B與Phi 3.5-mini模型,至於Llama 3.2 1B某些部分的表現亦不輸Gemma與Phi。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02