Mistral AI用Mamba架構打造出程式碼生成模型Codestral Mamba,具70億參數。

重點新聞(0719~0725)

Mamba Mistral AI 程式碼

Mistral AI用Mamba架構打造程式碼生成模型

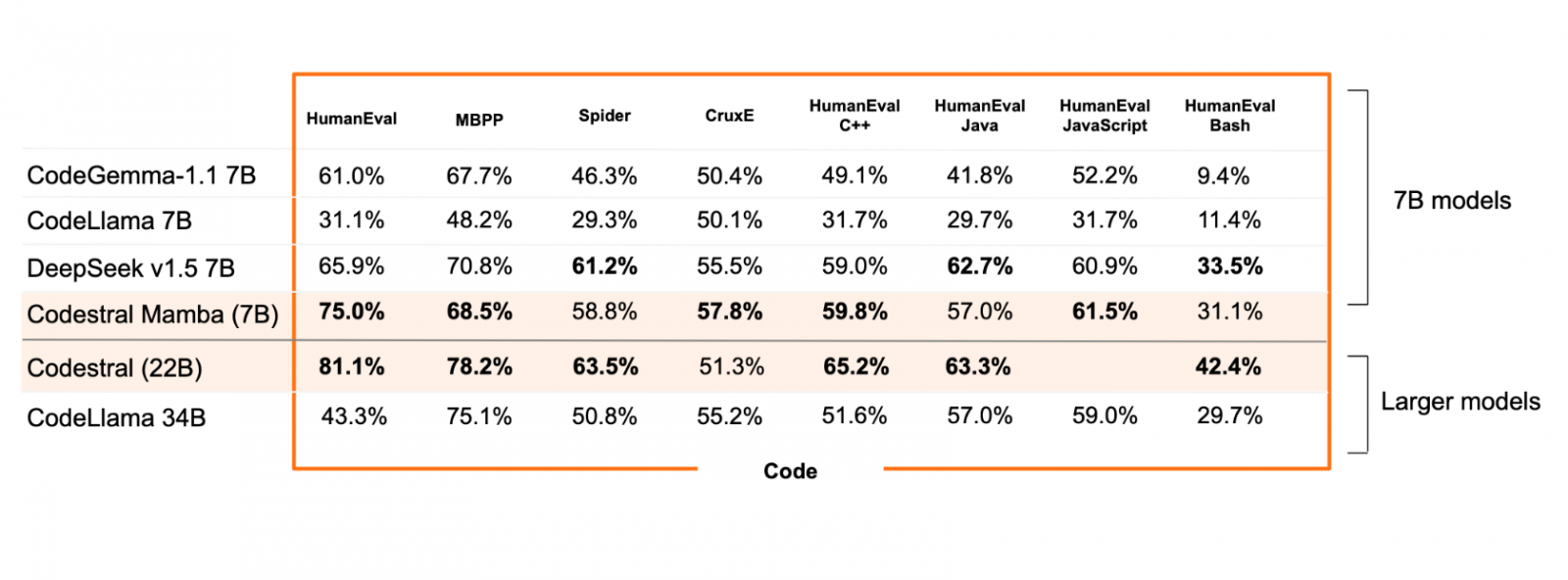

Mistral AI最近開源一款70億參數的程式碼生成模型Codestral Mamba,特別的是,這款模型不以Transformer架構為基礎,而是採用後來出現的Mamba 2架構。Mistral AI解釋,有別於主導AI發展的Transformer架構模型,Mamba架構可處理線性時間推論,意味著無論輸入長度如何,模型都能處理且快速回應。

而Codestral Mamba專精程式碼生成,可發揮Mamba長文輸入的優勢,支援Python、Java、C、C++、JavaScript、Bash,以及Swift和Fortran等程式語言。該模型也通過256K Token的上下文檢索能力測試,代表使用者可在本地端部署模型、搭配RAG來執行推論。就模型本身的表現來說,不論是人類評估還是其他基準測試,Codestral Mamba大多勝過同大小的模型,如CodeLlama、CodeGemma等。使用者可從Hugging Face下載原始權重,也能在la Plateforme平臺測試模型表現。(詳全文)

Hugging Face SmolLM 小型語言模型

Hugging Face釋出小又強健的語言模型SmolLM

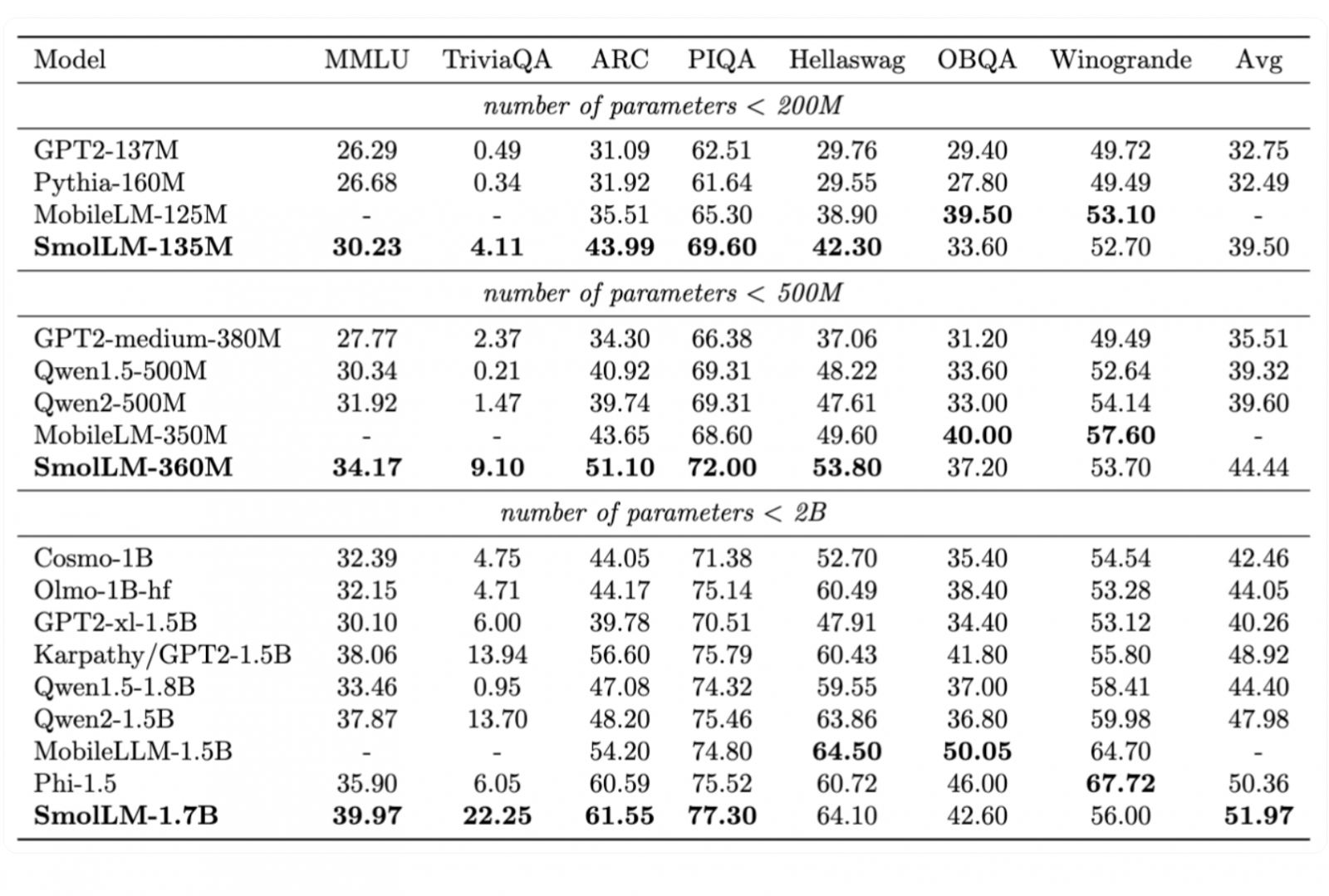

最近Hugging Face發布一系列語言模型,名為SmolLM,共有3個版本,包括1.35億參數(135M)、2.6億參數(360M)和17億參數(1.7B)版本。為訓練這些模型,Hugging Face還建置了高品質的訓練語料庫SmolLM-Corpus,由3大類語料組成,分別是目前最大的合成教科書和故事資料集Cosmopedia v2,共有280億個字符(Tokens),以及程式碼教學範例資料集Python-Edu、篩除重複範例的網路範例資料集FineWeb-Edu。這個SmolLM-Corpus語料庫,也隨著模型一起開源。

就模型效能來說,SmolLM在各種常識推理和世界知識測試中表現優異,超越了同規模的MobileLLM、Phi-1.5和Qwen模型。這一系列小型模型,有助於AI在各種裝置上執行,提高應用性。(詳全文)

Llama 3.1 Meta 開源

Meta終於開源Llama 3.1 405B了

日前,Meta開源了Llama系列語言模型的最新款Llama 3.1 405B,具4,050億個參數,脈絡長度達12.8萬個字符(Token),支援8種語言,是Meta迄今開發的最大模型,號稱是全球第一個達頂尖水準的開源模型。Meta創辦人暨執行長祖克柏還特別強調開源AI的重要性,認為開源才是AI的未來。

進一步來說,該模型有2個版本,包括Llama 3.1 405B和Llama 3.1 405B Instruct。Llama 3.1 405B是在近15兆個Token上進行訓練,經測試,Llama 3.1 405B在通用基準測試IFEval、數學測試GSM8K、推論測試ARC Challenge等測試中,都勝過GPT-4、GPT-4o和Claude 3.5 Sonnet。但在人類專家評估中,則與GPT-4-0125、Claude 3.5 Sonnet的表現不相上下,但明顯不及GPT-4o。(詳全文)

LazyLLM 蘋果 Transformer

有效加速Transformer生成時間,蘋果推LazyLLM

最近,蘋果推出一種名為LazyLLM的新方法,可用來加速Transformer語言模型的推論過程。進一步來說,Transformer模型推論可分為2個階段,首先是預填充階段,包括計算提示的鍵值(KV)快取和生成第一個字符(Token),再來是解碼階段,來生成後續字符。對於長提示來說,模型需在預填充階段,計算所有字符的鍵值快取,也就拉長了生成第一個字符的時間,成為瓶頸。

為解決問題,團隊設計了LazyLLM,可在預填充和解碼階段,選擇性地計算字符鍵值,而這些被選中的字符,對預測下一個字符來說是重要的。透過這個方法,可節省Transformer模型處理長提示的時間。而且,與靜態修剪不同,LazyLLM允許語言模型在不同生成步驟中,動態選擇不同字符子集,即使這些字符之前已經修剪過。經測試,LazyLLM可無縫整合現有語言模型,無需微調就能大幅加速生成過程,比如在多文檔問答任務中,LazyLLM在保持準確性的同時,能加速LLama 2 7B模型的預填充階段達2.34倍。(詳全文)

客製化 生成式AI Nvidia

Nvidia推出企業級模型客製化平臺AI Foundry

最近,Nvidia推出最新解決方案AI Foundry,可讓企業在Nvidia雲端上客製化生成式AI模型,提供了從專案規畫、合成數據生成、模型微調、RAG、模型安全防範到模型評估和部署等一系列功能。Nvidia說明,AI Foundry整合了Nvidia雲端平臺DGX Cloud、Nvidia NeMo平臺和第三方工具,可搭配多種底層模型來進行客製化。

AI Foundry提供的模型,包括了Nvidia Nemotron和開源模型,如Llama 3.1 405B、CodeGemma、Gemma、Mistral和Mixtral,以及微軟Phi-3、StarCoder2等。除了Nvidia本身的資源,企業還能用Nvidia合作夥伴提供的AIOps和MLOps平臺,來開發AI Foundry模型,包括Cleanlab、DataDog、Dataiku、Dataloop、New Relic、Scale等。企業客戶也能將在AI Foundry客製的模型,連同優化的引擎和標準API輸出為Nvidia NIM推論微服務,在AI加速基礎設施上執行。(詳全文)

DCLM 蘋果 語言模型

蘋果再開源2款小模型DCLM

繼4月份發表可在裝置上執行的小語言模型OpenELM後,蘋果最近又揭露2款小模型,包括14億參數和70億參數的DCLM模型,號稱效能不輸Llama 3、Gemma或Mistral等模型,且更省訓練運算資源。

這二款模型是由蘋果DataComp for Language Models(DCLM)團隊開發,並在Hugging Face平臺上釋出。第一款是70億參數的DCLM-7B,以2.6兆個字符(token)訓練而成。與SOTA模型如Mistral、Llama 3、Gemma、阿里巴巴Qwen-2、微軟Phi-3和開源模型MAP-Neo相比,DCLM-7B在多語理解測試MMLU的最終表現和Map-Neo相同,但所需的運算資源少了40%。第二款是14億參數的DCLM-1B模型,它在Alpaca bench測試中,表現比Hugging Face最近發表的小模型SmolLM還要好。蘋果也將DCLM模型框架、高品質訓練資料集DCLM-BASELINE和預訓練方法,開源公布在https://datacomp.ai/dclm專案網站。(詳全文)

微調 GPT-4o mini OpenAI

可免費用2個月,OpenAI推出GPT-4o mini微調工具

就在揭露最新小模型GPT-4o mini後不到一周,OpenAI再公布微調工具,提供特定用量免費使用2個月。這個微調工具可由API使用,一開始提供給tier 4和tier 5用戶,之後會逐步推展到所有收費等級的用戶。從即日起到9月23日,每日前200萬個字符(token)可免費使用。

可提供微調的模型,包括GPT-4和gpt-4o-mini,以及gpt-3.5-turbo-0125、gpt-3.5-turbo-1106、gpt-3.5-turbo-0613、babbage-002、davinci-002、gpt-4-0613(實驗中)、gpt-4o-2024-05-13,以及gpt-4o-mini-2024-07-18(建議)。OpenAI點出,以效能和易用性來說,gpt-4o-mini對大部分用戶而言是最適合的模型。他們表示,用API微調模型,可讓用戶輸入更多的訓練範例,提升GPT-4o mini模型生成的品質,且由於用戶不需使用那麼長的提示,可節省字符及成本,延遲性也更低。(詳全文)

AI安全 供應鏈 CoSAI

瞄準AI系統供應鏈安全,微軟、Nvidia和Google聯手推動安全AI聯盟

專門推動全球結構化資訊標準的非營利組織OASIS Open,日前提出安全AI聯盟(CoSAI)開源倡議,要建立一個協作生態體系,來分享AI安全設計方法、標準框架和相關工具。該聯盟的主要贊助者有Google、IBM、Intel、Microsoft、Nvidia和PayPal,其它贊助者還包括Amazon、Anthropic、思科、GenLab、OpenAI等。

身為CoSAI創始成員,Google表示,該聯盟計畫與產學界共同解決3大領域問題,包括AI系統的軟體供應鏈安全、讓防禦者為不斷變化的網路安全領域作好準備,以及AI安全治理。同時,CoSAI也將與Frontier Model Forum、Partnership on AI、Open Source Security Foundation及ML Commons 等組織合作,以共同推動負責任的AI。(詳全文)

圖片來源/Mistral AI、Hugging Face、Meta

AI近期新聞

1. Meta AI擴大支援7種語言

2. Nvidia與Mistral AI攜手釋出企業級AI模型Mistral NeMo

3. AWS旗下AI平臺如Amazon Bedrock、SageMaker開始支援3款Llama 3.1模型和Mistral Large 2模型

資料來源:iThome整理,2024年7月

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02