2020年5月,Nvidia在年度GTC大會期間,一口氣發表多項技術與產品,例如,新的GPU架構Ampere,基於這個架構的資料中心等級GPU加速器A100(搭配40GB的HBM2記憶體),以及搭配A100的GPU整合應用設備DGX A100(搭配8套A100)。

而到了11月美國超級電腦大會SC20,他們增設了HBM2記憶體容量提升1倍的A100 80GB,也宣布DGX A100與此時新發表的AI工作站DGX Station A100(搭配4套A100),都將提供兩種GPU組態──一是搭配早先上市的A100 40GB,另一是最新推出的A100 80GB。

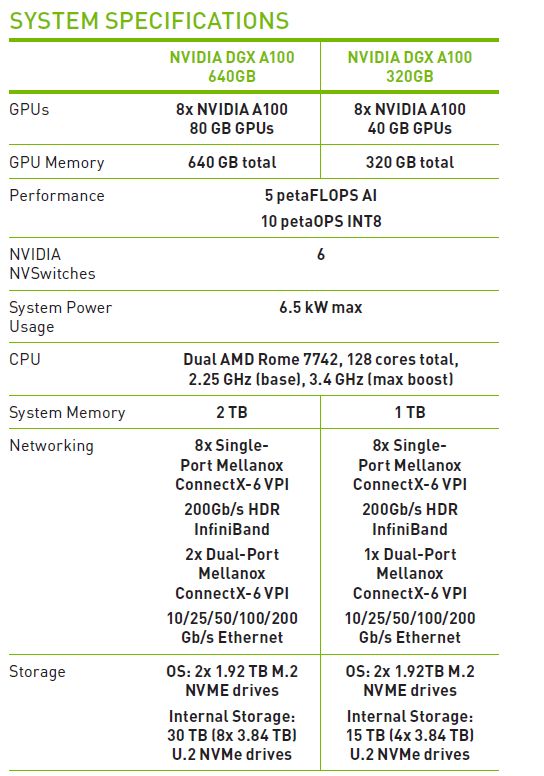

連帶地,這樣的規格變化,也促使Nvidia的GPU整合應用設備,各自衍生為兩種機型組態,例如,DGX A100區分為640GB與320GB的版本,以及DGX Station A100區分為 320GB與160GB的版本。

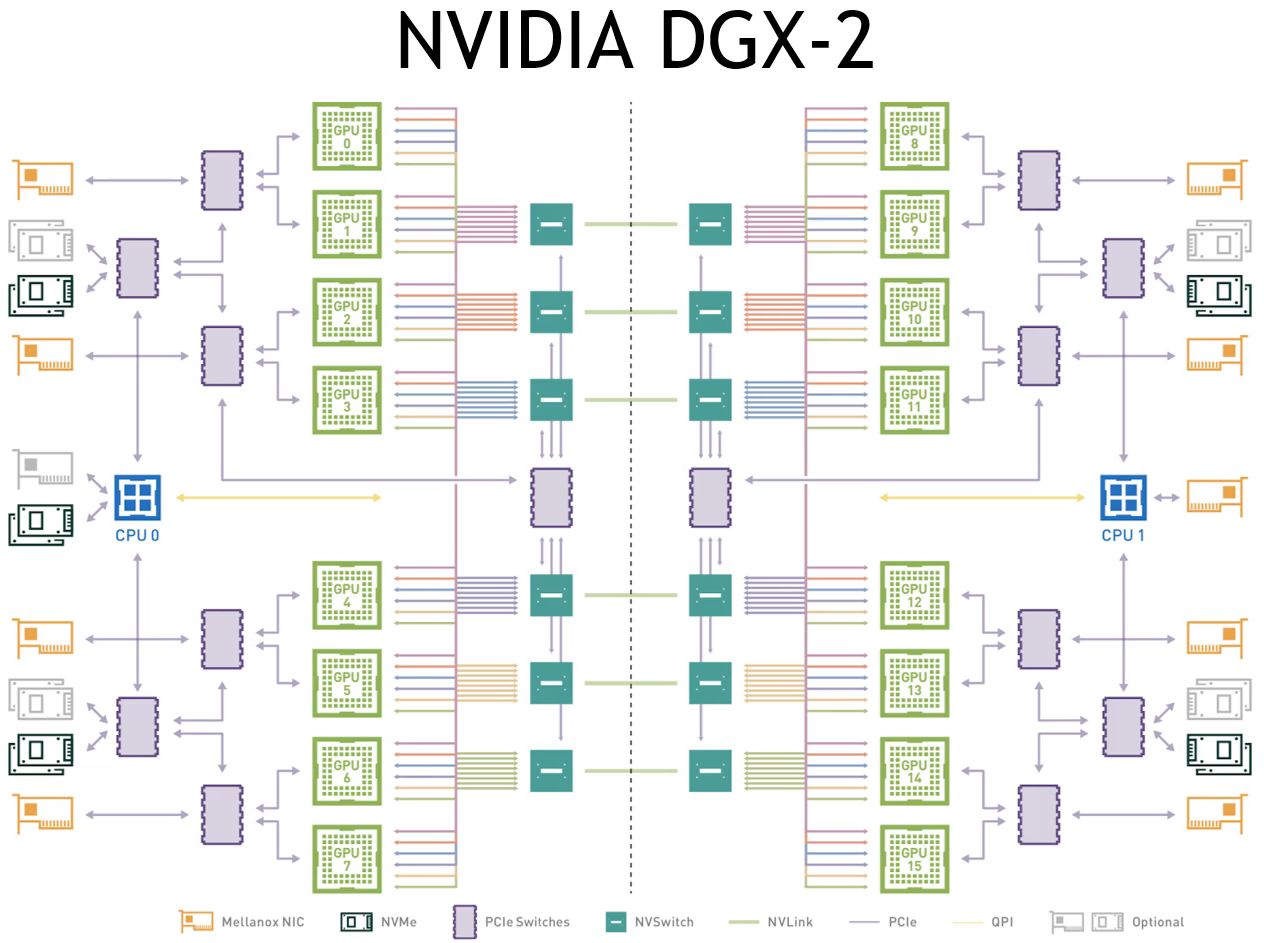

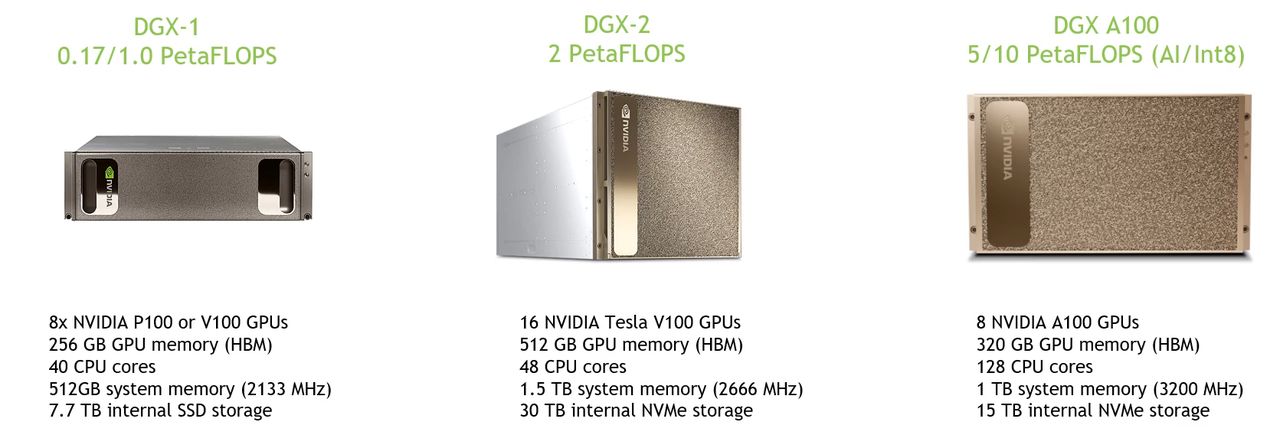

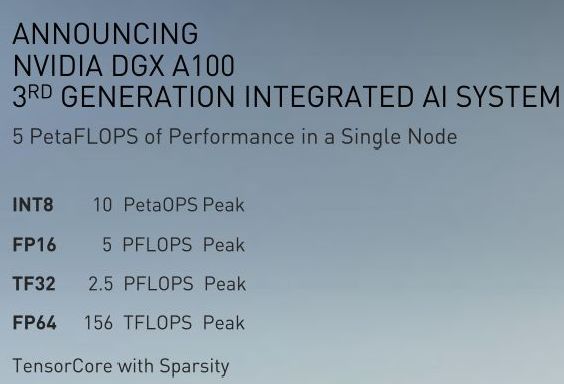

而在2020年上半發表的DGX A100相關消息當中,Nvidia強調這款產品是該公司的第3代人工智慧整合應用系統,單臺設備可提供5 PFLOPS的AI運算效能,以及10 petaOPS的整數運算效能(INT8),而且機箱尺寸縮減至6U,整機耗電量最高為6,500瓦。相較之下,他們在2018年推出的前代產品DGX-2,搭配了16套Tesla V100(GPU記憶體為32GB),單臺設備可提供2 PFLOPS的AI運算效能,機箱尺寸卻高達10U,整機耗電量為1萬瓦。

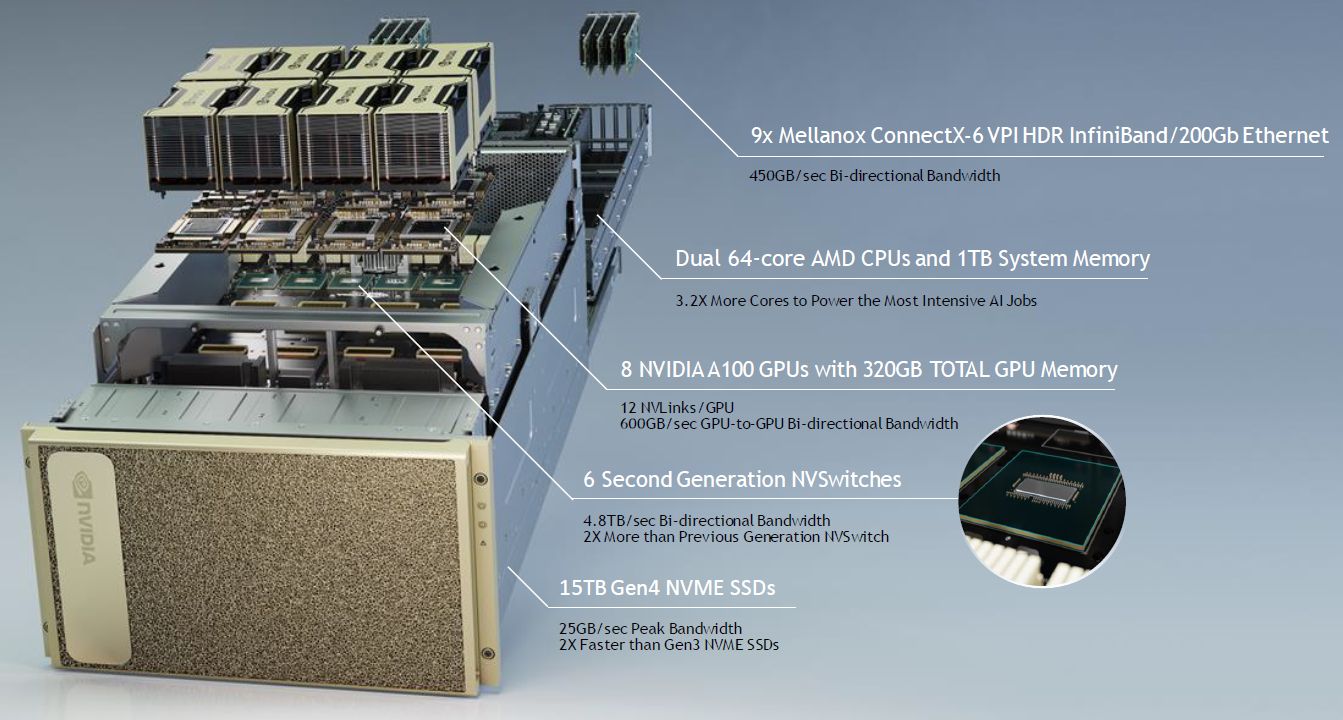

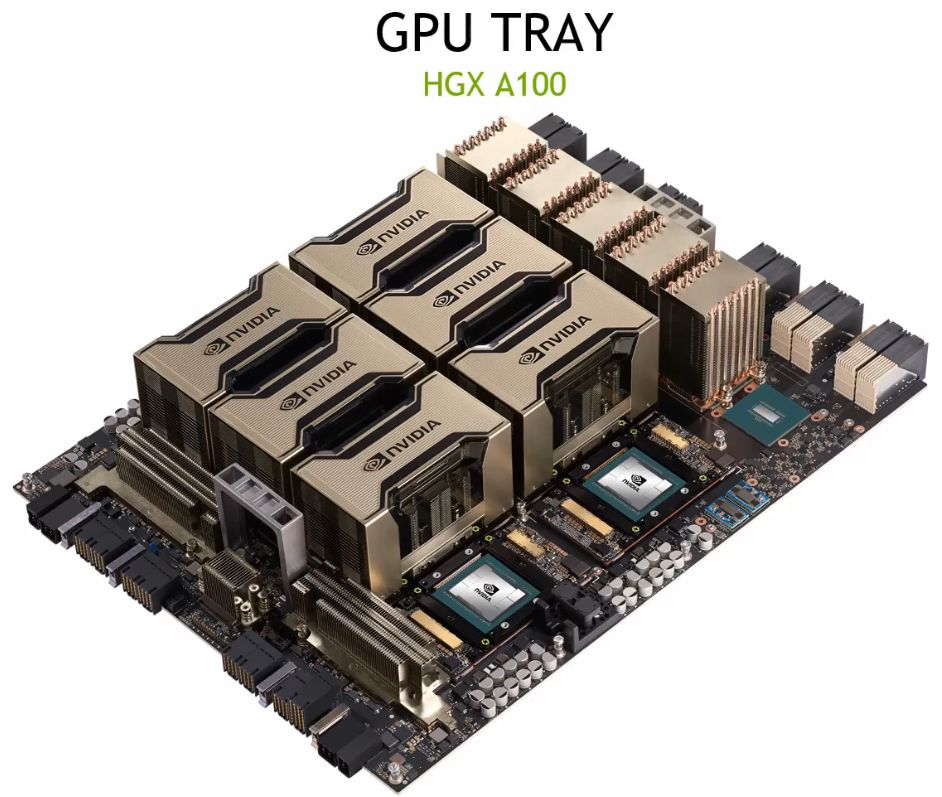

就Nvidia在2020年上半時公布的DGX A100規格資訊來看,這款設備搭配8套Nvidia A100 GPU,總共可提供320GB的GPU記憶體,用作超大型AI資料集的訓練。

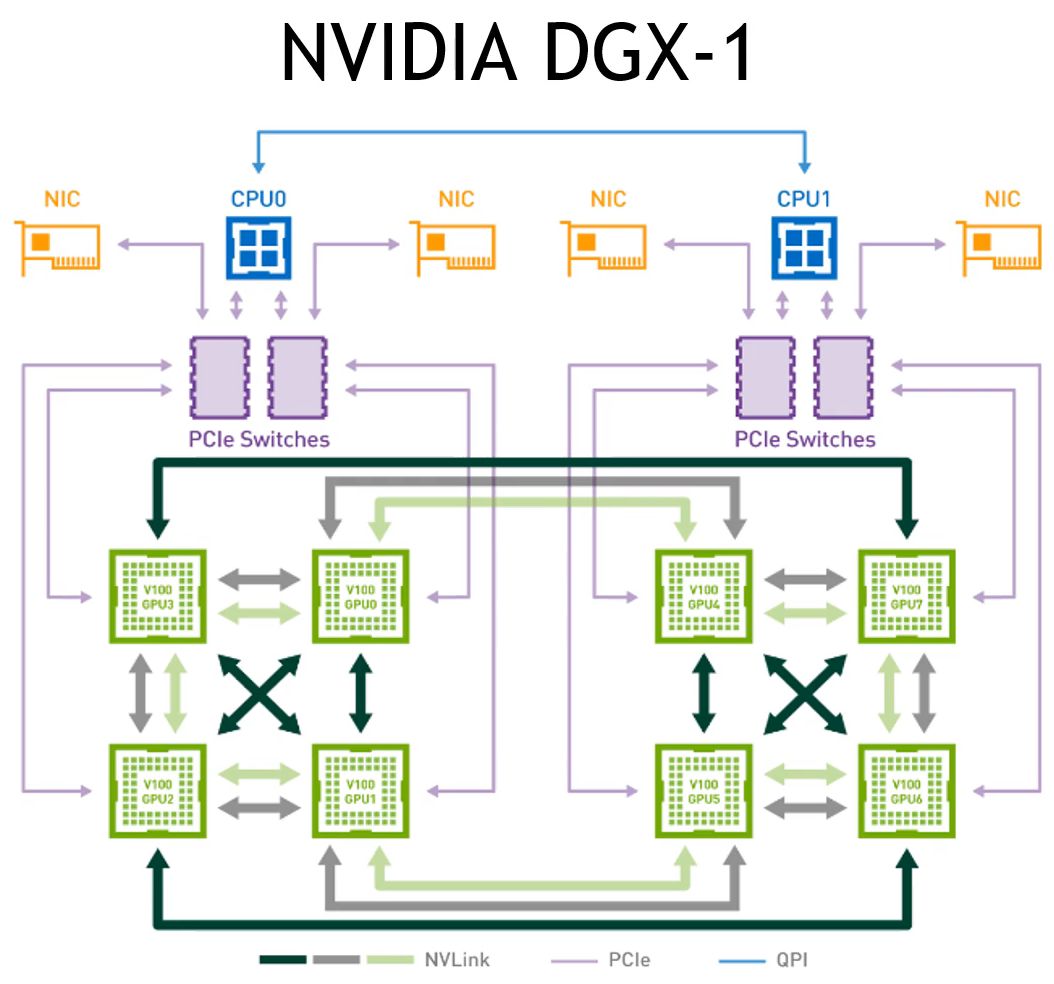

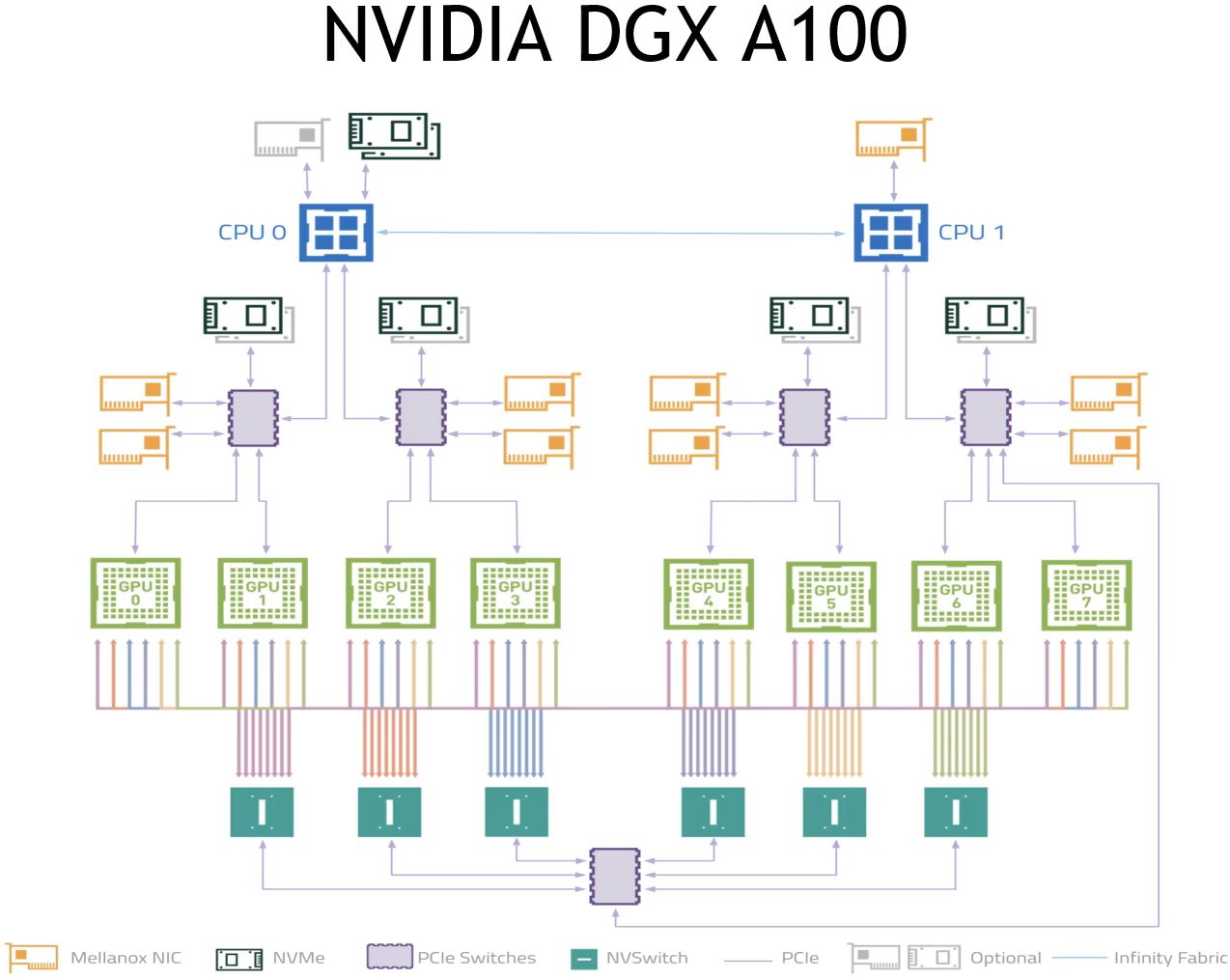

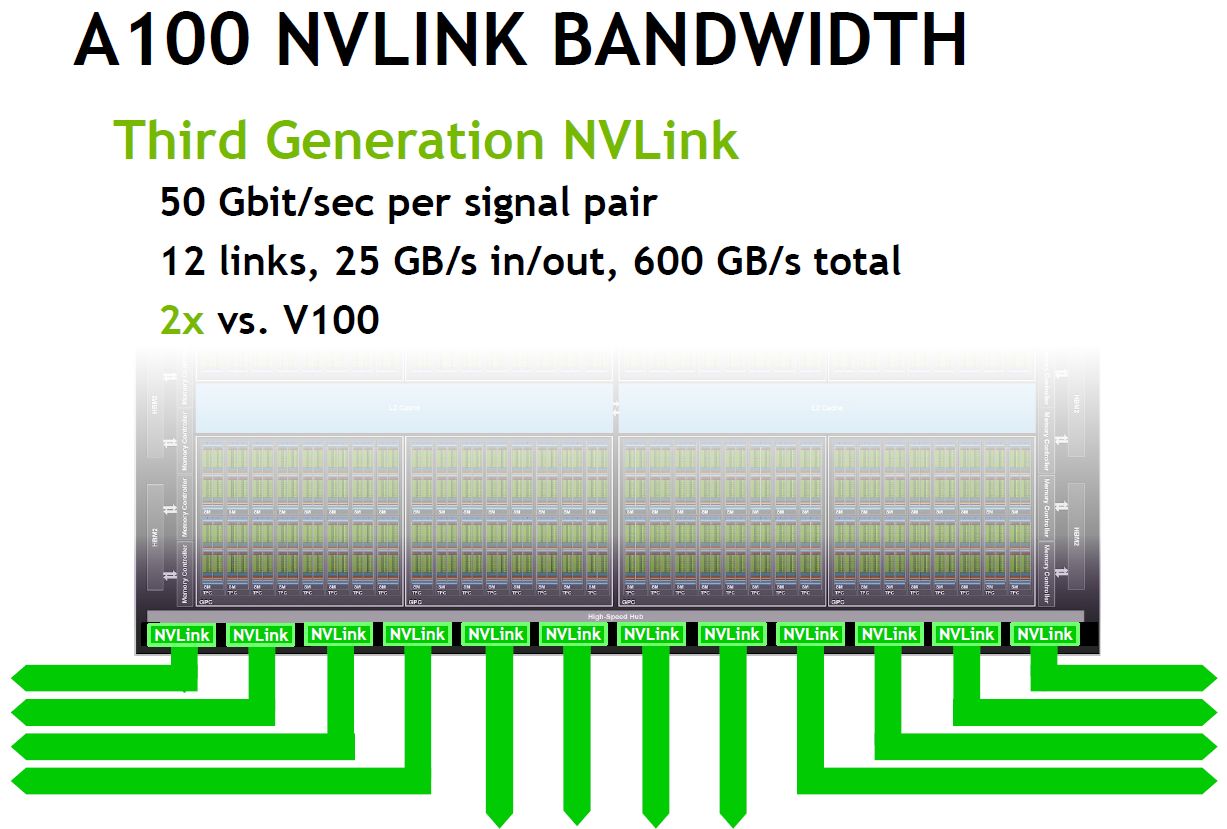

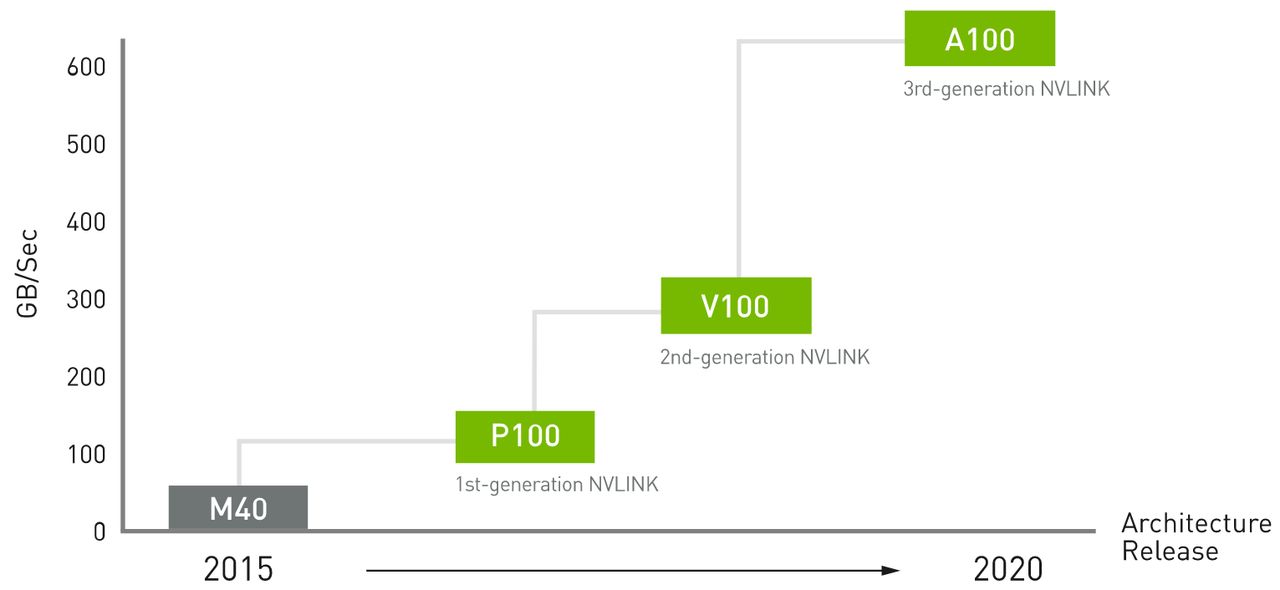

在GPU與GPU之間的互連介面上,A100 GPU與DGX A100均採用第三代NVLink技術,A100可支援12條NVLink,存取頻寬可達600 GB/s,是前代技術的2倍(V100與DGX-2採用NVLink 2.0,GPU互連頻寬為300GB/s)。

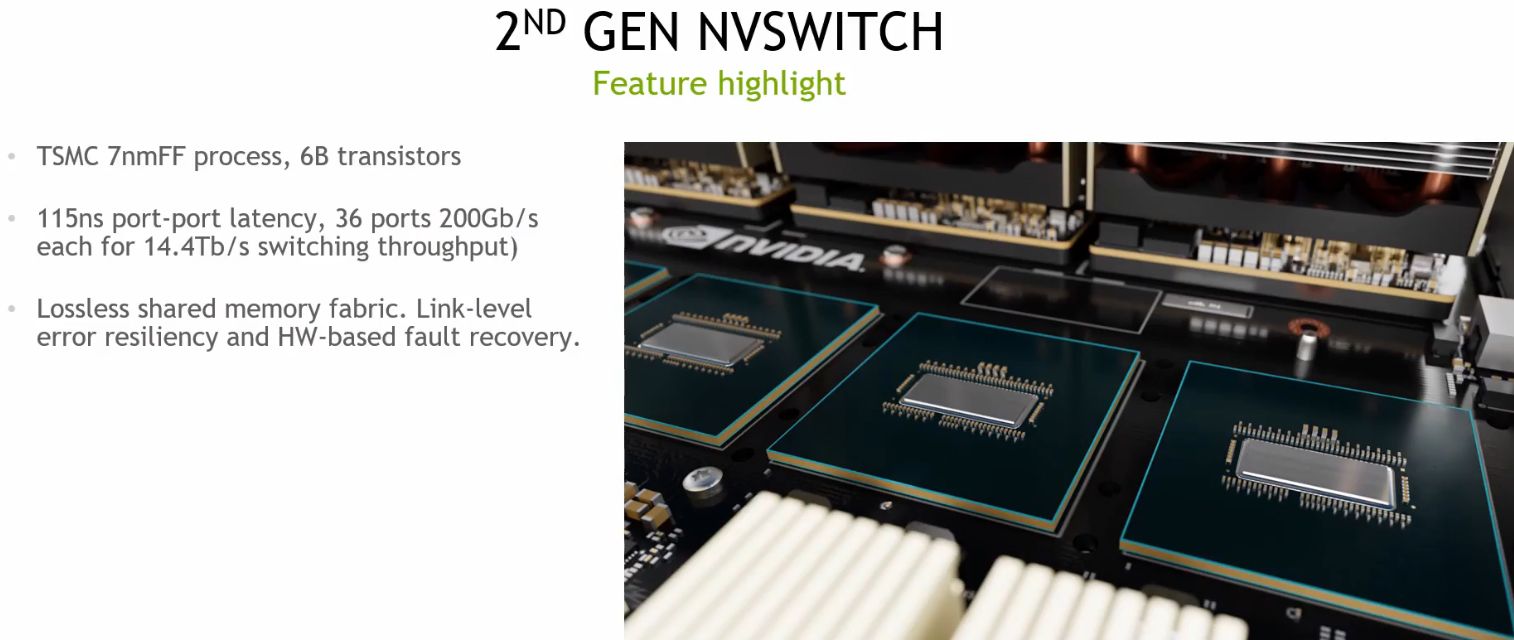

而在大量NVLink的匯聚處理技術上,DGX A100採用6顆第二代NVSwitch晶片來支撐8套A100 GPU,GPU基板內部的雙向頻寬可達到4.8 TB/s,是前代NVSwitch的兩倍。第二代NVSwitch採用台積電7nmFF製程,包含的電晶體高達60億個,是前代NVSwitch的3倍。

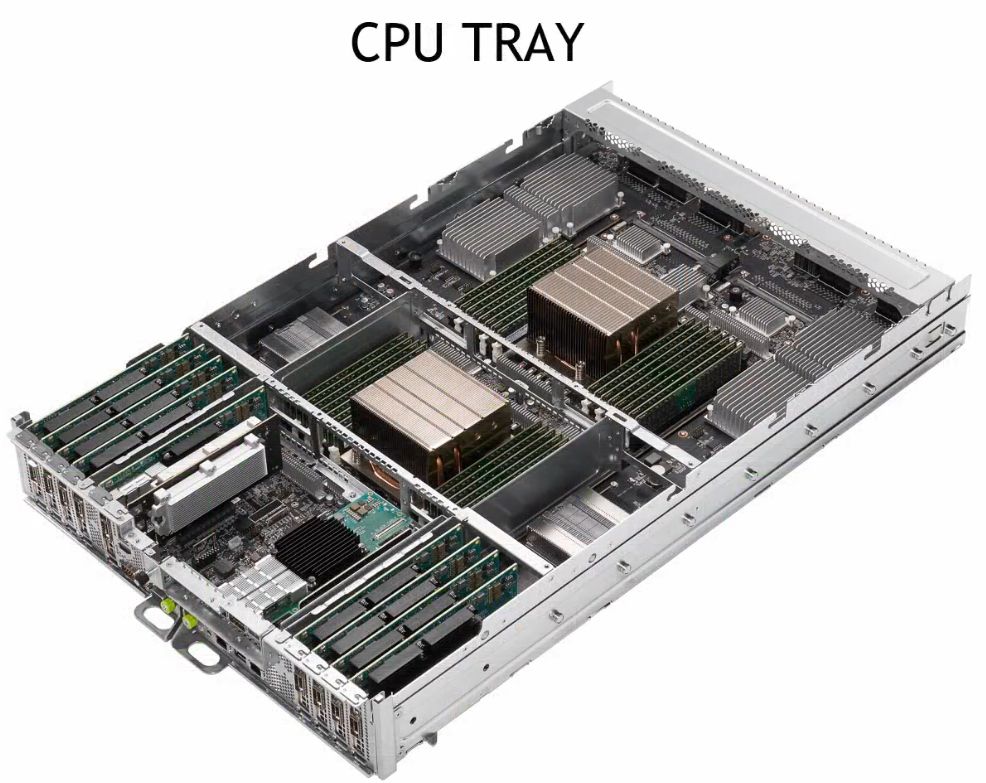

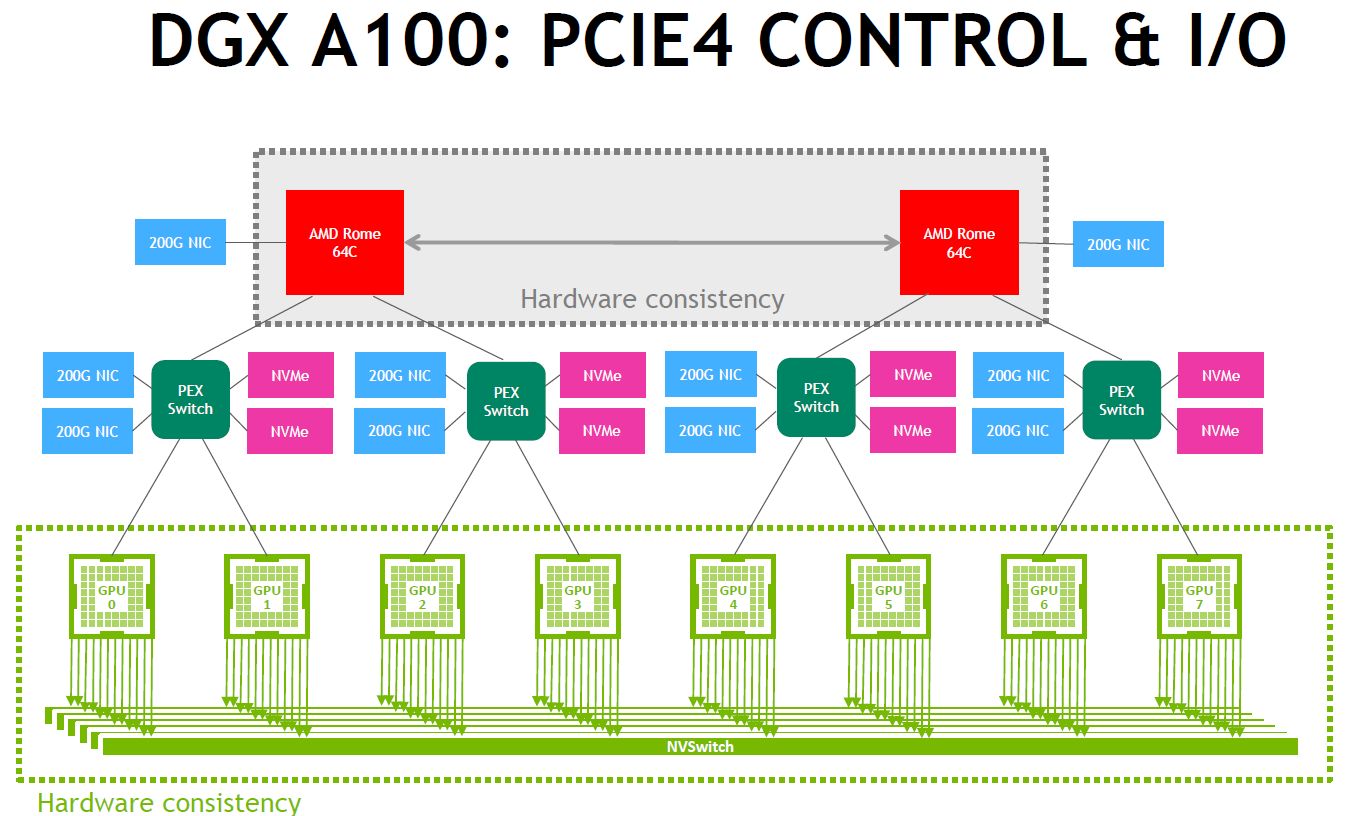

值得注意的是,DGX A100採用的中央處理器,已經改為AMD第二代EPYC,也因此能支援PCIe 4.0的I/O介面。

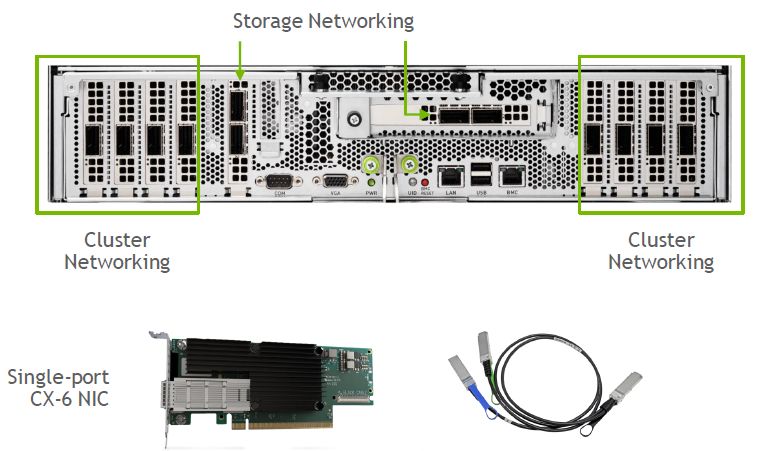

此外,在伺服器機箱外部的網路連接方式上,DGX A100配置了存取頻寬高達200Gbps的InfiniBand與乙太網路的介面(Mellanox ConnectX-6 VPI)。

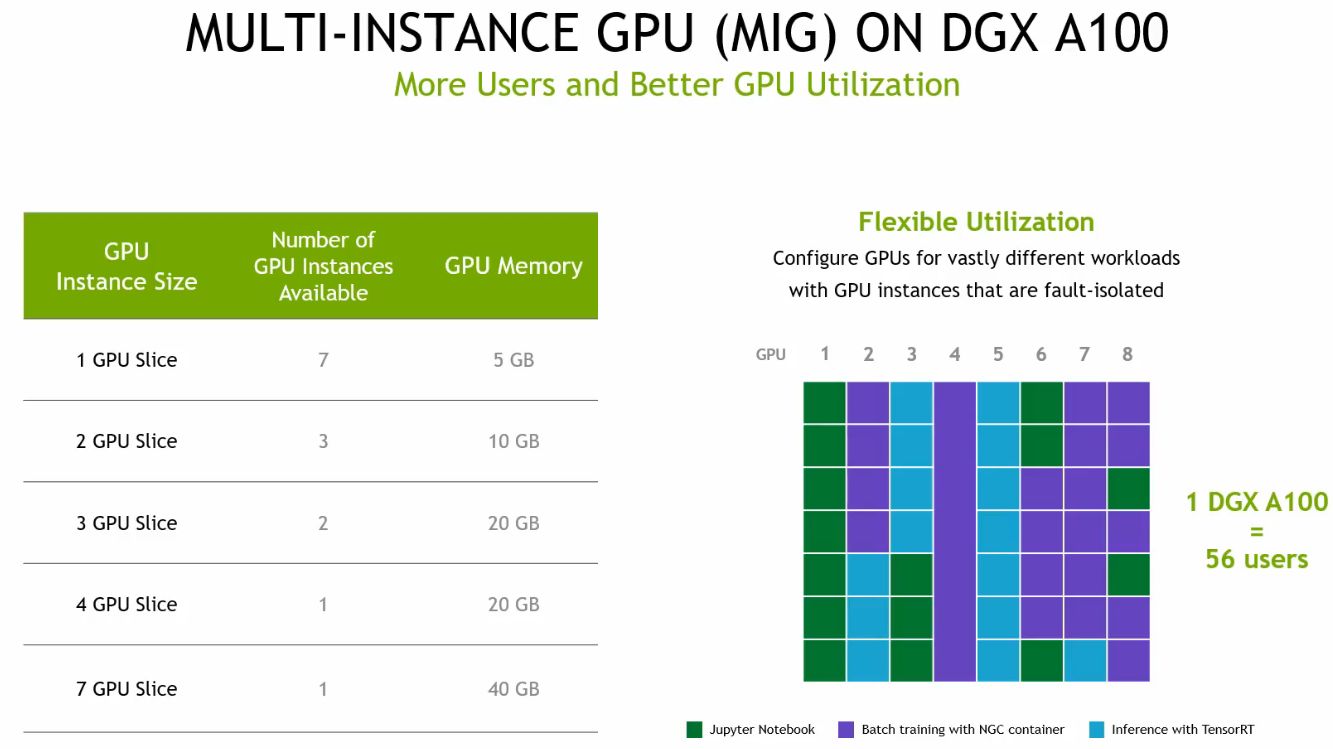

而在平行處理的運算上,由於Nvidia A100支援多執行個體(Multi-Instance GPU,MIG),單套GPU最多能分割成7個執行個體來運作,而DGX A100本身配置了8套Nvidia A100,因此,整臺系統最多可切分成56個執行個體同時執行。

產品資訊

Nvidia DGX A100

●原廠:Nvidia

●建議售價:199,000美元

●組態:DGX A100 640GB、DGX A100 320GB

●機箱尺寸:6U

●處理器:2顆64核心AMD EPYC 7742 2.25GHz

●系統記憶體:2TB或1TB

●硬碟:8臺或4臺2.5吋U.2 3.84 TB NVMe SSD(RAID 0),搭配2臺M.2 1.92 TB NVMe SSD

●GPU加速模組:8套Nvidia A100 80GB或Nvidia A100 40GB(6912顆CUDA核心、40GB或80GB HBM2記憶體、1555 GB/s記憶體頻寬)

●網路介面:8個200 Gb/s HDR InfiniBand埠(Mellanox ConnectX-6 VPI)+2個或1個200GbE(Mellanox ConnectX-6 VPI)

●軟體:DGX OS Server Software(Ubuntu OS LTS)

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-26

2026-02-27

2026-02-27

2026-02-27

2026-02-27

2026-02-27