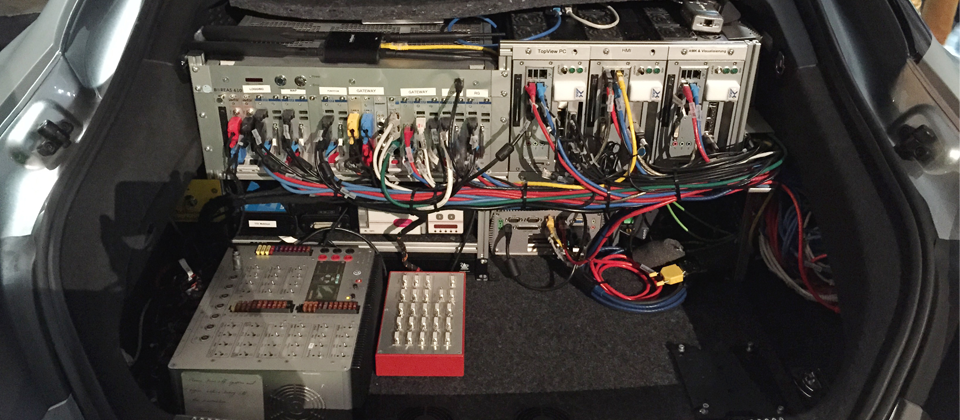

AUDI表示,在2015 GTC展出的新一代車載系統,是方便實驗蒐集行車數據的雛型,車內的電腦會將配備在車上的各種感測器測得的數據,回傳至遠端的資料中心,經過機器學習分析處理後,再將結果送回車上,修正自動操控判斷規則,以優化輔助駕駛的能力。

iThome

下一個世代的汽車自動化駕駛是什麼樣子呢?在2015年GTC中,Audi揭露,如何打造新一代輔助駕駛系統Piloted Driving的塞車自動駕駛(Traffic Jam Pilot),分擔塞車時走走停停的駕駛任務,並且展示結合GPU技術與機器學習,來優化自動化駕駛技術的雛形車。

塞車時走走停停的路況讓人煩躁,塞車自動駕駛可以讓車輛自動在移動緩慢的車龍中,以每小時60公里的速度自動前進。Audi駕駛輔助系統架構總監Matthias Rudolph說,根據調查,人們每天都花上許多時間在塞車上,他舉了5個城市為例,柏林市民平均每天花27分鐘塞車,洛杉磯市民每天花39分鐘,墨西哥每天花76分鐘,而人口密集的北京市民平均每天要花100分鐘在塞車上,聖保羅市民甚至一天要花上2小時,在無意義的車龍中等待,而塞車時走走停停的情況,需要一直盯著前面車輛的移動,踩放油門跟煞車,會讓不少駕駛精神緊繃,Matthias Rudolph表示,Piloted Driving現在可以接下這項任務。

Audi認為,人類的行為控制從感官開始,而聽覺、視覺以及觸覺等知覺訊號送到大腦,肢體受驅動之後做出相對應的動作。Piloted Driving也是相同的原理,Audi的車上有許多環境感測器,諸如GPS、攝影機、雷達以及雷射掃描器等,這些感測器將訊號送到處理單元後,對方向盤以及煞車等控制器做出反應。

7大感測器提供零死角視野

搭載Piloted Driving系統的Audi汽車,在車上配備許多感測器。車身裝設俯視角度的攝影機,雖然距離較小但是涵蓋全車360度,四周除了攝影鏡頭外,也以中程雷達包圍,車頭車尾裝設超音波感測器,而車頭的監控較為複雜,除了長程雷達外,還有夜視鏡頭以及雷射掃描器,在擋風玻璃上緣也裝設能提供立體視覺的3D攝影機。這些複雜的感測器提供了Piloted Driving系統無死角的環境辨識能力。

但Matthias Rudolph說,每一種的感測器現在只對應單一功能,未來希望不同感測器的訊號能夠更靈活的交叉使用,以發展更複雜的應用。現在所有的感測器訊號運算都是倚靠名為zFAS的All in One中央輔助控制單元處理,其中包含了Nvidia K1晶片,可以處理4路的攝影機訊號,負責停車駕駛的影像處理以及駕駛員監控,還有Altera的Cyclone晶片負責處理超音波感測器的訊號,而Mobileye EyeQ3晶片除了自動緊急煞車系統(AEB),也負責車前攝影機的影像處理。

zFAS的軟體架構分為4層,第一層為應用程式的框架以及發動機控制器(ECU)等基本層,在基本層以上是知覺層,處理汽車的各項感測器的訊號,諸如燈光偵測、物體偵測、巷道偵測或是交通工具偵測,而第三層是Fusion層,透過感測器蒐集到的訊號,做綜合性的處理,彙整成通用資訊,有Mapfusion、Objectfusion與Roadgraph,讓第四層的功能可以應用,而第二層以及第四層的功能可由第三方提供。

Matthias Rudolph表示,Piloted Driving駕駛輔助系統並非要取代駕駛員,而僅是輔助的角色,駕駛仍然需要在緊急的時刻中斷輔助系統,立刻接手駕駛的工作,而且在輔助駕駛的過程,駕駛員也需要持續的監控路況。他說,未來Piloted Driving的目標是有更高的可預測性,駕駛員也能放心的把行車任務交給電腦,不需要一直監控著行車狀態,並且車載系統能與其他交通工具功能整合,期望做到在特定的情況,能完全取代駕駛員的工作。

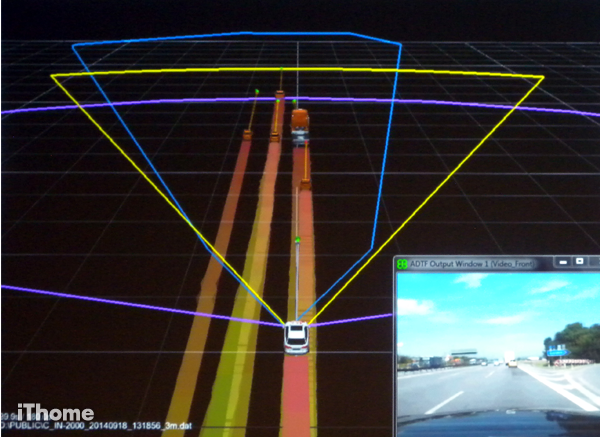

Audi蒐集車旁360度半徑800公尺內動態物體的資訊,匯整後存放在Object Fusion系統中,其中包括行進中的車輛或移動的障礙物。

另一個與Object Fusion相反的系統Map Fusion,蒐集汽車旁160公尺的靜態障礙物的資訊,精準度可到公分。

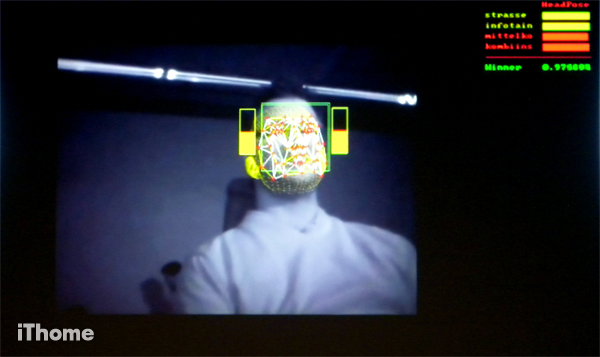

車載電腦會隨時監控駕駛員的臉部變化,像是表情或是眨眼的頻率等,評估駕駛員精神狀況,在適當的時機給予警告,避免發生意外。

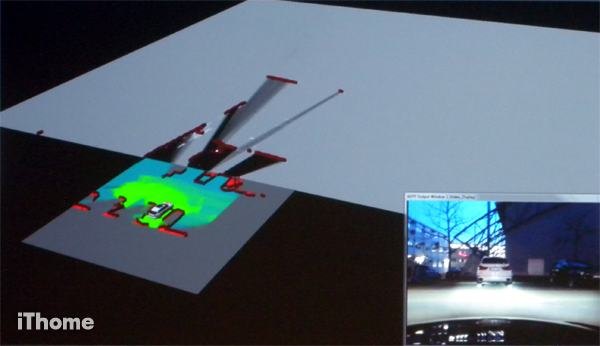

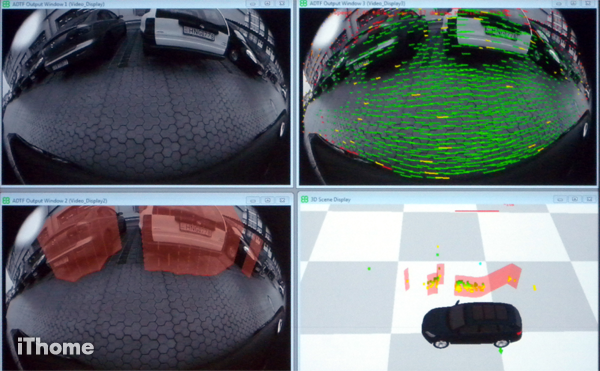

雛形車內建360度的俯視攝影機,能辨識車旁的障礙物,紅色半透明色塊表示不可通行的區域。

Audi表示,自動緊急煞車系統採用單眼3D攝影機,只要一個鏡頭就能測量汽車前方各種物體離車的距離,作為判斷自動煞車的依據。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-05

2026-03-02

2026-03-02