微軟

微軟周一(1/26)發表新一代的推論AI加速晶片Maia 200,這是微軟在第一方的AI晶片計畫中,首個進入大規模商用部署的版本;同時,隨著生成式AI進入實際營運階段,微軟正將AI運算從單點效能競賽,推進到長期可擴展、可控成本的雲端基礎設施層級。

Maia並非通用GPU的替代品,而是專為大規模AI推論而設計的雲端加速器,首次於2023年Ignite大會對外揭露。

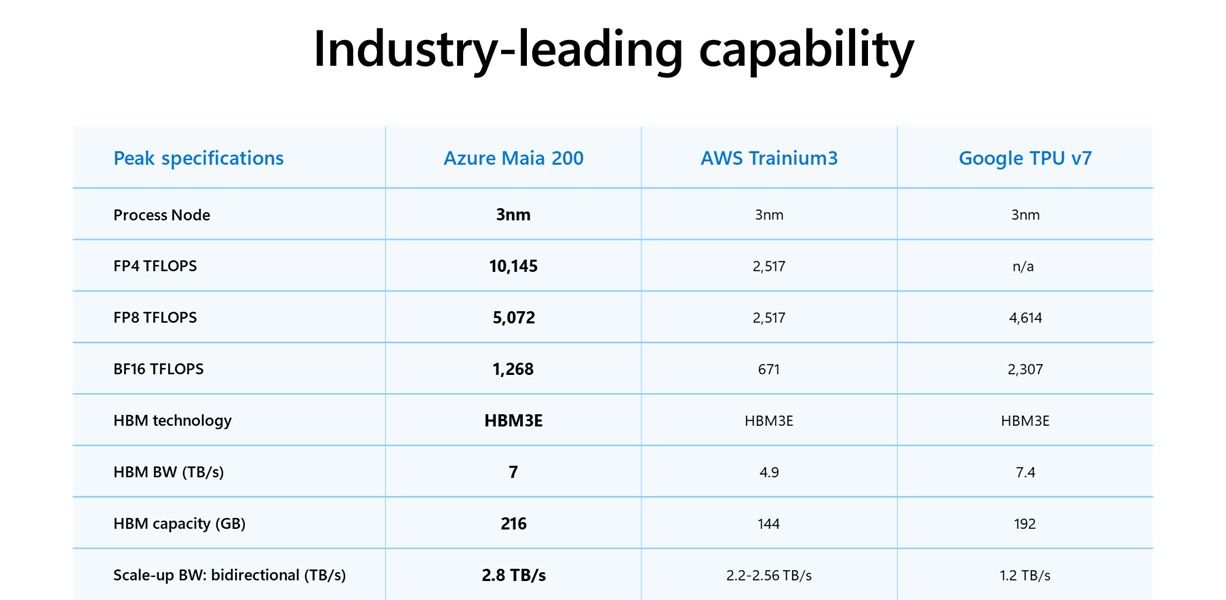

新一代的Maia 200採用台積電3奈米製程打造,內建原生FP4與FP8 Tensor核心,並配置216GB HBM3e、7TB/s記憶體頻寬與272MB晶片內SRAM,整體設計明確鎖定低精度推論與高Token吞吐需求。微軟指出,Maia 200在FP4運算效能上約為第三代AWS Trainium的3倍,FP8效能亦高於Google第七代TPU,且在其資料中心實際部署中,效能成本比提升約30%。

圖片來源/微軟

儘管Maia 200在硬體形態上是一顆AI加速器晶片,但其設計並未止於晶片本身。微軟在開發過程中,同步定義了晶片的互連方式、資料中心網路拓撲、機架配置與散熱方案,使Maia 200能直接融入Azure資料中心,作為可規模化的AI推論運算單位。

現階段微軟已將Maia 200部署於Azure資料中心,用於支援包括OpenAI最新GPT-5.2系列模型、Microsoft 365 Copilot與Microsoft Foundry等服務。Maia 200主要承擔高頻率的Token生成任務,作為GPU之外的另一條推論運算路徑,降低對單一硬體平臺的依賴,並提升AI服務在高負載狀態下的成本可預測性。

此外,微軟內部的超智慧團隊亦使用Maia 200進行合成資料生成與強化學習,支援下一代自研模型的研發流程。這使Maia不僅服務於既有產品推論,也被納入模型開發與優化體系之中。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02