微軟

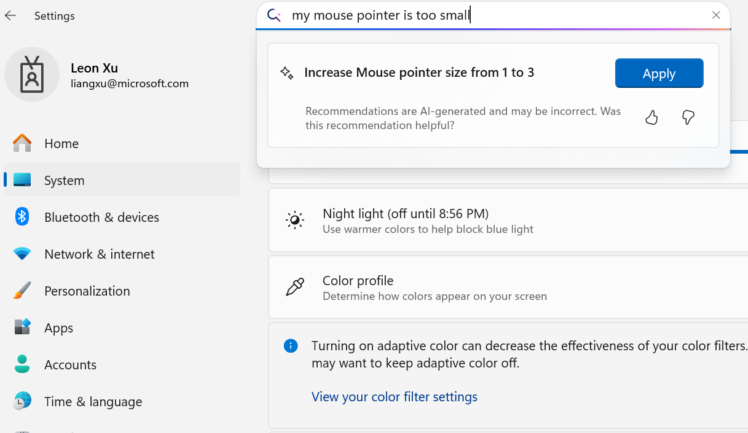

微軟Windows應用科學副總裁Vivek Pradeep於周一(6/23)發布部落格文章,揭露一款專為Copilot+ PC所設計的小型語言模型Mu。這是一個可於裝置端執行的模型,目前主要應用在Windows系統中的「設定代理人」功能,協助使用者透過自然語言調整數百項系統設定。該功能目前僅開放給Dev頻道中、使用Copilot+ PC的Windows Insiders測試者試用。

微軟於2024年5月正式發表主打AI應用的Copilot+ PC,採用基於Arm架構的系統單晶片,並整合神經處理單元(NPU),要求其NPU運算效能至少達到每秒40兆次操作(40 TOPS)。包括Surface、ASUS、HP、Lenovo、Dell、Acer等品牌皆已推出Copilot+ PC。然而截至2025年第一季,這類產品在整體PC市場中的市占率仍不到5%,距離普及尚有一段距離。

Mu模型正是專為這類具備NPU的裝置所打造,可完全於本機執行,推理速度超過每秒100個token。這也是微軟首度將語言模型應用於裝置端,並聚焦於「Windows設定代理人」的角色。使用者只需輸入像是「開啟飛航模式」、「提高螢幕亮度」、「關閉自動更新」等自然語言,就能觸發對應設定操作。不過目前僅支援文字輸入,尚未直接支援語音。

圖片來源/微軟

Pradeep表示,Mu是在微軟開發Phi系列模型的基礎上重新設計,從零開始打造、專為資源受限的NPU裝置最佳化。其核心採用Transformer的Encoder–Decoder架構,能先全面理解輸入內容,再產生精準輸出,運算效率更高。

為了發揮裝置端效能,微軟針對Mu的模型尺寸與參數分配做出精細調整,例如將2/3的參數配置給編碼器、1/3配給解碼器,並採用輸入/輸出權重共享以節省記憶體。同時,Mu僅使用NPU完全支援的運算操作,確保每次推理都能以最高效率執行。

在訓練過程上,Mu先以數千億個高品質教育資料進行預訓練,再透過Phi模型進行知識蒸餾,最後以LoRA微調技術針對特定任務強化模型表現。即便模型體積僅為Phi-3.5-mini的十分之一,Mu在標準任務(如SQuAD問答與CodeXGlue程式任務)上的表現仍與Phi相當接近。

在部署階段,微軟應用了後訓練量化(PTQ)技術,將模型從浮點格式轉為整數表示,進一步壓縮體積並降低計算負擔。加上與Qualcomm、Intel、AMD等晶片廠的合作優化,Mu在如Surface Laptop 7等Copilot+ PC裝置上,推理速度可達每秒200個token。

Pradeep補充,目前Mu僅應用於Windows設定代理人,並已針對此任務使用約360萬筆樣本進行微調,涵蓋數百項系統設定。模型也根據輸入語句的長度與明確程度調整回應方式,例如輸入「亮度」這類短語時會回傳傳統搜尋結果,而輸入「提高主要螢幕亮度」這類具體語句,才會由Mu代理人執行具體設定動作,以兼顧準確度與使用體驗。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-02-26

2026-03-02