Google Cloud國際資安合作負責人Christopher B. Porter在2025臺灣資安大會揭露現階段攻擊者運用AI的最新態勢。攝影/iThome

隨著近年生成式AI、大型語言模型(LLM)演進,資安界持續關注新興科技引發的風險,主要有兩大類包括:一是生成式AI本身的風險,這涵蓋攻擊者針對AI應用服務的攻擊,不久前我們剛完成相關報導,介紹LLM十大應用程式風險;另一是攻擊者運用AI技術提升網路攻擊的風險,在2025臺灣資安大會期間,恰巧有Google Cloud Security專家解析此議題,當中說明他們實際看到的攻擊者AI運用態勢,更指出現階段的最大危害,在於社交工程與語音偽冒的風險已變得更加嚴峻。

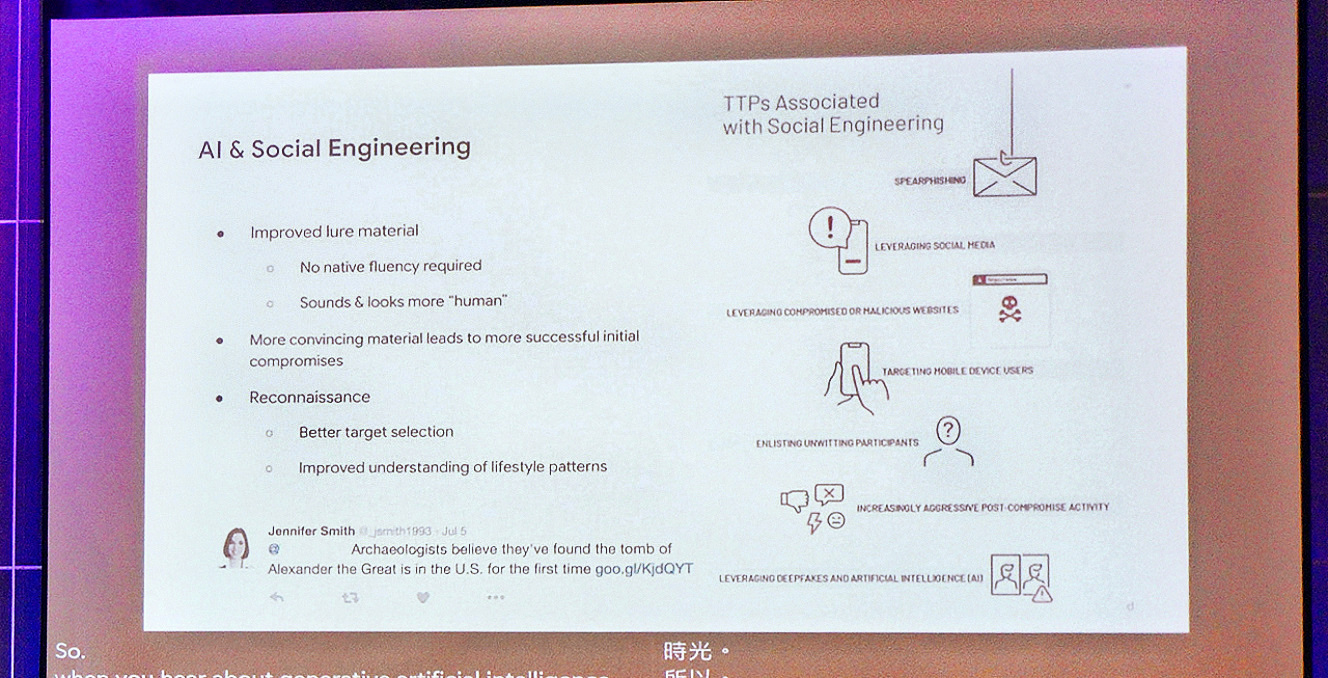

現階段生成式AI最常被駭客用在:社交工程攻擊的強化

「儘管外界多半擔憂AI被用於開發惡意程式,挖掘零時差漏洞用於攻擊,或自動化大規模攻擊,但實際上,生成式AI最常被攻擊者運用在社交工程手法的強化,特別是網路釣魚與偽冒行為。」過去曾擔任美國國家情報總監辦公室資安事務情報長,現為Google Cloud國際資安合作負責人的Christopher B. Porter指出,這些發現並非理論推測,而是來自Google Cloud客戶與Mandiant全球事件應變團隊的實際觀察結果。

生成式AI已打破語言的障礙,這也讓攻擊者在網路釣魚攻擊方面更有破壞力,Christopher指出,例如活躍於東歐、中東或拉丁美洲的網路犯罪集團,現在也有能力入侵臺灣的組織。

Christopher直言:「過去這些駭客雖然技術力強,但苦於語言障礙,難以理解或模仿目標組織內部的溝通語境,即使滲透後要找到關鍵敏感資料也很費工,如今這個障礙已不存在了。」

換言之,防禦方要意識到社交工程攻擊的風險,將比過去要來得更為嚴峻。因為現在攻擊者可以製作更高可信度的魚叉式網路釣魚(Spear Phishing)的內容,不僅跨越多種語言,亦有正確的用字遣詞。

而且,駭客入侵公司組織電子郵件後的行動也更加容易,因為AI能幫助總結電子郵件的內容,因此可以更逼真地偽冒回應,並製作更容易引人誤信的郵件內容與對話。

Christopher強調,儘管大眾普遍關注攻擊者將AI技術應用於零時差漏洞挖掘或惡意軟體開發,但以2025年而言,更實際的威脅在於:具備高度技術能力的攻擊者,如今正在藉由AI強化魚叉式網路釣魚攻擊的精準度與說服力,而不像過去可能因為無法深入理解目標環境而受限。

偽冒聲音的駭客攻擊成功率更高,金融業以語音驗證身分的方式現在就不再可靠

除了濫用文字生成進行網釣,另一個攻擊者用AI提升網路攻擊的嚴重威脅,是語音與影音偽造。

具體而言,攻擊者製作的Deepfake影片,特別會用於資訊操弄、輿論影響行動,但Christopher提醒,偽冒聲音、音訊所帶來的威脅成功率更高,需要大家特別留意。

舉例來說,例如你接到一通電話,聲音與你相識一輩子的親人、朋友、或同事幾乎一模一樣,即便是陌生號碼的來電,你聽到聲音後還是可能分辨不出問題,這與人類心智的運作有關(應指心智辨識熟悉聲音時,會自動套用既有記憶與信任感),使我們難以察覺其中的異常。

Christopher表示,根據Google Cloud與Mandiant團隊的觀察,這類受害案例遍布各行各業,其中又以金融業最為嚴重,比例高達三分之一。

在此威脅態勢之下,他特別強調一件事:「之前有許多銀行提供VIP客戶的服務,其安全措施是建立在語音驗證上,但這兩年AI進步到如此程度,傳統的安全措施今日已經變得無效,這不是未來的威脅,而是現在進行式。」

而且,這不僅僅是金融業面對的挑戰,在大家的工作環境中,若你接到來電的聲音與主管聲音很像,甚至是你主管的主管,要求你或命令你去做一些不尋常的事情,身為員工的你很有可能照做。

Christopher指出,這就是社交工程利用人性的問題,如果你接到重要或權力人士的來電,即使感到懷疑有些不對勁,但很可能依然會依照對方指示行動,最終落入詐騙陷阱。

我們從Christopher的說明,聯想到許多網路攻擊的成功率都可能因此大幅提升。過去像是商業電子郵件詐騙(BEC)這類精心策畫的攻擊,主要利用非即時同步的電子郵件溝通管道,如今攻擊者可讓誘騙管道擴及即時同步的語音溝通方式,搭配AI偽冒語音技術,變得更加能夠取信於受害者,

對於這樣的威脅演變,Christopher指出,語音偽冒攻擊的確極難防範,雖然已有相關技術解決方案正在研發,但當可行技術尚未成熟前,最有效的防禦策略,就是建立良好的政策與制度。例如,重要命令不能透過電話下達,應要求以受信任的數位通訊環境,或是親自傳達的方式進行。

他也特別提醒,不應為高階主管設立特例規則,否則將可能成為繞過安全機制的漏洞。他也再次強調,任何語音作為驗證身分的手段,現在就已經不再可靠。

對於駭客應用Deepfake的態勢,Christopher另外舉出一例。他表示,這幾年北韓駭客假冒IT工程師的行動持續擴張,主要就是透過偽造身分、Deepfake技術與社交工程等詐騙手段,來應徵遠端工作的IT職位。不論是利用他人資料建立虛假的LinkedIn和GitHub帳號,甚至使用Deepfake生成假照片或深度偽造影片,以通過視訊面試。

一旦受雇,這些意圖不軌的工作者就會竊取公司機敏資訊,並在被發現或解雇後,可能威脅公開這些資料,要求贖金。他指出,假冒IT工作者的北韓駭客滲透的範圍,雖以美國科技公司為主,但已擴及英國、歐洲及亞洲等多國企業,近期更頻傳有滲透加密貨幣交易所的案例。

最新Google DeepMind研究出爐,顯現AI會讓攻擊的偵察成本降低

攻擊者還有哪些潛在AI運用方式?Christopher表示,Google DeepMind對這方面有深入研究。該單位是Google設於英國的AI研究部門,於2023年整合Google Brain與DeepMind兩大部門而成。

Christopher特別引述Google DeepMind於今年3月發表的最新論文,解釋AI遭濫用於網路威脅的情況,並指出該研究的目標在於建立系統化框架,以評估生成式AI在網路攻擊情境中的應用潛力。

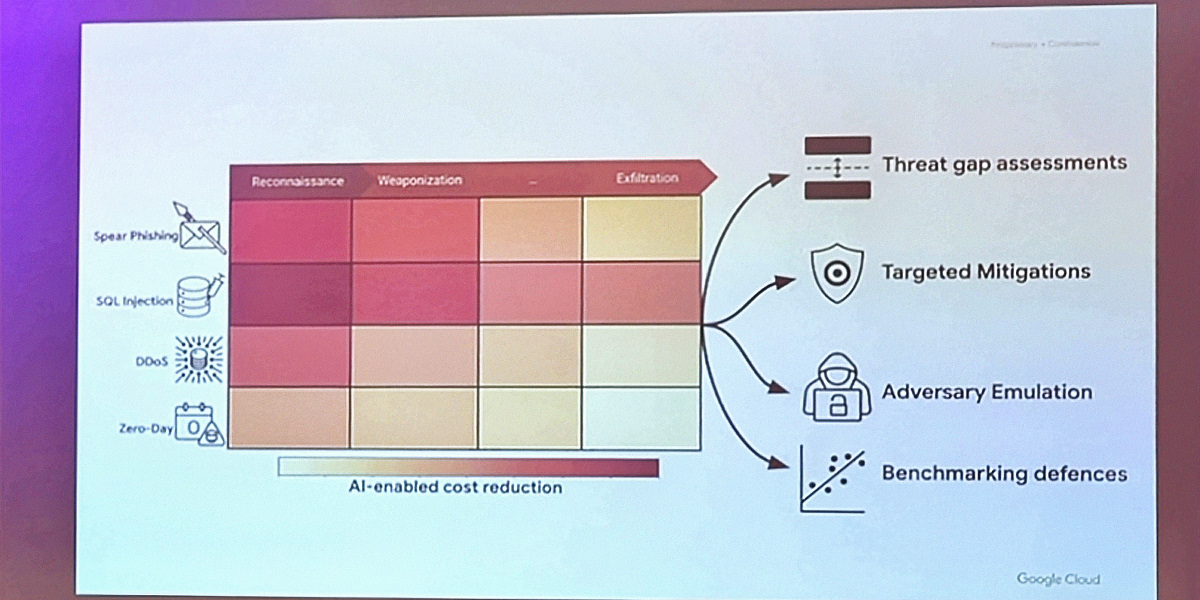

首先,他以簡報展示該研究團隊設計的分析矩陣示意圖,讓大家了解其架構與分析方式。根據簡報內容,我們可以了解到,這個矩陣的設計主要包含兩個維度:

橫軸是將每項任務對應至網路攻擊鏈或MITRE ATT&CK的不同階段。例如,從偵察(Reconnaissance)開始,再到武器化(Weaponization)等多個不同階段,最後則是滲出(Exfiltration)階段。

縱軸是定義出多個明確攻擊任務,例如,魚叉式網路釣魚(Spear Phishing)、SQL注入攻擊、DDoS攻擊,以及零時差漏洞攻擊等。

這項研究有哪些重要發現?Christopher解釋,在此我們先要假設生成式AI能涵蓋所有工作任務,而圖中(如上圖)色塊越深的部分,表示AI對攻擊者的效益越大,可降低更多攻擊成本。依據圖中顯示,在攻擊的初期,也就是「偵察」階段,AI的效益最為明顯,可協助駭客快速搜尋與分析目標的公開資訊,大幅降低準備成本。

他們另也發現,當攻擊任務愈抽象或複雜,例如「竊取資料時不要被發現」,或是「隱密竊取特定類型資料」,AI的能力則迅速下降。如果是相當複雜的任務,成功率更是接近於零。

儘管這是一項學術研究,但Christopher表示,其結果非常接近Google威脅研究小組在現實世界看到的網路攻擊情形。

另一方面,Google DeepMind也有依據任務的複雜程度,嘗試驗證是否影響其攻擊成功率,結果顯示,即使他們依據MITRE ATT&CK等資源,針對LLM提供了非常詳細的範例進行訓練,AI仍只能完成較簡單的部分,對高階、複雜行動的支援能力有限,像是生成式AI可以完成所有Strawman(稻草人)等級任務,但簡單任務的完成率只有50%,中等任務則下降至約10%,困難任務成功率更是低於10%。

整體而言,在Christopher介紹之下,我們可以發現這項研究提供了一個新的角度,防禦方可以藉由量化攻擊者在各階段用AI的效益,進一步思考我們如何可以讓攻擊變得不划算。

繼續閱讀:【臺灣資安大會直擊】國家級APT駭客族群如何濫用生成式AI?

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03