來自喬治亞理工學院、多倫多大學等機構的研究員發表AnyPlace,是一套機器人訓練方法,只靠合成資料,就能學會如何擺放物體,且在現實世界中依然可行。

重點新聞(0228~0306)

機器人 合成資料 AnyPlace

單用合成資料,也能訓練出精準擺放物體的機器人

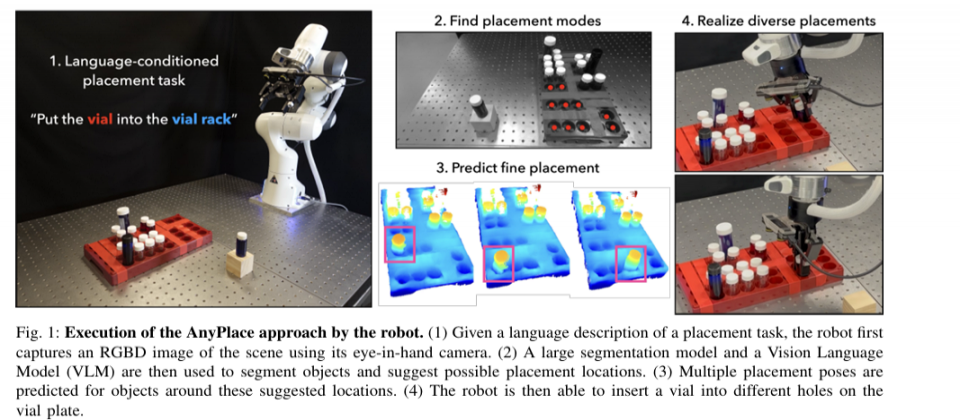

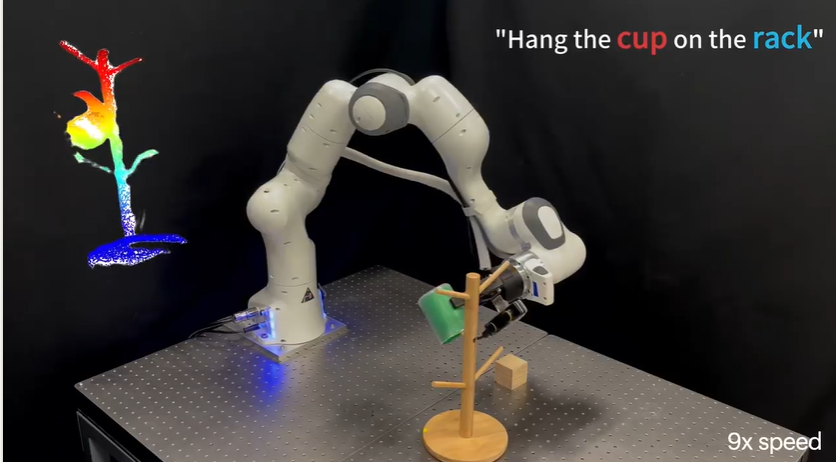

最近,來自喬治亞理工學院、多倫多大學、Vector Insititute等機構的研究團隊發表一項新機器人訓練方法AnyPlace,專門用合成資料,來訓練機器人在現實世界中擺放物體,包括堆疊、懸掛、插入等多種擺放方式。這個AnyPlace包含兩階段方法,首先是用視覺語言模型(VLM)來辨識大致的擺放區域,同時聚焦要擺放的局部區域。如此一來,就能用來訓練擺置動作預測模型,來在精確範圍內預測最佳的擺放方式,這就是第二階段方法。

為加強模型泛化能力,團隊用合成資料來訓練模型,包括用Blender生成隨機物體、用IsaacSim設置多元的擺放配置,來讓模型在沒有真實世界資料的條件下,學習擺放各種物體。經測試,AnyPlace在成功率、擺放方式和精確度等方面超越基礎模型,且能在真實世界中正確擺放,有別於其他模型的吃力表現。(詳全文)

生物電腦 人類神經元 CL1

澳洲新創用人腦神經元打造生物電腦

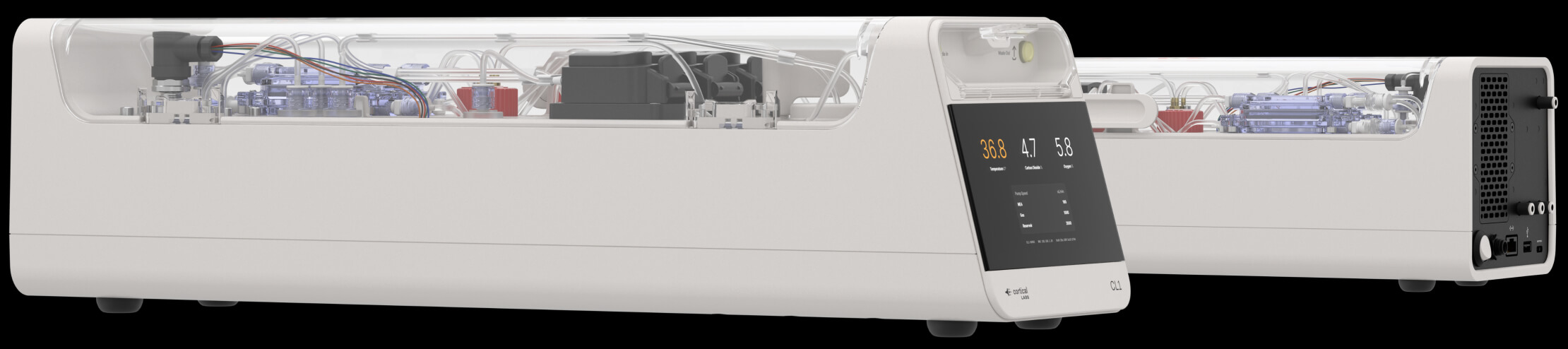

在近期落幕的行動通訊大會MWC上,澳洲一家生物科技公司Cortical Labs亮相一款商用生物電腦,名為CL1,由數十萬個人類腦細胞和傳統矽晶片組成,目前正研究其在AI和機器學習等領域的潛在應用。CL1由一個矽晶片組成,覆蓋一層實驗室培育的人類神經元。這些神經元可回應電訊號,形成類似生物大腦的訊息處理網路,並整合到自家開發的生物智慧作業系統(biOS)中,作業系統可將環境資訊傳遞給神經元,由神經元反應、執行模擬。

該公司表示,這些神經元可感知和適應環境,形成原始的學習能力,也能部署程式碼。不過,這些神經元最長可存活6個月。Cortical Labs認為,將生物元素整合到電腦中,可提高傳統AI難以完成的任務的效率,例如模式辨識,或在不可預測環境中的下決策。在推出CL1前,Cortical Labs 曾在2022年打造DishBrain生物電腦,由實驗室培養的80萬個神經元組成,經訓練後可以玩簡單的乒乓球遊戲。

Cortical Labs透露,首款CL1電腦將於今年6月出貨,每臺售價約3萬5千美元,使用者也能透過WaaS(Wetware-as-a-Service)雲端服務從遠端使用。儘管CL1這樣的生物電腦可能比傳統AI模型更有優勢,特別是學習效率和能耗部分,但這項技術的可擴展性仍不明確,要生產和維護這類系統,也比傳統處理器複雜許多。尤其,人類腦細胞的應用也引發倫理擔憂。(詳全文)

資料 數發部 人才

數發部瞄準AI資料需求,研擬草案要解放更多資料價值

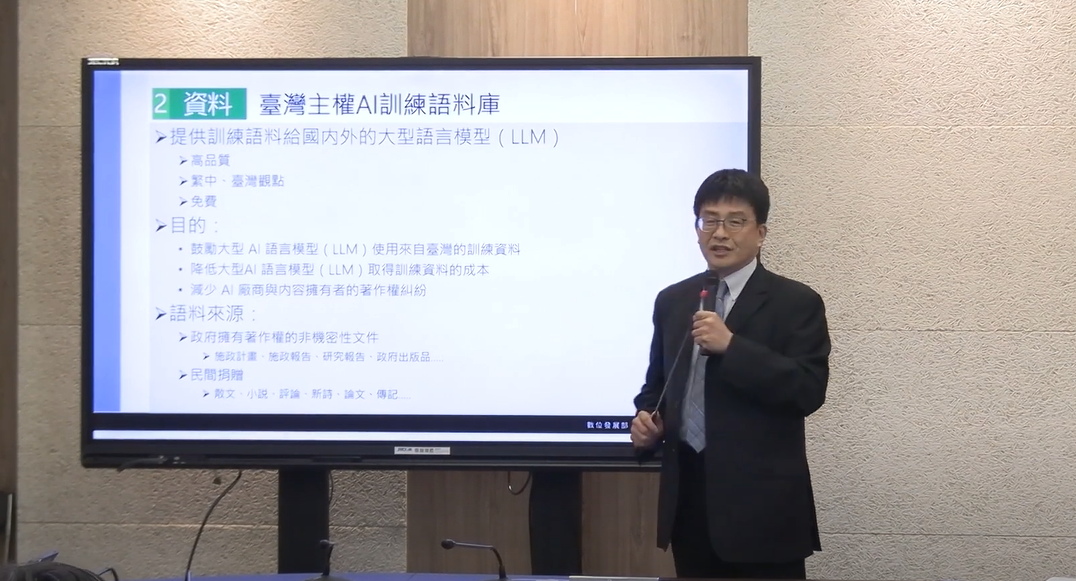

數發部在2月27日揭露發展臺灣AI的5大策略,鎖定算力、資料、人才、行銷和資金。其中,就資料來說,數發部今年要研擬促進資料創新利用發展條例草案,來提高非個資資料於AI訓練的可用性,同時建置臺灣主權AI訓練語料庫,作為訓練語料給國內外LLM使用,內容將涵蓋政府擁有著作權的非機密性文件,以及鼓勵民間捐贈的著作權內容。

不只非個資的資料,對於政府各部會擁有含有個資的結構化資料,數發部也提出資料匯流與隱私強化的計畫。該計畫將由數發部建置資料匯流的Proxy連結各個部會,由各部會提供資料目錄,當AI研究員向數發部提出資料需求,數發部再轉向管理資料的部會提出需求,部會將資料經過去識別化處理後,傳送給數發部,再由數發部進一步強化隱私處理,並將處理後的資料提供給AI研究員。

至於AI人才部分,目前數發部正在推動公務機關導入AI,要透過線上課程、實體課程,培養一般公務人員運用AI提升效率,另也要針對公部門IT人力,培養簡易開發AI應用的能力。再來,產官學的AI人才培養,則將由國科會、教育部、數發部、經濟部分別推動計畫,數發部也會與AI學校等民間單位合作,制定AI開發人才指引及標準。(詳全文)

算力 資金 媒合

數發部揭AI算力、行銷和資金策略

數發部在2月27日宣布,要從算力、資料、人才、行銷、資金等5面向提高臺灣AI發展。其中,就算力而言,目前以國科會國家實驗研究院的國網中心超級電腦為主,去年底建置的新超級電腦算力達16PF,預計今年5月開放算力服務,今年底再增100PF算力。

同時,數發部數產署去年已建置共32片Nvidia H100和8片AMD MI300X的GPU算力池,算力約1.58PF,去年已開放部分軟體、新創者申請免費使用,今年預計開放三個梯次申請,包括4月開放50家業者免費使用、7月和10月各開放70家業者使用。

另一方面,行銷策略方面,數產署將與軟體業者合作,舉辦多場Demo Day或需求媒合會,讓軟體或AI業者展示AI產品或服務,供開發資源不足的中小型企業參考。至於資金,數發部要與國發會合作,匡列為期10年的100億元預算,要與民間創投業者聯手共同投資具潛力的AI業者,或還未上市櫃的數位經濟領域公司。(詳全文)

VS Code 代理模式 智慧提示

VS Code 1.98版再強化Copilot整合,推代理模式

微軟最近發布程式碼編輯器VS Code 1.98正式版,針對GitHub Copilot的編輯輔助體驗、終端機智慧提示和自動化執行能力進行大幅升級。首先,這次更新主打的Agent模式,讓Copilot能自動檢查程式碼錯誤,還能以互動式介面執行終端機指令,協助開發者自動完成更複雜的工作流程,比如開發者透過簡單的快捷鍵,確認或修改Copilot提出的終端機指令,減少過去在終端機與編輯器間來回切換的不便。

另一個亮點是終端機智慧提示(Terminal IntelliSense),VS Code 1.98改善了終端機中常見Shell工具的智慧化完成功能,增加對Bash、Zsh與PowerShell指令更詳盡的參數描述,也納入絕對路徑與別名(Alias)的辨識,提供更直覺且準確的建議資訊。再來,VS Code也針對Notebook編輯進行調整,開發者在編輯Jupyter Notebook等檔案時,Copilot可針對不同的Notebook單元格提供更流暢的自動化建議,降低手動編輯大量資料和文件的負擔。(詳全文)

阿里巴巴 QwQ-32B 推理

阿里巴巴開源QwQ-32B模型

繼於去年11月釋出QwQ-32B-Preview模型之後,阿里巴巴旗下的通義千問團隊近日正式開源QwQ-32B。千問團隊主要開發同名的Qwen基礎模型,而QwQ則是以Qwen系列為基礎的推理模型,具更深入的思考和推論能力,可在相對困難的下游任務中,表現更好。

這個具325億參數的QwQ-32B屬中型推理模型,團隊稱其表現可媲美DeepSeek-R1、o1-mini等先進模型。他們用來衡量模型表現的基準測試,涵蓋了數學推論、程式碼任務、語言能力、遵從自然語言指令的能力,以及函數調用能力,並發現,自家模型表現都與DeepSeek-R1-671B、OpenAI-o1-mini以及Qwen-32B等模型相當,有些甚至超越。(詳全文)

圖靈獎 強化學習 獎勵

2024圖靈獎頒給強化學習奠基者

有電腦科學界諾貝爾獎之稱的ACM圖靈獎,日前揭曉2024年得主,皆為奠定強化學習(Reinforcement Learning)的兩位重量級人物,分別是Andrew Barto和Richard Sutton。這兩位學者從1980年代開始,逐步建立強化學習核心理論和演算法框架,如時序差分學習演算法、策略梯度法、神經網路表達學習函式等,讓電腦在未知環境下,能根據累積的經驗自行調整行為,逐步提高決策品質。

這些貢獻,奠定了AI代理透過經驗和獎勵訊號來自主學習的基礎,進而開啟機器自主決策的現代應用。尤其,過去10年深度學習快速崛起,強化學習技術再次受到重視,特別是在對話機器人ChatGPT中扮演的關鍵角色。其他如晶片設計、機器人控制、網路壅塞控制,甚至供應鏈最佳化等領域,也已開始大規模導入強化學習技術。(詳全文)

微軟 Phi 多模態

微軟發表多模態模型Phi-4-multimodal

微軟在2月底發布小型語言模型Phi-4-multimodal,具56億參數、支援12.8萬Token的上下文長度,可處理語音、圖像和文字任務,已於Azure AI Foundry、Hugging Face和Nvidia API Catalog等平臺上架。相比前幾代模型Phi-3.5和Phi-4.0,這次版本不但加強多模態整合能力,也強化了語音辨識、視覺理解和推理能力,適合開發多種AI應用場景。而且,Phi-4-multimodal還針對運算資源受限情況進行最佳化,能在裝置端執行。

目前,這個多模態模型可處理20種語言,如中文、日文、韓文、德文和法文等,語音則能處理英語、中文、西班牙語、日語等主要語種,圖像處理則以英文為主。另一方面,微軟也推出Phi-4-mini,是一款38億參數的小模型,專注於文字處理,特別適用於程式碼生成、數學推理、長文本處理與函式呼叫,也支援12.8萬Token內容。(詳全文)

圖片來源/喬治亞理工學院、Cortical Labs、數發部、阿里巴巴

AI近期新聞

2. Google搜尋測試新工具,具推理能力的AI Mode

資料來源:iThome整理,2025年3月

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02