微軟發布最新機器學習推理引擎ONNX Runtime 1.5,這個版本加入了ONNX Runtime Mobile的支援,現在開發者可以在智慧型手機、嵌入式裝置和物聯網等邊緣裝置,以ONNX Runtime執行機器學習模型。

ONNX Runtime是用來執行ONNX模型的推理引擎,可以在不同作業系統和硬體上執行,由於ONNX Runtime提供的Execution Provider介面,使其能夠輕易地與不同硬體整合,目前有適用於x86_64和aarch64的套件,開發者也可以從原始碼自定義配置,而現在ONNX Runtime 1.5發布的,是專為各種邊緣裝置最佳化的套件。

邊緣裝置套件支援與一般裝置相同,能夠管理和執行推論對話的API,藉此將人工智慧應用,帶入到更廣泛的使用情境中,解決邊緣任務。微軟提到,邊緣裝置應用程式利用主機平臺或是打包函式庫的Runtime引擎,執行機器學習模型,這些應用程式使用的磁碟與記憶體容量會比較小,才能最佳化行動裝置、Windows 10電腦,和其他邊緣裝置的資源使用。

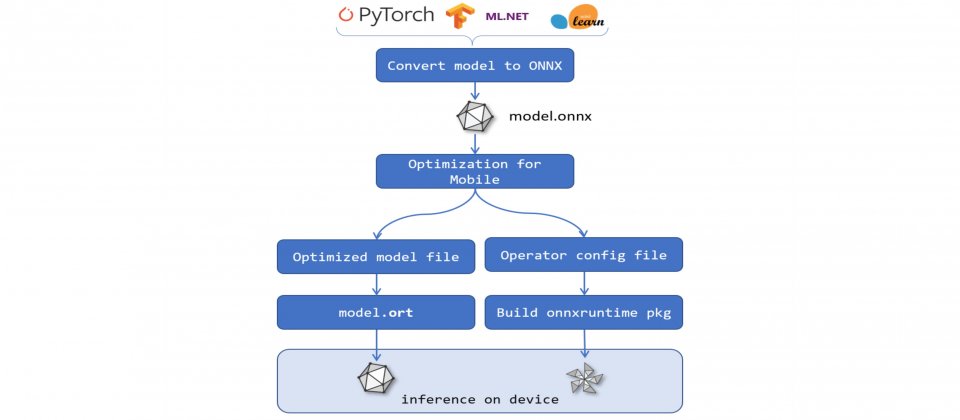

為此,微軟發布了ONNX Runtime Mobile,使得開發人員可以創建較小的Runtime套件,在客戶端裝置中執行ONNX模型。ONNX Runtime Mobile以用戶配置的ONNX模型集,自定義二進位檔案,並且在模型檔案使用最佳化檔案格式,以縮小整體套件容量。

ONNX Runtime Mobile仍可以執行所有標準ONNX模型,套件的大小取決於開發者支援的模型。微軟比較ONNX Runtime Mobile,以及TensorFlowLite支援Mobilenet模型的套件容量,ONNX Runtime完整建置要7,546,880位元組,而ONNX Runtime Mobile則只要387,398位元組,略大於TensorFlowLite的382,892位元組。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23