李宗翰攝影

【美國拉斯維加斯現場報導】原本是學術領域較常用到的高效能運算(HPC)技術,如今隨著大數據分析與人工智慧的走紅,開始日益受到重視,但過往我們可能必須在設有超級電腦的特定環境,才能發展相關的應用,然而,隨著運算技術的進步,如今我們可以透過串連多臺x86伺服器,搭配GPU加速卡,也能支援高效能運算的各種應用。

然而,如果要在伺服器虛擬化平臺、雲端服務的環境,執行高效能運算,至今似乎仍相當少見,因為大家總會擔心在這樣的虛擬、多租戶共享的架構下,運算和I/O效能都會有折損,如何還能支撐高效能運算的使用場景。

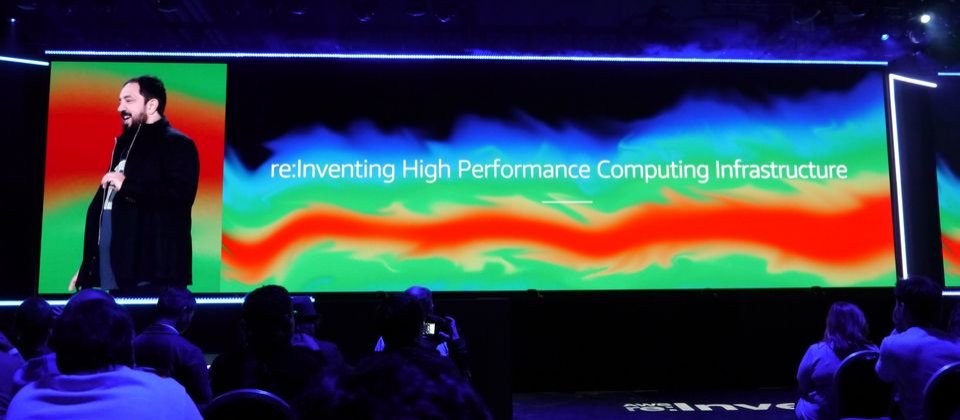

不過,現在有公有雲業者想要打破這個刻板印象,希望吸引更多有這方面需求的用戶,也能積極考慮採用公有雲環境。舉例來說,今年AWS在年度全球用戶大會re:Invent的第一天,AWS全球基礎設施與客戶支援副總裁Peter DeSantis就以此為題,講述他們現在其實已經能夠負荷這樣的應用情境。

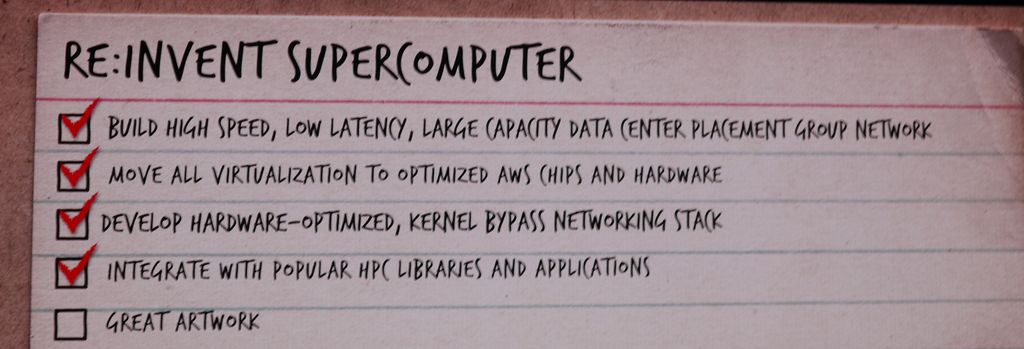

為何現在AWS提供的IT基礎架構,已做到能讓一般用戶向其租用超級電腦等級環境的需求?Peter DeSantis列出了他們重新發明超級電腦架構的歷程。

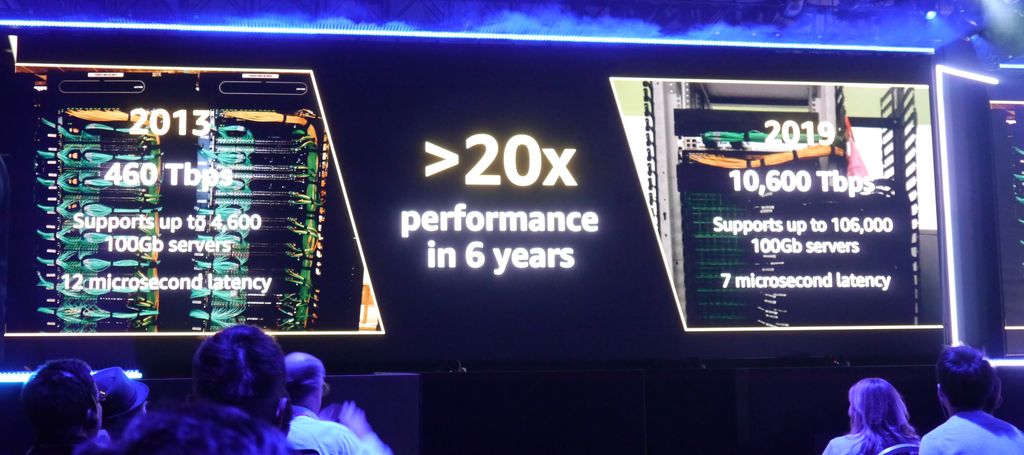

首先,是建立了高速、低延遲、大容量的資料中心網路。經過6年的發展,AWS目前提供的執行個體(虛擬機器或裸機的租用服務),有了相當大的進步,不只是虛擬CPU的顆數增加了1倍多,尤其是網路規格就成長了10倍(10Gb vs. 100Gb),在整體網路負載的能力上,更是差距20倍以上(460 Tbps vs.10,600 Tbps)。

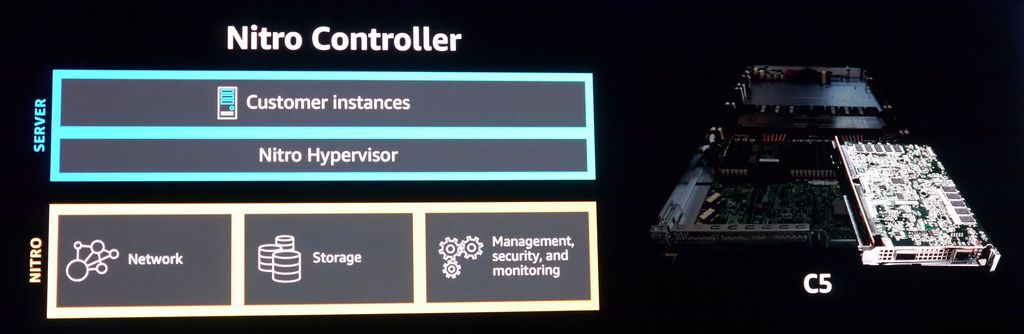

第二,將所有虛擬化作業都卸載到AWS發展的晶片與硬體技術。這裡所指的硬體技術,主要是AWS與2015年併購的Annapurna Labs研發的Nitro Controller架構,在這樣的系統之下,EC2所有虛擬化功能都是執行在Nitro Controller,網路流量雖然轉為虛擬化,但延遲度、變化性、成本均可降到最低。目前而言,EC2的C5和C5n都是基於這個技術而成的執行個體。

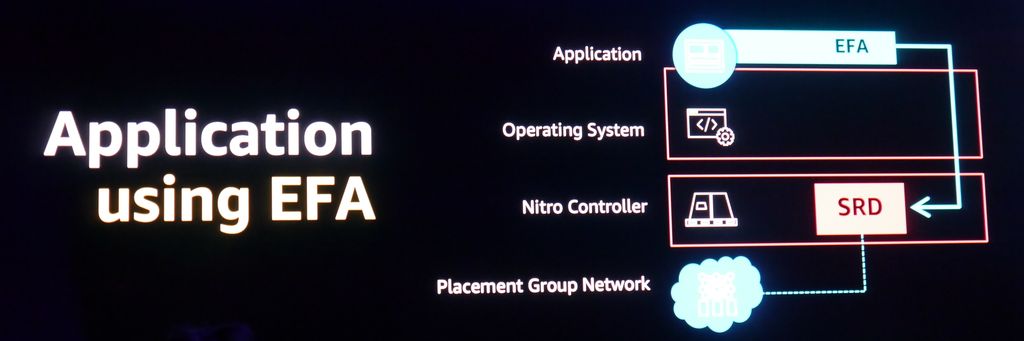

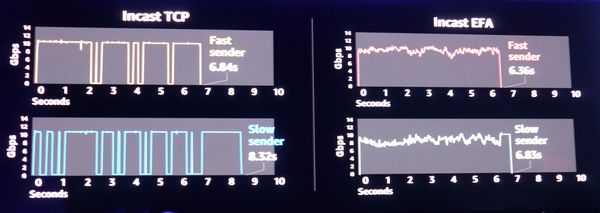

第三,AWS發展出硬體最佳化、核心旁路的網路堆疊(Kernel Bypass Network Stack)。他們在2018年的re:Invent大會宣布推出的網路介面Elastic Fabric Adapter(EFA),就是一個例子。相較於原本只用TCP來進行Incast的傳送,改用EFA來處理,可縮短傳送較快者與傳送較慢者之間的傳輸時間差距。

第四,整合常用的程式庫與應用程式。以EFA而言,不只是Amazon Linux支援,也有其他軟體或應用程式介面支援,像是Ubuntu、Red Hat、SUSE、OpenFOAM、LS-DYNA、Open MPI。

最後,要有很好的使用案例。Peter DeSantisu也舉出幾個企業應用實例,主要是銷售風扇的Big Ass Fans公司,以及與AWS合作的F1賽車。

熱門新聞

2026-02-26

2026-02-27

2026-02-27

2026-02-27

2026-02-27

2026-02-26