Google、史丹佛大學以及哥倫比亞大學合作,開發了一種稱為Form2Fit的機器人操作演算法,能夠透過深度神經網路,學習視覺辨識物體之間的對應關係,執行像是把物體擺放到相對應形狀的包裝或紙盒中的任務。Form2Fit現在已經可以讓機器人組裝各種類型的套件(Kit),成功率達到94%。

形狀是現實物體組合的基本概念,而人們在日常生活中,也會不停地組合各種物體,像是把外套掛到衣架上、把插頭插進插座中,或是把USB接到對應的USB孔裡,人們藉由時間累積經驗,學習把事務組合在一起的知識,而研究人員認為,要是機器人也可以學會這樣的能力,未來將可以自動把DIY家具組合起來,或是自動包裝禮物。

過去要教機器人組裝的能力,把物體精確的擺放到對應的盒子中,使其成為一個單元,需要為特定任務建置專門的系統,而且需要大量的手動調整,才能一次組裝一個套件,而現在研究人員則是應用物品對應在一起的一般概念,讓機器人能夠組裝各式套件,Form2Fit演算法是第一個可以組裝,在訓練期間未見過物體的系統。

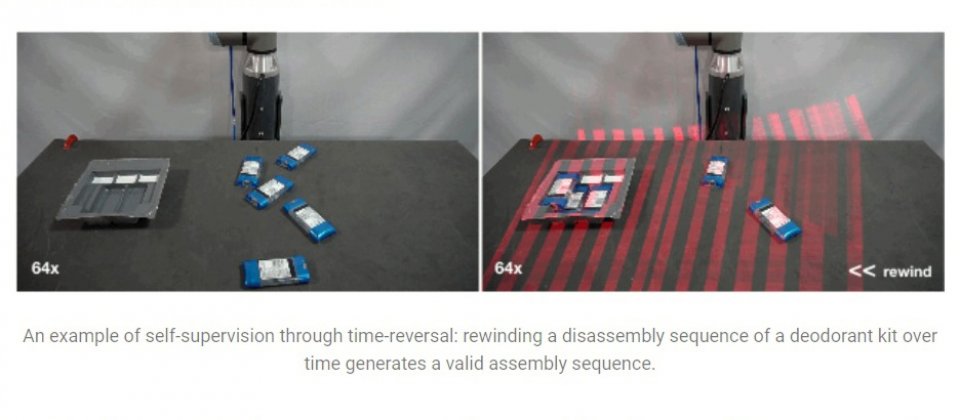

Form2Fit是從拆卸過程學習組合的方法,研究人員提到,神經網路需要大量的訓練資料,但組裝之類的任務訓練資料卻很難收集。要精確地把物體,依照正確的方向插入緊密的空間中,很難靠測試錯誤來完成,因為隨機探索的成功率非常小,而相較之下,拆卸已經完成的單元,更容易透過反覆試驗來學習,因為移除物體的錯誤方法,要比正確插入物體的錯誤方法少得多,因此研究人員利用這種差異累積Form2Fit的訓練資料。

而且許多套件的組裝方式,逆轉拆卸順序就是組裝的順序,這種反轉時間拆卸的概念,可以讓Form2Fit以隨機試錯的方式拆解完整的套件,以自我監督的方式進行訓練,也就是反轉拆解的順序,以學習組裝的方法。

研究人員的實驗結果,發現這個方法的確能讓機器人習得通用的組裝方法,讓機器人自己收集訓練資料,並經過12個小時的訓練後,機器人學習了各種套件的有效撿取和放置的技能,在物體和套件各種不同的配置情況下,機器人有94%的成功率完成組裝任務,而對於全新沒見過的套件,也有高達86%的組裝成功率。

即便Form2Fit初步的成果很好,這是因為研究人員把複雜度限制在2D平面工作空間,讓機器人只要進行上下的撿取和放置操作,但是對於大部分實際的使用情境,都需要有第三維度的參與,因此研究人員會繼續擴展Form2Fit演算法到3D組裝上。

熱門新聞

2026-03-02

2026-02-26

2026-02-27

2026-03-02

2026-02-27

2026-02-27

2026-02-27