AR技術能幫助用戶創造更多數位應用,像是Google地圖的AR功能可以讓用戶找方向,Pixel相機的AR功能也能讓用戶的自拍增添動畫面具、眼鏡、帽子等物品,不過,AR技術最大的挑戰是要將虛擬物件準確的放在真實世界的物件上,這個過程需要一系列特殊的技術,來處理高度動態的幾何表面,像是每個微笑、皺眉細微的臉部表情。

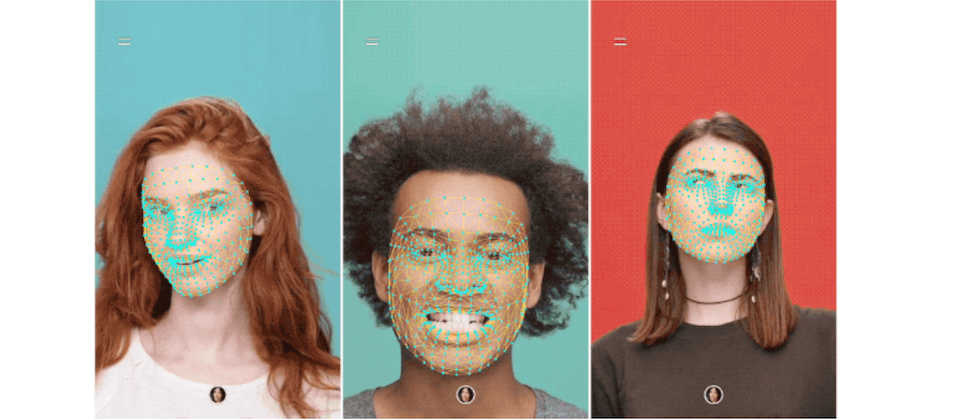

為了能夠準確追蹤臉部表情變化,Google採用機器學習來推斷大約的3D表面幾何形狀,來使得視覺動畫效果變得可行,只需要一般的攝像鏡頭就能做到,不需要精密的深度感測器,這個方法能夠即時產生AR動畫,同時,Google也將該技術透過最新版的ARCore SDK和機器學習臉部輪廓偵測工具(ML Kit Face Contour Detection API)釋出。

Google的AR動畫機器學習工作流程包含2個即時的深度神經網路模型,一個是掃過整個影像和計算臉部位置的偵測模型,另一個則是透過迴歸預測表面幾何的3D網格生成模型,精準地裁剪出臉部位置可以大幅地降低資料增強的需求,像是旋轉、平移等轉化工作,一旦偵測模型找出臉部位置後,網格模型會透過平滑化的技術,來減少靜態臉部圖像中的噪音,同時也針對大幅的移動,避免延遲的情況出現。

Google的3D網格生成模型是透過遷移學習和用多個目標訓練而成的網路,該網路同時預測合成資料的3D網格座標和真實世界資料的2D輪廓,模型接收裁切過的影片片段,經過處理後,生成用3D表示臉部可能位置的點,並且透過TensorFlow Lite,建立裝置上的神經網路推斷模型,來加速模型的效能表現。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23