現實世界中獎勵很少,因此多數的增強學習演算法都努力的解決這種獎勵稀疏性,而解決方式之一就是讓人工智慧自己創造獎勵,Google Brain、DeepMind和ETHZürich合作發表了基於情景記憶的模型,能夠提供增強學習獲得類似好奇心的獎勵以探索環境,這擴展了增強學習可以解決問題的範圍。

增強學習現在是機器學習中熱門的研究領域之一,當人工智慧代理做了正確的事給予獎勵,反之則給予懲罰。DeepMind以這種方式教DQN演算法遊玩Atari遊戲,也讓AlphaGoZero能與人類在圍棋打得難分高下,OpenAI也是用增強學習訓練Open Five遊玩線上戰鬥競技類遊戲Dota 2。另外,Google也以增強學習教機器手臂以近似人的行為抓握物體。

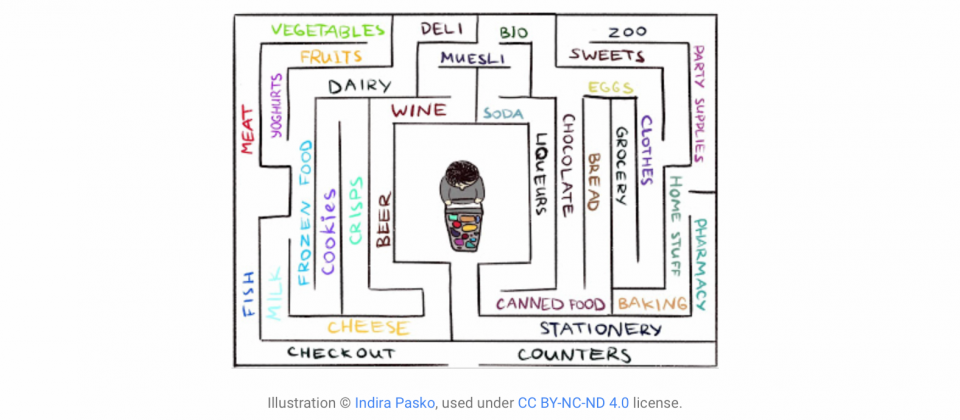

Google提到,標準的增強學習演算法有其問題,人工智慧總會在回饋稀疏的環境中掙扎,而現實世界通常是這樣的環境條件。以在大型迷宮尋找寶藏為例,當人們在迷宮中四處搜尋,但都沒找到寶藏時,在缺乏尋得寶藏的正向回饋獎勵下,如果都不繼續堅持而直接放棄,則永遠無法得知自己是否朝向正確的方向前進,而不會讓人類在迷宮中原地打轉的驅動力便是好奇心,激勵人類朝向一個不熟悉的方向探索以追尋寶藏。

而Google Brain、DeepMind和ETHZürich最新的合作成果,是以基於情景記憶的模型提供代理人好奇心獎勵,讓代理人有動力繼續探索環境,但是探索環境也並非終極目標,而只是達成原始任務的手段,完成任務仍然是最重要的事情,因此研究團隊將模型提供的好奇心獎勵添加到原始任務的稀疏獎勵中,這樣的結合使得獎勵不再稀疏,標準增強學習能夠從中獲得良好學習的驅動力。這個好奇心方法擴展了增強學習可以解決問題的範圍。

.png)

這個方法的關鍵想法是把代理人從環境中獲得的觀察結果儲存在情景記憶中,並獎勵代理人取得尚未在記憶中出現的觀察。因此不在記憶體中,是這個新方法對好奇心的定義,驅使代理人尋求不熟悉事物,而這將帶領人工智慧代理人前往新的位置,進而防止原地打轉的行為出現。

過去也有類似的研究,最近一篇論文Curiosity-driven Exploration by Self-supervised Prediction探討了名為ICM的方法,是透過對即將要發現的事物進行預測,當預測與實際不符時便獲得驚訝獎勵。ICM方法建立了世界動態的預測模型,在模型未能做出良好預測的時候給予代理人獎勵,但由於探索未曾發現過的位置不在演算法中,代理人到這些新位置,只是為了要獲得驚訝獎勵,因此在某些情況下,代理人為了要獲得最大化的獎勵而故意造成自我驚訝,導致奇怪的行為。

ICM演算法的這個自我驚訝的問題,會讓代理人發生拖延症,以上述在迷宮中找寶藏的例子,當代理人在迷宮中遇到電視物件,代理人可以隨意的切換節目頻道,當預測下一個頻道的節目與實際切換的不符合時,便能獲得驚訝獎勵,而ICM代理人為了最大化獎勵,便會在電視前隨機切換頻道,藉由預測錯誤獲得源源不絕的獎勵。

Google基於情景記憶的好奇心模型,被證明不容易產生類似自我放縱獲取即時滿足感的現象,同樣已在迷宮中切換電視頻道來說,最終所有頻道的內容將都在記憶體中,因此所有內容都會變得熟悉,即便節目隨機變換也是一樣,好奇心模型不是對未來進行預測,而檢查過去是否已經觀察過相同的情景。

但要讓代理人判斷看到與記憶體中相同的事物這件事情本身也是個問題,無法以完全匹配的方法來實作,因為在實際情況中,代理人很少會看到兩次完全相同的事情,即便第二次進入相同房間,也會因為記憶中看房間的角度不同,而被認為是不一樣的經驗。最後研究團隊以深度神經網路來判斷兩種經驗相似的程度,而非對記憶體進行精準匹配。在訓練這個神經網路時,研究團隊讓時間作為判斷經驗遠近的重要考量,時間接近度高則會被視為同一經驗。另外,研究人員還以可達性來評斷新穎性,以神經網路來評估經驗之間的距離,決定新穎與否。

.png)

研究團隊分別在ViZDoom和DMLab這兩個視覺豐富的3D環境中測試好奇心模型,在這些環境中,代理人的任務是處理各種問題,像是在迷宮中搜尋目標物、收集好物體以及避開壞東西。

研究團隊提到,他們的方法與先前的研究在相同的條件下相比,更能學習合理的探索行為,這是因為基於情景記憶的好奇心模型不會嘗試預測行為的結果,而是尋求在情景記憶中未曾出現的觀察,換句話說,代理會傾向追求目標,而這些目標是需要更多努力才能達成,而非僅靠單一操作。另外,這個方法給予獎勵的方式會懲罰代理人繞圈子的行為,因為代理人在同一空間繞完一圈後,就不會再觀察到與記憶體中不同的事物,因此也不會獲得任何獎勵,這也讓代理人有更好的探索行為。

熱門新聞

2026-03-06

2026-03-06

2026-03-06

2026-03-06

2026-03-09

2026-03-06

2026-03-06