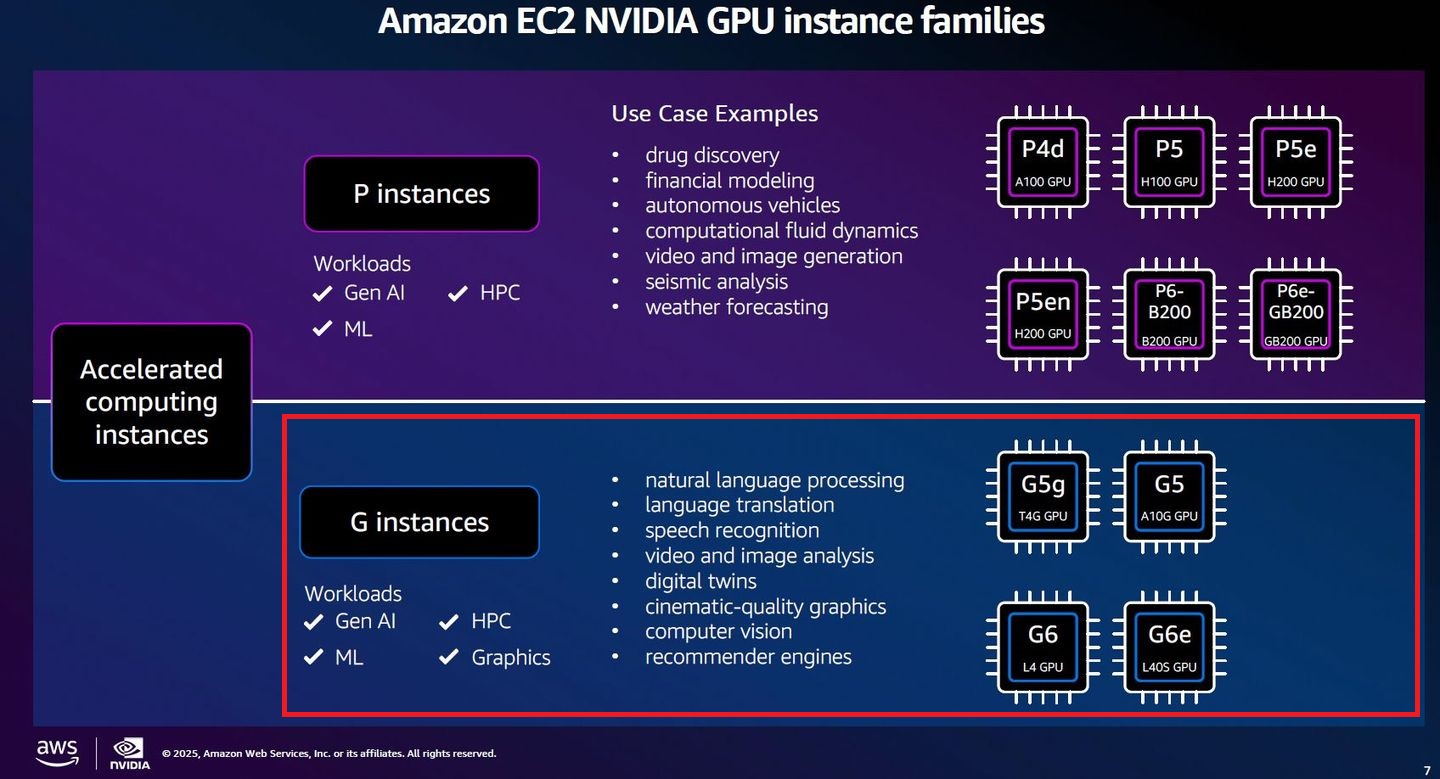

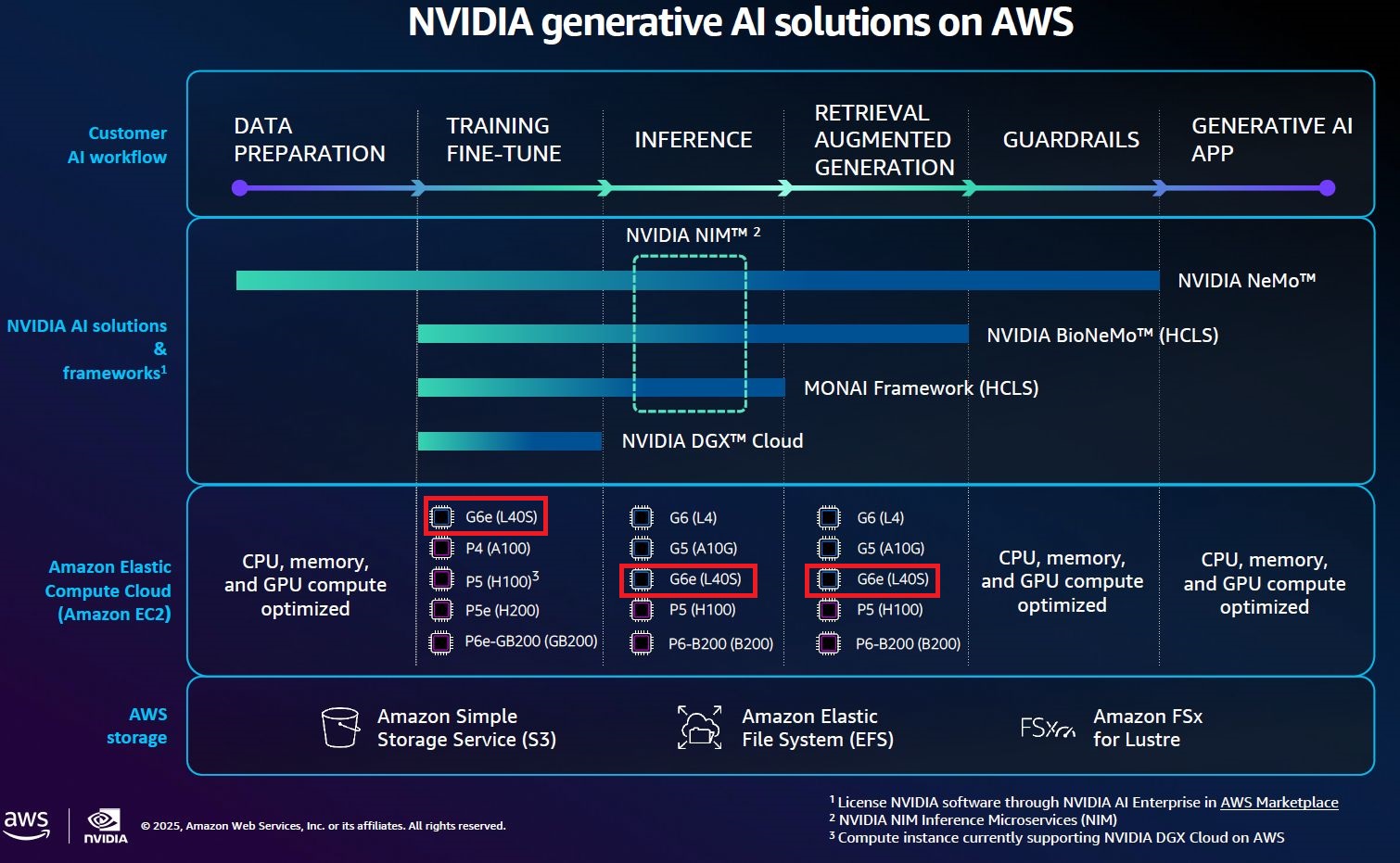

在2025年10月,Google Cloud宣布推出新一代GPU加速運算服務G4,當中將採用Nvidia新一代資料中心PCIe GPU產品RTX Pro 6000 Blackwell Server Edition(BSE),12月初公有雲龍頭業者AWS在年度用戶大會舉行的期間,與Nvidia聯合預告數週後將推出搭配上述GPU產品的雲端服務,到了今年1月AWS宣布為此增設新的加速運算服務G7e,能針對生成式AI推論與承擔繁重圖形處理負荷的工作負載,提供具有成本效益的效能。

純就加速生成式AI推論與空間運算(Spatial Computing)工作負載的AWS雲端運算服務而言,將既有的資料中心GPU加速運算服務G6e作為比較基準,最新上線的G7e可提供2.3倍的AI推論效能。

就細部配置而言,G7e具有多種領先G6e的特色。以GPU而言,G6e搭配的Nvidia L40S,GPU內建GDDR6記憶體,容量為48 GB,頻寬為864 GB/s,G7e搭配的Nvidia RTX Pro 6000 Blackwell Server Edition,GPU內建GDDR7記憶體,容量增加1倍(96 GB),頻寬提升85%(1,597 GB/s),單靠一張GPU,就足以執行FP8精度、700億個參數的中型規模AI模型。

在I/O架構上,G7e支援Nvidia的GPUDirect P2P技術,可針對多GPU工作負載的執行,減少存取延遲。基本上,AWS雲端執行個體能經由PCIe介面互連多個GPU,每個GPU之間可藉此直接溝通,而且,基於同一個PCIe交換器,針對多個GPU的存取,提供最低延遲的點對點存取方式。

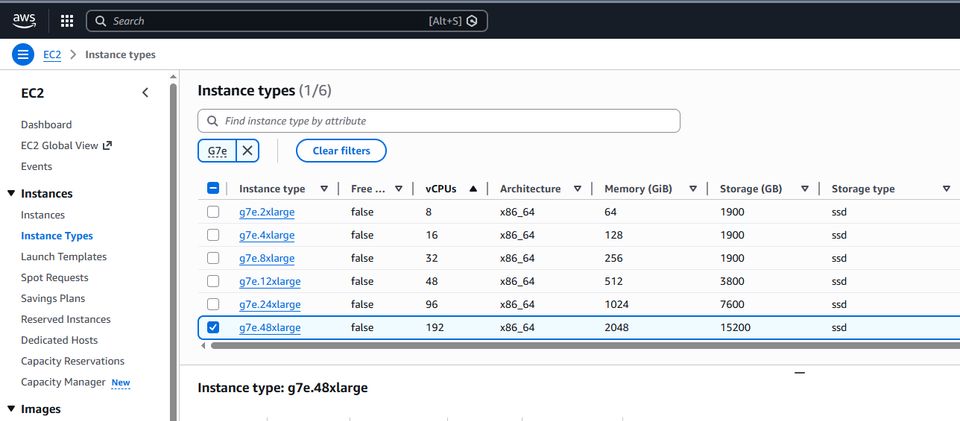

除此之外,單就多個GPU互連頻寬而言,比起G6e採用的L40S,G7e搭配的RTX Pro 6000 Blackwell Server Edition,可達到4倍之多,能大幅提升多GPU工作負載的運作效能。基於這些改善特色,用戶可橫跨多個GPU執行更大規模的模型,以單一執行個體而言,G7e最大可配置8個GPU,總共可提供768 GB的GPU記憶體容量。

網路頻寬的配置方面,G7e也予以大幅強化。例如,G6e網路頻寬最大可達到400 Gbps,G7e則是1,600 Gbps,一舉提升4倍,用戶可將這臺執行個體用於小型的多節點工作負載執行。同時,採用多GPU組態的G7e執行個體,也透過AWS EFA網路卡支援Nvidia GPUDirect RDMA(Remote Direct Memory Access)以提供遠端記憶體直接存取,能針對多節點工作負載之間的遠端GPU互相溝通,減少延遲。

AWS表示,G7e執行個體也額外支援Nvidia GPUDirectStorage,使GPU能直連AWS雲端檔案存取服務Amazon FSx for Lustre,如此一來,能將資料吞吐量提升至1.2 Tbps,用戶可更快載入AI模型。

產品資訊

AWS Amazon EC2 G7e

●原廠:AWS

●建議售價:美西地區(俄亥俄),g7e.2xlarge隨需每小時3.36312美元

●處理器:英特爾第五代Xeon Scalable

●提供服務規模選擇與組態:g7e.48xlarge,191顆虛擬處理器、2,048 GiB記憶體、8張Nvidia RTX Pro 6000 Blackwell Server Edition、網路頻寬為1600 Gbps,網路儲存:使用AWS區塊儲存服務EBS,存取頻寬為100 Gbps

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-01-27

2026-01-27

2026-01-27

2026-01-26

2026-01-28

2026-01-28