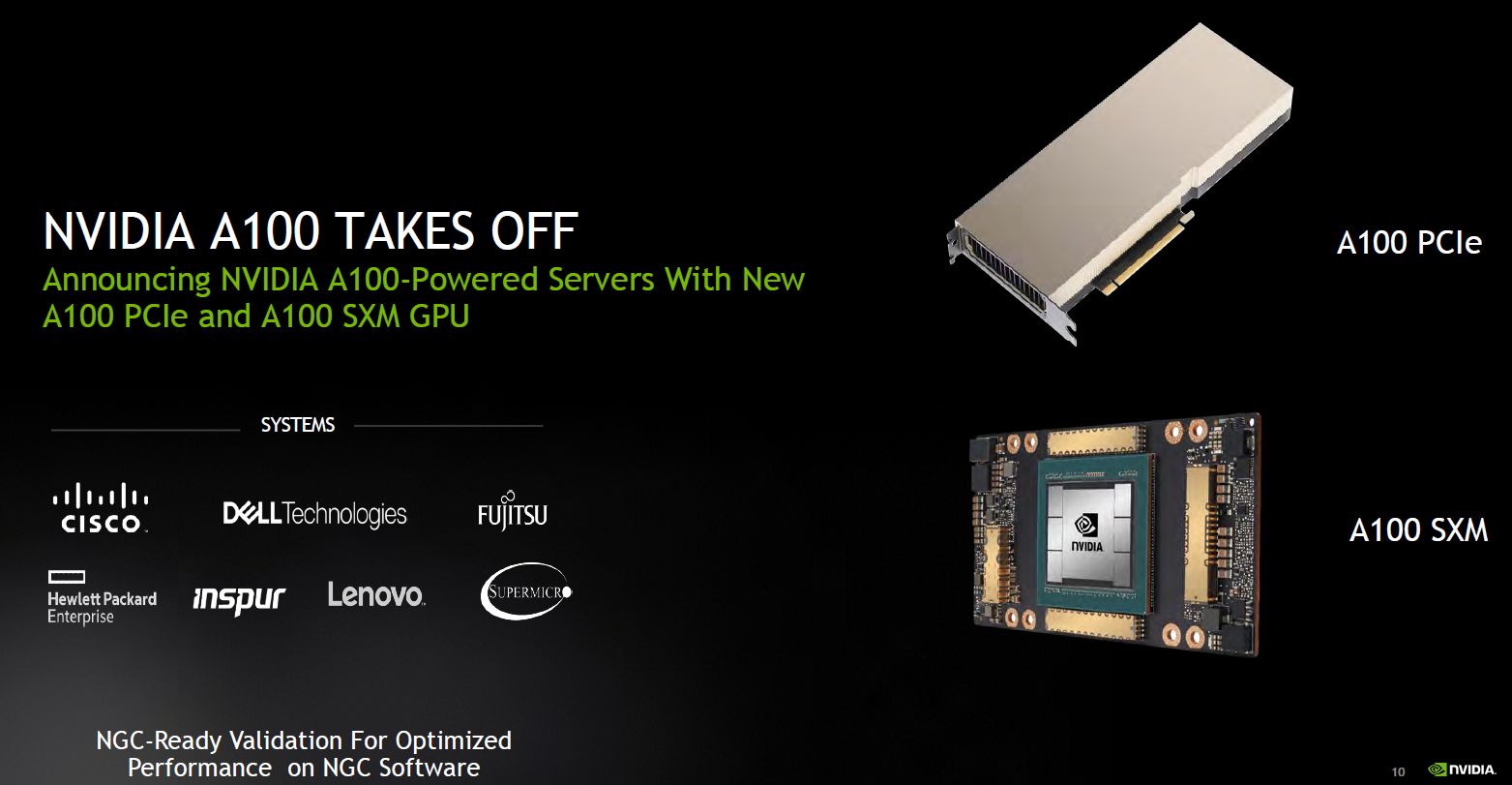

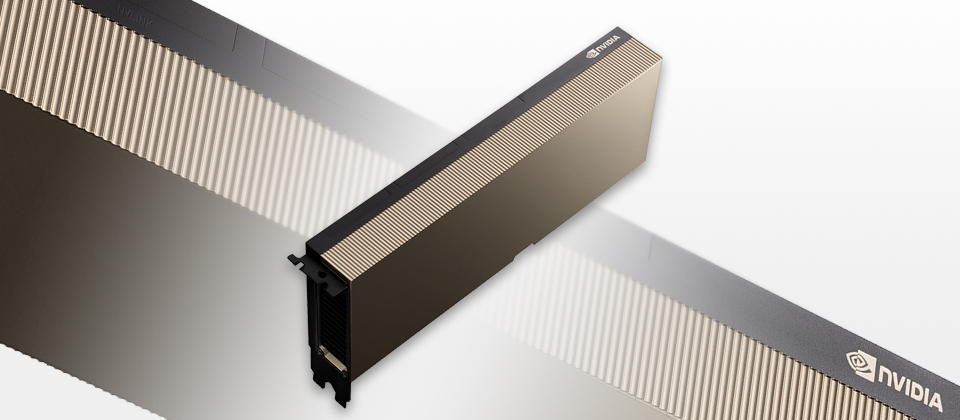

今年5月,Nvidia推出新一代資料中心等級GPU加速卡A100,採用SXM的封裝方式,到了相隔一個月後的歐洲國際超級電腦大會(ISC),他們發表了PCIe介面卡形式的A100。

相較於過往,從2016年的P100、2017年的V100,到今年登場的A100,該公司都遵循這樣的產品發布頻率,而這也對應到GPU架構的世代交替,例如P100開啟了Pascal架構的來臨,V100是Volta架構,而A100則是Ampere架構。

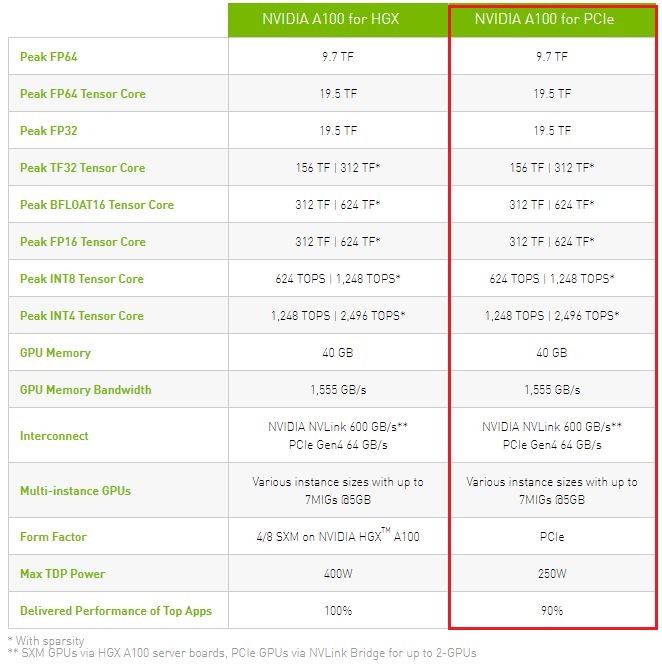

不過,就P100和V100而言,在同一世代當中的Nvidia資料中心等級GPU,SXM版本的運算效能通常優於PCIe介面卡版本(唯一的例外是2019年11月推出的V100S PCle),而最大的熱設計功耗(TDP)也分別是300瓦和250瓦。到了A100,無論是SXM或PCIe介面卡,在各種運算效能和GPU互連頻寬的規格都一樣,差別僅在於熱設計功耗(400瓦 vs. 250瓦),以及針對熱門應用程式提供的效能(100% vs. 90%)。

顯然A100大幅縮短了PCIe介面卡版本與SXM版本的效能差距,而且,可安裝的既有伺服器機型數量較多,又有耗電量較低的優勢,有機會大幅擴展A100的市占。

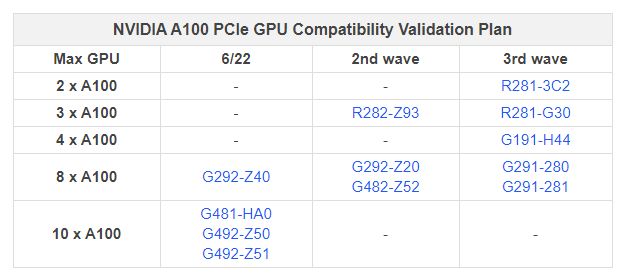

而在A100 PCIe版本於6月底推出之際,許多伺服器廠商也紛紛響應,公布他們支援A100 PCIe版本的伺服器機型。例如:華碩發表2U尺寸的GPU伺服器ESC4000A-E10,可搭配4張A100 PCIe;

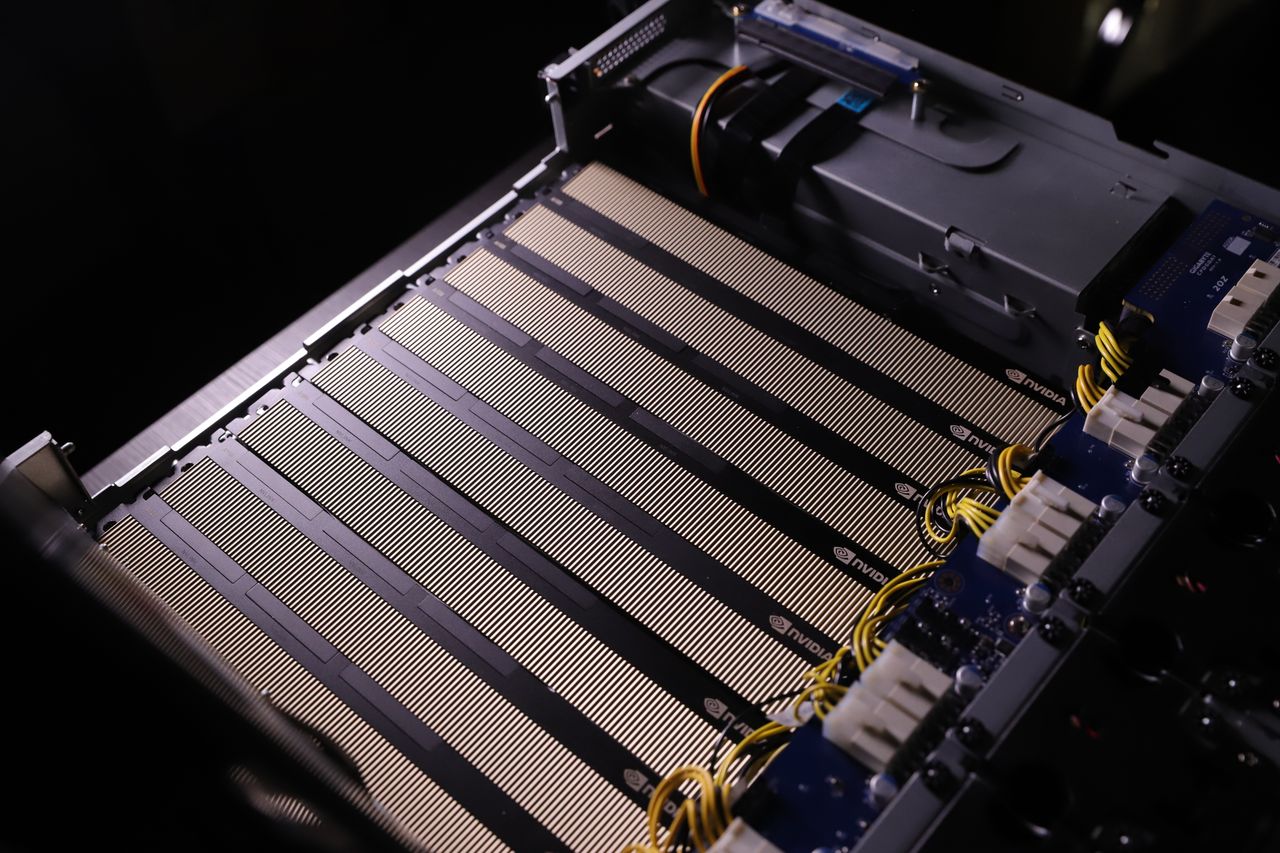

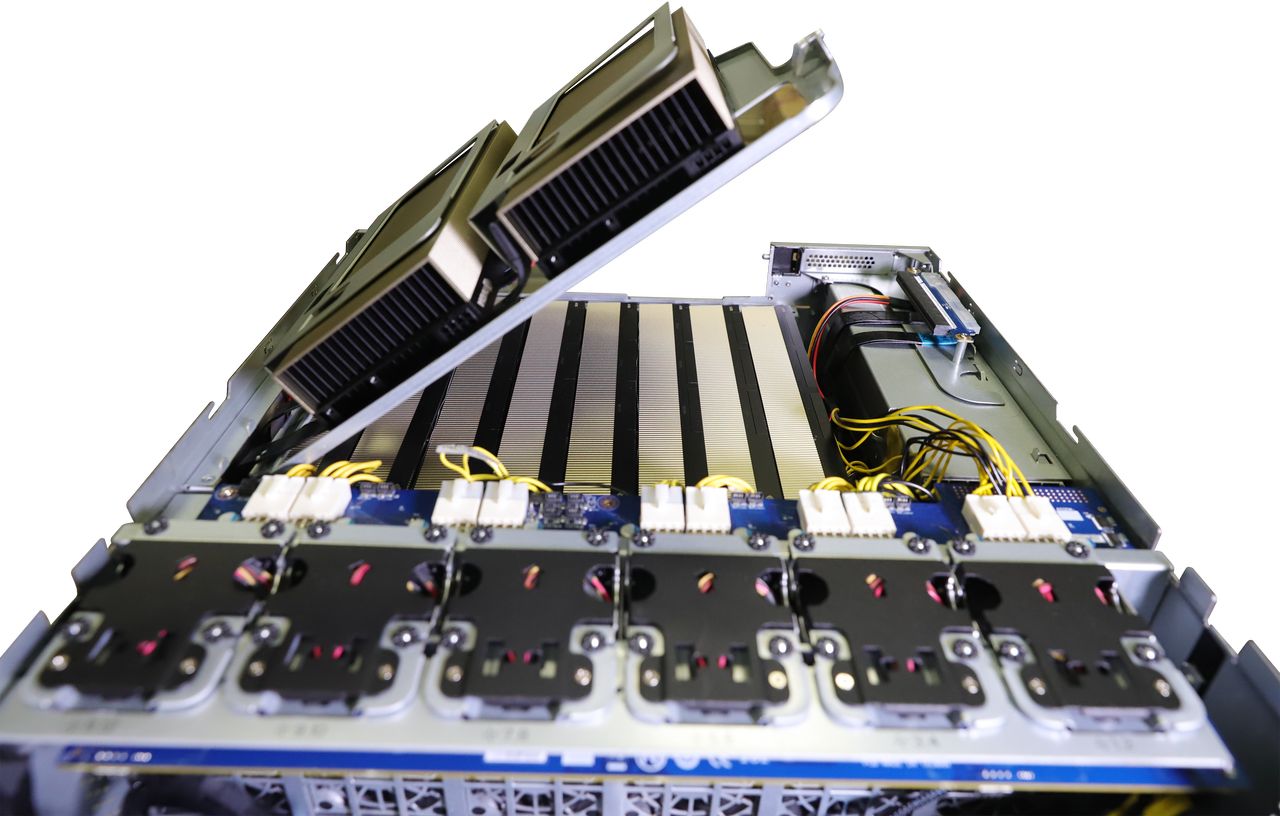

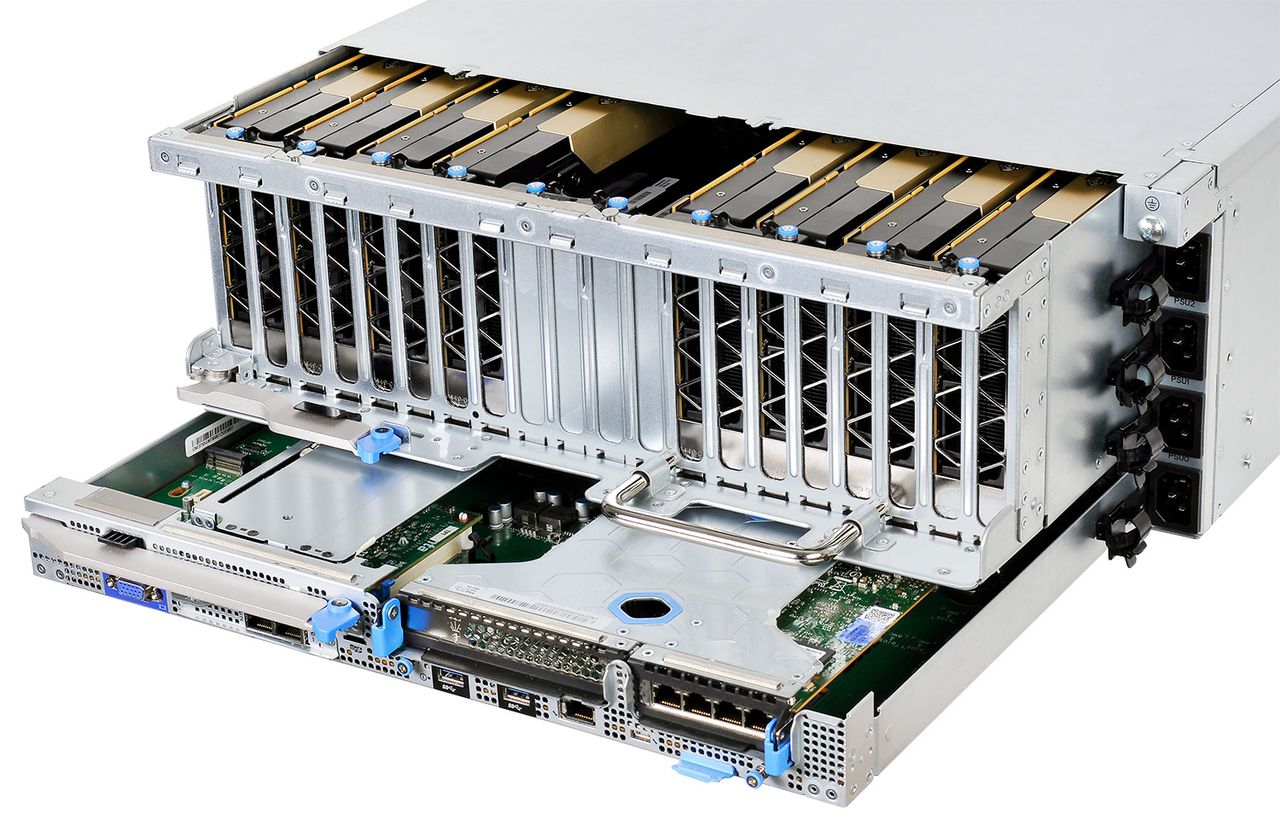

技嘉現有的4U尺寸GPU伺服器G481-HA0、G492-Z50、G492-Z51,可搭配10張A100 PCIe,另一款G292-Z40可搭配8張A100 PCIe。

廣達/雲達推出4U尺寸的D52G-4U,可搭配8張A100 PCIe,以及2U尺寸的D52BV-2U與D43KQ-2U,可搭配2張A100 PCIe。

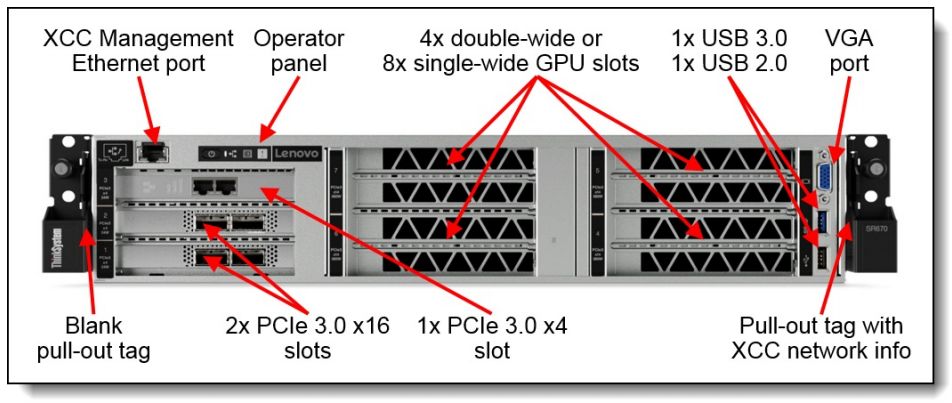

而預告將支援A100 PCIe的伺服器,則有下列廠牌的產品。例如:思科會在UCS系列伺服器,以及HypeFlex超融合基礎架構整合設備來支援;Dell EMC的部分,會先針對PowerEdge系列 C4140(1U機箱,可容納4張A100 PCIe)、R7525(2U機箱,可容納3張A100 PCIe),以及DSS 8440(4U機箱,可容納10張A100 PCIe);HPE則是會在ProLiant DL380(2U機箱,可容納2張A100 PCIe),以及Apollo 6500系列(4U機箱,可容納8張A100 PCIe)提供支援;聯想會先從ThinkSystem SR670(2U機箱,可容納4張A100 PCIe)著手,至於ThinkSystem系列的其他機型,以及ThinkAgile系列,預計在秋季開始支援A100 PCIe;

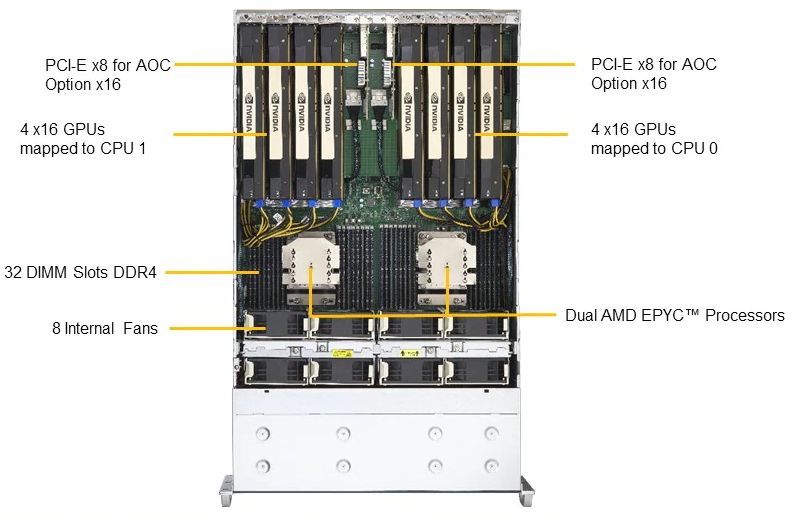

Supermicro則是會推出新機型4124GS-TNR(4U機箱,可容納8張A100 PCIe)。

產品資訊

Nvidia A100 for PCIe

●原廠:Nvidia

●建議售價:廠商未提供

●處理器製程:TSMC 7nm N7 FinFET

●I/O介面:PCIe 4.0 x16

●外形:PCIe介面卡(Dual Slot)

●GPU架構:Nvidia Ampere

●GPU核心:6912顆CUDA核心、432顆Tensor Core

●GPU記憶體:40GB HBM2

●記憶體頻寬:1555 GB/s

●運算效能:雙精度(FP64)為9.7 TFLOPS

●支援運算API:CUDA-X HPC 、CUDA、OpenACC

●GPU互連介面:第三代NVLink,600 GB/s

●耗電量:250瓦

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-02-16

2026-02-17

2026-02-16

2026-02-13

2026-02-16