在8月舉行的SIGGRAPH大會,Nvidia揭露了下一代GPU架構Turing,以及首批採用這套架構的Quadro RTX系列繪圖卡。事隔一個月後,他們在GTC日本大會宣布推出新款GPU加速卡Tesla T4,同樣也導入了Turing架構的設計,可用於資料中心、企業、邊緣運算裝置等環境的人工智慧推論處理需求。

而在11月舉行的美國超級電腦大會SC18,Nvidia表示,目前已有57款伺服器設計採用Tesla T4,涵蓋Dell EMC、HPE、IBM、聯想、Supermicro等廠商,均會推出相容該款GPU的伺服器機型。

同時,也有雲端服務廠商開始提供這款GPU的搭配選項,Google Cloud Platform將是第一家支援的業者──用戶若要使用Tesla T4,可在Google Compute Engine(GCE)當中,選擇預先設定的Deep Learning VM映像,也可以到自定機器類型的VM當中手動掛載。

相較於2016年推出的上一代產品Tesla P4,新登場的Tesla T4同樣配置了2,560顆CUDA核心,最大的差異是額外提供了320顆Tensor核心,更能充分支援多精度的計算應用。

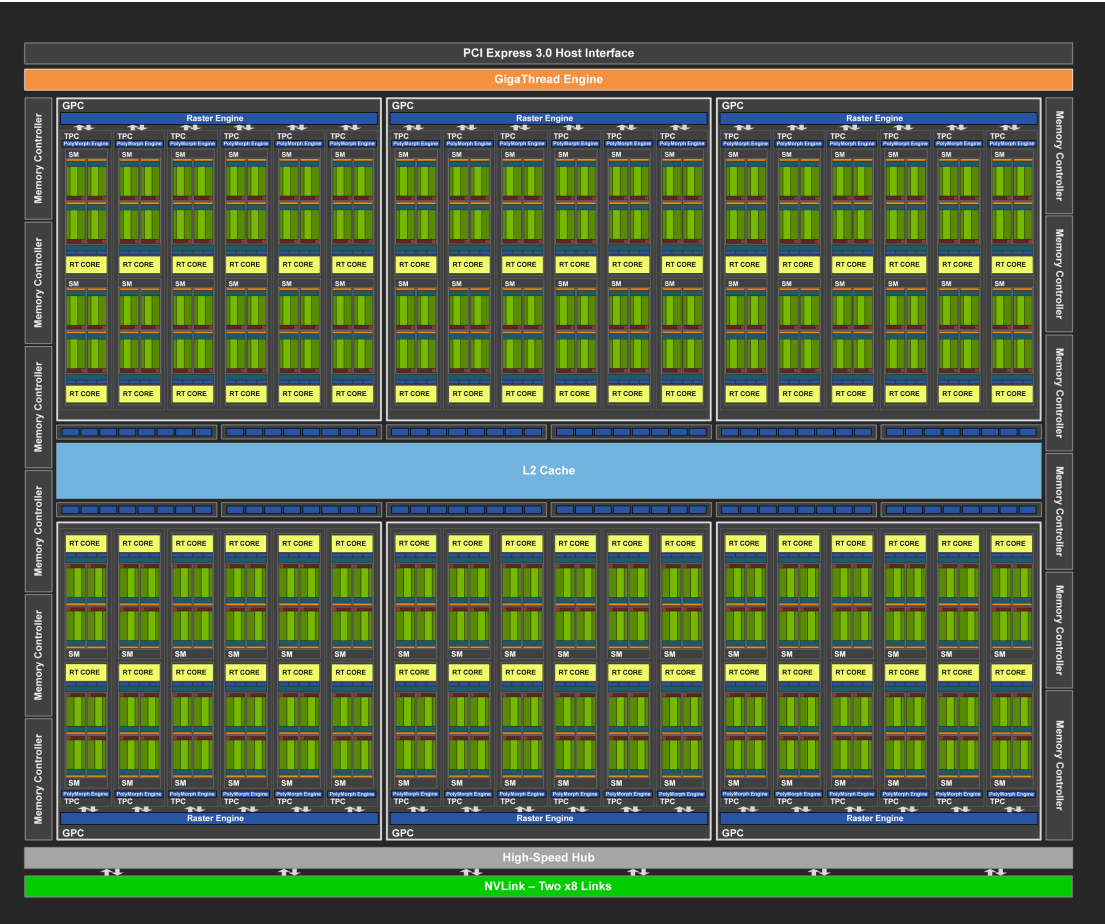

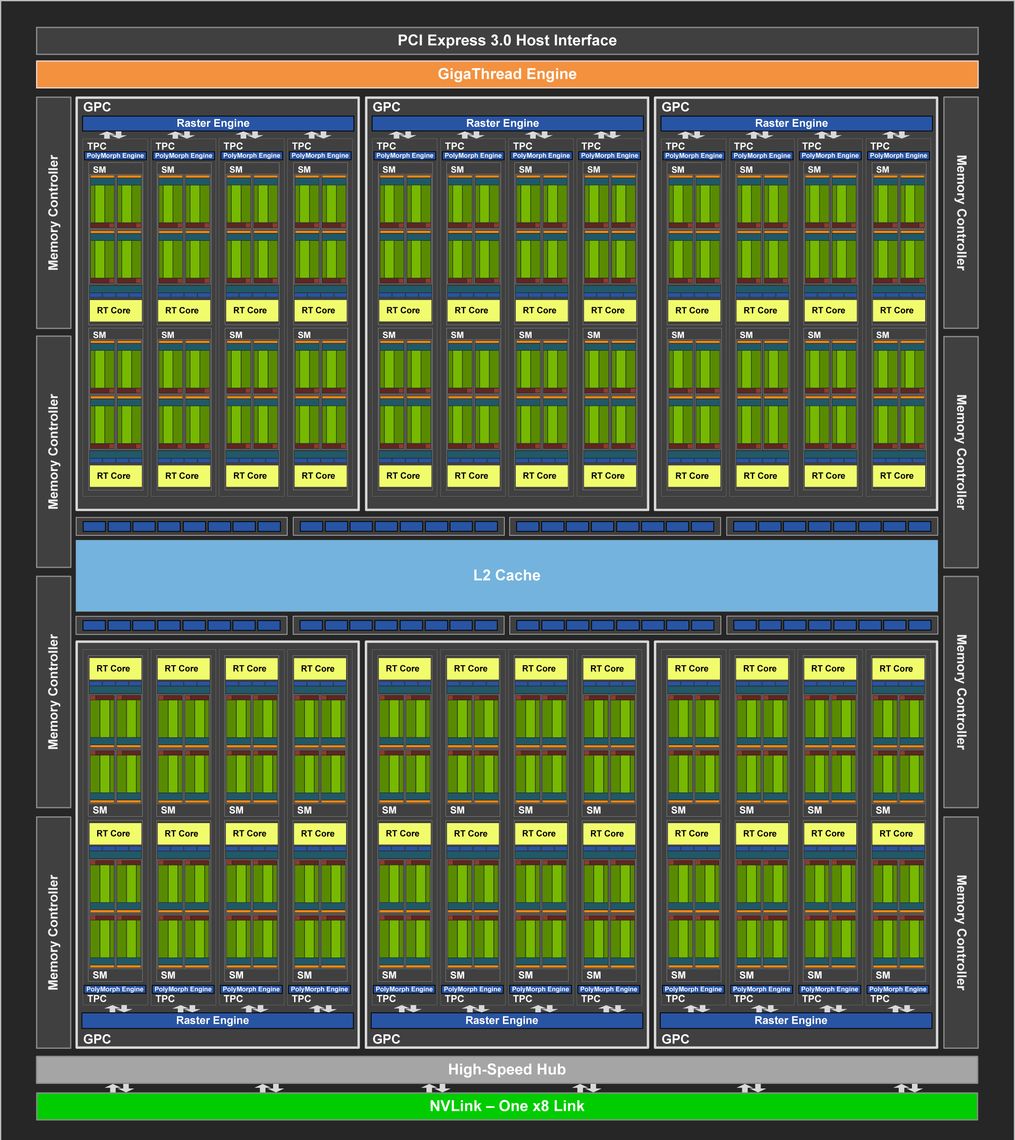

在Turing架構的Nvidia GPU當中,依照效能高低、使用模式、市場區隔,可區分為TU102、TU104、TU106等三種類型,它們的基本架構相同,而我們這次介紹的Tesla T4,與GeForce RTX 2080、Quadro RTX 5000皆為TU104(左圖),而RTX 2080 Ti、Quadro RTX 6000則為TU102(右圖)。

整體而言,TU104本身的架構,包含8個32位元的記憶體控制器(位於兩側,各4個),以及6個圖形處理叢集(GPC)、24顆Tensor核心(TPC)、48顆串流多重處理器(SM)、64顆CUDA核心、48顆RT核心。

以單一GPC來看,具有4顆Tensor核心;每顆Tensor核心裡面,有1個多形引擎(PolyMorph Engine)、2顆串流多重處理器;每顆串流多重處理器當中,則包含64顆CUDA核心與1顆RT核心。

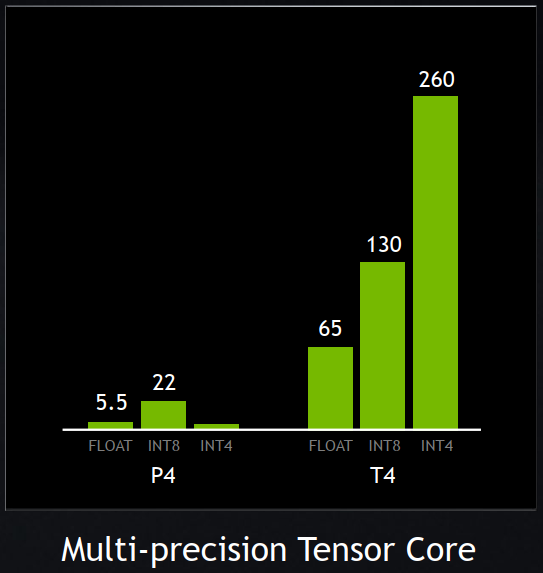

基本上,Turing架構的Tensor核心針對推論類型的工作負載,增添了INT8和INT4的整數運算精度模式,而能容忍量化誤差,同時,也支援半精度的浮點運算(FP16),因應需要更高精度的工作負載執行需求。

在記憶體存取的規格上,T4內建了16 GB的GDDR6記憶體,存取頻寬是320 GB/s以上,可支援分散式訓練,強化學習(Reinforcement Learning),以及其他機器學習工作負載。而早先推出的P4搭配的是8GB GDDR5記憶體,存取頻寬是192 GB/s,已然相形見絀。

而就整體處理能力而言,T4的單精度浮點運算效能(FP32),提升到8.1 TFLOPS(P4是5.5 TFLOPS),混合精度浮點運算效能(FP32和FP16)則是65 TFLOPS,整數運算(INT8)增長到130 TOPS(P4是22 TOPS)。

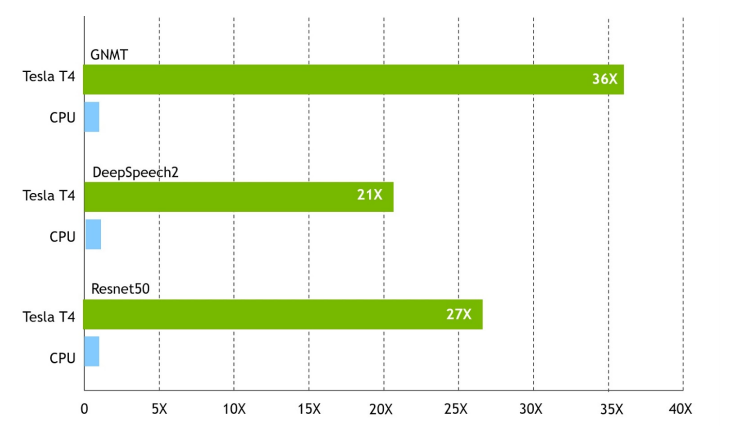

在機器學習(GNMT),以及深度學習(DeepSpeech2、Resnet50)的類神經網路推論處理中,Nvidia Tesla T4展現出強大的效能,若以純CPU架構的伺服器(Intel Xeon Gold 6140搭配OpenVino軟體)為基準,搭配Nvidia Tesla T4與TensorRT軟體之後的伺服器,最高可提供將近40倍的效能。

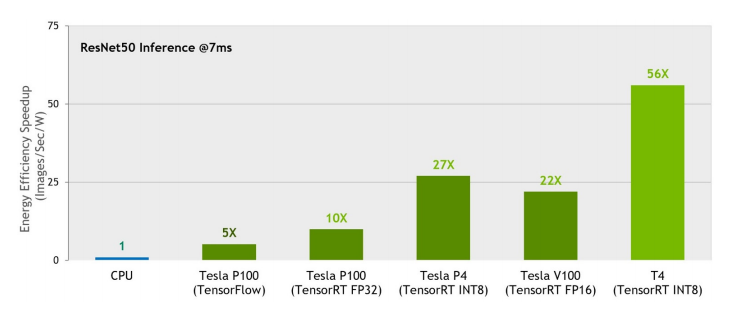

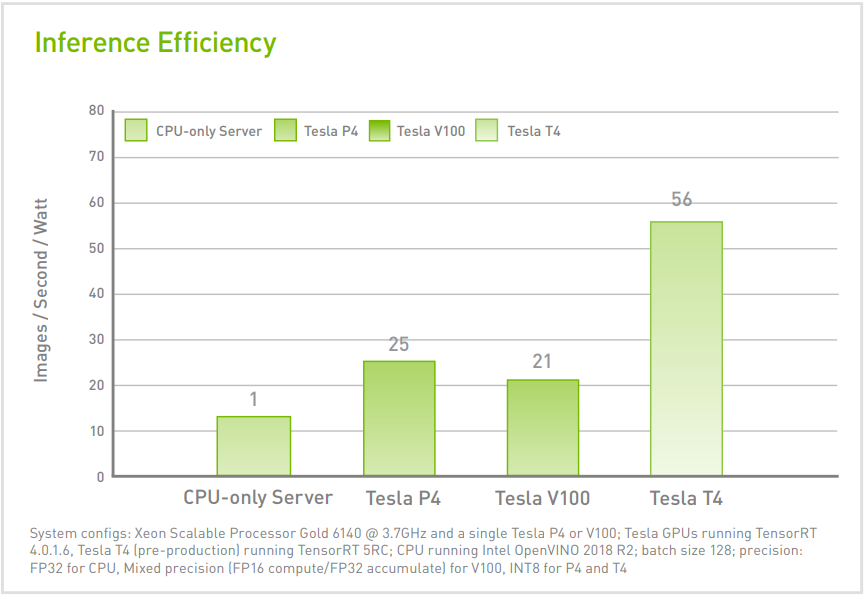

就能源使用效率來看,搭配Tesla T4的伺服器,可達到純CPU伺服器的50倍以上。若以搭配上代推論加速卡Tesla P4的伺服器為基準,搭配Tesla T4的伺服器,也能具有兩倍以上的能源使用效率。

相較於採用Pascal架構的Tesla P4,新推出的Tesla T4,因為改用Turing架構,而能支援更多影像解碼的格式,像是HEVC 4:4:4(8/10/12位元),以及VP9(10/12位元),所以能同時處理更多視訊串流,如上圖的測試結果比較,Tesla T4能夠同時解碼的視訊串流數量,多了一倍。

此外,就GPU記憶體容量與記憶體存取頻寬而言,Tesla T4規格更為優異,是16GB GDDR6、320 GB/s,而Telsa P4是8GB GDDR5、192GB/s。

在這樣的架構下,對照單靠CPU架構來執行運算的伺服器,Nvidia認為搭配Tesla T4的伺服器,能夠取代大量純CPU伺服器。根據他們的評估,因應AI推論的工作負載時,搭配兩張Tesla T4 GPU加速卡協同運算的伺服器,足以取代54臺純CPU伺服器;若是AI的機器學習與深度學習訓練,相當於9臺2路純CPU伺服器。

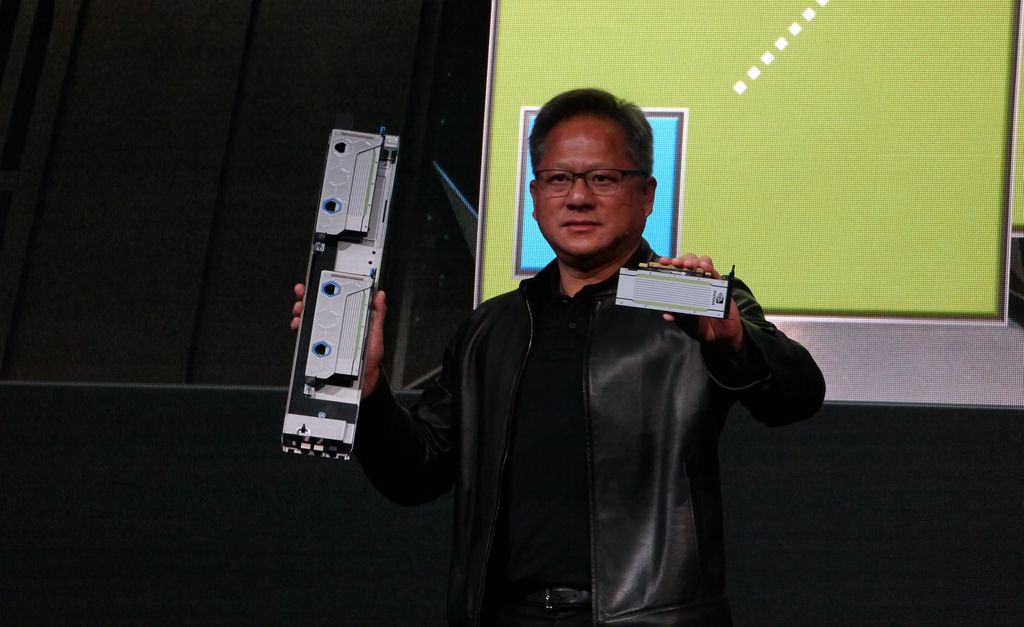

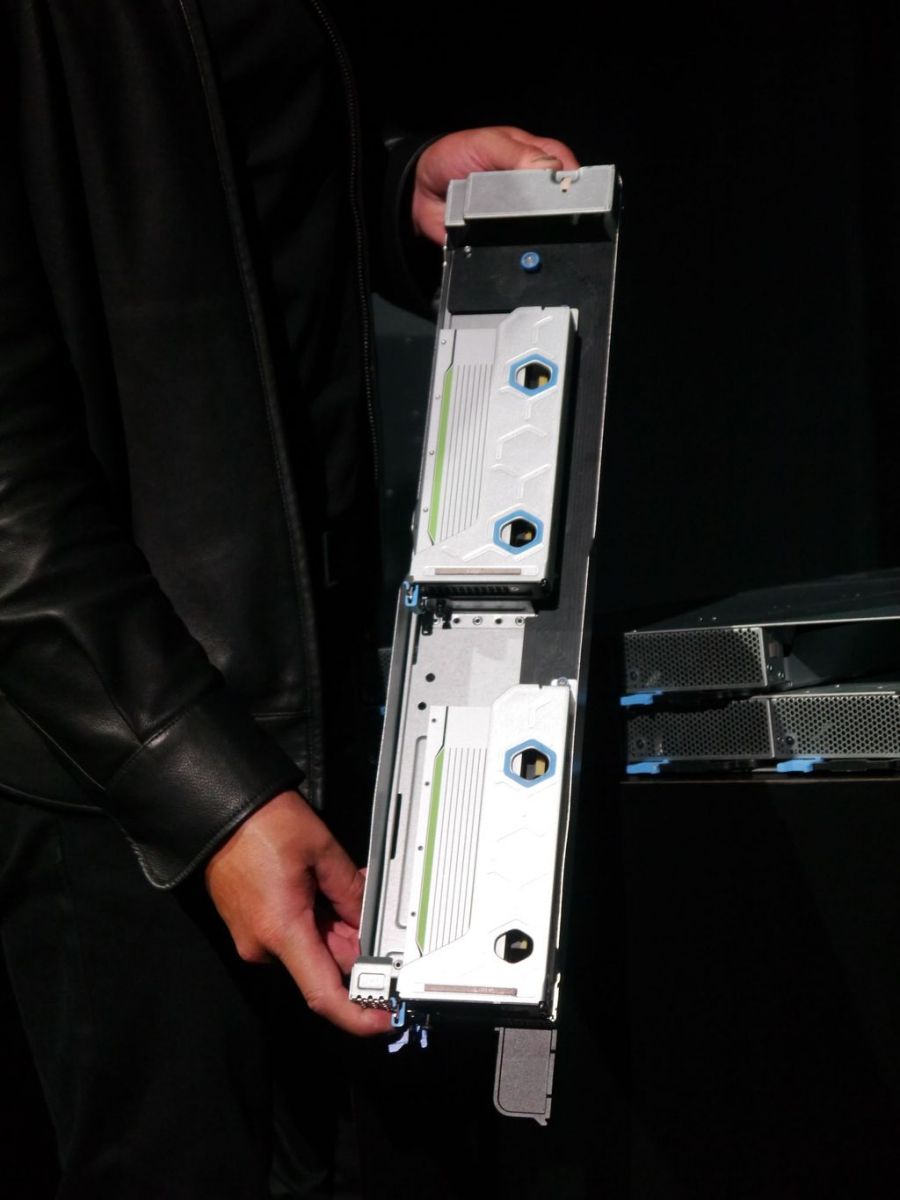

在SC18期間,Nvidia也在附近的飯店舉辦大型的新聞發布會,而該公司創辦人暨執行長黃仁勳也在這場活動中,向與會大眾展示剛推出的Tesla T4,以及能夠搭配這款AI推論加速卡的伺服器。

等到黃仁勳的演講結束之後,我們也走到主舞臺前,就近觀察搭配Tesla T4的伺服器,看得出來,這是一臺可搭配多個運算節點的伺服器,而當中的部分節點,可容納2張Tesla T4。

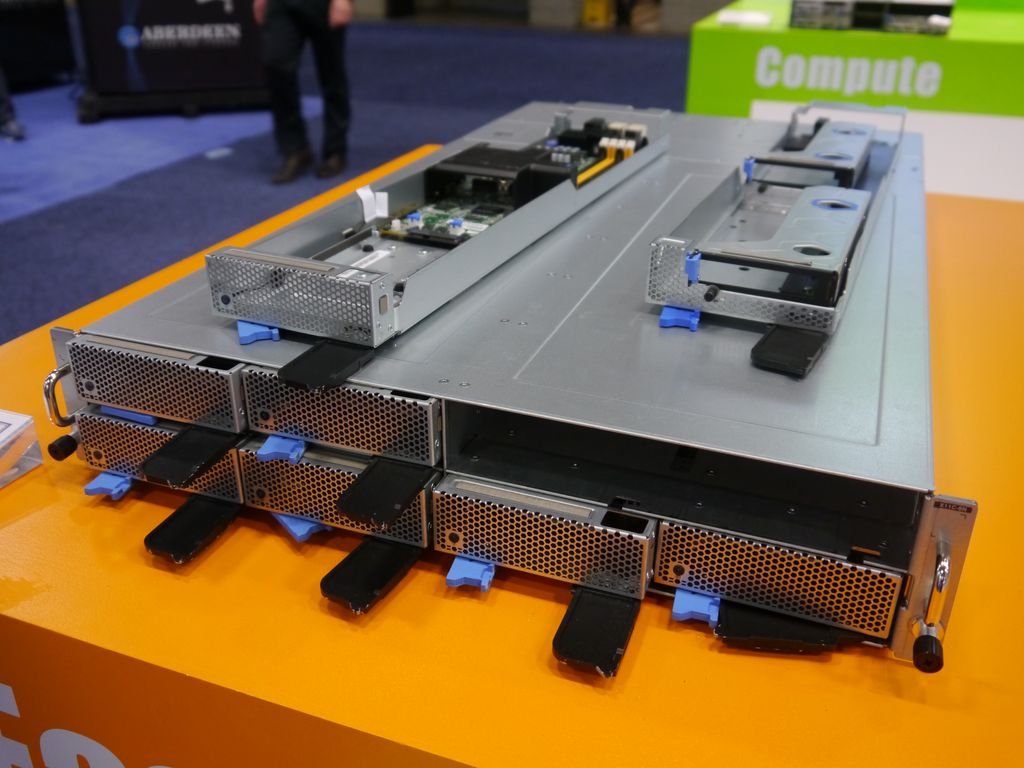

在SC18大會的廠商展示區,我們找到在Nvidia活動首度亮相的新一代GPU伺服器。該款設備是由雲達科技(Quanta Cloud Technology,QCT)所推出的機型,當中可容納的運算節點,分為CPU模組和GPU模組,兩者需相互搭配使用。

產品資訊

Nvidia Tesla T4

●原廠:Nvidia(02)6605-5700

●建議售價:廠商未提供

●處理器製程:12奈米FFN

●外型:介面卡(PCIe 3.0 x 16)

●GPU架構:Turing

●GPU核心:2560顆CUDA核心,320顆Tensor核心

●GPU記憶體:16 GB GDDR6

●記憶體頻寬:320 GB/s 以上

●運算效能:單精度為8.1 TFLOPS

●熱設計功耗:70瓦

【註:規格與價格由廠商提供,因時有異動,正確資訊請洽廠商】

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02