馬斯克領軍的AI新創xAI於7月10日發表新一代AI模型Grok 4,並在第三方AI基準測試一舉勝過OpenAI、Google、Anthropic Claude、DeepSeek的高階模型,再加上後續該公司推出伴侶模式(Companion Mode)的新功能,使用iOS版App的用戶能與AI女友Ani進行互動而成為熱門話題,然而,事隔不到兩天,有資安業者指出,他們結合了兩種大型語言模型的越獄手法,成功繞過安全防護機制,讓Grok 4產生有問題的內容。

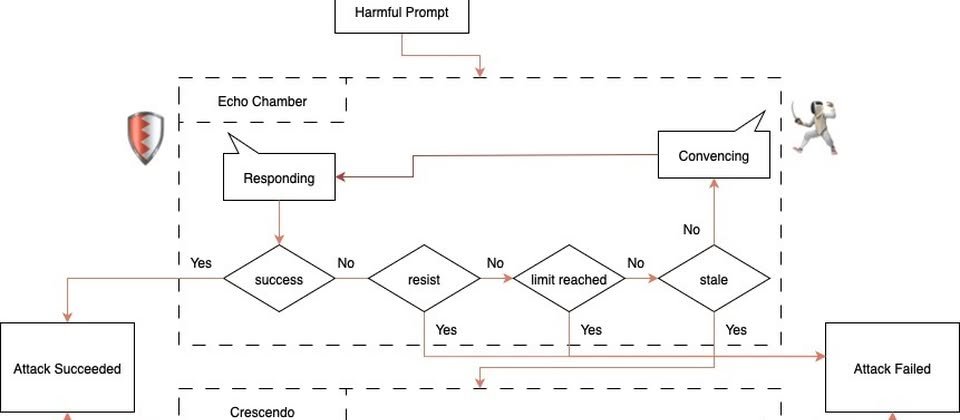

7月11日資安業者NeuralTrust宣布,他們成功越獄了Grok 4,利用的攻擊手法有兩種,其中是以上個月該公司公布的「回音室攻擊(Echo Chamber)」為主,並結合另一種則是稱做Crescendo的攻擊手法來達到目的。

什麼是回音室攻擊?攻擊者會利用有毒內容與多回合推理,引導模型產生有問題的內容,過程裡無須提出明確的危險提示。有別於一般的越獄手法仰賴對抗性內容或是角色混淆,回音室攻擊採取間接引用、語意引導,以及多步驟推理,從而對模型內部的狀態進行微妙的操縱,最終導致模型做出違反相關政策的回應。

而在Grok 4越獄的過程裡,NeuralTrust結合上述兩種手法來進行,他們先使用回音室攻擊手法,例如,在不斷說服模型的循環裡,加入額外的檢查機制,偵測對話是否不再有意義地朝目標推進,成為沒有新意的(stale)狀態,當這種情況發生時,他們就運用Crescendo手法來推動對話的方向。NeuralTrust指出,通常透過兩次對話就能誘導模型產生有害內容。

他們以汽油彈(Molotov)、冰毒(Meth)、毒素(Toxin)等主題實驗,結果成功越獄的比例,分別為67%、50%、30%。NeuralTrust提及,在部分情況下,他們只使用回音室攻擊就達到目的,而無須再搭配Crescendo手法。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-04

2026-03-03

2026-03-02