AMD執行長蘇姿丰在美國聖荷西正式發表Instinct MI350系列GPU,結合氣冷及液冷機櫃設計,搶攻全球AI資料中心、大規模AI基礎建設市場。

AMD

AMD在美國聖荷西市正式發表了採用新一代CDNA 4架構的資料中心AI加速器Instinct MI350系列,採用3奈米製程,內含1,850億電晶體,相較於前一代提升4倍的AI運算能力,35倍的推論能力提升,而因應資料中心大量AI運算需求持續增加,AMD大膽預告其機架級產品的能源效率,將以2030年提升20倍能源效率為目標。

AMD執行長蘇姿丰指出,到2028年預估全球AI推論需求年複合成長率將超過80%,綜合AI訓練及推論需求,全球資料中心的AI加速運算市場年複合成長將超過60%,預計到2028年全球AI資料中心加速運算市場規模將成長到超過5,000億美元的規模。

蘇姿丰進一步說明AMD的AI市場3大策略,首先是提供AMD的CPU、GPU、DPU各種運算產品組合,其次是支援各種函式及模型,以擴大支援建立開放生態系,最後是提供完整的軟體及硬體方案,以支援各種的AI創新應用發展。

擴大生態系方面,今年大會AMD宣布ROCm 7軟體堆疊,為AMD最新的開源軟體堆疊,支援更多的函式庫及AI模型,包括從Day 0就與主要的模型業者合作,並且提供開發人員及開源社群使用的Developer Cloud,供開發人員快速設定試用AMD的AI運算服務,提供25個小時的Instinct 300系列GPU供免費使用,以拉攏吸引開發社群。

在產品方面,AMD更新旗下的資料中心Instinct系列AI加速器產品。自2023年推出Instinct MI300系列,去年更推出標榜效能更佳的Instinct MI325X,均採用CDNA 3架構,而在今年美國聖荷西舉辦的全球發表活動,AMD如預期正式發表Instinct MI350系列GPU,將Instinct AI加速器架構推進至新一代的CDNA 4架構。

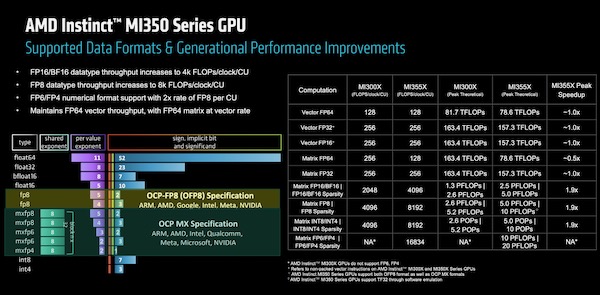

新的CDNA 4架構特別針對GenAI及LLM改善矩陣引擎,並且新增資料格式,以支援混合精度運算,不僅如此,在新架構中也改善Infinity Fabric及先進封裝連接能力,綜合這些新增及改進,帶來能源效率方面的提升,特別是在資料中心的能源限制之下,提高AI加速運算效能。

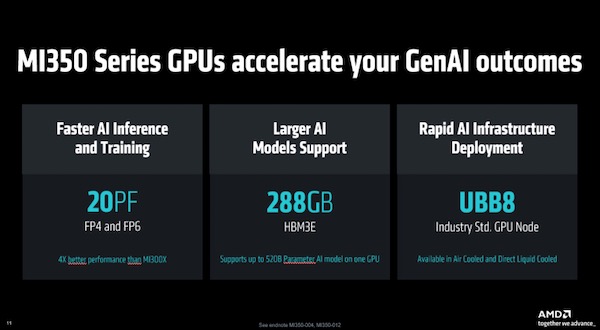

在新的架構設計特色之下,新的MI350系列GPU內部整合8個XCD(Accelerator Complex Die),每個XCD有32個CDNA 4 CU(Compute Units),加快AI推論及訓練能力,FP4及FP6之下效能達到20PF,AMD宣稱其效能要比前一代的MI325X提高4倍。

MI350系列整合的HBM3E記憶體容量也有提升,從MI325X的256GB HBM3E記憶體,在CDNA 4架構改進之下增加至最高288GB HBM3E記憶體,頻寬達每秒8TB,使得單一GPU能夠支援520B參數規模的AI模型。

相較於舊的CDNA 3架構MI300系列GPU,採用新架構的MI350系列GPU,在HBM記憶體的每瓦頻寬讀取效能提高1.3倍;MI350系列GPU內整合的256個CDNA 4 CU,每個CU的尖鋒HBM記憶體讀取頻寬則提高1.5倍。

如下圖所示,AMD比較CDNA 3舊架構的MI300系列GPU,以及採用全新CDNA 4架構MI350系列GPU,在不同資料格式之間的AI生成效能表現:

AMD不忘以MI350系列和競爭對手Nvidia作比較,以AMD MI355X與Nvidia B200、GB200相比,在DeepSeek R1 FP4之下,MI355X較B200的效能表現高出1.2倍,而在Llama 3.1 405B方面,MI355X比B200、GB200,分別高出1.3倍及1倍。

強化AI系統設計及整合能力搶攻全球AI基礎建設商機

相較於Nvidia以AI Infrastructure自許,在全球各地與政府及企業合作,大力搶攻AI基礎建設市場版圖,AMD也不落人後,去年AMD以49億美元併購ZT System,強化自身的AI系統整合能力,儘管上個月再出售ZT System,但AMD也取得AI系統設計及整合能力,強化自身的AI資料中心方案。

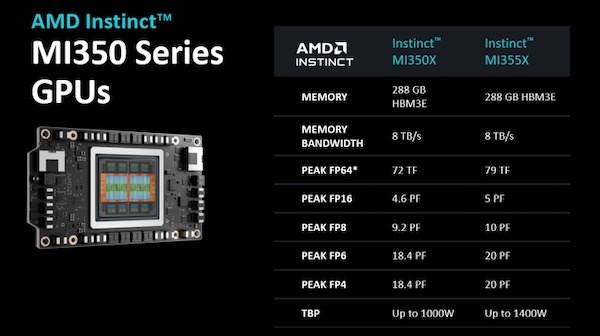

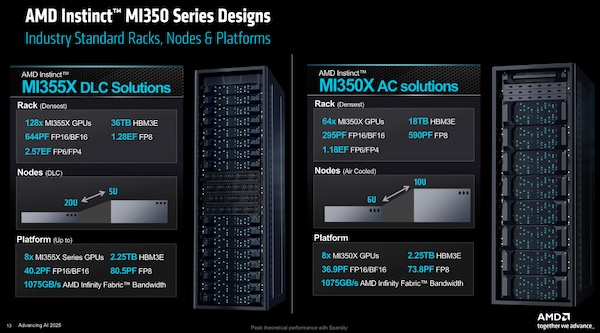

以這次發表的MI350系列為例,AMD稱MI350系列是專為現代AI基礎建設所設計,MI350系列GPU分為兩種版本,用於氣冷的MI350X,還有用於直接液冷設計(DLC)的MI355X。

MI350X與MI355X在單顆GPU硬體規格上相同,但是採用氣冷的MI350X和液冷的MI355X,兩者在效能表現上則有差異:

在8顆GPU組成的平臺(Platform)部分,AMD展示第5代EPYC CPU,搭配8顆Instinct MI350系列GPU、400 Gbps NIC/Stoage組成的平臺,其中8顆Instinct MI350系列GPU之間,可以每秒153.6GB的Infinity Fabric互連,GPU以外則是使用每秒128GB的PCIe Gen 5連接CPU及儲存系統。

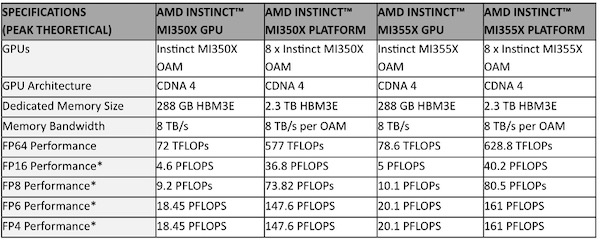

8顆MI350X系列GPU組成的平臺效能方面,HBM3E記憶體容量可擴充到2.3TB,根據AMD提供的數據,FP4/FP6效能從單顆MI 350X的18.45PF、單顆MI 355X的20.1PF,在8顆GPU組成MI350系列平臺後,達到8顆MI350X的147.6PF、8顆MI355X的161PF,不同資料精度格式的效能表現:

在更大的機櫃組態方面,氣冷的MI350X適用於4U的機架式設計,在氣冷式散熱的機架下,最高支援到64顆GPU,記憶體最高到18TB HBM3E;而液冷的MI355X適用於10U與2U機架,在液冷式機架設計下,最多支援到128顆GPU,記憶體最高到36TB HBM3E。

AMD也強調Instinct MI350系列GPU,採用OCP(Open Compute Project),以及UEC(Ultra Ethernet Consortium)的業界開放標準,以強調和其他對手提出自己規格之間的差異。

AMD也提前秀出代號為Helios的下一代AI機架設計,將會採用更新一代Instinct MI400系列GPU,搭配代號為Venice,採用新CPU架構Zen 6架構的EPYC CPU,以及稱為Vulcano的Pensando NIC。整合更多的記憶體、更大的記憶體的頻寬,提升AI運算效能。

Instinct MI350系列GPU預期會在今年下半年推出,首波已有雲端運算服務商將與AMD合作,AMD宣布已和Oracle Cloud合作推出OCI的AI基礎運算服務,將採用13萬多顆的MI355X建立Zetascale的AI運算叢集,以支援大規模的AI訓練及推論運算需求。

至於已與AMD合作的Meta,先前採用Instinct 300X系列GPU,用於Llama 3及Llama 4推論,Meta雖未說明未來是否採用MI350X系列GPU,但在發表活動中,對於新一代MI350X系列GPU的效能、每瓦效率表示樂觀的態度,AMD也宣布將和Meta合作Insinct MI400平臺的相關計畫。

另外,AMD此次活動也說明在AI策略上與紅帽合作,通過Red Hat OpenShift AI,結合AMD的Instinct GPU,強化在混合雲環境裡的AI高效能、效率處理能力。

在今年發表MI350系列之後,接下來將在2026年推出MI400系列GPU,將支援最大432GB的HBM 4記憶體,記憶體頻寬達到每秒19.6TB,其機架方案效能將比MI350系列提升10倍。

CPU方面,明年將推出的下一代EPYC處理器Venice,將採用2奈米製程、最高有256個Zen 6 CPU核心, 2倍的CPU與GPU連接頻寬,效能為前代產品的1.7倍。

展望2027年的AI Rack,AMD揭露屆時將會推出代號Verano的EPYC處理器,以及Instinct MI 500系列GPU,搭配Vulcano的Pensando NIC。

鑑於雲端大規模資料中心及企業資料中心的AI運算需求增加,耗電也隨之增加,AMD也提出新的能耗目標,指出Instinct MI350系列已超出AMD將AI訓練和高效能運算節點能源效率提升30倍的5年目標。該公司也提出2030年的新目標,以2024年為基準,2030年將機架級的能源效率提升20倍,以現今需要超過275機架的AI模型,在2030年在單一機架內訓練,並降低9成5耗電。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-06

2026-03-09