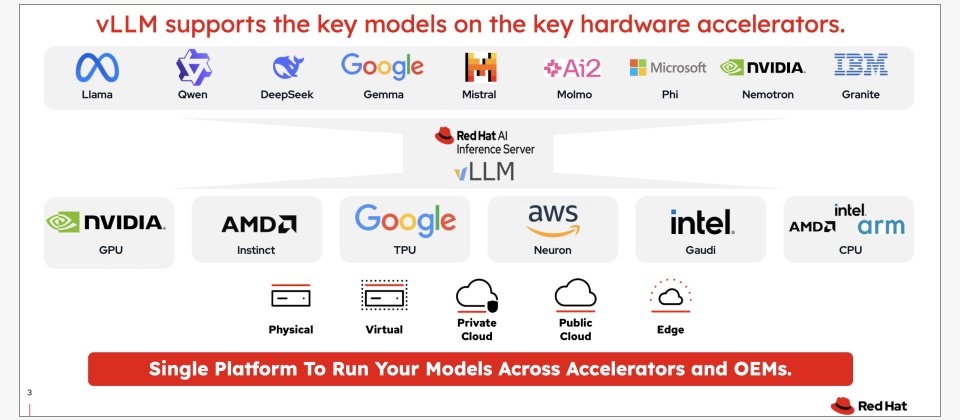

紅帽今年年會新發表了,以推論AI加速開源專案vLLM為基礎,所打造的紅帽AI推論伺服器。這套產品架構的上層是各種模型,提供了紅帽與不同模型供應商合作的驗證模型和優化版配置。(圖片來源/紅帽)

【波士頓現場直擊】

創立超過30年的老牌作業系統商紅帽,在今年年度大會中,揭露了新的GenAI發展策略。

突然爆紅的生成式AI浪潮和發展多年的IT現代化浪潮,帶給企業兩個不同的課題,紅帽執行長Matt Hicks指出,一個「當前」的世界,另一個是「未來」的世界,現在的世界是混合雲、虛擬化、現代化、安全性的混合挑戰,但未來的世界完全聚焦AI,大規模運作的AI是企業新的挑戰。

紅帽過去的產品發展策略,一向聚焦企業當前的挑戰,Matt Hicks解釋,紅帽專注於企業真正運作的環境,也就是讓任何工作負載、任何應用程式,都可以在公共雲、邊緣上執行,讓企業可以處理傳統應用程式、虛擬化工作,也能安全、大規模地執行各種眼前的業務。

過去兩年來,公雲巨頭和AI領導業者,如OpenAI、微軟、Google、Nvidia、AWS等,善用手上的龐大算力和海量資料,來發展出各式各樣的大型語言模型或可落地部署的小語言模型。

但是,對紅帽這家成立三十多年的老牌軟體商而言,他們的策略堅持不走大型語言模型研發路線,而是要想辦法善用原本的優勢,來卡位新一波的代理AI浪潮。

紅帽執行長Matt Hicks表示,紅帽產品戰略轉向任何模型、任何加速晶片、任何雲的支援。圖片來源/紅帽

為了支援企業大規模的運用GAI,紅帽在年度大會第一天開場演講中,宣布了五項重要的產品戰略。

第一項宣布是「新AI戰略方向」。Matt Hicks比較,過去的戰略是通吃任何工作負載,任何形式App,可以在任何地方執行(Any Workload,Any App,Anywhere),隨著生成式AI全球爆紅之後,帶來了全新的工作負載型態,所以,紅帽新的GAI產品戰略也轉向到瞄準「任何模型、任何加速晶片、任何雲(Any Model、Any accelerator、Any Cloud)」的支援。

這句話的意思是,紅帽未來的產品發展,要能夠支援企業可以運用任何類型的模型,在不同廠牌的加速晶片上,或是任何模式的雲端環境,從公雲,私雲到地端邊緣運算環境的生成式AI工作負載,紅帽未來都想要支援。

今年年會的第二項重要宣布是,紅帽推出新版開源作業系統RHEL(Red Hat Enterprise Linux) 10。

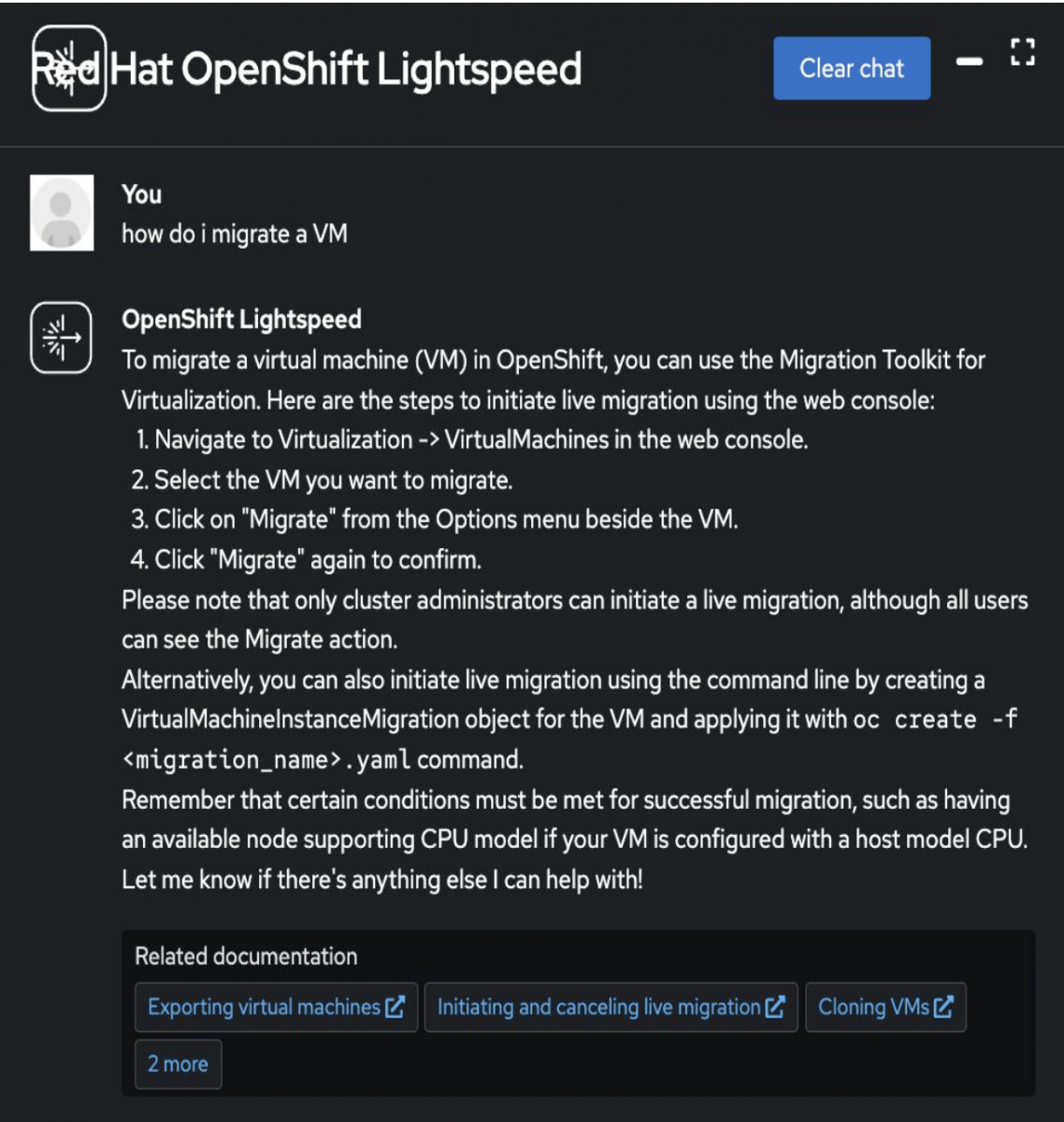

紅帽產品長Ashesh Badani更強調,這是20年來最強大的新版本,可以通吃混合雲和AI工作運算需求,其中一項重要的新功能是可以大幅簡化維運 的Image模式,讓OS更新就像手機更新一樣簡單,Image模式可以讓維運人員改用容器映像檔的部署更新方式,取代傳統的套裝元件安裝方式,將容器化應用的管理體驗帶到底層作業系統的元件管理上。另外,RHEL 10也推出了命令列的Linux通用AI助理Lightspeed服務,可以協助解決各種作業系統維運和使用的問題建議。RHEL也是第一款提供NIST批准的後量子加密演算法的商用作業系統,為日後的量子破解風險和相關合規要求,預作準備。

紅帽也將生成式AI帶進作業系統管理和基礎架構管理,推出了LightSpeed維運助手,不只在新版RHEL 10中,也能在虛擬化平臺和OpenShift中提供維運建議。未來計畫推出本地部署的版本。圖片來源/紅帽

第三項產品宣布是以vLLM為基礎,推出全新的AI推論伺服器。紅帽去年11月併購了vLLM專案主要貢獻者Neural Magic,納入Red Hat AI團隊。紅帽技術長Chris Wright強調,在AI世界,企業想要的生產上線( Production ),如何支援企業大規模的GAI使用是焦點。

這個可以用來加速LLM的開源專案vLLM,超過50萬次下載,可以將模型推論的吞吐量提高數倍。紅帽也以Neural Magic的技術為基礎,推出vLLM的AI Inference Server (紅帽AI推論伺服器),可以支援各種模型,也能部署到各種環雲端環境中。

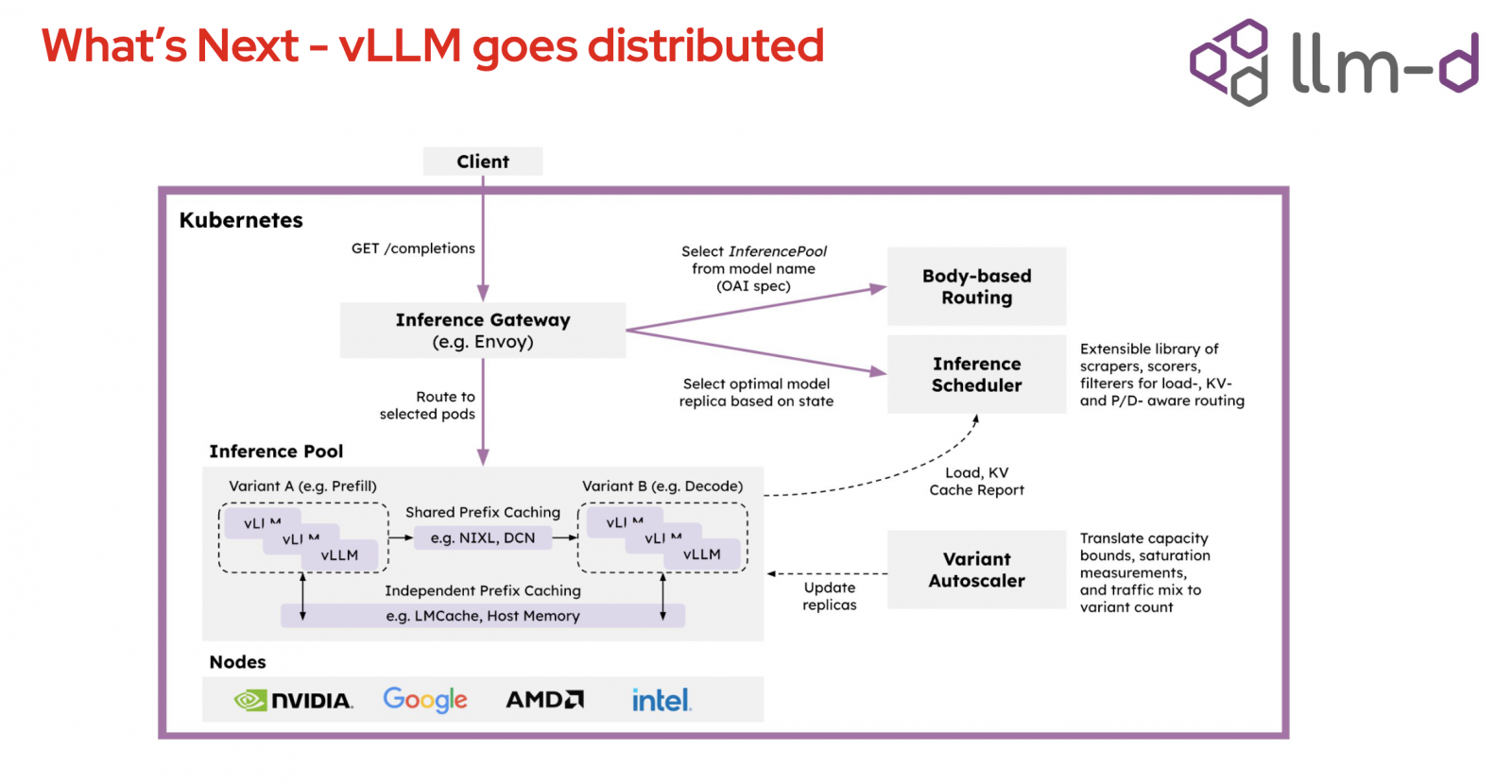

為了打破vLLM技術目前只能跑在單一伺服器上的限制,紅帽的第四項發布則是推出了一個大規模AI推論加速的開源專案llm-d。Chris Wright解釋,llm-d專案以K8s為基礎,打造出一個分散式推理架構,可以打破vLLM的單一伺服器限制,在正式環境中打造大規模的分散式推理架構,提供十倍推理吞吐量的能力。他比喻,llm-d專案對LLM推論世界的意義,就像是K8s,可以支援超大規模的架構。這項專案的創始成員包括了AMD、Cisco、CoreWeave、Google、Hugging Face、IBM Research、Intel、Lambda、Mistral AI和Nvidia。

不只推出vLLM的新產品,紅帽也發布新的開源專案llm-d,要將K8s分散式架構,帶進GenAI推論處理。紅帽也找來許多重要GenAI技術巨頭聯手開發。圖片來源/紅帽

最後一項重點是瞄準代理AI普及和大規模部署需求,紅帽旗下兩大AI產品線RedHat AI和OpenShift AI,未來將支援Meta的Llama Stack框架和 Anthropic 的 Model Context Protocol (MCP) 協定。 Llama Stack提供一整套標準化的GAI建置模組,後者則可以整合到龐大的MCP伺服器生態圈。

戰略布局1:用容器管理體驗,統一基礎架構生命周期管理

除了這五大新產品策略外,紅帽年會中特別強調今年初展開的虛擬化新產品線布局。紅帽在今年年初發表了新的虛擬化解決方案OpenShift Virtualization Engine,這是以OpenShift平臺為基礎所打造的全新虛擬化專用版本。

原本的OpenShift平臺中,整合了容器管理與虛擬化功能,可供企業在單一環境中同時管理容器化工作負載與虛擬機器的應用場景。

但是,今年初推出的OpenShift Virtualization Engine專門鎖定企業虛擬化的需求,使用企業級驗證的KVM(Kernel-based Virtual Machine)技術為基礎,移除了與虛擬機器無關的功能,像是去除容器管理功能,提供了一個輕量級的選擇,專注於虛擬機器的部署、管理和擴展調度。

OpenShift Virtualization Engine不僅可以在本地資料中心環境中執行,也能部署到雲端裸機執行實例上,來提供混合雲架構的部署彈性。這款產品也內建一套虛擬化平臺搬遷專用工具 Migration Toolkit for Virtualization,來解決虛擬機器搬遷痛點,盡量縮短停機時間。此外,這個引擎還能與Ansible Automation Platform整合,來提供虛擬機器的自動化遷移與管理。

長期發展上,紅帽希望OpenShift Virtualization Engine能做到跨叢集即時轉移虛擬機器(Live migration)(目前技術預覽版),提供更多轉移助手工具。未來也希望提供支援多叢集架構的可觀察性能力但大規模虛擬機器的管理能力。針對資安控管,未來也計畫讓多叢集的虛擬機器可以提供更精細的角色權限控管 (目前技術預覽版) ,也將持續強化多叢集維運生命周期的管理,像是虛擬機器和命名空間規模適當大小調整功能準備進入技術預覽版。

這套虛擬化引擎也將內建到新版OpenShift 4.19中(目前技術預覽版),提供預先配置設定,和代理型安裝程式,提供引導式的安裝流程,讓維運人員不用手動撰寫YAML或CLI指令。

為何紅帽今年反而特別聚焦企業虛擬化需求?紅帽的企業顧客區分為四大類,政府公布門,電信,金融,製造服務和零售。其中金融業是最有戰略意義的指標產業,因為金融業者往往是新技術的早期採用者,比其他產業更快嘗試雲原生技術和容器技術。

但是,在過去2年,企業虛擬化部署的成本有很大的變化,原本可購買永久授權的vSphere,現在轉為訂閱制,也讓企業虛擬化技術的成本大增,不少企業不只是尋求原有虛擬化產品的替代技術,也更積極轉換到容器和雲原生技術等現代化的技術架構。

紅帽也看上這個機會,大力發展虛擬化產品線,一方面接手更多傳統應用軟體的工作負載需求,另一方面,也要搶攻不同類型產業越來越多的新興IT現代化需求。先滿足這一類傳統工作負載需求的企業,等到這些企業日後想要轉型或升級到雲原生技術,可以直接銜接到紅帽的OpenShift平臺上,為日後的獲客先打基礎。

推出獨立虛擬化平臺產品,補齊資料中心管理軟體層

在軟體架構底層作業系統,和雲原生混合雲管理軟體之間,紅帽這個的虛擬化引擎產品,補齊了中間的資料中心軟體平臺層,可以用來強化網路、儲存、資料保護、資安強化、端點到雲端等虛擬化工作負載的管理,也能銜接到紅帽OpenShift平臺的混合雲管理架構,支援四大主要公雲的環境,包括AWS,Google Cloud、Azure和Oracle Cloud。紅帽還特別強調,連AWS在臺灣的新雲端區域中心也將可以支援。

甚至不只x86架構環境,OpenShift Virtualization未來還能在大型主機系統IBM Z和IBM LinuxONE上運作(目前是技術預覽版)。

不只是大型主機,紅帽也要將這款產品延伸到邊緣設備的支援,已經釋出了支援ARM架構64位元處理器(AARCH64)等低功耗環境的開發者預覽版本。紅帽希望未來可以做到,用單一平臺來也能管理到大型主機環境,甚至是邊緣設備上的虛擬機器,甚至紅帽更大的企圖是希望未來能做到跨這些不同處理器架構的環境中,提供虛擬機器的即時遷移能力。

以OpenShift簡化而成的OpenShift Virtualization,同樣也延續了原本OpenShift平臺的同一套容器化管理做法和體驗,可以來管理虛擬機器。

統一基礎架構生命周期管理體驗的最後一哩

紅帽想要統一基礎架構生命周期管理體驗的策略,只剩下最後一哩路,也就是如何將容器化管理體驗,帶到作業系統層的維運管理。這正是紅帽RHEL 10新功能Image模式所要解決的最後一哩管理課題,將容器的映像檔管理模式,帶到作業系統層。

Image模式可以用容器管理體驗,包括了用容器配置檔,將容器映像檔,搭配容器註冊服務,將作業系統部署到各種執行環境,從裸機、私雲、公雲,甚至是邊緣裝置的部署管理都可以統一。

傳統的作業系統元件部署方式採套件模式(Package mode),透過Image Builder建立映像檔(虛擬化映像檔),修補更新時則透過dnf搭配rpm儲存庫(repository)來發布更新,RHEL新推出的映像檔模式(Image Mode),則改用容器工具來建立映像檔(容器化映像檔),改用bootc容器部署工具和容器註冊服務(registry)來發布更新,新的映像檔模式也可以使用原本套件模式所運用的管理工具,如Satellite和Ansible來建立自動化管理流程。

未來,紅帽希望映像檔模式可以支援映像檔封裝機制,提供更嚴謹的映像檔完整性和開機流程,也能支援到最快只要10秒的軟開機能力,來縮短當機重開的時間。

從作業系統,虛擬化平臺到混合雲管理平臺,全都用同一套容器管理體驗,可以在任何公雲上,提供虛擬機器和容器的統一管理體驗,企業也可以在任意平臺上執行容器化應用。這是正是紅帽今年開始全力發展的第一項戰略布局,也正是紅帽執行長新戰略「Any Model、Any accelerator、Any Cloud」的第三項Any Cloud布局,有了這個基礎,就可以在上面發展前面兩項因應GenAI浪潮的新目標,紅帽選擇的產品策略切入點就是,瞄準企業未來大規模GenAI推論部署需求。

戰略布局2:K8s分散架構帶進GAI推論,瞄準大規模推論需求

擁有深厚作業系統背景的紅帽,對硬體支援非常熟悉,也和雲端供應商、硬體晶片供應商有很好的合作夥伴關係。紅帽技術長Chris Wright用一句話點出紅帽的新戰略定位:「將底層硬體和熱門模型的軟體架構串連起來,是紅帽在整個GAI世界中的位置。」

紅帽在年會中發表了,以推論AI加速開源專案vLLM為基礎,所打造的紅帽AI推論伺服器。這套產品架構的上層是各種模型,提供了紅帽與不同模型供應商合作的驗證模型和優化版配置。

紅帽AI推論伺服器,不只是一款社群可用版本,而是可以用於關鍵任務的運作環境。這款伺服器也可以說是一套作業系統,核心是Linux,可以用來建構和執行不同的模型。紅帽AI推論伺服器是紅帽AI產品組合的成員之一,可以部署成一臺獨立的伺服器,支援不同硬體,也能部署到OpenShift上,也可以部署到第三方的基礎設施,靈活度很高。

紅帽不只推出vLLM的新產品,也發布了一個新的開源專案llm-d,這個專案利用了紅帽熟悉的K8s分散式架構,來執行各種分散式GenAI推論工作。紅帽找來許多重要GenAI技術巨頭,像是Google、Nvidia等,聯手發展這個用於提高大規模GenAI推論用的專案。

vLLM可以不同的加速晶片上執行,不只是Nvidia、AMD最新晶片,也能支援Google的TPU晶片。

根據紅帽評估,同樣的GenAI推論任務,在同樣的加速晶片上,若使用vLLM技術,可以比原本做法提高2到4倍的Token吞吐量,等於在GenAI推論生成Token的能力,有可能提高到四倍。

而在新的llm-d專案中,可以進一步提高推論的Token生成能力。Chris Wright解釋,利用K8s的調度能力,結合企業現代化IT的能力和GenAI推論能力,就像K8s將分散式架構帶進了Linux伺服器,llm-d專案也同樣將分散式架構帶進了LLM伺服器,提供了一種分散式推理的能力。「單一推理請求,可以由整個從集中多個加速晶片來共同生成。」Chris Wright強調:「這是一種可以過推理吞吐量提高超過10倍的新架構。」

既有vLLM開源專案只能在單一伺服器上執行,但llm-d可以將推論請求分散到多個 vLLM引擎上,甚至分配到沒有充分利用的加速晶片上,也能將推論快速分散到多個儲存層,「不只可以讓AI應用跑得更快,還能降低整體成本。」這正是紅帽瞄準生成式AI浪潮的新戰略布局,瞄準企業大規模AI推論需求。

「2025將是AI推理的關鍵發展年,企業的AI產品真正開始進入大規模發展的關鍵時刻。」Chris Wright興奮的說。

熱門新聞

2026-02-23

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23