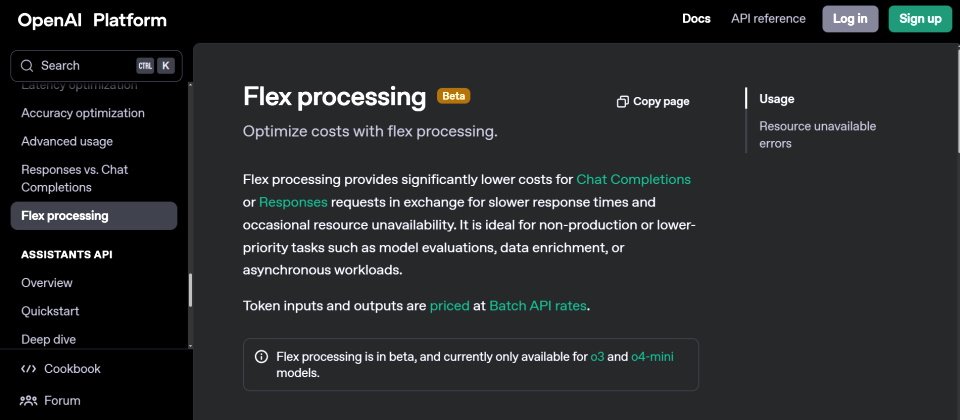

OpenAI開始測試一個名為Flex Processing的API選項,顧名思義,它具備彈性處理的特性,回應時間可能比較慢,偶爾還會出現資源不可得的狀態,但它的價格只有傳統API的一半,由於尚處測試階段,因此目前僅支援o3及o4-mini模型。

OpenAI說明,Flex Processing可大幅降低開發者在對話補全(Chat Completions)或回應(Responses)請求上的成本,代價是可能會有較慢的回應時間,或是偶爾會出現資源不可得的情況。然而,它非常適合非生產或低優先性的任務,像是模型評估,資料擴充,或是非同步的工作負載等。

目前OpenAI平臺的定價頁面上已經出現了Flex API,它的價格與Batch API一致,切換就能看到相關價格。

o3模型原本每百萬個輸入Token的價格為10美元,每百萬個輸出Token的價格為40美元,o4-mini每百萬個Token的輸入與輸出則分別是1.1美元與4.4美元,但切換至Flex API之後,它們的價格分別只要5美元、20美元、0.55美元與2.2美元。

開發人員只要在API請求中,將service_tier參數設為flex即可啟用該功能,OpenAI提醒,以官方OpenAI SDK送出API請求時,其預設的超時時間為10分鐘,倘若提示過於冗長或任務相對複雜,可能需要提高該數字,此外,當遇到資源不可得時,可採用指數退避機制來重試請求。

相較於Batch API主要用來處理大量任務,並非即時,且處理時間的上限長達24小時,Flex Processing依然傾向於即時處理,只是可能會稍微有些延遲。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02