Hugging Face

微軟本周發表20億參數的1-bit模型BitNet b1.58 LLM家族,稱此新型模型比主流Transformer LLM更不占記憶體且更少耗能,適合在CPU或較小型硬體平臺上執行。

微軟研究院與中國科學院研究人員2023年發表名為《BitNet: Scaling 1-bit Transformers for Large Language Models》的論文,首度發表為大語言模型設計的1-bit Transformer架構,稱為BitNet,去年再發表BitNet b1.58 LLM變種。

微軟表示,這是第一個參數20億的開源原生1-bit LLM。它是以4兆字詞的資料集訓練而成,具備4096 token的context length。

研究團隊說明,在BitNet b1.58模型中,單一參數或權重是三元( {-1, 0, 1})的。此類新模型架構引入BitLinear作為nn.Linear層的替代,能夠訓練1-bit 的權重,訓練出的LLM和同樣參數量及訓練字詞的全精度(FP16)Transformer LLM模型相較,具有相同的困惑度(perplexity)及終端任務效能,但卻能大幅減少了記憶體占用和能源耗損,就延遲性及傳輸率表現而言也更省成本。

微軟團隊認為,最重要的是, BitNet b1.58提出了新的模型擴展法則,可用於訓練高效能及低成本的下世代LLM,而且BitNet b1.58對CPU裝置更為友善,更適合執行於邊緣和行動裝置上,顯示出效能和能力。研究人員相信1-bit LLM可催生出新的硬體和為其優化的系統。

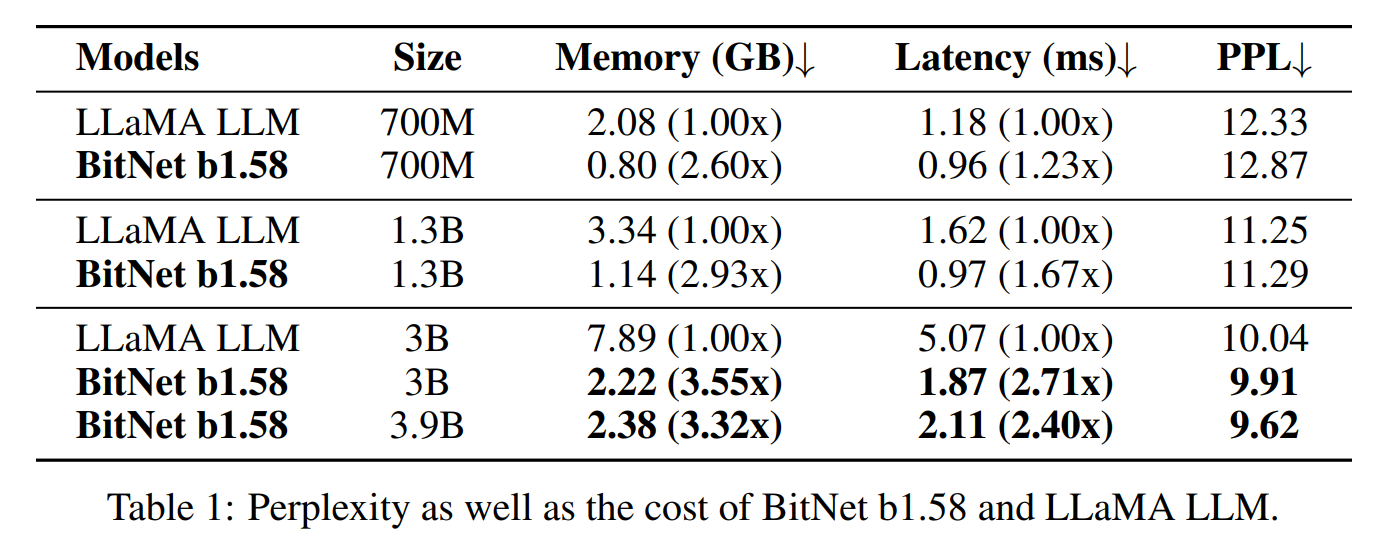

根據研究團隊比較測試,BitNet b1.58-3B/3.9B版本占用記憶體為2.22GB及2.38GB,遠小於LLaMA-3B的7.89GB。延遲性來看,BitNet b1.58-3B/3.9B各為1.87ms及2.11ms,優於LLaMA-3B的5.07ms。二個BitNet b1.58的PPL以及零樣本訓練準確性表現,也都超越LLaMA-3B。

微軟已在Hugging Face 開源三個版本的Bitnet-b1.58模型權重,一是BitNet b1.58 2B4T,適合模型部署。二是Bitnet-b1.58-2B-4T-bf16,僅適合模型訓練或微調。BitNet-b1.58-2B-4T-gguf則包含GGUF格式的權重,相容bitnet.cpp函式庫用於CPU推論。

但微軟也警告開發人員,目前Transformers函式庫的執行方式 並沒有包含為BitNet設計、高度最佳化的計算核心,因此無法彰顯 BitNet 架構的好處。

所以,雖然開發人員可能會因這個模型使用了量化(quantized)的權重而看到節省了一點記憶體,但無法看出速度快、耗能低等效能優勢,因為transformers本身不支援BitNet所需要的底層運算加速。想要體驗論文中提到的效能(包括低功耗和高效率的推論),必須使用官方提供的 C++ 實作版本:bitnet.cpp。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02