Meta

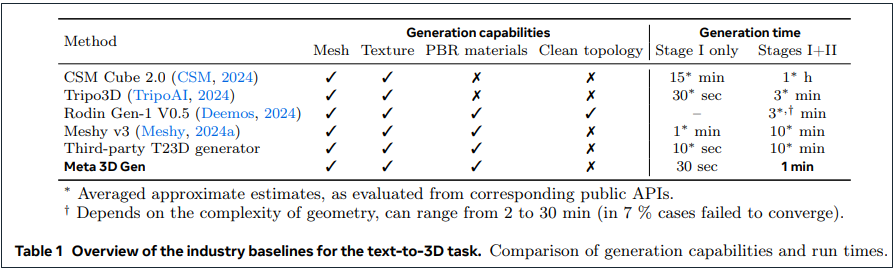

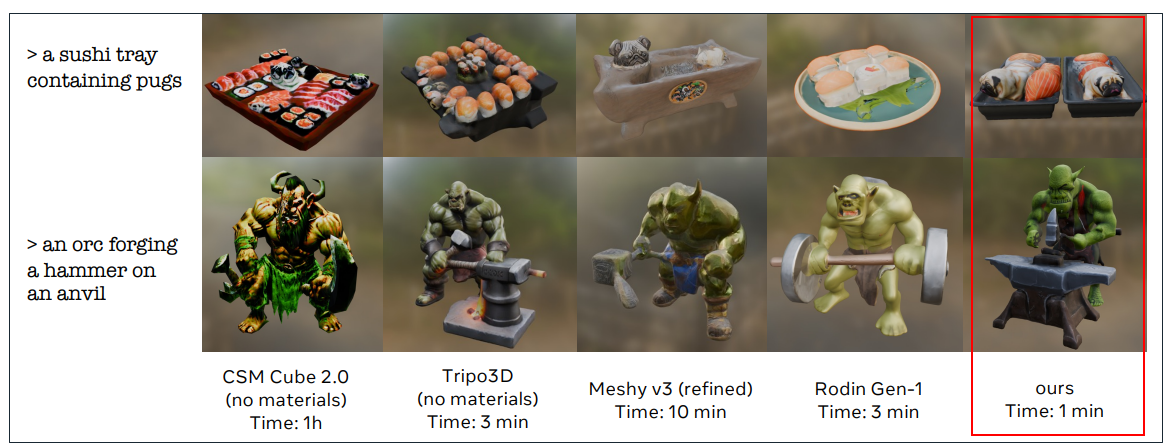

Meta本周公布一個可讓用戶輸入文字1分鐘就可以產生高品質3D物件的AI模型Meta 3D Gen,號稱速度是別人的3到10倍。

Meta說明,3D Gen能在不到1分鐘內根據用戶文字輸入,生成高度符合提示需求,具備高品質3D形狀和文字的資產。這新模型支援3D影像應用在為3D物件打光時,必要的實體渲染(physically-based rendering,PBR),也能將之前AI生成或人類創作的3D物件,根據用戶文字提示加以強化紋理(retexture)。

從技術面而言,3DGen結合了2個階段的2個模型,包括文字轉文字(text-to-text)技術3D TextGen,以及文字轉3D(text-to-3D)技術3D AssetGen。透過結合這二種能力,3DGen可同時以3種方式表達物件,包括視覺空間、體積空間及UV(或紋理)空間。

Meta指出,3D Gen整合2階段生成及結合各自表達(representation)結果。在其測試中,個別階段的模型優於競爭模型;AssetGen憑藉其RBR能力能生成更佳的3D形狀,它發展出的新神經網路可有效在單一紋理中整合視覺(view-based)資訊。另一方面,TextGen則發展端對端的網絡,可在視覺和UV混合空間運作,紋理產出效能也超越之前模型。

根據Meta提供的數據,和單一階段模型,包括Common Sense Machines(CSM)Cube、Tripo3D、Rodin Gen-1、Meshy T23D(text-to-3D)生成模型相比,Meta有68%的勝率。在AssetGen階段中,Meta 3D Gen居第二(僅低於CSM Cube),而整合二個階段,Meta 3D Gen平均可以在1分鐘生成3D物件超過大部分其他模型。

圖片來源/Meta

Meta 3D Gen目前還在研究階段,論文可在此下載。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-06

2026-03-09