國科會

重點新聞(0315~0321)

人才 國科會 TAIDE

國科會揭半導體AI人才策略、TAIDE進展和氣象AI規畫

3月20日,國科會召開第10次委員會議,揭露半導體AI人才和淨零策略,以及國產大語言模型TAIDE進展和氣象AI的運用計畫。就人才策略來說,國科會聯手國發會、經濟部、數位部、環境部、教育部、金管會等部會,根據2023年行政院科技顧問會議結論定出策略,目標是要延攬國際人才、培育國內人才,尤其是AI實作人才,實際作法則是要以獎勵制度提高技職體系育才、促進大學與產業合作,並推動AI全產業應用。此外,政府也將完善AI法制、資料基礎和運算環境。同時,他們還要利用AI和ICT優勢,來發展淨零科技,前陣子提出的晶創臺灣方案和淨零科技方案,就是這些策略的具體措施。

再來,國科會TAIDE團隊一方面盤點公、私部門資料,並個別洽談授權,整理了89.4GB的優質繁體中文資料,另一方面在去年12月,將超級電腦臺灣杉二號整合新購入的H100 GPU運算資源,並正式提供運算服務。而可商用的TAIDE-7B版本和限學研用的TAIDE-13B版本,已具備多輪對話和阻絕產生不恰當回應的能力,另也透過產學研合作打造不少應用,如智慧客服、行政常見問題回應、農業知識問答和中小學臺語教學等,接下來將重點支援公部門導入TAIDE,並預計4月中旬開源釋出TAIDE-7B。

另一方面,交通部氣象署也要運用AI,來提高氣象測報和防災預警能力。他們已規畫AI發展藍圖,要先打造良好的GPU運算環境,以利於AI應用和研發。同時,他們也要導入新技術,來提供鄉鎮尺度災害天氣特報資訊,還要建置金馬雷達,來擴大氣象雷達網拼圖,目標是要在劇烈天氣發生前的3至6小時提供預警。最後,他們也要擴大氣象大數據資料集,作為氣象科技、AI應用的發展基礎。(詳全文)

Nvidia 生成式AI 微服務

Nvidia推生成式AI微服務

在今年度GTC大會上,Nvidia宣布在Nvidia AI Enterprise 5.0平臺新添數十款生成式AI微服務,可分為NIM和CUDA-X兩大類別,前者主要提供最佳化的推論微服務,好來大規模部署AI模型,後者則瞄準需要資料處理、AI與高效能運算的各種應用。

其中,NIM是個容器化的推論微服務,內含預建的容器、產業標準API、特定領域程式碼和最佳化的推論引擎等,要縮小企業營運需求和AI部署間的差距,可將模型部署時間從幾周縮短至幾分鐘。CUDA-X則提供端對端的建置組塊,來支援資料準備、客製化和訓練工作,加速AI開發,如客製化語音與翻譯AI的Nvidia Riva微服務、路徑最佳化的Nvidia cuOpt或高解析度的天氣模擬Nvidia Earth-2等。Nvidia表示,企業可在不同基礎設施上部署這些微服務,如AWS、Google Cloud、Azure或Oracle Cloud Infrastructure。(詳全文)

蘋果 大語言模型 MM1

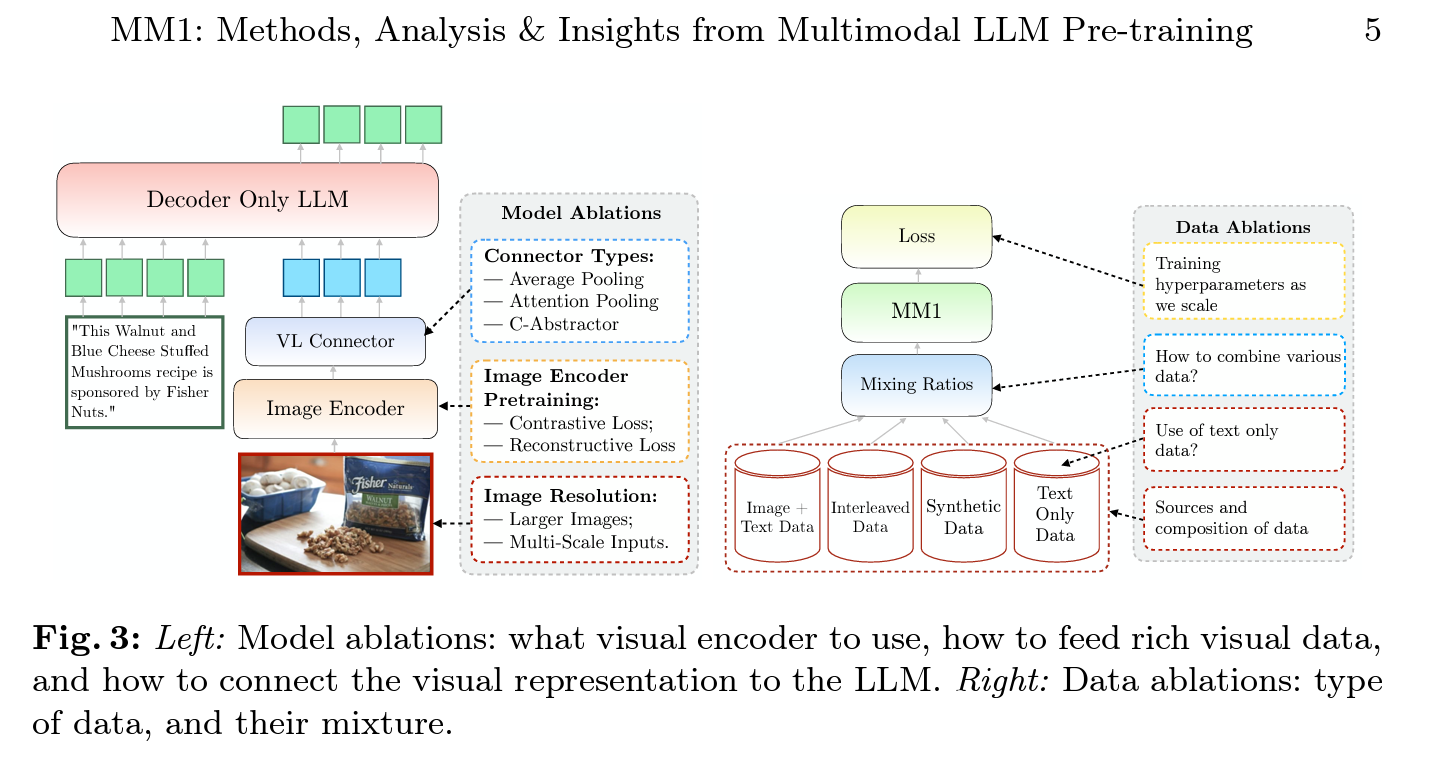

蘋果發表多模態大型語言模型MM1

繼去年底發表的多模態大型語言模型(MLLM)Ferret後,蘋果最近再發表另一個多模態系列模型MM1,最大型的版本具備300億參數。在開發這套模型前,蘋果團隊先是研究了各種多模態模型架構和資料選擇,比如圖像編輯器、視覺語言連接器和各種預訓練資料等,他們因此歸納出幾個重要發現。 舉例來說,要讓多模態預訓練模型在多種基準測試中,達到少樣本SOTA等級的表現,就得採用謹慎設計的訓練資料集,包括圖像搭配圖說、穿插搭配文字的圖像、純文字資料。而且,圖像編輯器加上影像解析度與圖像Token數量,也對模型表現有重大影響,視覺語言連接器的影響力反而可忽略不計。

於是,他們以這些發現為基礎,擴展後打造出MM1系列模型,包含密集模型和混合專家(MoE)架構變體,兩種都在預訓練指標中達到SOTA水準,且經過監督式微調後,還在多個基準測試中達到不錯的表現。受益於大規模預訓練,MM1具有更好的脈絡學習能力、多圖像推理能力,也能處理少量的思維鏈指令。(詳全文)

Grok-1 LLM xAI

xAI開源大型語言模型Grok-1

馬斯克去年成立的AI新創xAI,日前開源自家聊天機器人Grok底層大型語言模型(LLM)Grok-1,具3,140億個參數,採用混合專家架構,包括8個專家模型。這種架構,對任何Token的運算只會使用25%權重(即參數)。xAI表示,目前開源的Grok-1,是未經任何微調的基礎模型,而就表現來說,Grok-1在GSM8k、MMLU、HumanEval與MATH等基準評測上雖然尚未超越GPT-4,但都勝過GPT-3.5。Grok-1採Apache 2.0授權,可進行商業使用和修改,但無法註冊商標。(詳全文)

皮膚 資料集 Google

Google公開皮膚病狀圖片資料集

有鑒於當前皮膚科影像資料集的不足,Google聯手史丹佛大學醫學院,收集各種膚色、身體部位皮膚病狀的照片,然後發表皮膚病狀圖像網路(SCIN)資料集。這個資料集的出現,補足了臨床皮膚疾病資料集的不足,還能提高AI模型通用性。

進一步來說,SCIN資料集經仔細設計,透過新型群眾外包方式,收集各種條件的照片、詳細的貢獻者資訊,以及專業皮膚科醫師的標註。SCIN資料集收錄超過1萬張皮膚、指甲和頭髮狀況的圖像,這些圖像由本人自願貢獻,提供特寫和較遠距離的版本。這些照片還由一到三位皮膚科醫生標註,給出最多5個皮膚病狀,並附上每個標籤的信賴分數。Google表示,資料集包含單獨的標籤,以及衍生的聚合和加權差異診斷,可用於模型測試和訓練。(詳全文)

Stability AI 3D 多視角

Stability AI開源多視角影片生成模型SV3D

Stability AI以Stable Video Diffusion模型為基礎,開發一套Stable Video 3D(SV3D)模型,不只能生成高品質的3D多視角影片,品質還比前幾代好,效能也優於複雜的Zero123-XL模型。

Stable Video 3D模型有兩個版本,分別是SV3D_u和SV3D_p。其中,SV3D_u能用單一圖像,不需使用者設定攝影機參數,就能生成環繞物體的連續視角影片,而SV3D_p則在SV3D_u基礎上,不僅支援單一圖像生成影片,還能根據環繞物體的影片,生成指定攝影機路徑的3D影片。目前,Stable Video 3D供Stability AI會員使用,商業運用也可以。至於非商業用途,開發者可在Hugging Face下載模型權重,並參照Stability AI研究論文。(詳全文)

GPU Nvidia Blackwell

新一代高效能GPU來了,Nvidia發表Blackwell

Nvidia在今年度GTC開發者大會上,發表新一代專為生成式AI設計的處理器Blackwell,各大科技巨頭如AWS、微軟、Meta、OpenAI、Dell、Google、甲骨文、Tesla和xAI等都計畫採用。

由於生成式AI和多模態AI模型訓練需求越來越高,對運算的需求也日益增溫,Blackwell就是為解決這一挑戰而誕生。它是新一代GPU架構,是兩年前推出的Hopper架構的繼任者。Blackwell GPU是由2,080億個電晶體組成,採客製化的台積電4NP製程,所有Blackwell產品都配備2個具光罩限制的晶粒,藉每秒10TB的晶片互連技術,產生一個強大的GPU。此外,Blackwell支援第二代Transformer引擎,可加速大型語言模型和專家混合模型(MoE)的推論與訓練,並提高精度和準確度。而且,Blackwell在訓練上的FP8效能是Hopper的2.5倍,推論的FP4效能是Hopper的5倍,採用第5代NVLink技術則可達到Hopper的兩倍快。(詳全文)

Nvidia 人形機器人 基礎模型

Nvidia也拼人形機器人大腦,揭露通用基礎模型專案GR00T

在今年度GTC開發者大會上,Nvidia揭露全新專案Project GR00T,是一款專為人形機器人設計的通用基礎模型,可作為機器人大腦,來推動機器人技術和具體化AI(Embodied AI)領域研究。

Nvidia正開發各種GR00T技術,例如GR00T本身就是在Omniverse Isaac Sim模擬平臺上的iIsaac Lab應用進行模擬,並在雲端運算調度服務OSMO上進行訓練、部署至新的運算平臺Jetson Thor。其中,Jetson Thor是一款Thor系統單晶片的人型機器人電腦,能執行複雜任務、安全地與人類和機器人互動。負責具體化AI的Nvidia研究經理Jim Fan指出,Project GR00T可讓機器人理解多模態指令,如語言、影片或示範,還能執行各種有用任務。Nvidia正在與全球主要的人形機器人業者合作,來將GR00T部署到各種人形機器人上。(詳全文)

圖片來源/蘋果、Stability AI、Google、Nvidia

AI近期新聞

1. Google發表UI與資訊圖表理解模型ScreenAI

2. Amazon SageMaker整合Nvidia NIM推論微服務

資料來源:iThome整理,2024年3月

熱門新聞

2026-03-06

2026-03-11

2026-03-06

2026-03-10