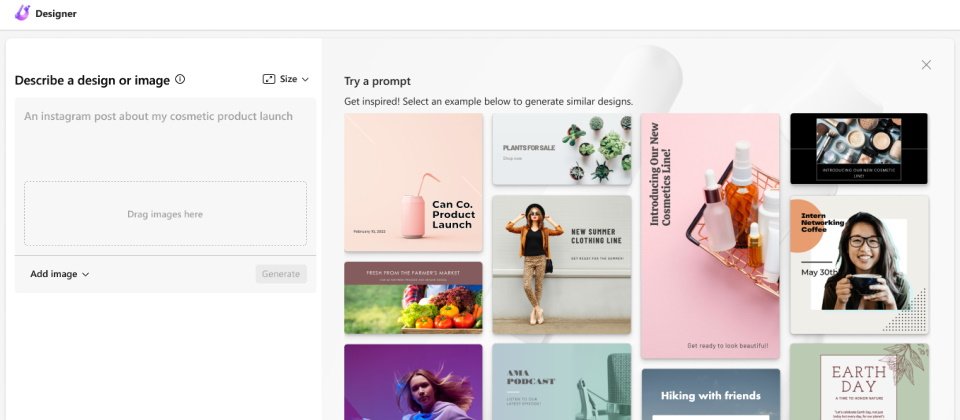

Microsoft Designer功能示意圖。(圖片來源/微軟)

上周美國創作歌手Taylor Swift的假裸照在Telegram、4chan及X等社交媒體上瘋傳,有人直指這些以假亂真的深度偽造(Deepfake)照片是透過微軟的文字轉圖像AI視覺工具Designer所生成,網路科技媒體《404 Media》則發現,微軟已悄悄修補了此一用來生成名人裸照的漏洞。不過,迄今微軟並未證實相關Deepfake是否源自於Designer。

根據《404 Media》的報導,其實Designer原本就不允許生成名人裸照,例如它會封鎖Taylor Swift nude等相關的文字提示,然而,卻有使用者發現他們只要稍微拼錯這些名人的名字,再加上於文字提示中不要使用與性有關的字眼,就能繞過系統最初的保護,進而生成名人的裸照,等於是找到了Designer的漏洞。《404 Media》上周四(1/25)驗證它的確是可行的。

在傳出相關裸照是由Designer製作的之後,微軟執行長Satya Nadella周五(1/26)接受了《NBC News》的專訪,他說對這些Deepfake及其傳播速度感到震驚,也認為業者必須採取行動,強化其文字過濾及避免服務遭到濫用。但Nadella並未證實Deepfake來自Designer。

在受到外界的詢問之後,微軟亦發布了聲明,表示正在調查相關報導,但無法重現報導中所生成的露骨照片,也沒有任何證據表明Designer的安全機制被繞過了,不過亦已強化了該服務的文字過濾機制。

而《404 Media》之後便無法再利用同樣的方式於Designer上生成裸照,相信微軟已修補了該漏洞。

不過,並不只是Designer,使用者似乎也已在其它系統上找到類似的漏洞。至於X則是已經封鎖了散布Deepfake的帳號,為了安全起見,也曾一度封鎖以Taylor Swift為關鍵字的搜尋。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-05

2026-03-02