背景圖片來源/Nvidia

Nvidia、Arm與Intel本周共同發表了8位元浮點(8-bit Floating Point,FP8)規格,期望以較低精確度的格式來改善運算效能,加快深度學習訓練推理速度,以作為AI的標準交換格式,已計畫將該規格提交給電機電子工程師協會(Institute of Electrical and Electronics Engineers,IEEE)。

Nvidia解釋,AI處理需要跨軟體與硬體平臺的全棧創新,才能解決神經網路日益增加的運算需求,促進效率的關鍵之一是採用較低精確的數字格式來改善運算效能,降低記憶體的使用,並針對互動頻寬進行最佳化。為了實現上述好處,業界已由32位元的精確度降至16位元,現在則是8位元,而他們相信擁有一個共通的交換格式,將能推動軟體與硬體平臺的互動,進而改善運算。

因此,Nvidia、Arm與Intel共同撰寫了《供深度學習使用的FP8格式》(FP8 Formats for Deep Learning)白皮書,用以描述8位元浮點規格,提供一個共同的格式來加速包括AI訓練與推理的AI發展。

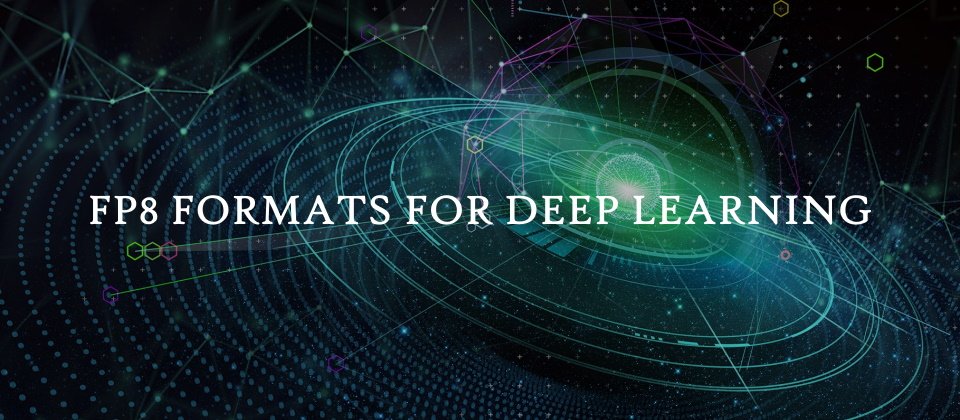

FP8規格由E5M2與E4M3組成,前者使用5個位元來表示指數,2個位元表示尾數,後者則是以4個位元表示指數,3個表示尾數,由於該規格只使用了8個位元,因而節省了額外的運算周期。

圖表取自《FP8 Formats for Deep Learning》白皮書

此外,FP8最大限度地減少了它與IEEE 754浮點格式的偏差,在硬體與軟體之間取得了良好的平衡,因而得以利用現有的實作,加速採用,並改善開發者的生產力。

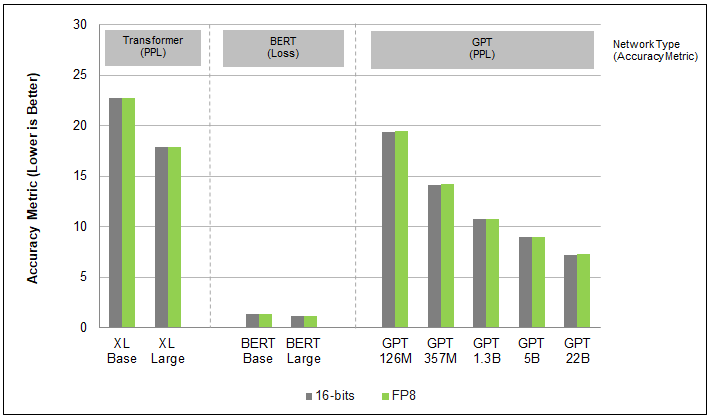

根據實驗,不管是在Transformer、電腦視覺或是GAN網路上,FP8訓練的準確性都類似16位元的結果,但效能上卻有極大的進步。例如Nvidia的Hopper在BERT高精確模型上採用FP8格式,在無損準確性的狀態下創造了4.5倍的速度。

圖片來源/Nvidia

此一規格將採開放及免費授權形式,期望藉由一個可維持準確性的交換格式,讓AI模型於所有硬體平臺上都能有一致的表現。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-02-26

2026-03-02