Google在Pixel 6中,使用一種全新的技術,來計算自拍人像精確的Alpha遮罩,目的是要改善人像模式的拍攝效果,在合成景深效果的時候,能夠利用精確的Alpha遮罩,來擷取拍攝對象的輪廓,並且分離前景和背景。官方提到,這個技術讓擁有各種髮型的用戶,使用人像模式自拍時,都能取得漂亮的照片。

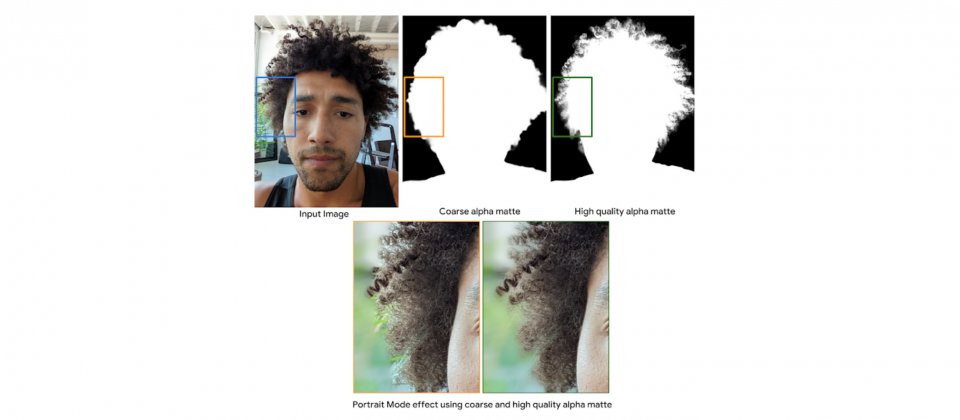

影像去背(Image Matting)是一種擷取精確Alpha遮罩的程序,該遮罩可以將前景和背景物體分開,被廣泛地應用在電影或是圖像編輯中,以達成替換背景或是合成景深效果等視覺效果。在傳統的影像分割技術中,圖像會以二元的方法進行分割,每個像素皆屬於前景或是背景。

研究人員解釋,影像分割技術無法處理細緻的場景,像是頭髮或是毛皮,除非替前景物體,估算每個像素透明值。而與分割遮罩不同,具有透明資訊的Alpha遮罩,可以保留髮絲等級的細節,並且精確地標記出前景邊界。

雖然目前深度學習技術,在影像去背方面有了明顯的進展,但Google提到,這項技術仍然存在許多挑戰,像是生成準確基準真相Alpha遮罩的方法,或是提高野外圖像的泛化能力,甚至是在行動裝置上,使用模型對高解析度圖像進行推理的障礙等。

Pixel 6人像模式所使用的人像去背技術,則克服了這些挑戰,Google訓練了一個由序列編碼器和解碼器模塊,所組成的全卷積神經網路,來估計高品質的Alpha遮罩。

.png)

研究人員使用MobileNetV3模型作為骨幹,加上淺層解碼器,將RGB圖像以及粗糙的Alpha遮罩作為輸入,取得初步低解析度經改善過的Alpha遮罩。

接著則是通過序列淺層編碼器和解碼器模塊,來處理高解析度圖像,以及上一步經改善過的Alpha遮罩,研究人員解釋,淺層編碼器和解碼器比MobileNetV3,更仰賴低階的特徵,能夠利用高解析度的結構特徵,來預測每個像素最終的透明度數值。

全卷積神經網路能夠細化初始前景Alpha遮罩,並擷取像是髮絲等非常精細的細節,該神經網路架構,皆使用Tensorflow Lite,並可在Pixel 6上高效能地運作。

當前多數的影像去背深度學習研究,都仰賴人工註解每個像素以產生Alpha遮罩,以分開前景和背景,這些遮罩由圖像編輯工具或是綠幕生成,Google提到,這個過程很無聊,也難以產生大型資料集,而且Alpha遮罩也容易出現錯誤。

Google則是使用容積擷取系統Light Stage,來生成高品質的訓練資料集,跟過去的資料集相比更加真實,另外,Google還透過合成野外圖像的Alpha遮罩,來提高模型的泛化能力。

熱門新聞

2026-03-06

2026-03-06

2026-03-09

2026-03-09

2026-03-09