健保署自行開發一套自然語言處理模型,要來改善健保醫療影像檢查報告的審查作業,目前先鎖定最常見的頭部電腦斷層影像(CT),未來將進一步開發適用於胸、腹部醫療影像檢查報告的AI模型。

重點新聞(0830~0905)

健保署 NLP 醫療大數據

健保申報審查AI化,健保署用NLP判讀14萬份CT檢查報告只要10小時

為因應大量的醫療申報資料,中央健康保險署自行開發一套自然語言處理(NLP)模型,來自動判讀醫院申報的放射影像檢查報告,以加速健保醫療費用審查作業。

健保署指出,自健保開辦以來,至今年7月已累積了24.7億筆檢驗檢查報告,每年須仰賴3,500位專家來審察260萬件專業醫療案件,其中以電腦斷層(CT)的檢驗費用最高,而頭部又是CT檢查最常執行的部位。為加強審查效率,健保署自5月中開始打造頭部CT檢查報告NLP模型,以2018年第二季共1,000筆頭部CT檢查報告為訓練資料,請來5位專家標註病灶和報告分類。模型至8月初完成,與專家相比,NLP機器學習模型判讀的結果準確率達99%。此外,在時間成本上,這套模型分析14萬筆資料僅需10小時,但專家則需13個月。未來,健保署也將開發胸、腹部等影像檢查報告的NLP模型。(詳全文)

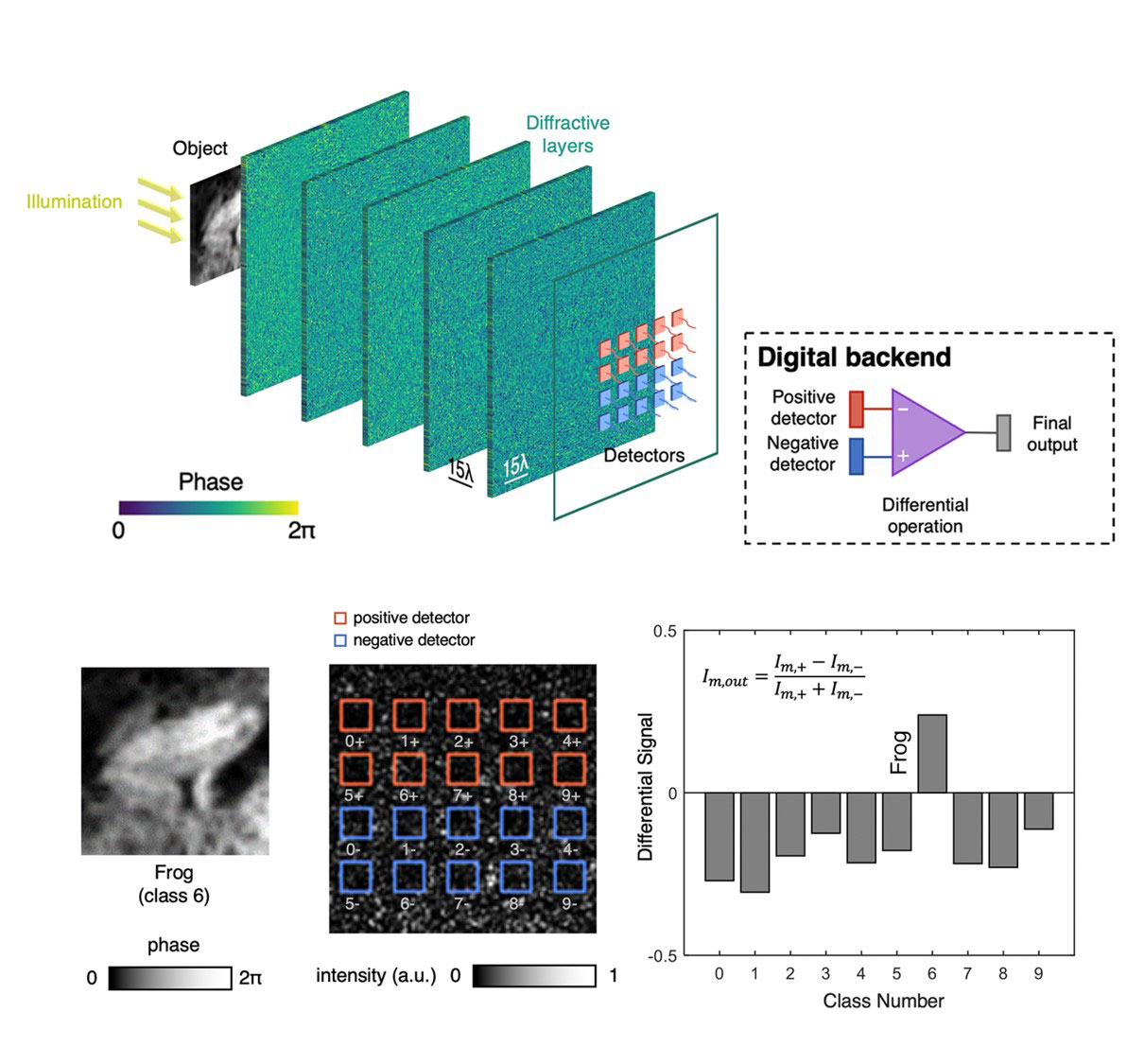

光學類神經網路 UCLA 影像辨識

光學類神經網路不只快如光速,UCLA還大幅提高辨識準確度

近日,加州大學洛杉磯分校(UCLA)改善自家研發的光學類神經網路(Optical Neural Network)設計,大幅提高影像辨識的準確度。光學類神經網路是UCLA去年發表的實體類神經網路,由數個3D列印的8平方公分晶圓組成,靠晶圓上數萬個凸起的像素、光檢測器和光學繞射機制來辨識物體,不僅處理訊息的速度等同光速,也不需要大功率來進行運算。

在這次的研究中,UCLA團隊在光學類神經網路中新添了第二組光檢測器,來增加兩組光檢測器的訊號差異,進而提高物體辨識準確率。團隊後來用CIFAR-10影像資料集來測試,發現改善的光學類神經網路辨識手寫數字、服裝樣式、各種車輛與動物的準確率,分別為98.6%、91.1%和51.4%。(詳全文)

玉山金控 AI專案 風險預測

玉山金控近百項金融AI專案新進展,靠ML評估顧客3年倒帳風險比人還準

玉山金控科技長陳昇瑋近日揭露玉山金AI應用新進展,目前有近百項AI專案正在進行,而已上線的應用範圍涵蓋銀行風險控管、金融商品推銷、投顧服務,以及內部流程自動化,不只精準度高於傳統人工作業,也節省不少人力成本。

在銀行風險控管方面,當銀行面對法人和個人申請新金融業務時,必須考量客戶的倒帳風險。過去,玉山銀行皆以人工方式查閱申請戶資料,再用統計模型來推估未來1至3年內的償還風險,人工推估準確度約為8成。後來導入機器學習技術,來查閱、分析申請戶相關歷史資料,再來自動評估申請戶未來1至3年的償還風險,準確度高達95%。」(詳全文)

影像辨識 85度C 自助結帳

美國85度C新導入麵包自助結帳機,就靠國產麵包辨識AI引擎

今年8月,美國85度C麵包店正式推出麵包自助結帳KIOSK系統,顧客只要將選好的麵包托盤放在攝影鏡頭下,系統就能自動辨識所有麵包的品項和數量,讓顧客自己刷卡結帳。這個用來辨識出各種麵包影像的關鍵技術來自臺灣新創創意引晴(Viscovery)。

為訓練這套系統,創意引晴團隊利用5至10張影像來訓練每種麵包品項,涵蓋各種顏色、形狀等特徵,來提高模型辨識率。此外,他們也研發了可模擬不同情境的影像生成技術,來增加差異化影像資料量。訓練好的模型,可部署到雲端或在企業內部機房,店家至少要有一支1080P高解析度的數位攝影機,並整合辨識引擎API到店家POS機來結帳。每次結帳時,圖片會上傳到雲端辨識引擎,再將自動辨識好的品項與數量資料回傳到POS機。最近,臺灣也有大型連鎖零售商要導入這套系統,推出同樣能自動辨識麵包的結帳服務。(詳全文)

智慧導眼 影像辨識 盲胞

南臺科大用AI作為盲胞的雙眼,輔助安全過馬路

南臺科大師生自行開發一套智慧導眼,要來輔助盲人安全行走。智慧導眼主要由三個硬體設備組成,包括智慧眼鏡與耳機、手杖和腰掛式裝置。智慧眼鏡配有紅外線感測器,可偵測障礙物、發送訊號到手杖,手杖便會震動提醒盲胞;此外,智慧眼鏡還配有一個小型鏡頭,可透過內建於裝置的AI模型來辨識斑馬線,如果盲胞走偏了,耳機就會提醒往左或往右。

這套AI模型由南臺師生自行開發,團隊利用TensorFlow和2,000張斑馬線影像來打造這套系統,包括白天、晚上和雨天,辨識準確度分別高達97%、95%等,而為了加速AI模型在裝置上運行的時間,團隊也自行開發一款技術來讓模型更輕量。而耳機部分也配合眼鏡感測器,透過相同通訊協定來接收紅綠燈號誌訊號和秒數,來告訴盲胞。此外,搭配智慧導眼App,要是盲胞不小心跌倒,系統會將盲胞所在的GPS位置和緊急訊息發送給家屬。這套解決方案也已與盲胞測試。(詳全文)

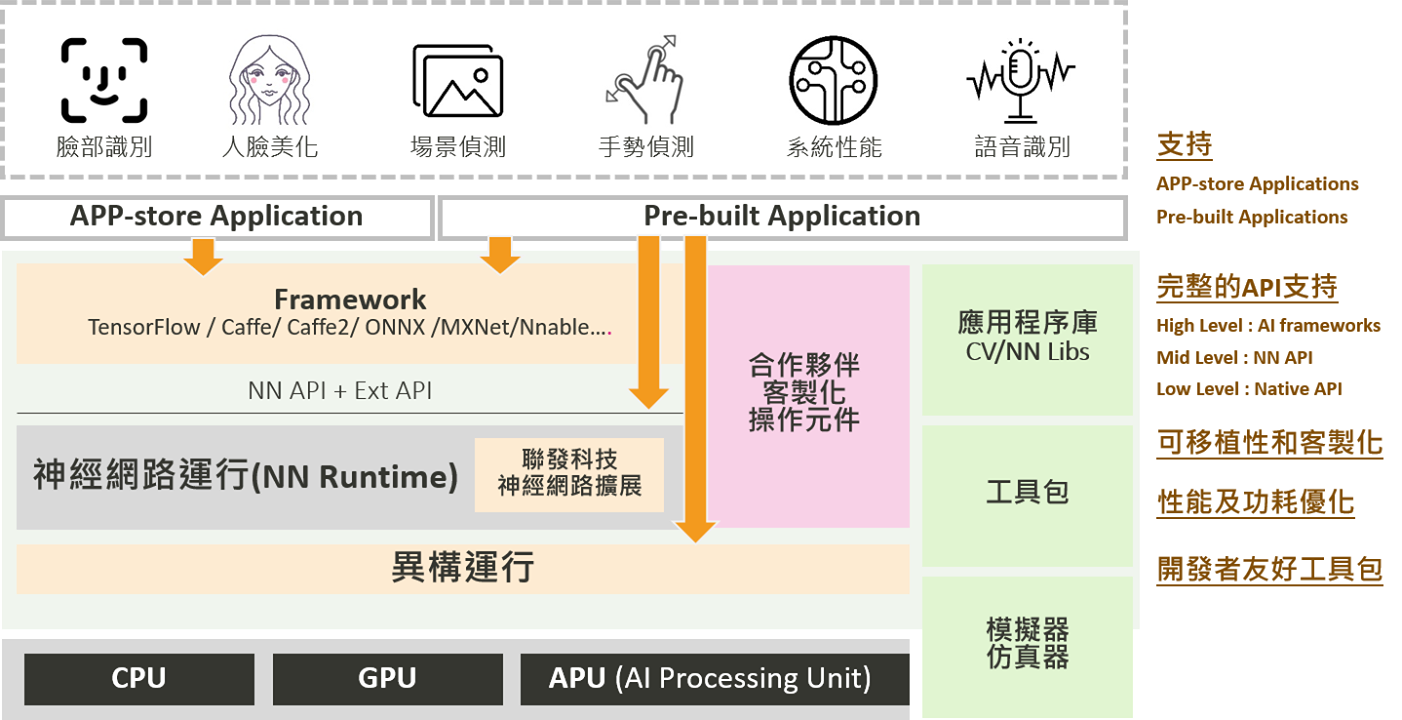

國研院 聯發科 終端AI

國研院半導體中心聯手聯發科,要培養終端AI人才

國研院半導體中心近日攜手聯發科,一起為大學種子師資規畫終端AI(Edge AI)課程,這項課程也已於新竹和臺南開辦,吸引了全臺10多所大專院校和技職體系共80多位教師。

為加速實作體驗,聯發科也捐贈了30套終端AI開發平臺軟硬體NeuroPilot。該平臺利用單晶片整合高效能的AI處理器APU,結合一系列AI開發工具,讓開發者可快速將雲端AI部署到終端AI平臺上,不需透過網路即可完成,避免資安隱憂。(詳全文)

DeepMind 增強式學習 OpenSpiel

DeepMind釋出遊戲增強式學習框架OpenSpiel

DeepMind研究團隊近日在GitHub上釋出應用於遊戲的增強式學習框架OpenSpiel,包含增強式學習的環境和演算法,可用於遊戲中的通用增強式學習、搜尋和規畫,並提供分析學習動態的工具,以及常用的評估指標。

進一步來說,OpenSpiel內建20多種不同類型的遊戲,這些遊戲涵蓋了單一或多個代理人,遊戲形式則有零和、合作、一般和對局(General-Sum)等。這些遊戲以C++撰寫,並以Python打包。OpenSpiel的演算法則是以C++或Python實作,由於這2種語言的API幾乎相同,可方便開發者在2者間切換。此外,DeepMind也正開發PyTorch和JAX的支援,另由於OpenSpiel函式庫的一個子集被移植到Swift上,開發者也能在MacOS裝置上進行研究。(詳全文)

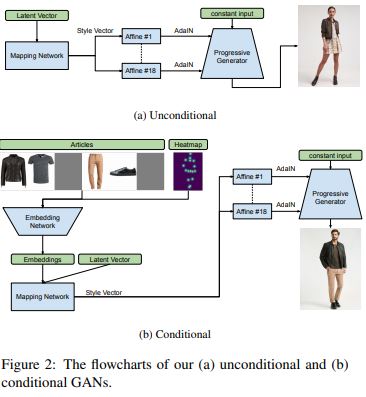

Zalando StyleGAN 時裝

德國獨角獸新創發表一套GAN模型,可自動生成不同造型和姿勢的時裝模特兒

德國一家時裝科技新創Zalando利用對抗生成網路(GAN)來產生高畫質的時裝模特兒影像,隨時可「換上」不同風格的服飾並擺出不同姿勢。團隊首先以Nvidia去年推出的StyleGAN為基礎,採用無條件StyleGAN和條件式StyleGAN等兩款模型,同時建立一個擁有38萬張影像、解析度為1024×768像素的資料集,每張影像都有一個模特兒、衣服和配件加起來最多6件,另外還有一個深度姿勢估計器,會擷取模特兒身體的16個關鍵點。團隊利用這些資料和4個Nvidia V100 GPU來訓練模型,以4周時間訓練完後,無條件StyleGAN可產生逼真的模特兒影像,未來還計畫結合Deepfake AI技術,來將消費者的面貌整合到虛擬模特兒上,進一步提供個性化虛擬時尚購物體驗。(詳全文)

攝影/王若樸 圖片來源/UCLA、聯發科、Viscovery

AI趨勢近期新聞

1. 臺灣人工智慧學校攜手臺大醫院、三軍總醫院、林口長庚,開辦北部智慧醫療專班

2. Nvidia和VMware合作要將AI工作負載帶上AWS

3. Google智慧門鈴Nest Hello的訂閱服務,開始提供包裏偵測功能

資料來源:iThome整理,2019年9月

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02