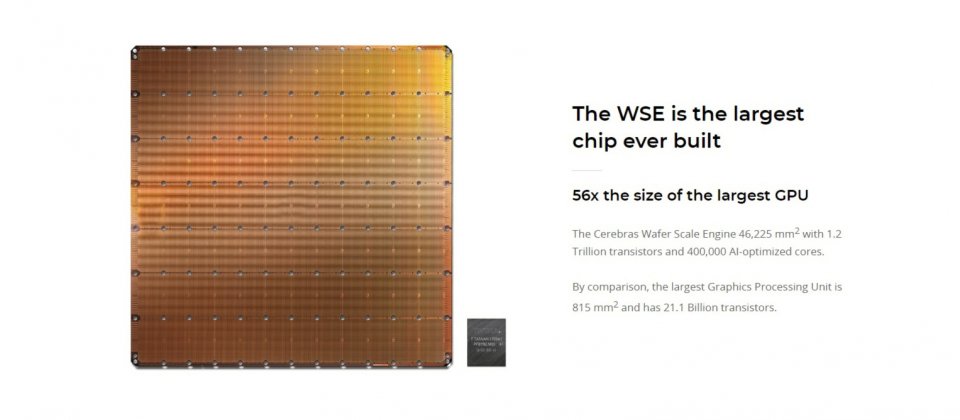

電腦系統公司Cerebras Systems發表了一款有史以來最大的半導體運算晶片Cerebras Wafer Scale Engine(WSE),其尺寸超過一個iPad Air大小,上面擁有超過1.2兆個電晶體,以及40萬個人工智慧最佳化的核心,要為深度學習應用提供更強大的運算能力。

Cerebras Systems是一間由電腦架構師、電腦科學家以及深度學習研究人員組成的新公司,目的是要建立新型態的電腦,以加速深度學習的應用,而晶片WSE則是Cerebras Systems所發展的解決方案,其中一個重要的組成元素。這個巨型晶片的邊長接近22公分,面積比目前最大的GPU,還要大上56倍,而上面所擁有的運算資源,包括核心、記憶體甚至是記憶體頻寬,都比單一GPU晶片多上許多。

在這麼大塊的晶片上,可以放上40萬個為人工智慧最佳化的核心,以及提供18GB的晶片上記憶體,這些記憶體分散在各核心之間,但都在同一層級的記憶體階層架構下運作,核心能以一個時脈周期的速度存取記憶體。這些人工智慧運算核心則使用Swarm Fabric技術,在2D的網狀網路上相連,以100Pb的頻寬進行訊息交換,其頻寬適GPU的一萬倍。官方提到,Swarm Fabric是一個突破性的技術,可以為記憶體間提供超高頻寬以及低延遲,但耗能僅為傳統GPU技術的一小部分。

WSE的所有核心都可透過軟體配置,以支援用戶訓練模型所需要的特定精確通訊,這些大量的可程式化核心,在單一晶片上提供叢集規模的計算能力,而就設計在核心旁邊的記憶體,可以確保其記憶體的高使用率,而且晶片上的傳輸也比晶片間的傳輸技術,像是InfiniBand還要快非常多。

Cerebras Systems提到,深度學習的發展是當前重要的工作之一,因為能夠用於推動各領域的應用,但是其發展不僅受到應用程式與想法上的限制,還受到計算可用性的限制,訓練一個新模型可能需要數天到數個月,而這正是人工智慧創新的主要障礙。

他們也認為,特殊應用就需要專門的加速器,GPU原本就是為圖形處理任務設計的,並不適合用於深度學習,而WSE是專為深度學習設計,能夠提供更高數量級的運算能力,把數個月的模型訓練時間,縮短到數分鐘

熱門新聞

2026-03-06

2026-03-11

2026-03-06

2026-03-10