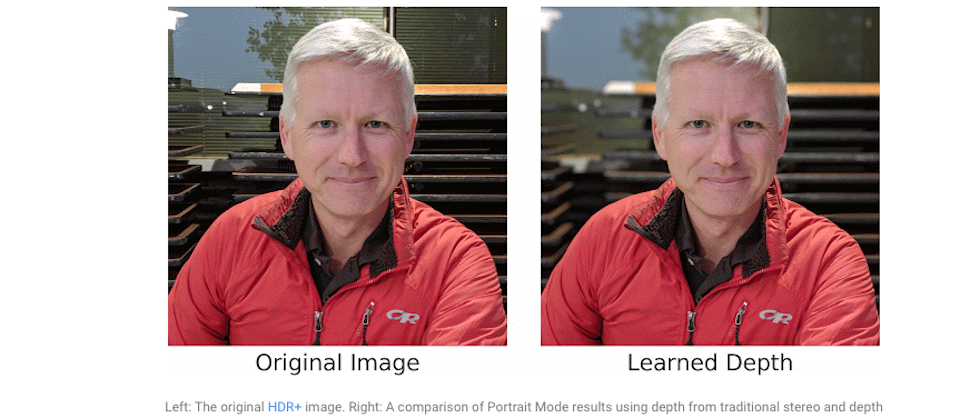

繼前陣子Google研究團隊公開提升夜拍模式品質背後的技術後,最近又發布了在相機的人像(Portrait)模式中,預測場景中物體深度的成果,Google推出的智慧型手機Pixel,相機內建人像模式,透過將背景經過模糊處理,將拍攝對象保持清晰,來創造出專業級的照片,去年,Google團隊曾公開如何在單一相機,透過相位對焦(Phase-Detection Autofocus),或是稱為Dual Pixel自動對焦的傳統立體視覺演算法計算景深,今年,Google研究團隊改用機器學習,在Pixel 3 手機上,改善景深的預測來提升人像模式照片的品質。

過去處理人像模式的照片是透過神經網路,來決定每個pixel和人像、背景的關係,透過相位對焦產生帶有深度資訊的分割遮罩,再根據深度資訊進行模糊處理,這樣的方法比較接近專業相機的作法。相位對焦就是在同個場景,拍攝兩張角度些微不同的照片,人像在兩張照片中看起來是靜止的,而受到視差(parallax)的影響,背景會呈現水平移動,而透過視差就能預測物體的深度。

不過,Google指出,相位對焦的挑戰在於背景平移的值太小,要準確地計算有難度,再加上傳統的立體視覺技術會遇到孔徑(Aperture)的問題,也就是說,當透過小的孔徑來觀察影像時,因為只觀察物體的局部,無法明確辨識出直線平移的方向和距離值,這兩項因素都會導致深度評估輸出錯誤的結果。

為了解決這種可能的錯誤,首先,Google透過是視差來校正誤差,舉例來說,與接近焦點平面的點相比,遠離焦點平面的點,在照片中看起來便沒有那麼尖銳,可做為判斷失焦(defocus)的參考依據,接著人類因為知道物體在現實生活中大略的大小,即便是在平面的影像中,人也能分別出影像中物體的遠近,Google稱之為語義的參考依據。

要將這兩項參考依據手動設計成演算法非常困難,但是透過機器學習技術就能辦到,Google在Tensor中建立了一套卷積式神經網路,將相位對焦像素作為輸入資料,讓該神經網路學習預測深度,這項改良過的神經網路,正是改善Pixel 3 人像模式照片拍攝品質的關鍵。

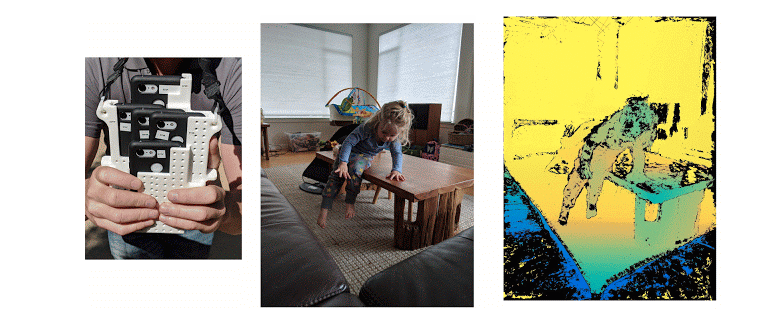

為了訓練該神經網路,Google需要大量的相位對焦影像和對應的高品質深度特徵圖(Depth Maps),由於要使該神經網路預測深度的結果,能夠應用在智慧型手機上,Google也需要加入類似使用者會拍攝的照片,作為訓練樣本,為了收集這些訓練資料,Google將5支pixel 3 手機綁在一起,打造了一支外型怪異的裝置Frankenphone,讓5支手機同時拍攝,將誤差值控制在2毫秒內,透過該裝置拍攝的照片,能夠利用運動的結構和多視角的立體視覺,計算出準確的深度。

左一為Google將5支pixel 3 手機綁在一起,用來拍攝訓練資料的裝置Frankenphone,中間的圖為拍攝的照片,右一則是深度特徵圖。

圖片來源:Google

Google指出,該設備拍攝的影像非常適合訓練該神經網路,因為從5個視角拍攝,確保了多個方向的視差問題,也避免了孔徑問題,且照片中的每個點幾乎都在另一張照片出現,大多數的點都有參考值可以找出對應關係,此外,同步拍攝還能確保動態場景的深度。

最後為了縮短人像照片處理的時間,需要系統能夠快速預測深度,因此Google用輕量級的裝置端機器學習平臺TensorFlow Lite,和pixel 3的GPU來快速計算景深,產生高品質的人像模式照片。

熱門新聞

2026-03-02

2026-03-02

2026-03-02

2026-03-02

2026-03-03

2026-03-02

2026-03-02