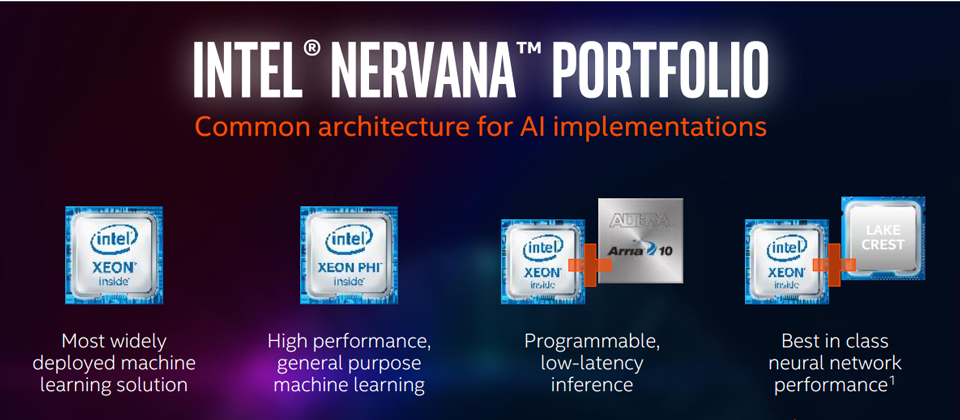

【英特爾AI應用主打4種伺服器處理器】若要在資料中心環境當中建構AI系統,英特爾預計將提供4種運算平臺:Xeon、Xeon Phi、Xeon搭配FPGA(Arria 10)、Xeon搭配Nervana(Lake Crest),分別主打基本用途、高效能、低延遲與可程式化、類神經網路加速等不同需求。

iThome

這一年來,除了雲端服務、大數據、行動應用持續走紅以外,人工智慧(AI)無疑是下一個即將起飛的熱門IT技術,許多人已經開始積極投入機器學習、深度學習的開發與應用,繪圖處理器大廠Nvidia今年的營收、獲利、股價持續上漲,也與此有關,而同樣是處理器大廠的英特爾,現在也對AI的發展寄予厚望,並正式宣布調整以AI為重的策略,全力發展軟硬體技術,以支援相關的發展。

在11月18日舉行的「Intel AI Day」活動當中,英特爾執行長Brian Krzanich提出了他們的願景,並期盼能推動AI普及,將AI變得更平民化,進而引領AI運算時代的來臨,使英特爾能夠成為加速AI發展的催化劑。

而就更實際的產品而言,英特爾在伺服器端處理器平臺上,也針對AI有所布局。在2017年,現有的Xeon E5、Xeon Phi處理器平臺都將推出新一代產品,同時,除了以Xeon搭配FPGA(Field Programmable Gate Array)晶片Altera Arria 10之外,英特爾也將以Xeon搭配新開發的「Lake Crest」晶片,專攻類神經網路的加速應用。

值得注意的是,Lake Crest的形式是一張基於矽晶片的獨立加速卡,技術源自於英特爾今年8月併購的新創公司Nervana Systems,該產品將於2017年第一季問世。之後,英特爾還將推出Xeon結合這種新型態加速AI處理機制的晶片,研發代號稱為「Knights Crest」,屆時,採用這顆晶片的伺服器直接具有系統開機的能力,無需搭配Xeon處理器。

-600-1.png)

英特爾AI伺服器平臺的發布時程

在2016這一年,英特爾已經推出了FPGA的系統單晶片解決方案Arria 10,以及Xeon Phi x200系列(Knights Landing)。2017年他們將發表新的Xeon Phi(Knights Mill),以及深度學習專用的運算晶片Lake Crest,而在通用伺服器級處理器Xeon系列,基於Skylake微架構的產品也將問世。

強化平行處理與向量處理性能,Xeon與Xeon Phi支援新指令集

英特爾在2017年即將推出的伺服器產品,還包括採用Skylake微架構的新一代Xeon處理器,以及Xeon Phi(代號為Knights Mill)。

以現行的Xeon E5-2600 v4系列處理器而言,根據英特爾提供的效能測試數據,若執行大數據與AI領域經常會運用的Apache Spark軟體環境,效能提升的幅度,可望達到18倍之高(以今年推出的Xeon E5-2699 v4搭配MKL 2017 Update 1程式庫,對上Xeon E5-2697 v2搭配F2jBLAS程式庫)。

英特爾表示,在初期出貨給特定雲端服務業者的「Skylake」Xeon處理器版本(preliminary version)當中,將會加入更多整合式加速運算的進階特色。例如,新的進階向量延伸指令集AVX-512,可針對機器學習類型工作負載的執行,提升相關的推理論斷能力。至於Xeon新平臺其他增益的功能與組態支援,預計將會在2017年中正式發布時,才會揭露。

若單看AVX-512這套指令集,目前只有今年6月推出的Xeon Phi x200系列處理器(Knights Landing)支援,接下來,英特爾的主力通用伺服器平臺Xeon處理器,會在下一代採用Skylake微架構的產品當中支援。

因此,就目前而言,英特爾現有處理器所支援的AVX指令集,總共可分為三代:Sandy Bridge和Ivy Bridge微架構處理器,內建的是第一代AVX,Haswell和Broadwell微架構處理器改為AVX2,而Skylake微架構和Knights Landing是採用AVX512。基本上,前兩代的AVX指令集,都是基於128位元SIMD暫存器,可延伸到256位元。

至於Xeon Phi的下一代產品 「Knights Mill」,英特爾表示,會把深度學習的應用效能,提升到現有Xeon Phi處理器(7290)的4倍,並同樣具備直接記憶體存取(Direct Memory Access)的能力——最高可存取到400GB(Knights Landing是以384GB的DDR4記憶體,搭配16GB的MCDRAM)。

同時,在橫向擴展到32節點的系統環境當中,目前的Xeon Phi也已經能大幅縮短機器學習的訓練時間,成效差距可達到31倍之大。

基於FPGA可程式化硬體運算技術,推出深度學習加速卡DLIA

FPGA則是另一個英特爾近年來極力發展的重點,他們在2015年併購了專攻FPGA技術的Altera公司,並以此成立新的業務單位──可程式化解決方案事業群(Programmable Solutions Group)。

針對高效能運算(HPC)領域當中也相當熱門的AI應用,英特爾在今年11月稍早舉行的Supercomputing 2016大會期間,也宣布將於2017年初推出基於FPGA的AI加速解決方案,名為Deep Learning Inference Accelerator(DLIA),可用於影像辨識應用,並且具備大量的資料吞吐能力與高度的能源效益。

DLIA的硬體是英特爾FPGA 系列產品當中的Arria 10的介面卡,晶片之間傳輸率,最高可達到25.78 Gbps,最大浮點運算效能為1,500 GFLOPS,可因應卷積神經網路(CNN)的部署架構,提供最佳化效能。而且,Arria 10本身所採用的處理器,是20奈米製程的ARM系統單晶片(SoC)Cortex-A9 MPCore,比起前一代FPGA與SoC晶片,號稱能節省4成的電力。

同時,由於DLIA是基於FPGA技術而成,所以秉持了可程式化的特性,用戶能從遠端對DLIA進行韌體更新,以便隨時因應AI技術的改變,而且也能直接運用深度學習的軟體開發框架,例如英特爾自己維護、發行的Caffe,以及MKL-DNN(Math Kernel Library for Deep Neural Networks)等程式庫。

專為深度學習應用所設計的Crest系列晶片,預計將在2017年問世

英特爾2016年併購Nervana公司後,預計在2017年推出運算晶片Nervana Engine。

這顆代號為Lake Crest的處理器,是專為深度學習的工作負載所設計的,將提供極高的運算密度,大幅超越現行GPU的運算能力。

在資料存取的方式上,Lake Crest本身也配置了新一代的高速頻寬記憶體技術HBM2,搭配的總容量為32GB,存取速度高達8Tb/s。而晶片之間進行互相溝通時,Lake Crest提供12個雙向的連結通道,有助於在彼此互連的架構下,進行高速資料傳輸。

英特爾強調,Lake Crest能支援真正的資料模型平行處理作業,因為在這樣的運算架構當中,每一個運算節點,都會配置專用的記憶體介面,如此一來,系統能夠存取的資料模型大小較不受限,同時也可以藉此增進記憶體I/O效率。

而在Lake Crest之後,英特爾打算師法Xeon Phi x200系列處理器的作法,推出更進一步整合Xeon與Nervana加速技術的晶片,研發代號為Knights Crest。展望AI運算平臺的未來目標,他們希望將現行AI應用耗費在深度學習訓練的時間,盡可能地縮短,在2020年能做到即時訓練,達到節省幅度100倍的目標。

-600-2.png)

Lake Crest的深度學習處理架構

Lake Crest是基於多維度資料陣列(tensor-based)的處理架構,而且,提供Flexpoint的作法,所能支援的平行處理層級是現行技術的10倍。這顆晶片內建的記憶體也很特別,是HBM(High Bandwidth Memory)的第二代技術,記憶體頻寬是目前DDR4的12倍。

熱門新聞

2026-02-23

2026-02-20

2026-02-23

2026-02-23

2026-02-23

2026-02-20