Nvidia

今年3月GTC大會期間,輝達宣布3款商用GPU產品導入Blackwell架構,並將這些機型稱為RTX Pro Blackwell系列,5月先推出其中兩款桌上型電腦工作站GPU,另一款是資料中心GPU產品RTX Pro 6000 Blackwell Server Edition(以下簡稱為RTX Pro 6000 BSE),輝達當時僅揭露部分規格。

最近適逢SIGGRAPH年度大會舉行,我們發現伺服器版RTX Pro 6000 Blackwell的網頁,悄悄將產品上市狀態的標示,從原本的「即將推出(Coming Soon)」改為「現正供貨中(Coming Soon)」,而且,公布內容更完整的技術規格文件,在合格伺服器型錄Nvidia Qualified System Catalog當中,也將這款GPU產品列入,並標明此項搭配已符合Nvidia要求的伺服器產品:Dell PowerEdge XE7745。

相較之下,伺服器版RTX Pro 6000 Blackwell的硬體配備,如CUDA核心、Tensor核心、RT核心的數量,以及GPU記憶體的類型、容量、頻寬,都同於先前預告的內容;對於3種運算效能的標示,也微幅上修,例如,FP4最高為4 PFLOPS(先前為3.7 PFLOPS),FP32單精度為120 TFLOPS(先前為117 TFLOPS),RT核心的處理能力為355 TFLOPS(先前為354.5 TFLOPS)。

無獨有偶,輝達在8月第一週發表vGPU軟體第19版,當中唯一新支援的產品,就是RTX Pro 6000 BSE,強調GPU本身與搭配這款產品而成的RTX Pro Server伺服器平臺,可為虛擬化資料中心應用需求提供卓越的擴充性,以及更高的投資報酬率。

Nvidia今年上半預告推出Blackwell架構伺服器GPU加速卡,6月11日VivaTech 2025大會期間舉行的GTC Paris正式亮相,Nvidia共同創辦人暨執行長黃仁勳秀出RTX Pro 6000 Blackwell Server Edition,以及整合ConnectX-8 SuperNIC與PCIe交換器的主機板,組成RTX Pro伺服器,後續在8月SIGGRAPH大會正式推出這套解決方案。圖片來源/Nvidia

今年5月舉行的台北國際電腦展期間,Nvidia宣布推出RTX Pro Server,共同創辦人暨執行長黃仁勳在主題演講,強調這個平臺帶來的AI運算效能突破,得力於可提供更大容量的GPU記憶體,以及更大的I/O與網路頻寬。圖片來源/Nvidia

採用Blackwell架構,搭配最新一代Tensor核心與RT核心

單就RTX Pro 6000 BSE而言,可帶來哪些成效?Nvidia在3月預告在多種應用上,會有好幾倍的改善幅度。以採用Ada Lovelace架構的資料中心GPU產品L40S為基準,RTX Pro 6000 BSE針對代理型AI應用的大型語言模型(LLM)處理負載,吞吐量可提升至5倍,基因體學的定序速度暴增至7倍(Smith-Waterman演算法的處理可達到6.8倍),文字生成影片的速度提升至3.3倍,推薦系統的推論處理加快到逼近兩倍,著色處理速度超過兩倍。

在5月舉行的台北國際電腦展,Nvidia在自家的主題演講當中,共同創辦人暨執行長黃仁勳也親自介紹RTX Pro 6000 BSE,以及與各大伺服器廠商合作打造的RTX Pro Server。他旁邊的簡報畫面,列出搭配8張RTX Pro 6000 BSE的RTX Pro Server的效能特色,例如,使用Nvidia新創的浮點運算格式FP4,AI運算處理效能可達30 PFLOPS;執行Omniverse數位雙生即時模擬作業,效能為3 PFLOPS;可運用的GPU記憶體容量達到800 GB,並且擁有13 TB/s的GPU記憶體頻寬;伺服器配備ConnectX-8 SuperNIC Switch,針對多GPU互連,可提供800 GB/s的總頻寬。

而在每秒產生的符元(Token)數量上,Nvidia也秀出耗費每5百萬美元與單一使用者這兩種情境對應的效能走勢。採用Llama 70B模型時,RTX Pro Server最高可達到H100伺服器的1.7倍;採用DeepSeek R1模型時,RTX Pro Server可達到H100伺服器的4倍。

7月與Nvidia關係密切的AI運算服務供應商CoreWeave,宣布搭配RTX Pro 6000 BSE的執行個體正式上線,成為第一家採用這款伺服器級GPU暨提供運算服務的雲端平臺,每個執行個體配備2個英特爾第五代Xeon Scalable處理器、8個RTX Pro 6000 BSE GPU,以及多個BlueField-3資料處理器,他們也提及幾項效能突破的特色,例如:LLM推論效能提升至5.6倍(Llama 3 70B模型),文字生成影片的速度提升至3.5倍,FP4運算效能為3.8 PFLOPS。

在8月初介紹vGPU軟體第19版推出的部落格文章,Nvidia揭露更多的效能改善資訊。例如,同樣以L40S為比較基準,RTX Pro 6000 BSE用於Llama 3 70B模型,效能增長可達到5.6倍,用於自家Omniverse的著色處理效能是3.5倍,用於Autodesk Arnold的著色處理效能是1.9倍,用於模擬的效能提升至2倍(Siemens UFX、Dassault Abaqus)。

針對RTX Pro 6000 BSE內部而言,Nvidia也在新釋出的技術規格文件與8月11日發布的新聞稿,點出個別元件革新後的效能提升,呼應先前預告的資訊。

首先是這款GPU採用第五代Tensor核心與第二代Transformer引擎,由於支援FP4的運算精度,可加快AI模型處理、減少記憶體用量,相較於前一代GPU,AI推論的效能可提高至6倍。而在執行採用Llama Nemotron Super這類AI推理模型的AI代理,承擔複雜任務的自動化處理時,以單個GPU而言,對上既有支援FP8浮點運算格式的H100為比較基準時,RTX Pro 6000 Blackwell由於支援Nvidia新創設的浮點運算格式NVFP4,可獲得3倍的性價比優勢。

第二個特點是導入第四代RT核心,圖像擬真的著色處理效能增至4倍,光線與三角形相交速度提升1倍,搭配新支援的RTX Mega Geometry技術之後,光線追蹤三角形的繪製數量達到100倍以上,用戶可創造逼真、精確度與物理環境一致的場景,以及身歷其境的3D設計。

針對工廠數位雙生、機器人模擬,以及大規模合成資料產生的工作流程,相較於採用L40S的系統,Nvidia表示,RTX Pro Server可提供4倍的速度。

而在能源使用效率方面,對比單純採用CPU的2U伺服器系統,同樣面對資料分析、模擬、影片處理、圖形著色等工作負載時,Nvidia強調RTX Pro Server可提供45倍的效能、18倍的能源使用效率,以及更低的總持有成本。

支援MIG與vGPU,提供實體與虛擬等兩種多GPU應用

值得注意的是,Nvidia稍早推出的RTX Pro Blackwell系列GPU,當中的6000、5000,均支援GPU多執行個體(MIG),8月初Nvidia更強調,RTX Pro 6000 Blackwell系列是第一批支援MIG、專為加速圖形與運算工作負載的GPU產品。基於MIG的硬體分割機制,用戶可將單張RTX Pro 6000 BSE,區分為多個彼此隔離運作的GPU執行個體,各自擁有記憶體、快取、運算引擎,以及串流多處理器(Streaming Multiprocessors,SM),確保執行在不同MIG當中的個別工作負載,都能獲得一定的服務品質(QoS),不會因為其他工作負載的處理而遭到擾亂、甚至被迫中斷運作等影響。除此之外,若啟動MIG的GPU搭配vGPU軟體提供的分時共用機制(time-sliced)之後,用戶可在每一個GPU執行個體當中,建立多租戶服務架構,提供更大的執行規模擴充能力,實現高度整合的GPU基礎架構,促使單一GPU支援更多工作負載執行。

Nvidia表示,當RTX Pro Blackwell系列GPU啟用MIG功能,並且搭配vGPU 19.0軟體,能在單張GPU加速卡當中,最多支撐48臺配置GPU資源的虛擬機器同時運作——分成4個GPU執行個體,每個GPU個體可支撐12臺配置分時共用GPU資源的虛擬機器。有了這樣的使用彈性,企業的虛擬化基礎架構可用於多種工作負載,像是業務運作、視訊串流、圖形渲染、產品設計、AI開發。

從OVX進化到RTX Pro Server,多家伺服器廠商熱烈響應輝達號召

在今年5月舉行的台北國際電腦展,Nvidia宣布與多家伺服器廠商合作推出RTX Pro Server,將更多採用Blackwell架構的Nvidia GPU推廣至資料中心環境,並且能以虛擬化的方式執行各種類型的企業級工作負載。

類似性質的GPU伺服器推廣計畫,Nvidia也曾在2022年3月宣布,當時他們將這類系統平臺命名為OVX,鎖定數位雙生與協同設計的工作負載,其中的OVX伺服器將搭配多個A40 GPU、3張200Gb網路規格的ConnectX-6 Dx網卡、1 TB系統記憶體、16 TB NVMe固態硬碟,而且,每8臺OVX伺服器,可組成一座OVX POD;每32臺OVX伺服器可透過Spectrum-3交換器網路連接,組成一座OVX SuperPOD。

同年5月,Nvidia針對自家研發的Grace CPU設置的多種系統架構,也包含OVX系統,當中不僅採用多個Nvidia GPU,也搭配Grace CPU Superchip、BlueField-3資料處理器。

4個月之後,Nvidia發表第二代OVX系統,搭配8張採用Ada Lovelace架構的 L40 GPU,以及3張支援200 Gb網路規格的ConnectX-7 SmartNIC,預計隔年推出,參與的伺服器廠商包含浪潮、聯想、Supermicro,以及技嘉、新華三、雲達。

到了2023年3月,Nvidia宣布發展第三代OVX系統,硬體配備除了上述GPU與網卡,也搭配Spectrum乙太網路平臺,Dell、技嘉、HPE、聯想、雲達、Supermicro都將加入推廣行列,微軟也預告下半年推出Omniverse Cloud,這套基於OVX系統、為Omniverse軟體提供全代管模式的雲端服務,會在Azure環境當中供應,11月上線營運。

同年8月,OVX系統可搭配同架構、性能增強一些的L40S GPU(單臺伺服器可搭配8張),召集7家廠商開始主推(華碩也加入推廣OVX行列)。隔年3月,Nvidia號召多家企業級儲存廠商,為OVX系統搭配的儲存系統,推動產品驗證計畫,他們當時宣布有5家廠商通過驗證,分別是:DDN、Dell、NetApp、Pure Storage、WEKA。

至於2025年成軍的RTX Pro Server,可視為OVX系統的後繼者,此平臺採用的GPU是最新推出的RTX Pro 6000 BSE,提供更強大的圖形與AI運算處理能力,對於在Nvidia Omniverse平臺開發的工業數位雙生,以及機器人學習與模擬的工作流程,可提供充分的運算效能。

而且,每一臺RTX Pro Server最多可搭配8張RTX Pro Blackwell GPU加速卡,而且,這些伺服器也將採用BlueField-3 DPU,以及整合ConnectX-8 SuperNIC網路介面與PCIe 6.0交換器的I/O機板。

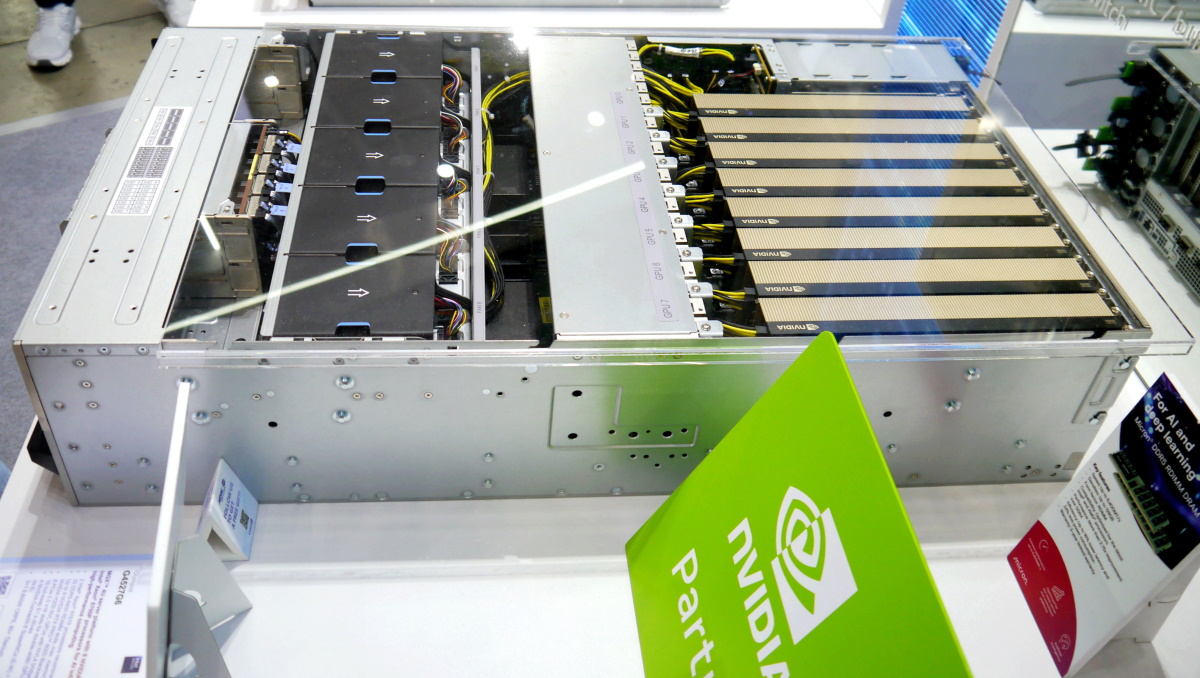

RTX Pro Server成軍,採用最新推出的Blackwell架構GPU加速卡是一大賣點,另一關鍵是伺服器導入新的I/O配置:搭配整合ConnectX-8 SuperNIC網路晶片及PCIe交換器的MGX機板。今年Computex現場許多伺服器廠商特別展出這個元件,圖中為和碩科技陳列的ConnectX-8 SuperNIC Switch機板(上),以及RTX Pro 6000 Blackwell Server Edition GPU(右下)。攝影/洪政偉

值得注意的是,相較過往PCIe GPU伺服器的配置,最大差異顯然是這張I/O機板,目前這個元件有幾種稱呼,似乎也內建分攤特定類型工作負載的能力。

Nvidia新聞稿將這項硬體機板元件,稱為ConnectX-8 SuperNICs with built-in PCIe Gen 6 switches,他們在2025台北國際電腦展主題演講過程中播放的影片,稱為ConnectX-8 SuperNIC Switch,號稱可將GPU的頻寬提升兩倍、具有密碼學加速處理能力且網路傳輸可維持線速、強化可程式化的I/O能力。黃仁勳表示,這張是連接8張RTX Pro 6000 Blackwell GPU的新一代主機板,蘊含一個交換器網路,並強調ConnectX-8 SuperNIC Switch是新的晶片類型,而且是交換器先行、網路晶片次之的產品,也是全世界最先進的網路晶片。就外觀而言,他也特別介紹這張主機板的背部有8個網路連接埠,正面有9個PCIe介面卡插槽,ConnectX-8可溝通兩者,網路傳輸頻寬達800 Gb/s,而在每個網路埠插上光纖網路收發器後,能使每張GPU加速卡擁有專屬的網路介面,同時,各個GPU也可透過東西向流量溝通。

而在部分伺服器廠商現場展示看板與後續釋出的新聞稿,則將此機板元件,稱為MGX PCIe Switch Board with ConnectX-8 SuperNIC,並提到它支援兩種網路環境:乙太網路(400 Gb / 200 Gb / 100 Gb / 50 Gb / 25 Gb)、InfiniBand(800Gb / 400 Gb / 200 Gb / 100 Gb),以及主機介面PCIe 6.0、最大提供48個通道。

針對這個架構,Nvidia也發布技術部落格文章,具體說明SuperNIC整合PCIe 6.0交換器的好處。

以單臺2路伺服器搭8張GPU加速卡、4張ConnectX-7網路卡、1張BlueField-3資料處理器為例,並以傳統伺服器PCIe交換器與網路介面各自運作的架構,作為對照,此時需要配置2至4個PCIe交換器,才能實現GPU對GPU,以及GPU對網路介面之間的連結。

不過,若改用整合PCIe 6.0交換器,以及多個支援800Gb網路的ConnectX-8 SuperNIC的機板裝置,每張GPU加速卡最大可獲得400Gb/s網路頻寬(每兩張GPU加速卡對接單張網路卡),並且能夠大幅減少系統複雜度、消除I/O瓶頸,在伺服器GPU、網路介面、儲存之間的資料搬移速度,也能因此大幅提高,在Nvidia集體溝通程式庫NCCL提供多GPU與多節點的相互存取上,效能可增至兩倍,也將有利於AI伺服器的規模擴展應用。

而在市場推廣方面,黃仁勳在台北國際電腦展期間正式宣布,RTX Pro Server已進入量產階段,當時響應Nvidia號召的伺服器廠商,總共有18家,聲勢遠遠超越OVX。

例如,在全球系統製造商方面,可供應Nvidia RTX Pro Server的品牌,涵蓋思科、戴爾科技集團、慧與科技(HPE)、聯想集團,而在資料中心系統合作夥伴方面,可供應Nvidia RTX Pro Server的廠商,則有研華、永擎電子、華碩、仁寶、鴻海科技集團、技嘉科技、英業達、神雲科技、微星科技、和碩聯合科技、雲達科技、美超微(Supermicro)、緯創、緯穎。

在今年上半的GTC大會、台北國際電腦展、自家用戶大會等場合,這些伺服器廠商均表示,自家產品將搭配RTX Pro 6000 BSE,而在硬體配置上,這些伺服器的機箱尺寸涵蓋3U(聯想 SR675 V3、Supermicro SYS-322GA-NR)、4U(華碩ESC8000A-E13與ESC8000A-E13P、永擎4UXGM-GNR2、Cisco C845A M8、Dell XE7740與XE7745、HPE DL380a Gen12、微星CG480-S5063、雲達D75E-4U、Supermicro SYS-422GL-NR)、5U(Supermicro SYS-522GA-NRT),每臺伺服器最多可搭配到10張GPU加速卡。

在8月初的SIGGRAPH大會上,Nvidia宣布供應RTX Pro Server的廠商增至20家,並表示開始提供採用4U尺寸機箱、配備8張RTX Pro Blackwell GPU的伺服器,舉例來說,除了上述機型,還有技嘉XL44-SX2-AAS1、永擎4UXGM-TURIN2。

至於採用2U尺寸機箱的RTX Pro Server產品,Nvidia預告將於今年稍晚推出。稍早,Supermicro已率先推出這類組態機型SYS-212GB-NR;HPE表示,DL385 Gen11於9月開始出貨;Dell將主推PowerEdge R7725與R770,今年稍晚上市;聯想提供ThinkSystem SR650a V4,第四季開放訂購。

Computex 2025亮相的Nvidia RTX Pro Server產品

.jpg)

英業達(Inventec)展出P4000G7,產品設計遵循Nvidia MGX 4U參考架構,最大可安裝8張RTX Pro 6000 Blackwell Server Edition加速卡。攝影/李宗翰

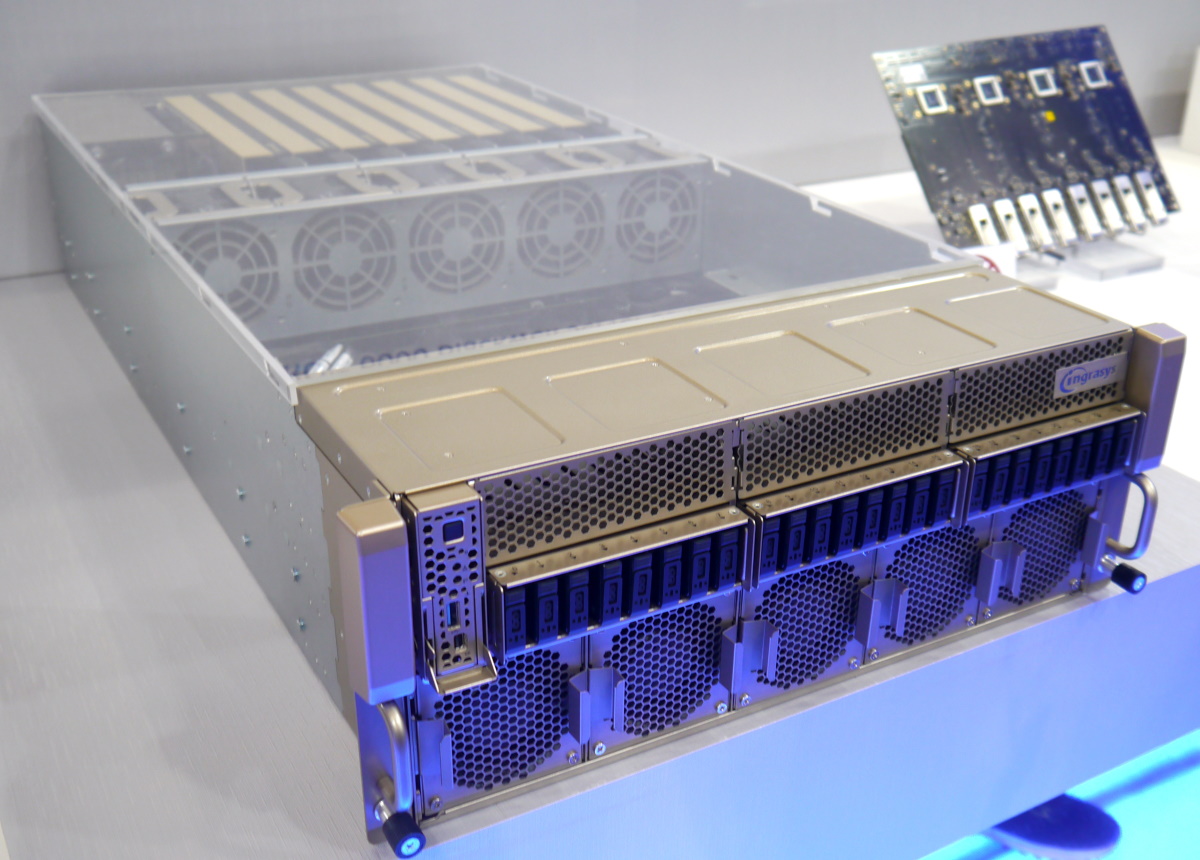

神雲科技(MiTAC Computing)針對Nvidia RTX Pro Server伺服器平臺推出的產品是G4527G6,GPU加速卡可搭配8張RTX Pro 6000 Blackwell Server Edition或H200 NVL。攝影/李宗翰

微星主推的RTX Pro Server機型是CG480-S5063,可安裝8張全高全長雙寬尺寸的GPU加速卡,能搭配RTX Pro 6000 Blackwell Server Edition或H200 NVL。攝影/李宗翰

鴻海針對RTX Pro Server的產品,在Computex展出採用Nvidia MGX 4U參考架構的伺服器設備,可搭配8張RTX Pro 6000 Blackwell Server Edition或全高全長雙寬尺寸的GPU加速卡。攝影/李宗翰

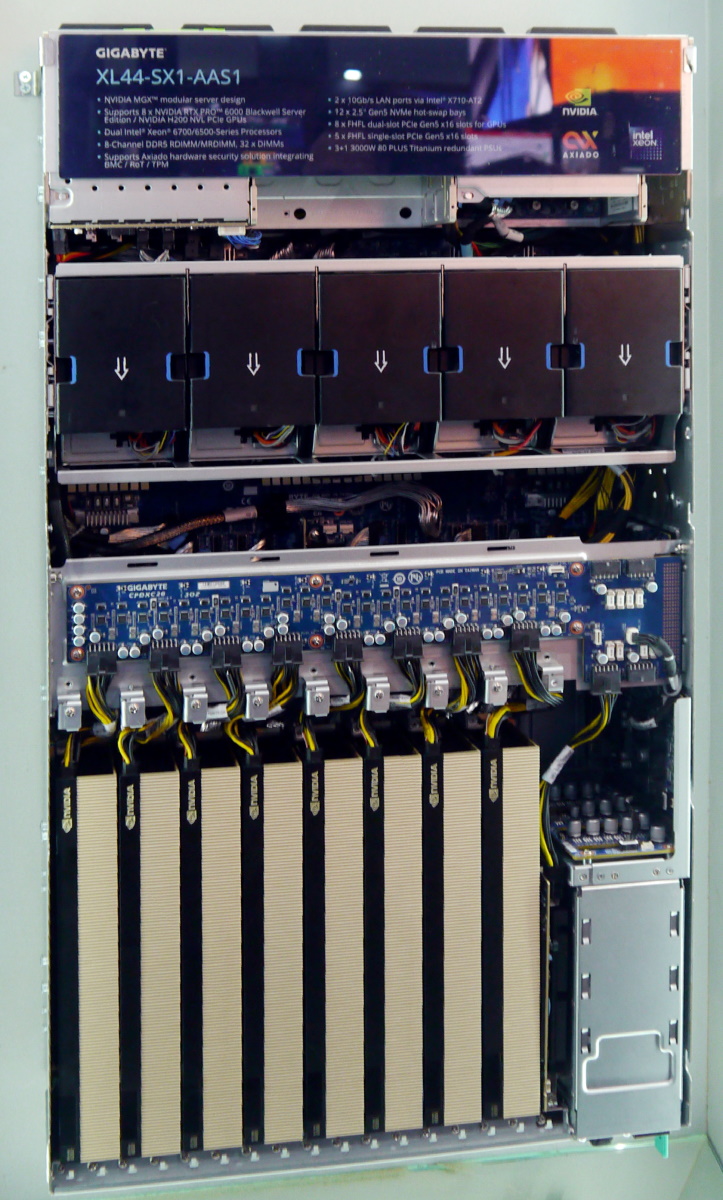

技嘉在今年Computex展出的RTX Pro Server機型是XL44-SX1-AS1,採用Nvidia的MGX模組化伺服器參考設計架構,而在8月初舉行的SIGGRAPH大會期間,他們主推另一款機型XL44-SX2-AAS1,採用Nvidia的 ConnectX-8 交換器機板。攝影/李宗翰

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10