Nvidia周一(1/5)發表新一代Rubin平臺,這是一套將CPU、GPU、互連、網路、安全與儲存等6大關鍵元件,整合為單一系統的機櫃級AI運算平臺,目標是把過去高度客製化的AI資料中心,轉化為可標準化部署的「AI工廠」。Nvidia同時宣布,微軟、AWS、Google、Oracle與CoreWeave等雲端業者,都準備在今年部署Rubin平臺。

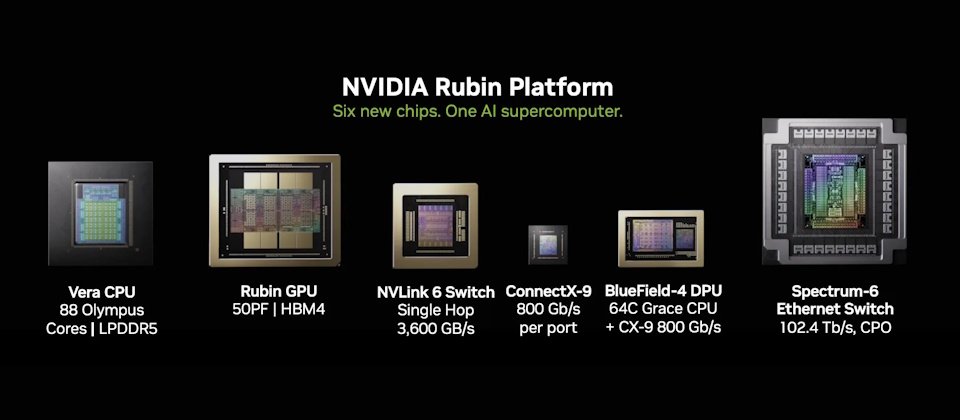

Rubin平臺整合的6大元件包括:Vera CPU、Rubin GPU、NVLink 6交換器、ConnectX-9 SuperNIC、BlueField-4 DPU,以及Spectrum-6乙太網路交換器。這些元件多半並非首次出現,但在Rubin平臺架構中,其定位出現根本性改變,並共同構成以機櫃為單位的AI運算系統。

其中,Vera CPU與Rubin GPU被視為Rubin平臺運算與推理能力的核心。Vera CPU是Nvidia首次為大型AI工廠量身打造的高能效CPU,採用88個自製Olympus核心,支援Armv9.2,並透過NVLink-C2C與GPU高速直連,特別適合代理式AI與推理流程的控制與協調。Rubin GPU則導入第三代Transformer Engine,結合硬體加速的自適應壓縮,在AI推論上提供50 PFLOPS的NVFP4算力,專為大模型與MoE推論最佳化。

在系統層面,Rubin也是首個在機櫃級導入第三代機密運算的平臺,能在CPU、GPU與NVLink間維持一致的資料保護,確保大型專有模型在訓練與推論時的安全性。同時,第二代RAS Engine橫跨CPU、GPU與互連,提供即時健康監測、容錯與預防性維護,加上模組化、無纜線設計,使組裝與維修效率較Blackwell提升最多18倍,進一步提升整體AI工廠的可用性與生產力。

這種跨元件的整體整合,直接影響AI的成本結構。Nvidia指出,相較前一代Blackwell平臺,Rubin在推論Token成本上最多可降低10倍,訓練大規模MoE模型所需的GPU數量,也可減少至原本的四分之一。

雖然Nvidia在過去幾個世代便已使用「平臺」來描述其AI系統,但Rubin的差異不在於是否整合,而在於整合的層級與交付單位。從官方說法可以看出,Rubin不再以單顆GPU或單一伺服器為核心,而是直接以「機櫃級系統(rack-scale system)」作為最小產品單位。這代表Nvidia不只是提供一組可組裝的系統方案,而是把整座AI運算環境,定義為可直接部署、可複製擴張的標準化AI工廠模組。

其實包括Anthropic、OpenAI、Mistral AI與xAI等,皆為預期採用Rubin的合作對象;Nvidia亦與紅帽擴大合作,將Red Hat Enterprise Linux、OpenShift與Red Hat AI納入針對Rubin最佳化的完整AI堆疊,進一步降低企業導入AI工廠的技術與營運門檻。

xAI創辦人暨執行長馬斯克(Elon Musk)表示,Rubin將成為AI領域的火箭引擎,對於希望大規模訓練與部署前沿模型的業者而言,這正是所需的基礎設施,也將再次向市場證明,Nvidia仍是業界的黃金標準。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-05

2026-03-02