法國AI新創Mistral AI釋出新一代開源模型家族Mistral 3,以旗艦模型Mistral Large 3搭配Ministral 3小型模型系列,形成從雲端資料中心到邊緣裝置都能部署的完整產品線,鎖定企業與開發者在多語言、多模態與在地運算上的需求。

Mistral Large 3採用稀疏MoE(Mixture-of-Experts)架構,推論時僅啟用部分專家網路,以降低運算成本與延遲。官方說明,Large 3約有410億活躍參數與6,750億總參數,支援最長25.6萬Token上下文,可支援長文件處理、跨語言對話與工具呼叫等企業級應用情境。

Mistral 3家族全部採用Apache 2.0授權,旗艦模型Mistral Large 3目前開放的是基本版(Base)與指令微調(Instruct)兩種權重,官方尚未同步釋出推理(Reasoning)版本,表示之後會推出專門強化推理能力的變體。Mistral同時提供AI Governance Hub等技術與治理文件,協助企業在導入過程中處理合規與風險管理議題。

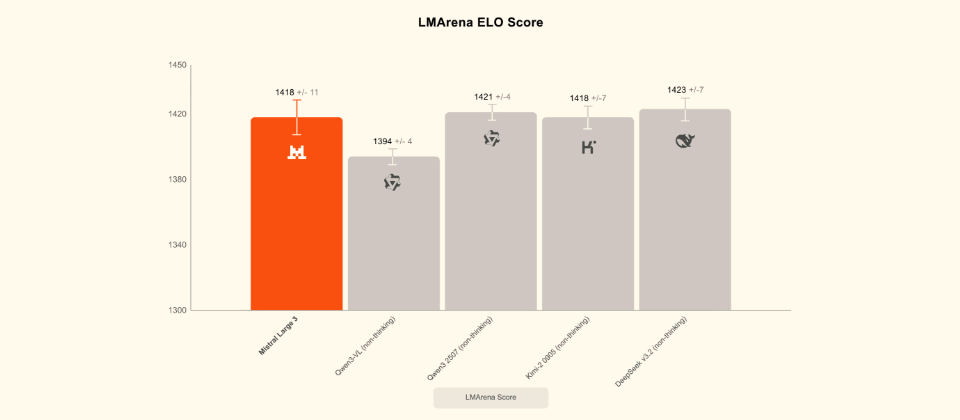

Mistral Large 3在開源模型社群的排名屬於前段班,在LMArena文字評測的ELO分數,Large 3約落在1418,與Qwen與DeepSeek等新一代開源旗艦模型的分數非常接近,整體實力明顯高於多數早期開源模型。依LMArena的分類來看,Large 3在開源非推理模型中已是前段班,要是只看開源陣營的整體排行榜,也達第一梯隊水準。

對本地與邊緣運算需求,Mistral推出Ministral 3系列,提供30億(3B)、80億(8B)與140億(14B)三種參數規模,每一種都分為基本版、指令微調與推理三個版本,並具備多語言與圖像理解能力,適合部署於筆電、工作站、嵌入式裝置與邊緣伺服器等硬體環境,在資源有限的條件下,仍可支援對話助理、文件摘要與基本推理等應用。

官方強調Ministral 3系列在成本效益上的設計不只反映在模型尺寸,也刻意控制回答時產生的Token數量,對於以Token計價或頻寬受限的場景,有助於降低營運成本,而針對需要較高準確度的情境,推理版本允許模型採用較長的推理步驟,以換取在數學與邏輯等基準測試上較佳表現。

Mistral 3家族已在Mistral AI Studio、Amazon Bedrock、Azure AI Foundry、Hugging Face、IBM WatsonX與OpenRouter等多個平臺上架,之後也規畫透過Nvidia NIM與AWS SageMaker提供容器化或託管服務。

熱門新聞

2026-03-06

2026-03-02

2026-03-02

2026-03-04

2026-03-02

2026-03-05

2026-03-02